隨著醫學診斷、治療模式的改變,醫學影像的質量直接影響著醫生對病情的診斷和治療。因此,通過計算機實現智能影像質控對放射科技師的拍片工作會有較大的輔助作用。本文擬就深度學習領域中的圖像分割模型、圖像分類模型結合傳統圖像處理算法應用于醫學影像質量評價的研究方法及應用情況予以闡述。我們發現使用深度學習算法對醫學影像大數據進行有效訓練,提取出來的特征相比于單純使用傳統圖像處理算法更加準確、高效,詮釋了深度學習在醫療領域的廣闊應用前景。本文開發出了一套輔助拍片智能質控系統,并成功應用到了華西醫院和其他市、縣級醫院的放射科,有效驗證了該質控系統的可行性與穩定性。

引用本文: 王繼元, 李真林, 蒲立新, 張凱, 劉秀民, 周濱. 基于人工智能的正位 DR 胸片質控體系研究與應用. 生物醫學工程學雜志, 2020, 37(1): 158-168. doi: 10.7507/1001-5515.201904017 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

引言

醫療事業關乎人民的生命健康,利用好龐大的醫療數據對提高醫療服務水平至關重要[1]。目前,醫療數據應用中仍然存在著很多問題,例如:數據類型多種多樣,包括圖、文、視頻、磁等;由于使用的設備不同,數據的質量存在較大差異;數據呈現波動特征,隨時間和特定事件變化;由于個體存在差異,病癥的規律沒有普遍適用性等。醫學影像是醫療數據中十分重要的組成部分,其質量好壞直接影響著臨床診斷和治療。建立有效的圖像質量評價機制,對于臨床醫學圖像處理技術[2]具有重大的應用價值。在圖像質量評價領域中,實現圖像質量評估的核心點是提取出能反映圖像某種特性的特征[3]。圖像質量的評價就是指采用特征提取的方法對圖像質量進行測度[4],評價圖像是否符合相應的標準。

目前國內外針對 X 射線、直接數字平板 X 線成像系統(digital radiography,DR)、計算機體層攝影(computed tomography,CT)和磁共振成像(magnetic resonance imaging,MRI)等各類型醫學影像,已建立了一套社會公認的醫學影像質量標準評價體系和方法,這些質控標準都是國內外醫生和相關專家們經過長期的臨床經驗總結出來的,且具有信息覆蓋全面、合理可行等特點。但是,這些質控標準的實際執行過程只停留在人工參考的層面,并沒有通過計算機算法將這些標準進行量化和智能質控,從而達到真正意義上的輔助拍片效果。因此本研究擬提出具有輔助拍片功能的智能質控系統,對于醫療影像質量的評價和醫療診斷質量的提高都將具有重要意義。

自 2006 年起,深度學習就作為機器學習領域的一個分支出現在人們的視野中[5],它是一種使用多層復雜結構或由多重非線性變換構成的多個處理層進行數據處理的方法。近年來,深度學習在計算機視覺、語音識別、自然語言處理、音頻識別與生物信息學等領域取得了突破性進展[6]。本文研究重點是制定合理可行的胸部正位 DR 醫學影像質控標準,并結合對深度學習領域中的醫療圖像分割算法、圖像分類算法和傳統圖像處理算法的研究,最終實現對正位 DR 胸片的質量評價與控制。本文使用 U-Net 圖像分割模型實現目標區域分割,該模型在其他醫學圖像分割領域取得過優秀的成績;同時使用 Inception-V4 模型實現圖像分類,該模型以其優秀的模塊結構和高效性得到了廣泛應用。

1 質控體系架構設計

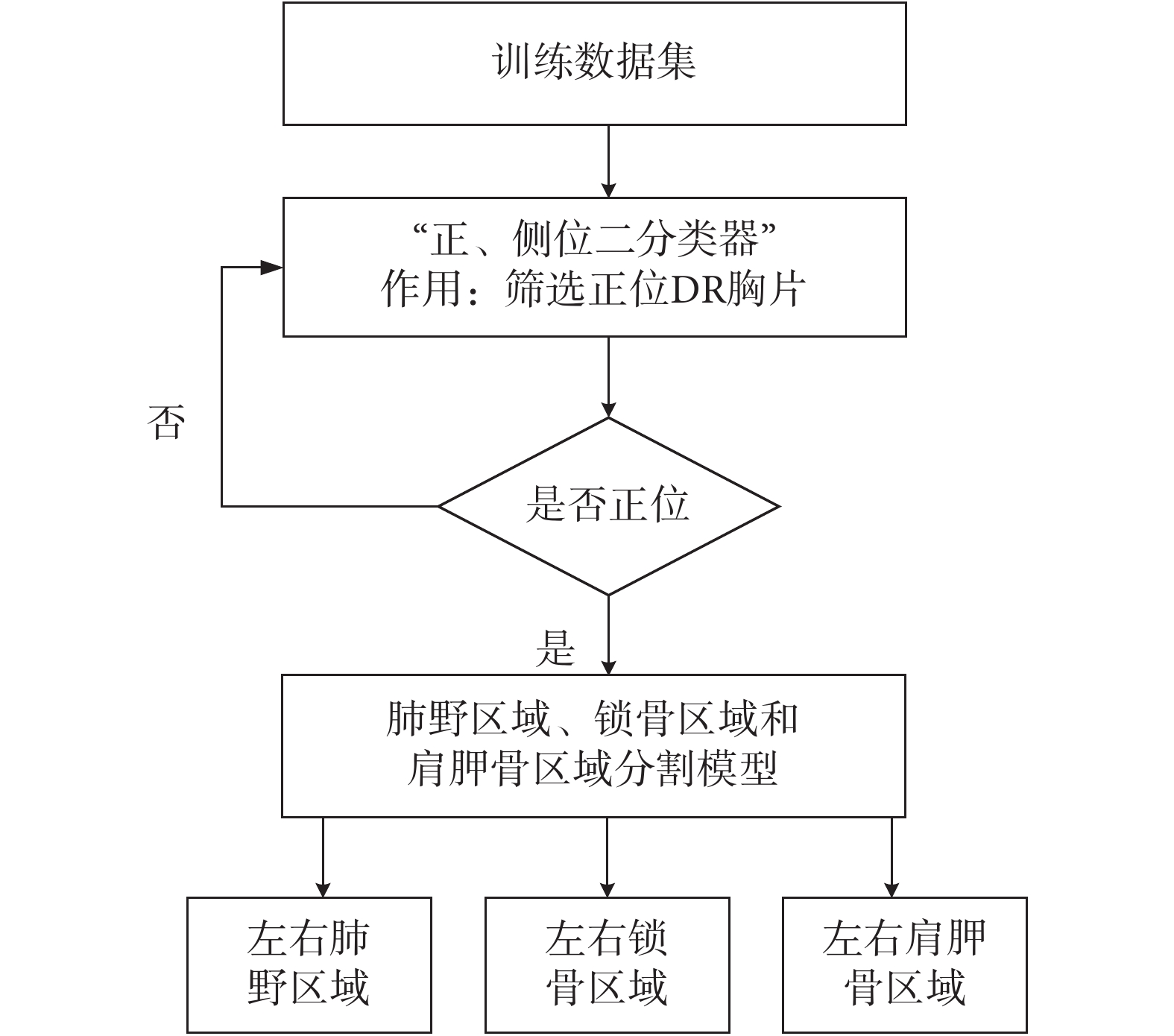

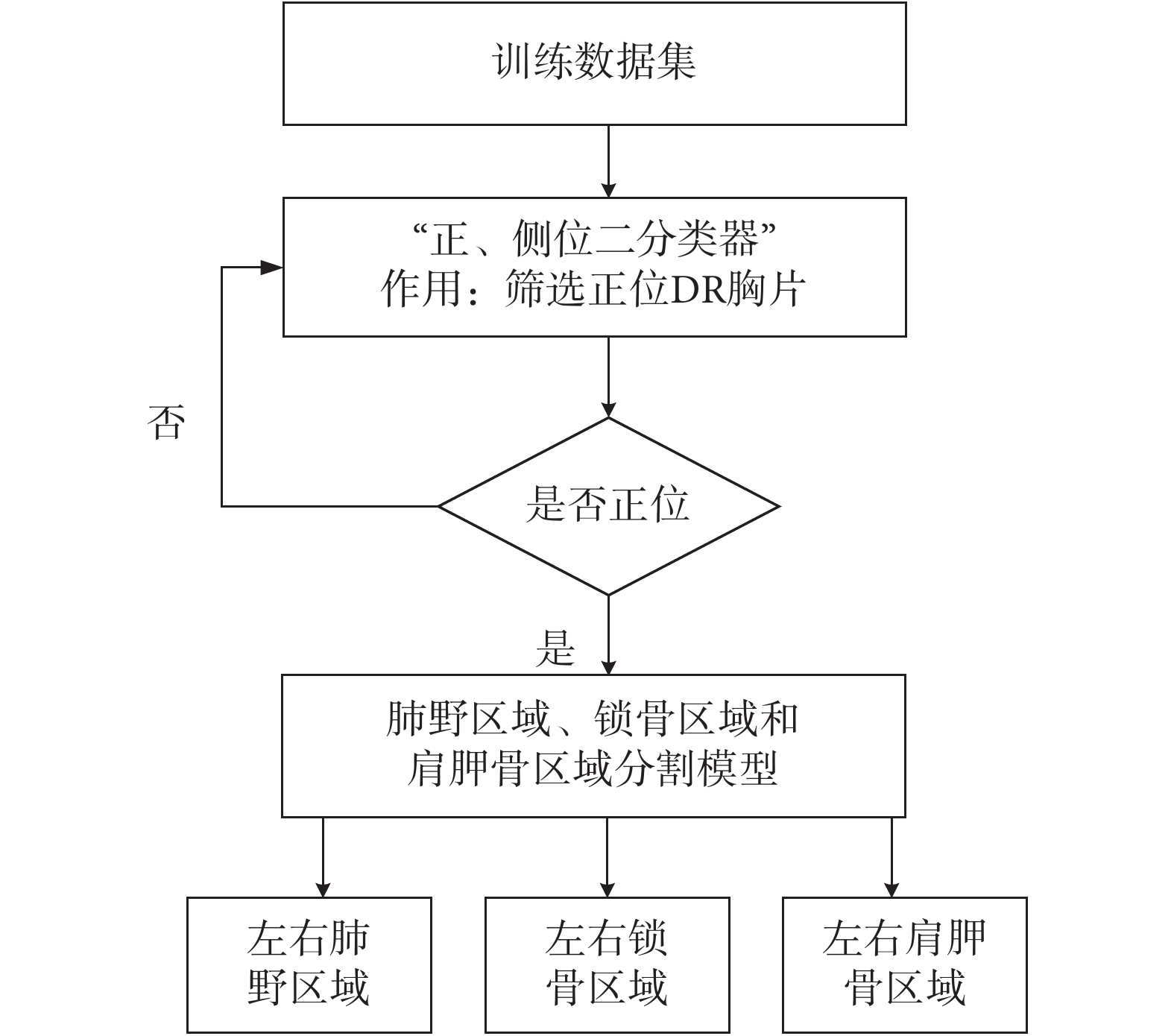

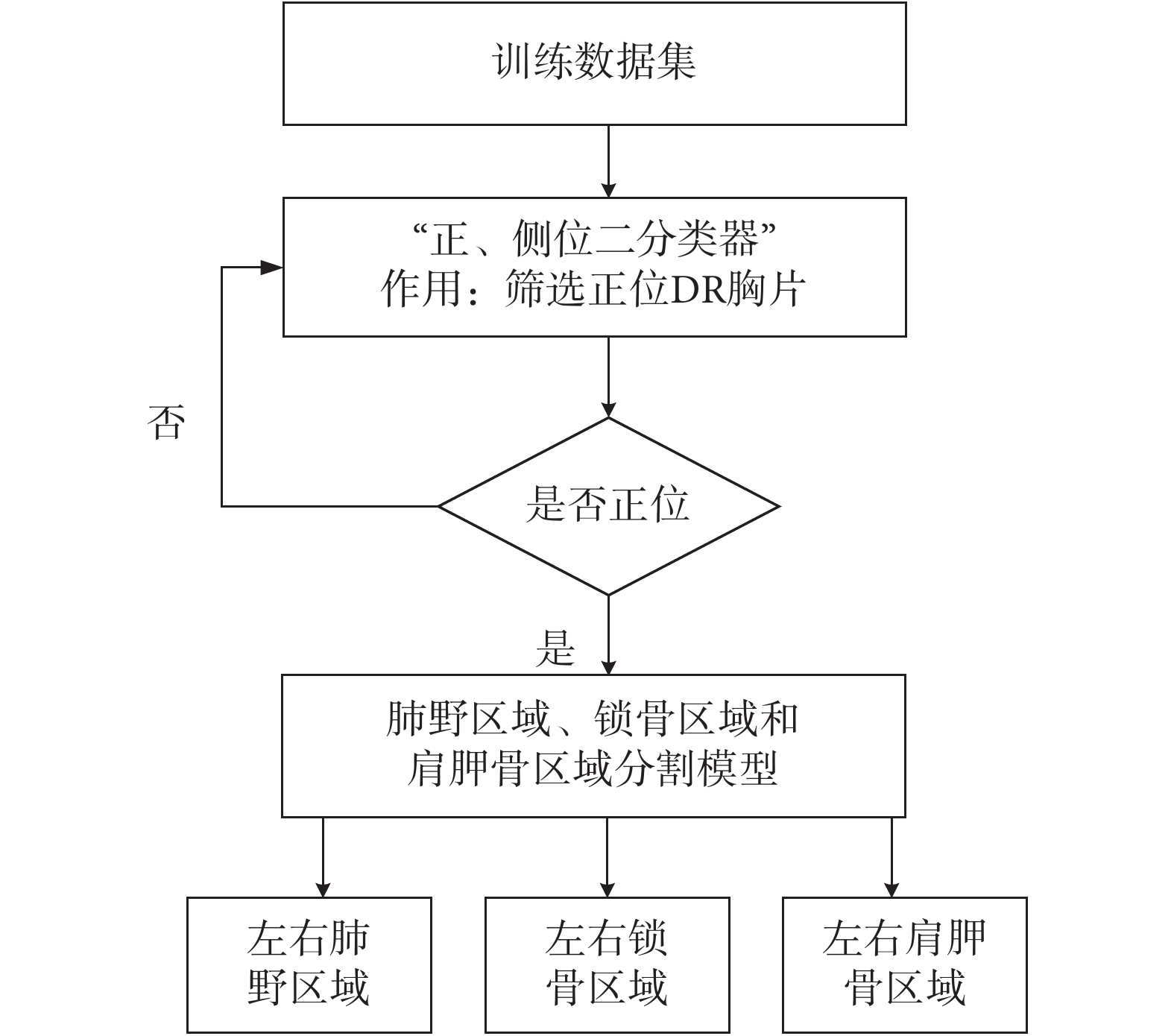

根據本文的研究思路,結合實際應用情況,總結出的質控體系架構設計路線如圖 1、圖 2、圖 3 所示。

圖1

正位 DR 數據篩選及區域分割流程

Figure1.

Filter of positive-bit DR data and regional segmentation process

圖1

正位 DR 數據篩選及區域分割流程

Figure1.

Filter of positive-bit DR data and regional segmentation process

圖2

深度學習分類模型對異物的判斷流程

Figure2.

The process of judging the foreign object by the deep learning classifier

圖2

深度學習分類模型對異物的判斷流程

Figure2.

The process of judging the foreign object by the deep learning classifier

圖3

圖像處理算法對拍片擺位的判斷流程

Figure3.

Image processing algorithm for the judgment process of film placement

圖3

圖像處理算法對拍片擺位的判斷流程

Figure3.

Image processing algorithm for the judgment process of film placement

如圖 1 所示,首先篩選出本文要研究的正位 DR 胸片,然后使用深度學習圖像分割模型對左右肺野區域、左右鎖骨區域和左右肩胛骨區域進行分割,便于進一步的深度學習分類模型研究和傳統圖像處理算法研究。

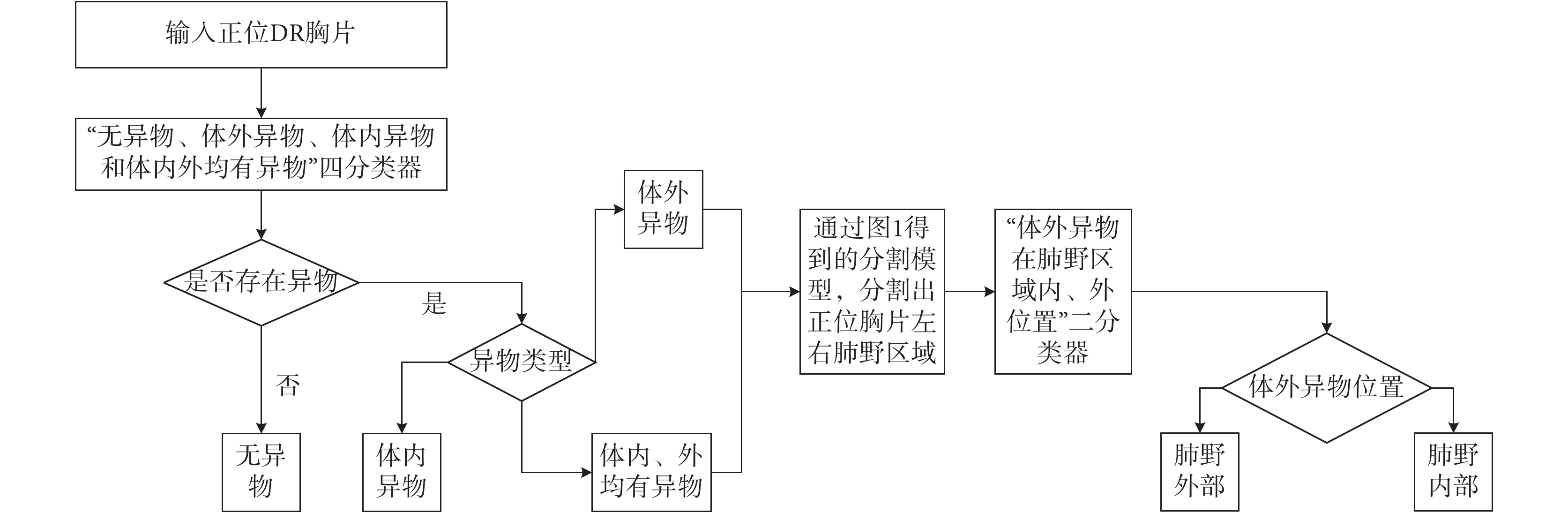

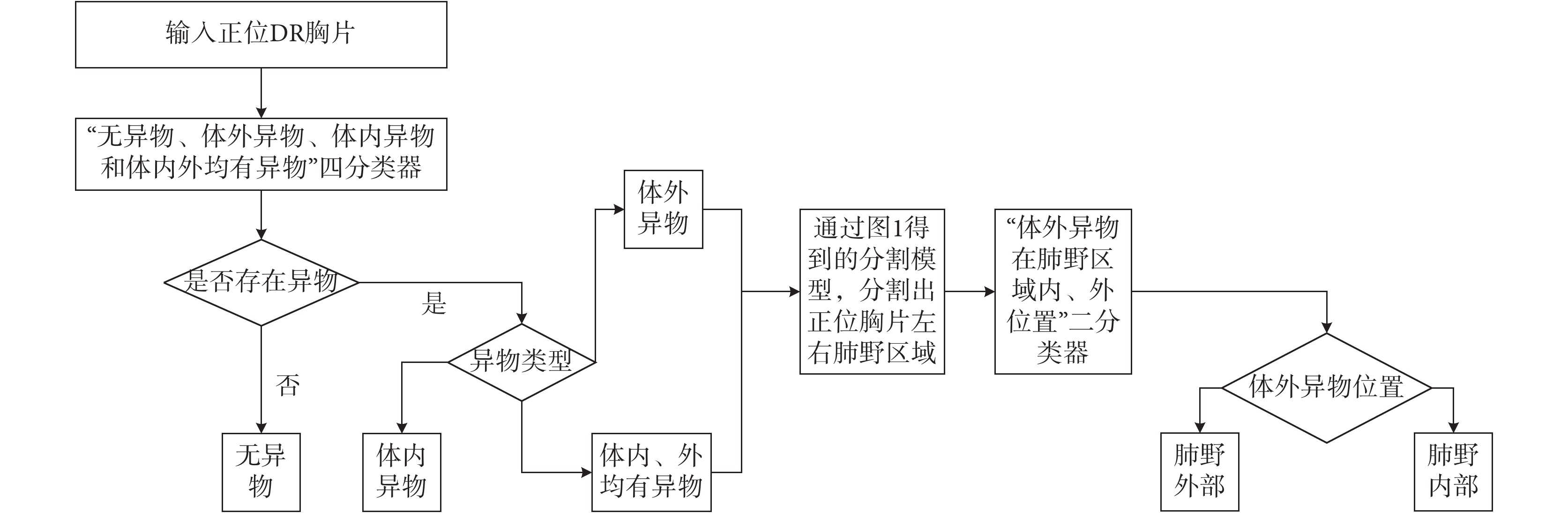

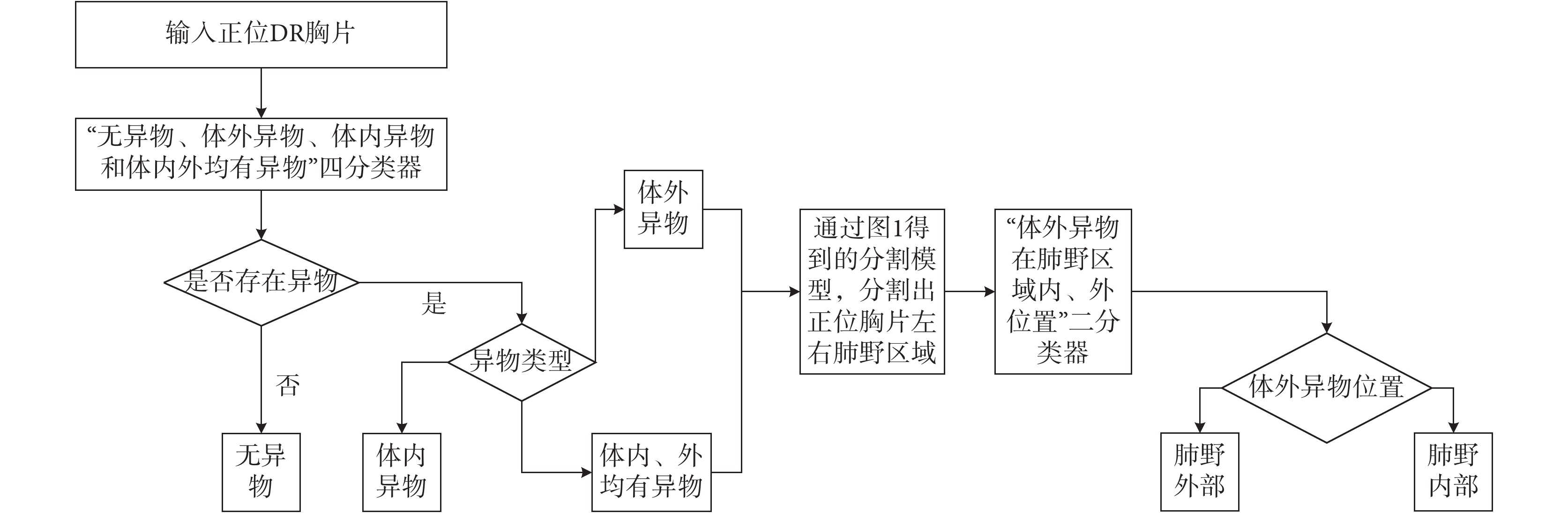

如圖 2 所示,依次使用了兩個深度學習分類模型。首先使用深度學習四分類器實現了異物類型的判斷,然后使用深度學習二分類器對體外異物的位置做出了判斷。

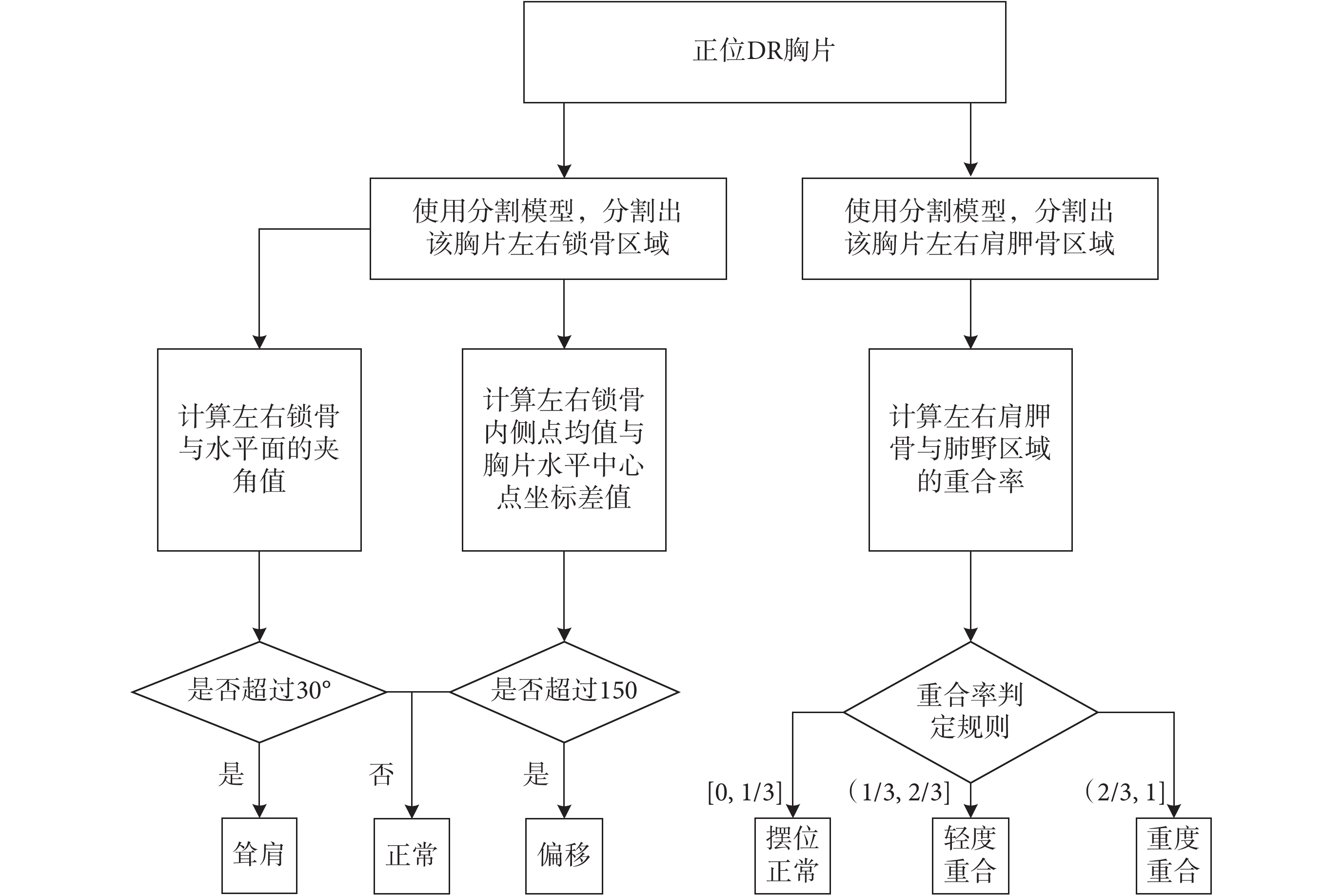

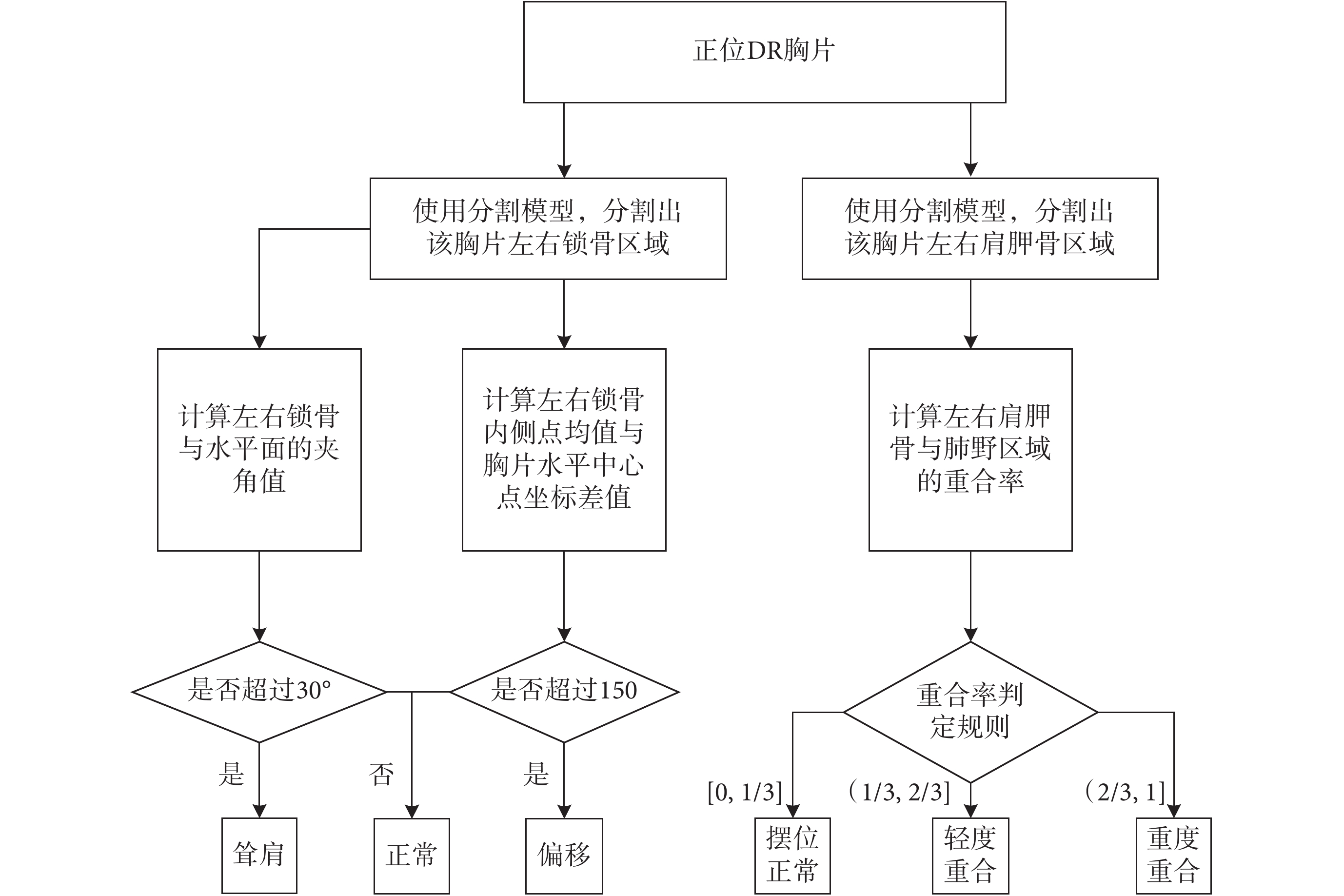

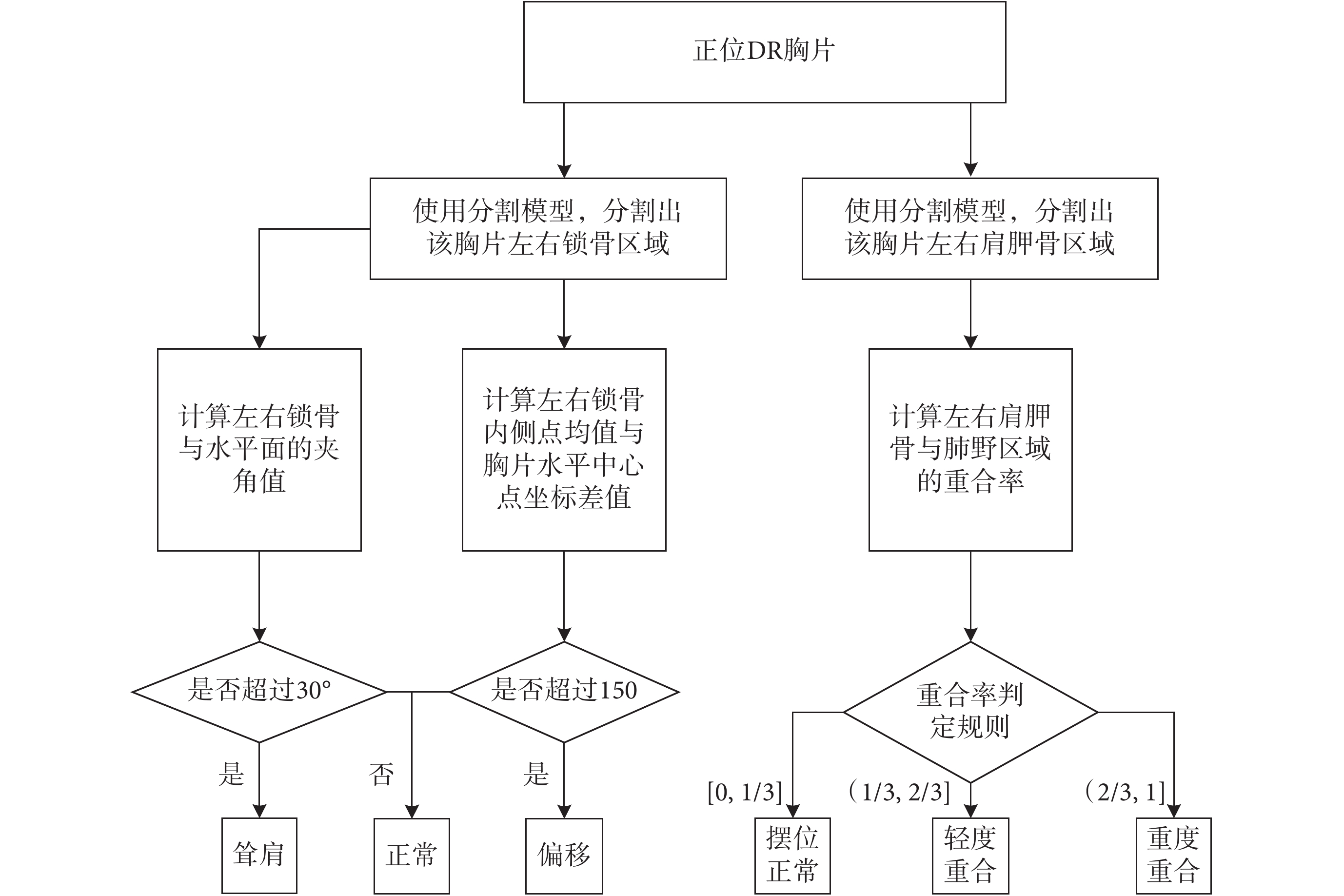

如圖 3 所示,使用傳統圖像處理算法分別對聳肩傾角、體位偏移量和肩胛骨重合度進行計算,提供了對拍攝體位判斷的量化依據。

2 研究方法

2.1 研究模塊

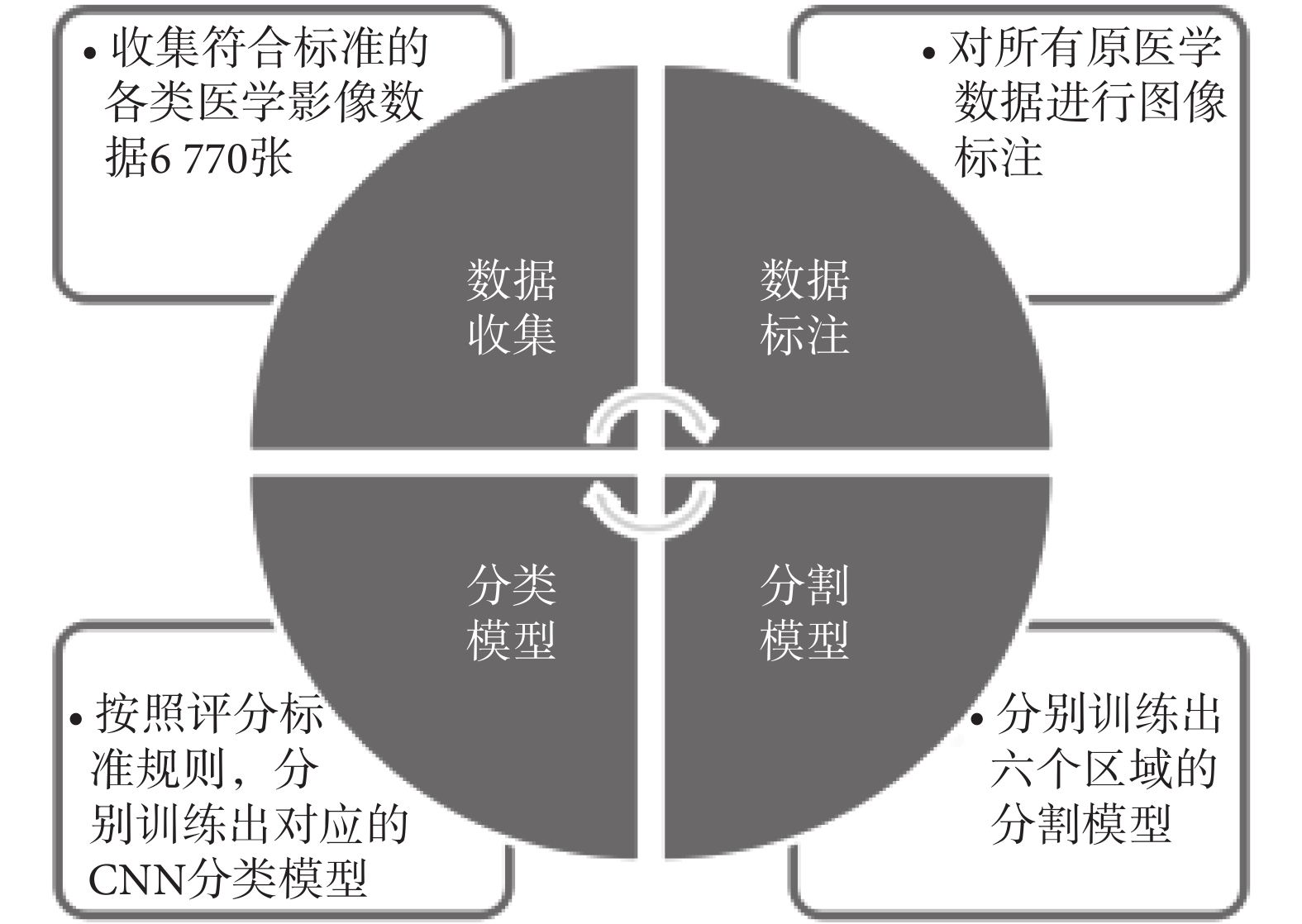

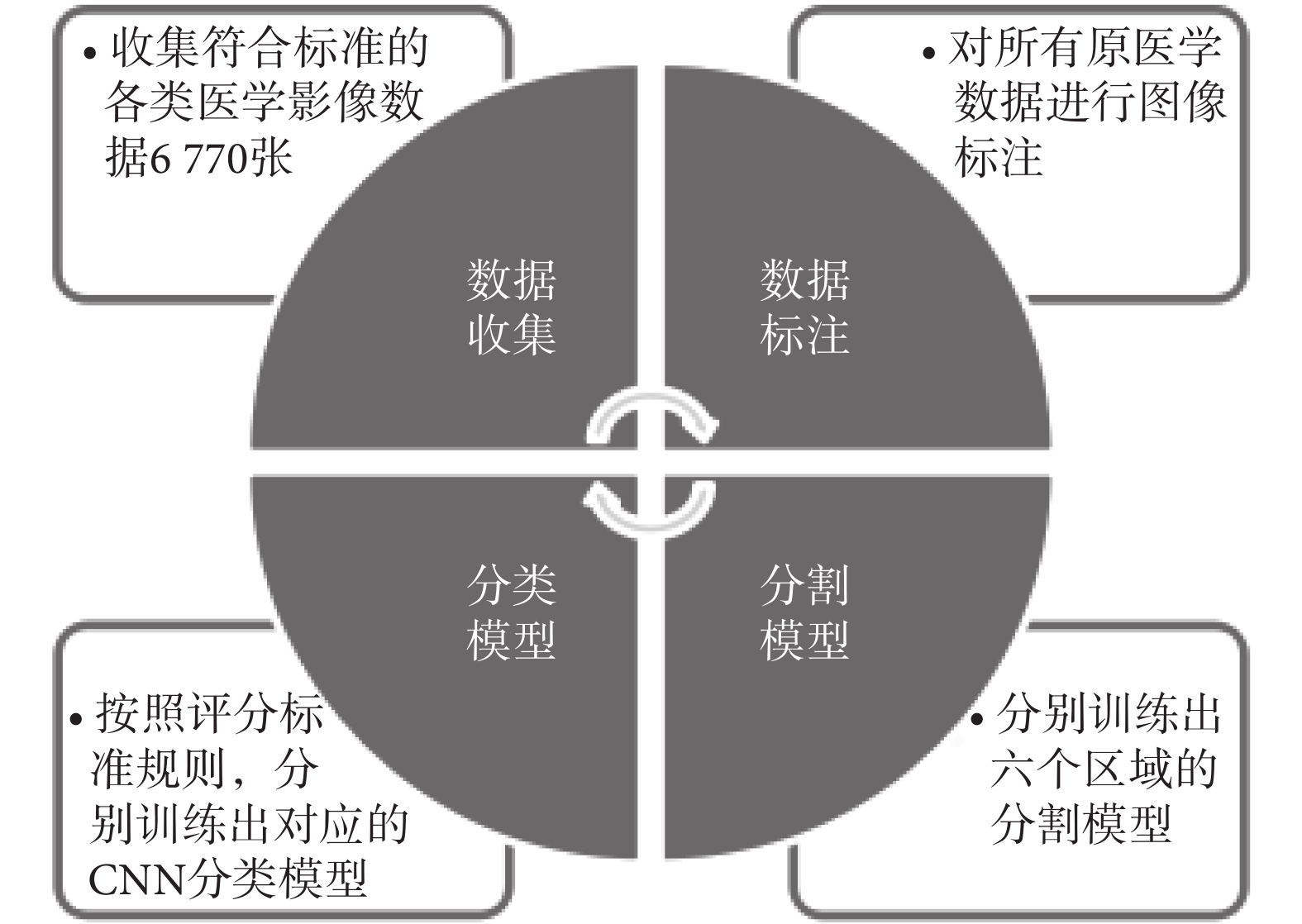

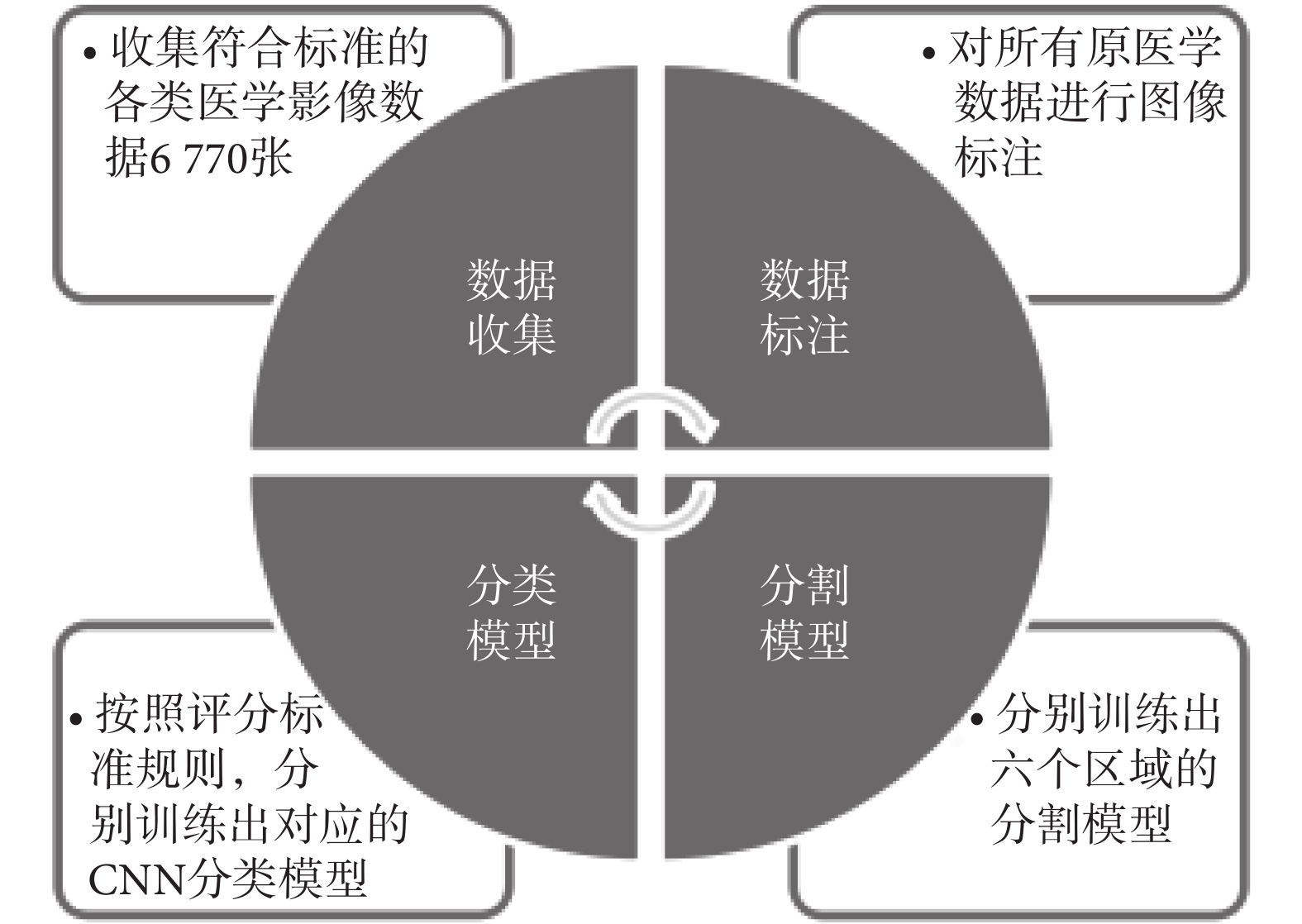

本文研究模塊包括:① 脫敏處理的正位 DR 醫學影像(本研究中使用的所有數據均是對個人敏感信息過濾處理后的純醫學影像)數據[7]收集;② 使用標注工具對研究區域輪廓進行手動標注[8];③ 使用 U-Net 分割模型[9-10]對 DR 正位胸片的左右肺野、左右鎖骨、左右肩胛骨等六個區域進行分割;④ 使用卷積神經網絡(convolutional neural networks,CNN)模型[11-12]針對特定數據進行有效分類判斷,模塊如圖 4 所示。

圖4

醫學影像質控體系研究方法模塊圖

Figure4.

Module diagram of quality control system of medical image

圖4

醫學影像質控體系研究方法模塊圖

Figure4.

Module diagram of quality control system of medical image

2.2 正位 DR 胸片數據質量評價控制標準

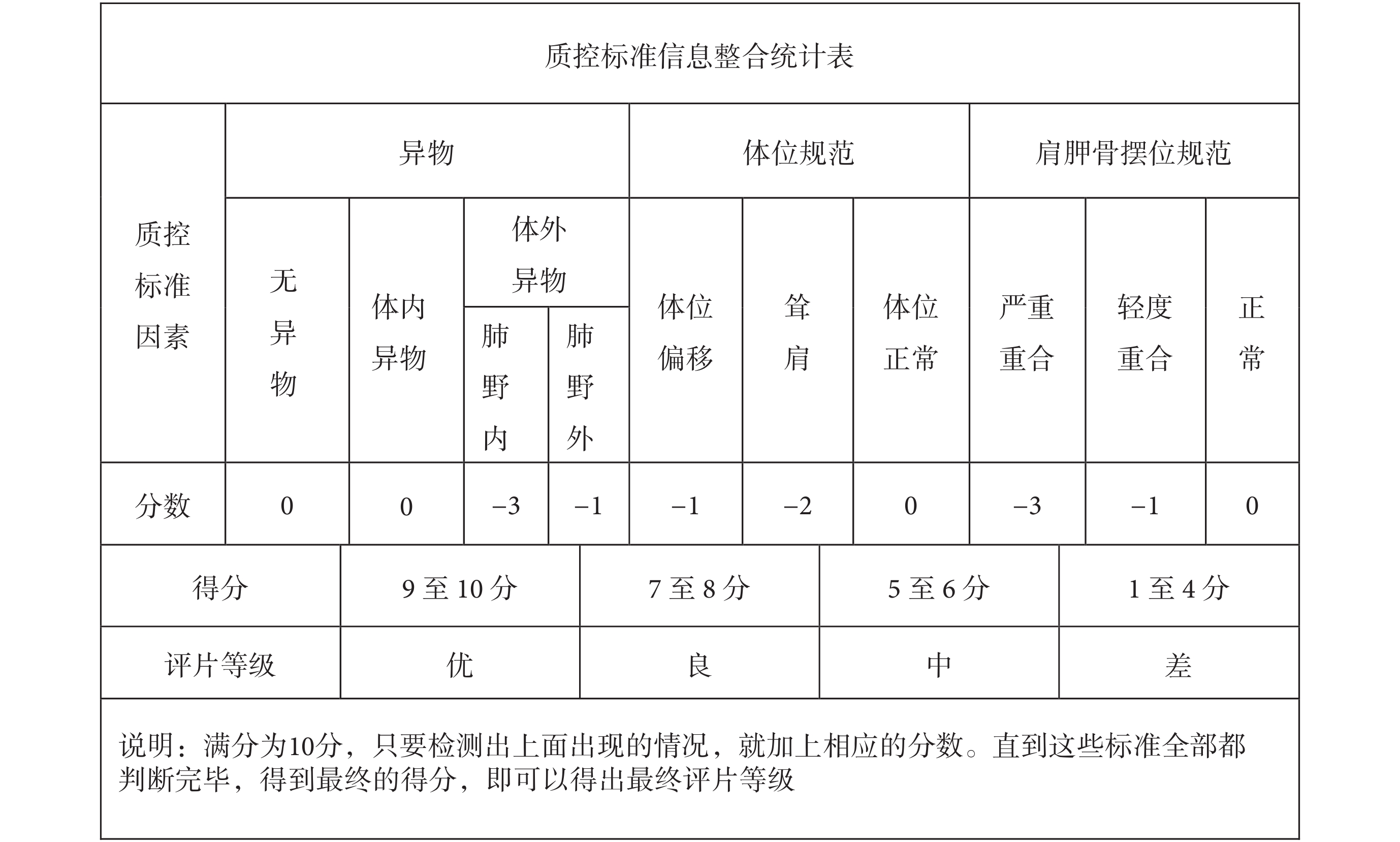

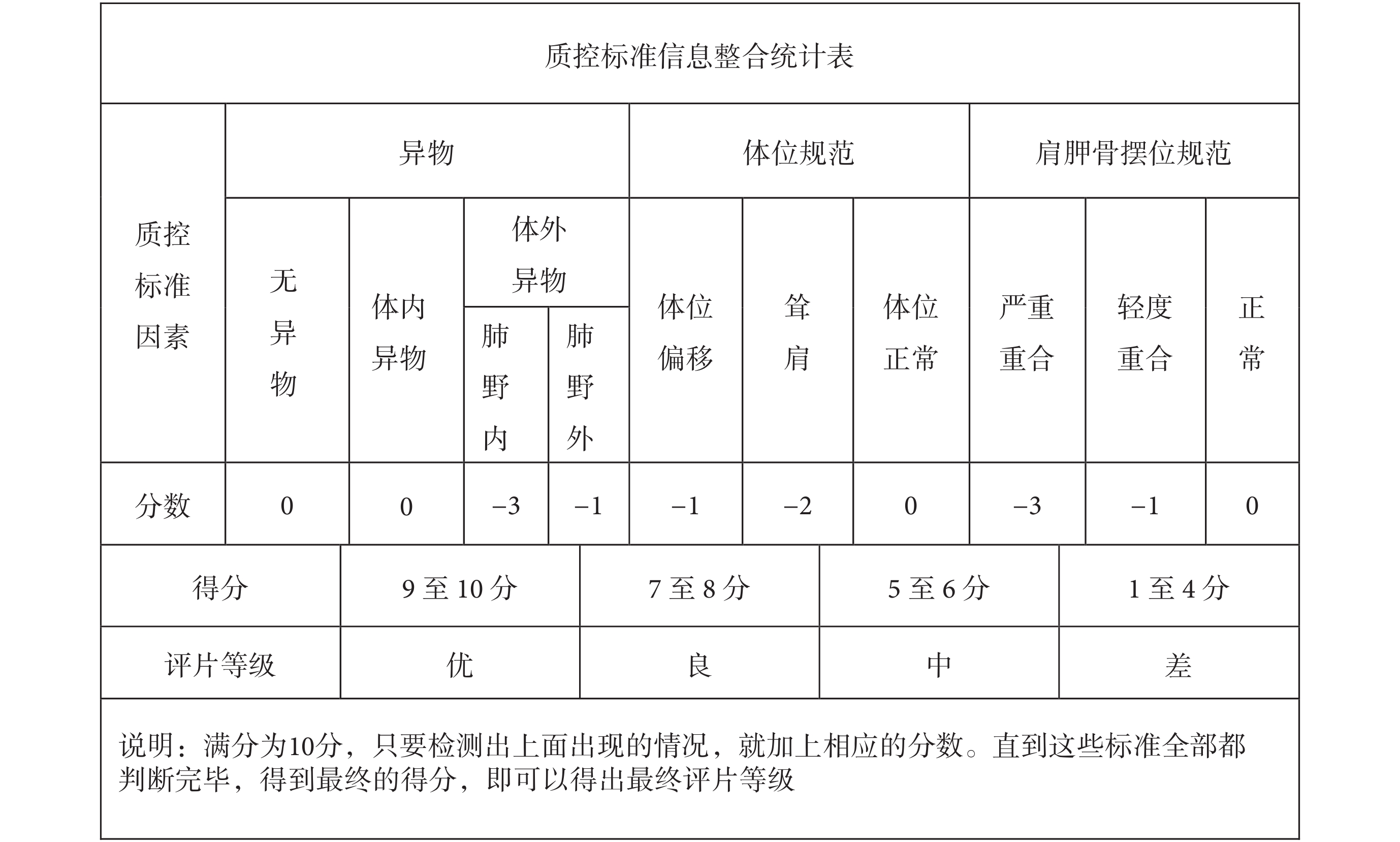

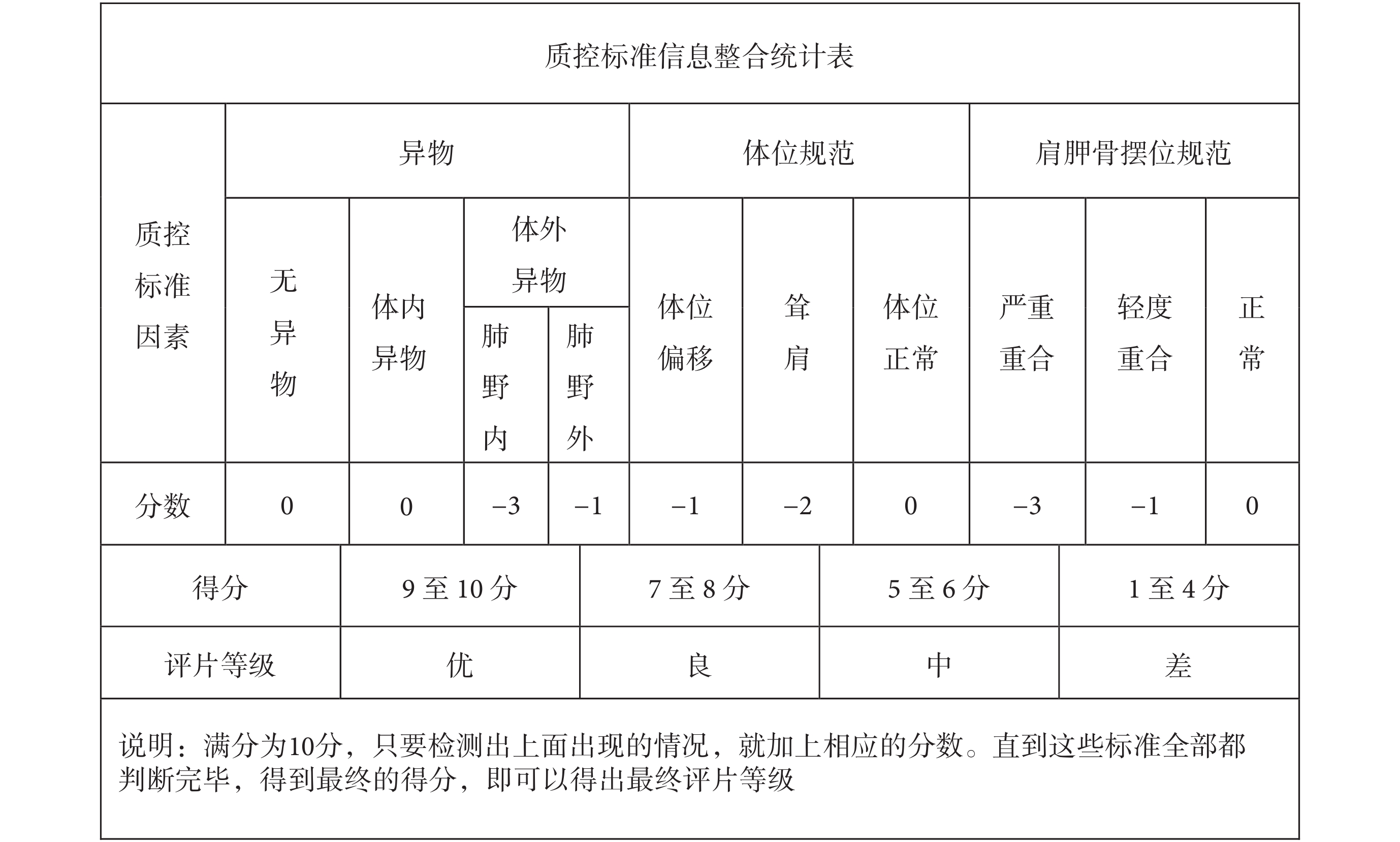

本次正位 DR 醫學影像質控體系研究過程中的首要核心任務為確定一套科學可行的質控評價標準,經過不斷實驗測試和改進,最終確定并使用的正位 DR 胸片數據質量評價控制標準如圖 5 所示。

圖5

質控標準信息統計

Figure5.

Statistics of quality control standard information

圖5

質控標準信息統計

Figure5.

Statistics of quality control standard information

圖 5 中的質控標準信息主要包括:異物、體位規范和肩胛骨擺位規范,且質控標準點都是技師在拍片過程中主要關注的評判點,只有當拍片質量都符合這些標準,醫生在閱片過程中才能做出更加精確的診斷。此外,這些質控標準點都可以用相應的深度學習算法和圖像處理算法完成和實現,可行性較高且準確率良好。

2.3 正位 DR 胸片數據收集與標注

2.3.1 數據收集

從四川大學華西醫院放射科[13]收集了 6 770 位受檢者的正位 DR 胸片,收集到的數據包括:優片、體外異物、體內異物[14]、鎖骨聳肩、體位不正、肩胛骨擺位不正[15]等各類情況,且部分受檢者同時存在以上中多種情況;此外,由于體內異物的情況很少存在,因此通過手動制作擴充體內異物數據 500 張,使數據集總數達到 7 270 張。各類別正位 DR 醫學影像具體數量為:2 300 張優片、2 000 張體外異物、1 000 張體內異物、850 張聳肩、1 250 張體位偏移、1 500 張肩胛骨擺位不正。

2.3.2 數據標注

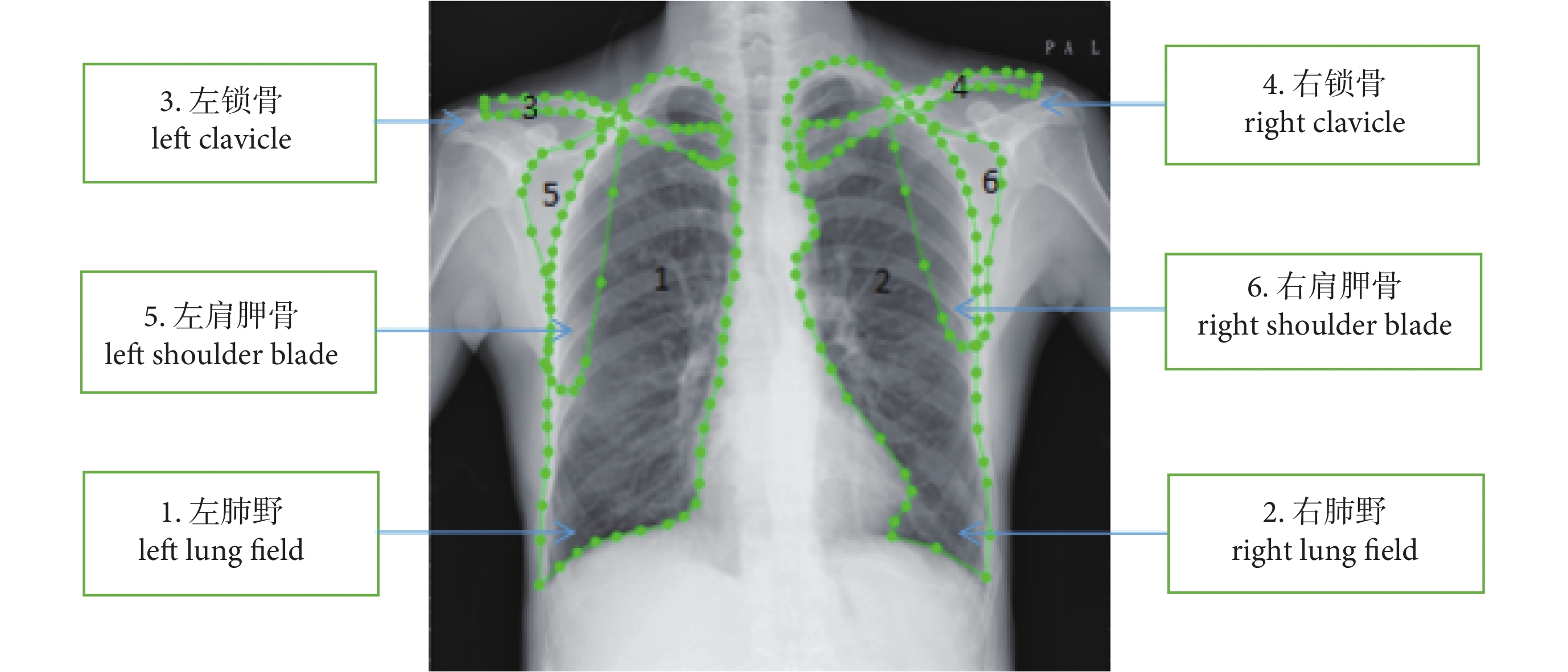

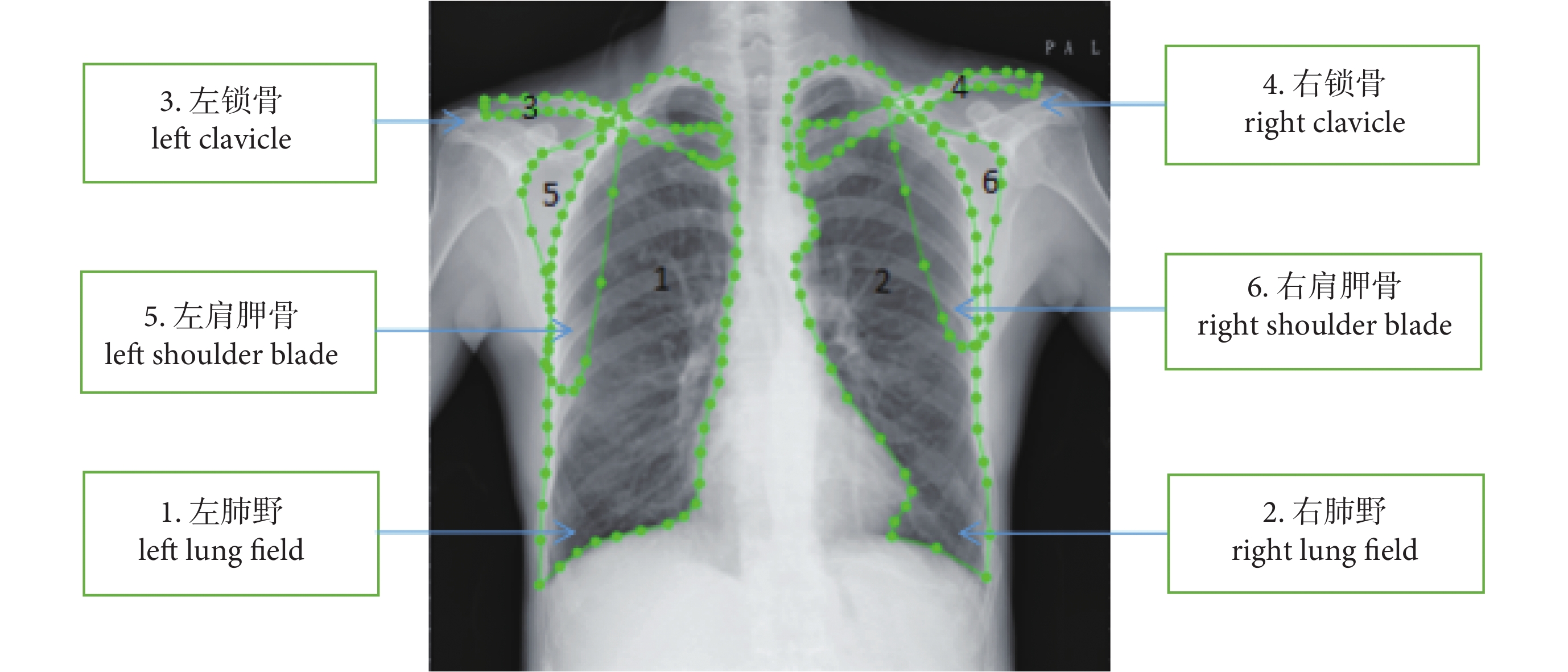

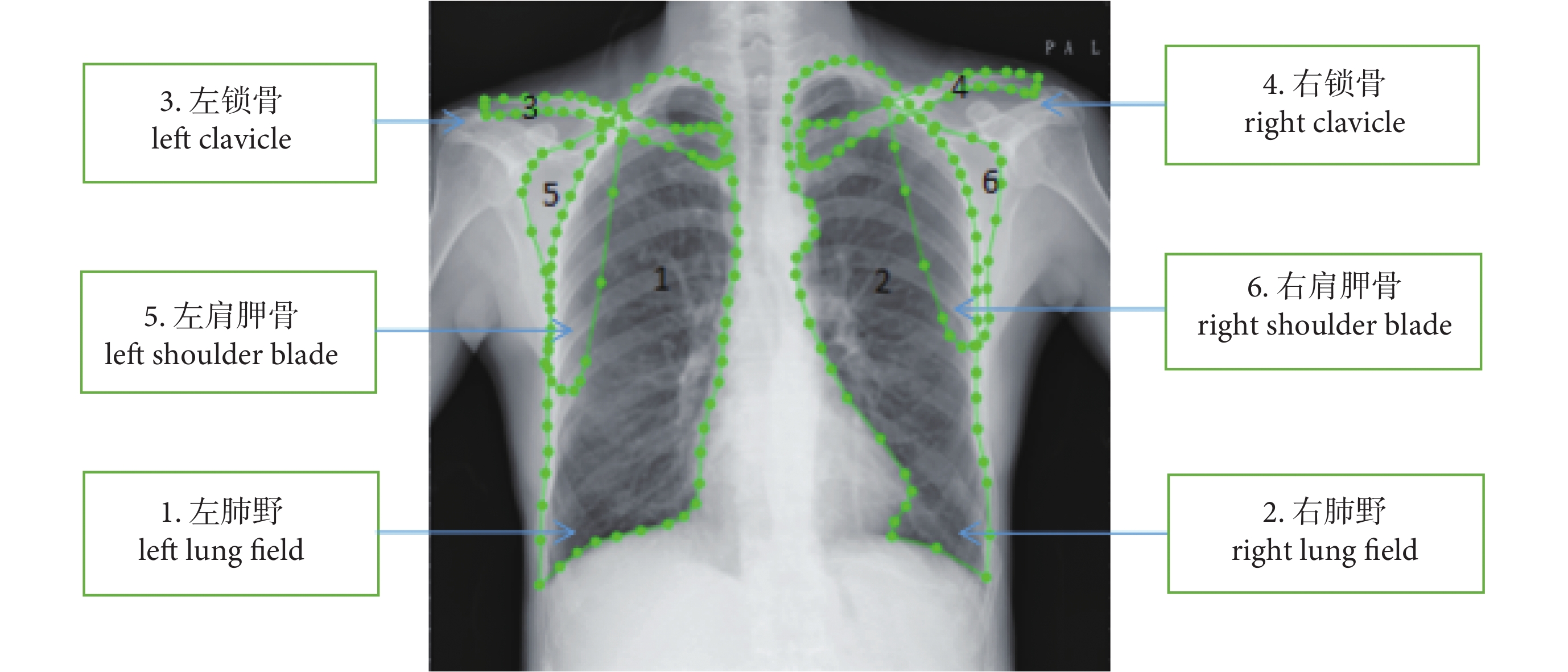

作者團隊和華西醫院放射科技師嚴格圍繞制定的質控標準,使用標注工具對數據中的研究區域進行標注,標注編號依次代表:① 左肺野;② 右肺野;③ 左鎖骨;④ 右鎖骨;⑤ 左肩胛骨;⑥ 右肩胛骨(此處標注的左右是指圖像顯示的左右,與實際人體結構方位相反,但不影響最終智能評片結果),標注效果如圖 6 所示。

圖6

正位 DR 胸片影像標注效果展示

Figure6.

Annotation effect display of positive DR chest image

圖6

正位 DR 胸片影像標注效果展示

Figure6.

Annotation effect display of positive DR chest image

2.4 正位 DR 胸片分割流程

2.4.1 數據集準備

首先,將標注工具生成的 json 文件解析為可用的數據集;然后,制作模型可用的數據集,用于訓練和測試分割模型的各類數據共 6 200 張,其中訓練過程中的數據量為 6 000 張,手動測試集為 200 張,并按照分割模型需要的數據存放規則對訓練集和測試集進行分類歸檔。

2.4.2 深度學習分割模型選擇

近些年,隨著深度學習領域的圖像分類模型、分割模型在圖像處理方面的不斷拓新和應用,誕生出了一系列優秀的圖像分割模型,對于圖像的分析不僅限于圖像的灰度值信息和邊緣信息,而是深入研究圖像更深層次的局部抽象信息,對于圖像特征信息有了更全面的提取和分析。

目前,深度學習圖像分割領域已經誕生了一些表現優秀的圖像分割網絡模型,如全卷積神經網絡(fully convolutional networks,FCN)分割網絡模型[16]、Mask RCNN 目標分割模型[17]和 U-Net 分割模型[18]等。這些模型都有各自的特點,并均在特定領域取得過突出的成績。

本研究使用的是 U-Net 分割模型,該網絡是一個基于 CNN 的圖像分割網絡,主要用于醫學圖像分割,依靠數據增強可以讓標注數據得到更為有效的使用。網絡最初提出時是用于細胞壁分割,之后在肺結節檢測以及眼底視網膜圖像的血管提取等方面都有著出色的表現。該分割模型網絡由收縮路徑和擴張路徑組成。其中,收縮路徑用于獲取上下文信息,擴張路徑用于精確的定位,且兩條路徑相互對稱。該網絡能夠采用極少圖像端對端進行訓練,運行速度非常快,在圖形處理器(graphics processing unit,GPU)上分割一張 512 × 512 的圖像不到一秒即可完成。

2.4.3 模型訓練和測試效果

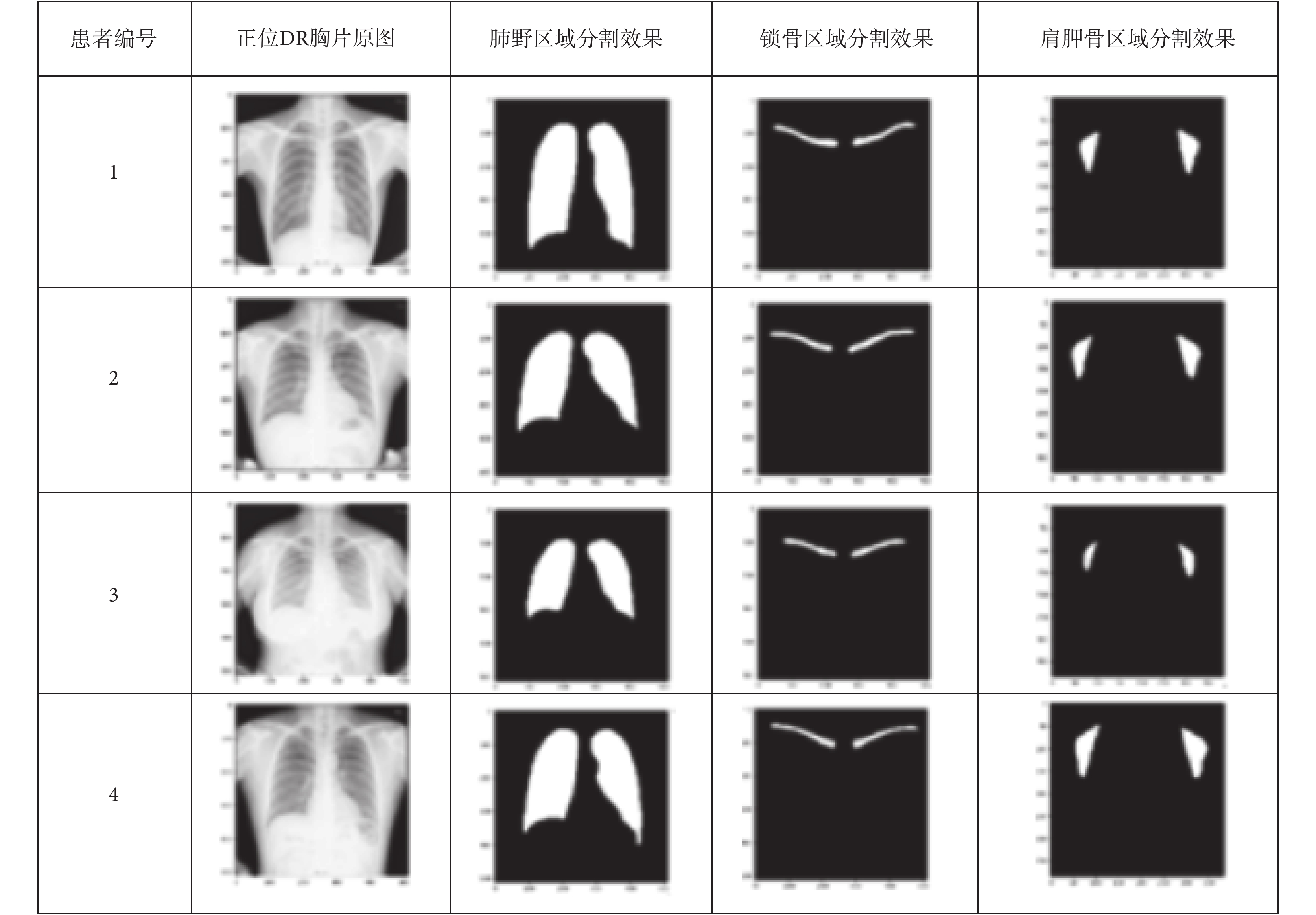

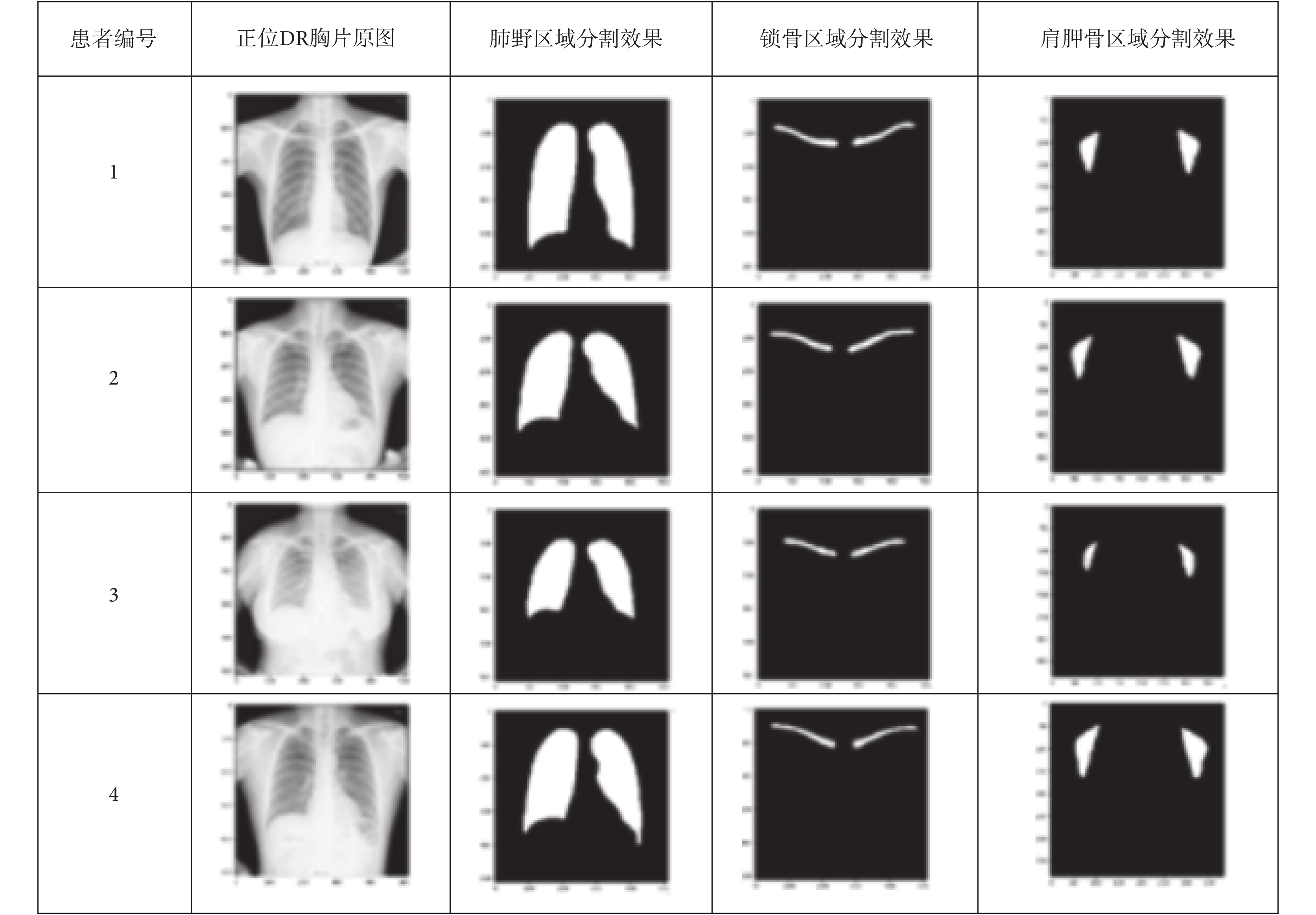

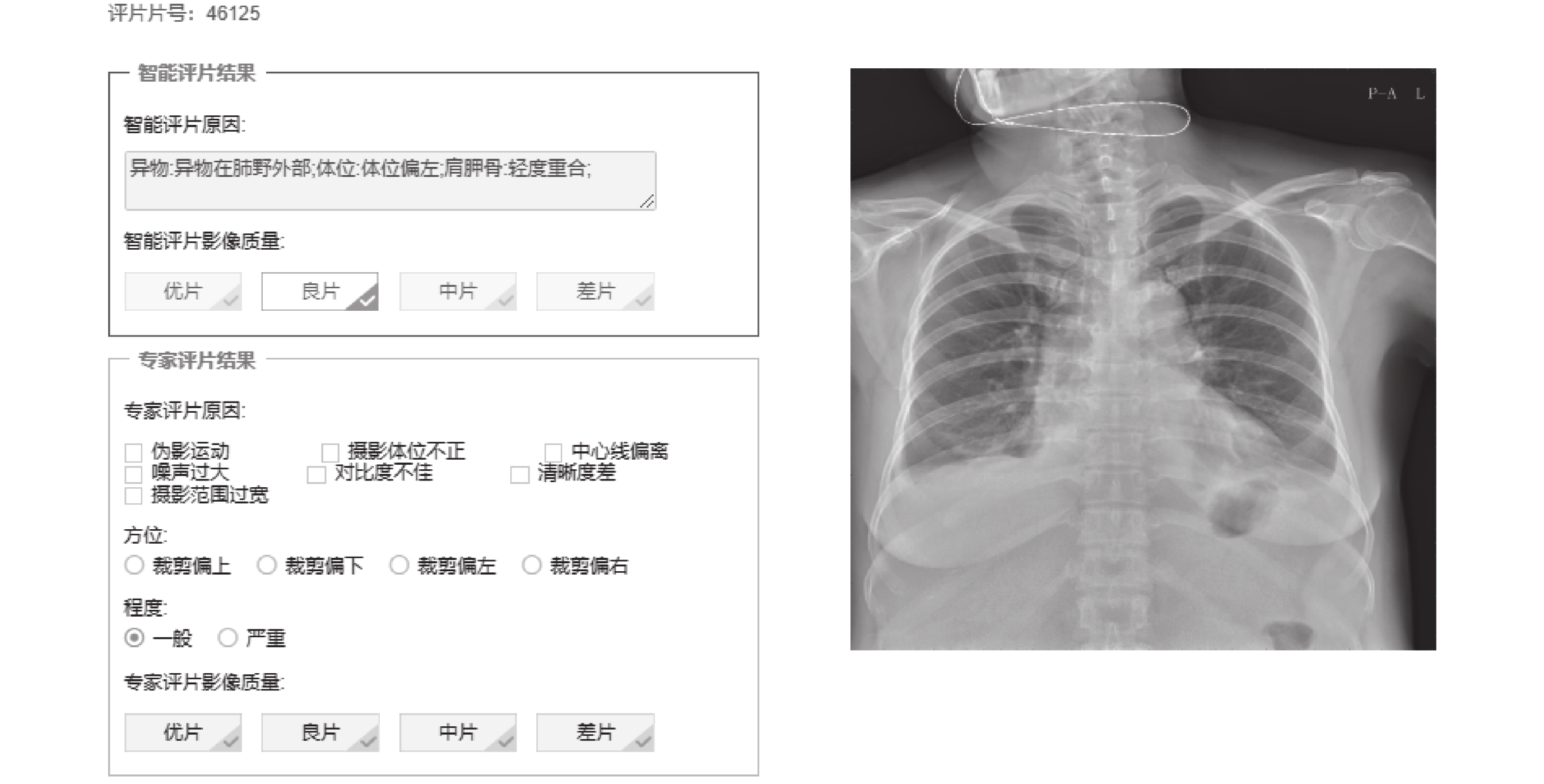

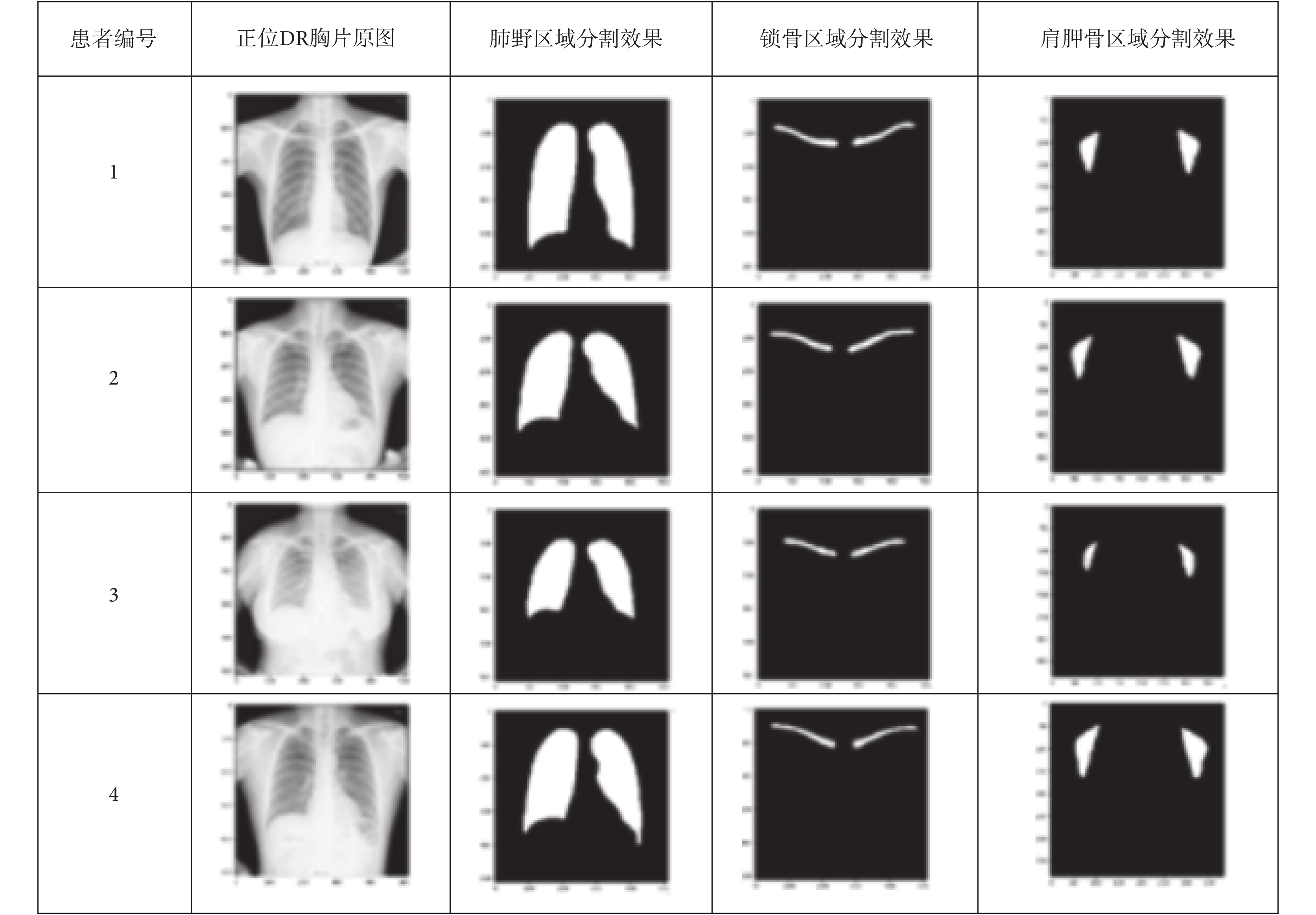

使用 U-Net 分割模型針對三個不同部位的六個區域分別進行模型訓練,通過不斷測試和調參,調試出符合各自部位的最優模型,針對優片的肺野區域、鎖骨區域、肩胛骨區域等六個區域的圖像分割[19]測試效果如圖 7 所示。

圖7

肺野區域、鎖骨區域、肩胛骨區域分割效果

Figure7.

Segmentation effect of lung field area, clavicular area, and scapula area

圖7

肺野區域、鎖骨區域、肩胛骨區域分割效果

Figure7.

Segmentation effect of lung field area, clavicular area, and scapula area

本次研究通過控制不同參數的大小對 6 000 張正位 DR 胸片進行模型訓練,在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機抽取數據分別組成訓練集和驗證集,即訓練集數據量為 5 400 張,驗證集為 600 張。可控參數包括:① N_subimgs:訓練樣本數量;② N_epochs:訓練次數;③ batch_size:單批訓練樣本數;④ IMG_WIDTH、IMG_HEIGHT:訓練樣本圖像的寬度和高度;⑤ stride_height、stride_width:池化矩陣移動縱向橫向步長;⑥ One_time:單次訓練時間;⑦ AUC:曲線下面積,即受試者操作特征(receiver operating characteristic,ROC)曲線下與坐標軸圍成的面積;⑧ Accuracy:模型準確率。測試得到的實驗結果如表 1 所示。

通過對異物分類模型中各項參數進行調節,使用模型中驗證集對模型準確率的自動測試發現,當參數 N_subimgs = 1 800、N_epochs = 50、batch_size = 2、IMG_WIDTH = 1 024、IMG_HEIGHT = 1 024、stride_height = 30、stride_width = 30 時,肺野和鎖骨的分割精度均最高。當其他參數保持不變,IMG_WIDTH = 512、IMG_HEIGHT = 512 時,肩胛骨的分割精度最高。各區域的分割準確率依次可以達到:肺野為 0.934 6、鎖骨為 0.922 5、肩胛骨為 0.901 8。

隨機使用 200 張測試數據對訓練好的分割模型進行手動測試,對分割出來的實際效果與原手工標注的輪廓進行重合度分析,同時根據評片主觀經驗進行分析,發現該分割模型的效果基本符合要求,針對一些多余或者殘缺的錯誤可以通過傳統圖像后處理算法進行填充修補和消除,從而不斷優化模型。

2.5 肺野部位的 CNN 分類模型研究與實現

2.5.1 分類模型網絡選擇

Inception 網絡是 CNN 分類器進化過程中很重要的里程碑,在其誕生之前,大部分 CNN 網絡僅僅是不斷增加網絡深度以期望得到更佳的分類識別效果,但這樣做只會成倍增加網絡參數,降低計算效率。Inception 網絡最大的創新之處是使用了 Inception 模塊實現了一種具有優良局部拓撲結構的網絡,即對輸入圖像并行地執行多個 1 × 1、3 × 3 或 5 × 5 等不同尺寸的卷積運算或池化操作,通過增加網絡深度和寬度,從而獲取圖像的不同細節信息,并將所有輸出結果拼接為一個非常深的特征圖。

本研究使用的是 Inception-V4 網絡[20],其網絡架構可以用很低的計算成本達到很高的性能,其設計主要沿用了之前 V2、V3 中提到的 CNN 網絡設計原則。Google team 將 V4 網絡執行遷移到了 tensorflow 上來執行,因此可不必再像之前在 DistBelief 上那樣,受限于他們所用系統的內存較小、計算量大等局限而只在幾種可行的范圍里選擇 Inception 通用模塊。簡單地說就是利用 tensorflow 天生的并行性,設計數據并行(data parallel)與模型并行(model parallel)的網絡。

2.5.2 主要研究點的分類模型測試結果及分析

(1)判斷正位 DR 胸片的異物類型:技師在 DR 拍片過程中經常能觀察到一些異物,會在整體或局部影響到醫生的診斷,甚至導致誤診。其中,體內異物是無法避免的情況,常見的有心臟起搏器[21]、胸腔肋骨固定夾和脊椎固定架[22],本模型可以自動檢測出體內異物,有效幫助技師再次確認是否存在體內異物,可以有效防止這類異物造成的誤診。體外異物則是應避免的情況,常見的有內衣、金屬佩戴物等,這類異物形態特征多樣,很容易和某些疾病混淆或者遮擋住某些疾病特征,導致醫生的誤診、漏診。本模型可以有效檢測出體外異物,節約時間成本和醫療資源。

本次研究通過控制不同參數的大小對 3 050 張正位 DR 胸片進行模型訓練,其中無異物數據量 1 300 張,體外異物數據量 800 張,體內異物數據量 500 張,體內外均有異物數據量 450 張。在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機從每個類別中抽取數據分別組成訓練集和驗證集,即訓練集數據量為 2 745 張,驗證集為 305 張。模型中對驗證集數據測試得到的實驗結果如表 2 所示。

通過對異物分類模型中各項參數進行調節,使用模型中驗證集對模型準確率的自動測試發現,當參數N_subimgs = 2 515、N_epochs = 80、batch_size = 5、IMG_WIDTH = 1 024、IMG_HEIGHT = 1 024、stride_height = 30、stride_width = 30 時,判斷正位 DR 胸片中異物類型的四分類器的分類準確率相對最高,可以達到 0.926 5。

隨機使用 200 張各類別測試數據對訓練好的模型進行手動測試,對識別到的實際效果與初始分類好的數據庫進行對比分析,同時根據評片事實經驗進行分析,結論為該分類模型的效果基本符合要求。其中,模型對體外異物和心臟起搏器的檢測準確率較高,但是對胸腔肋骨固定夾、脊椎固定架等異物檢測率較低,這是由于固定夾這類異物的特征和周圍骨頭的特征相近以及數據量少等原因所致。

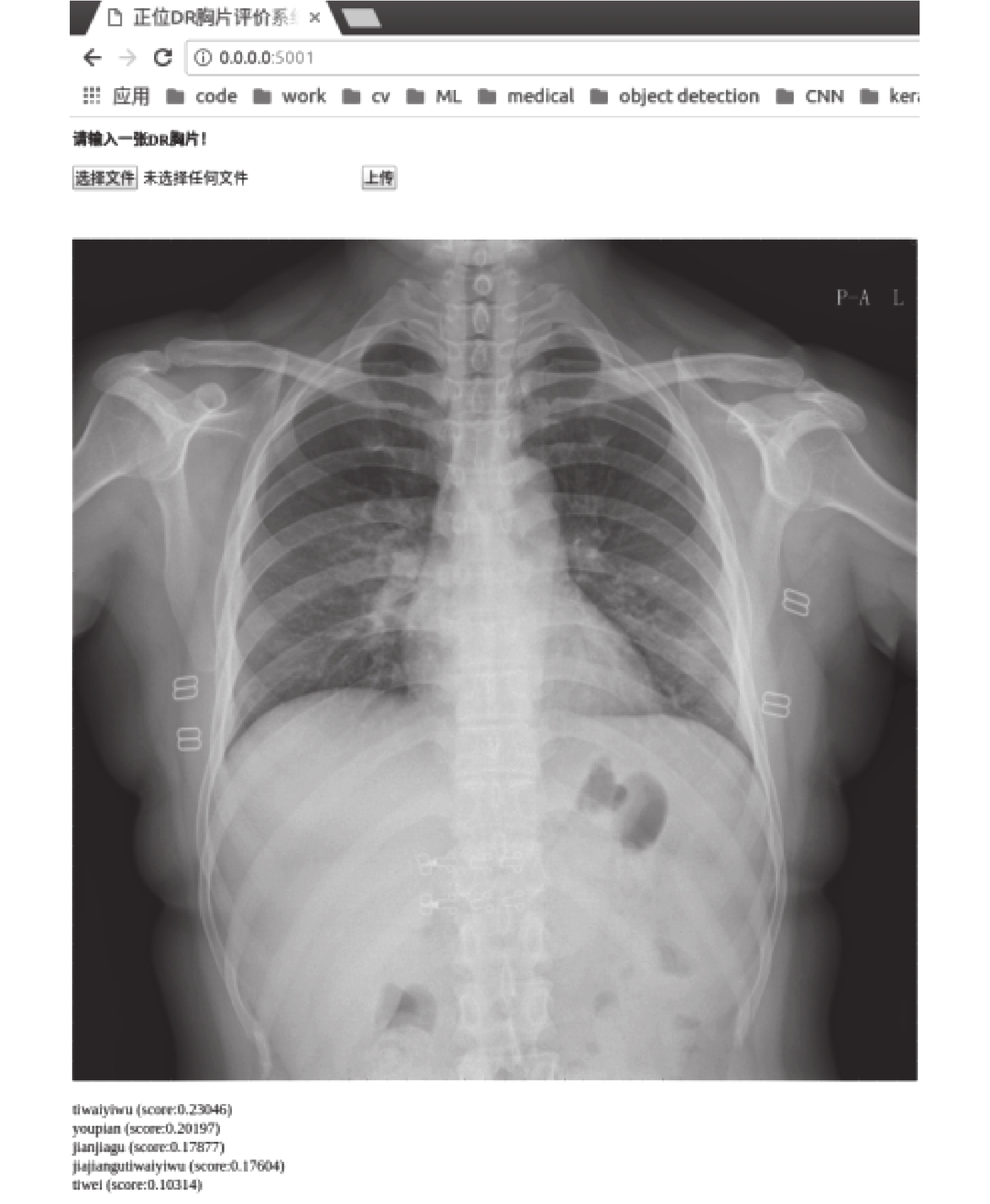

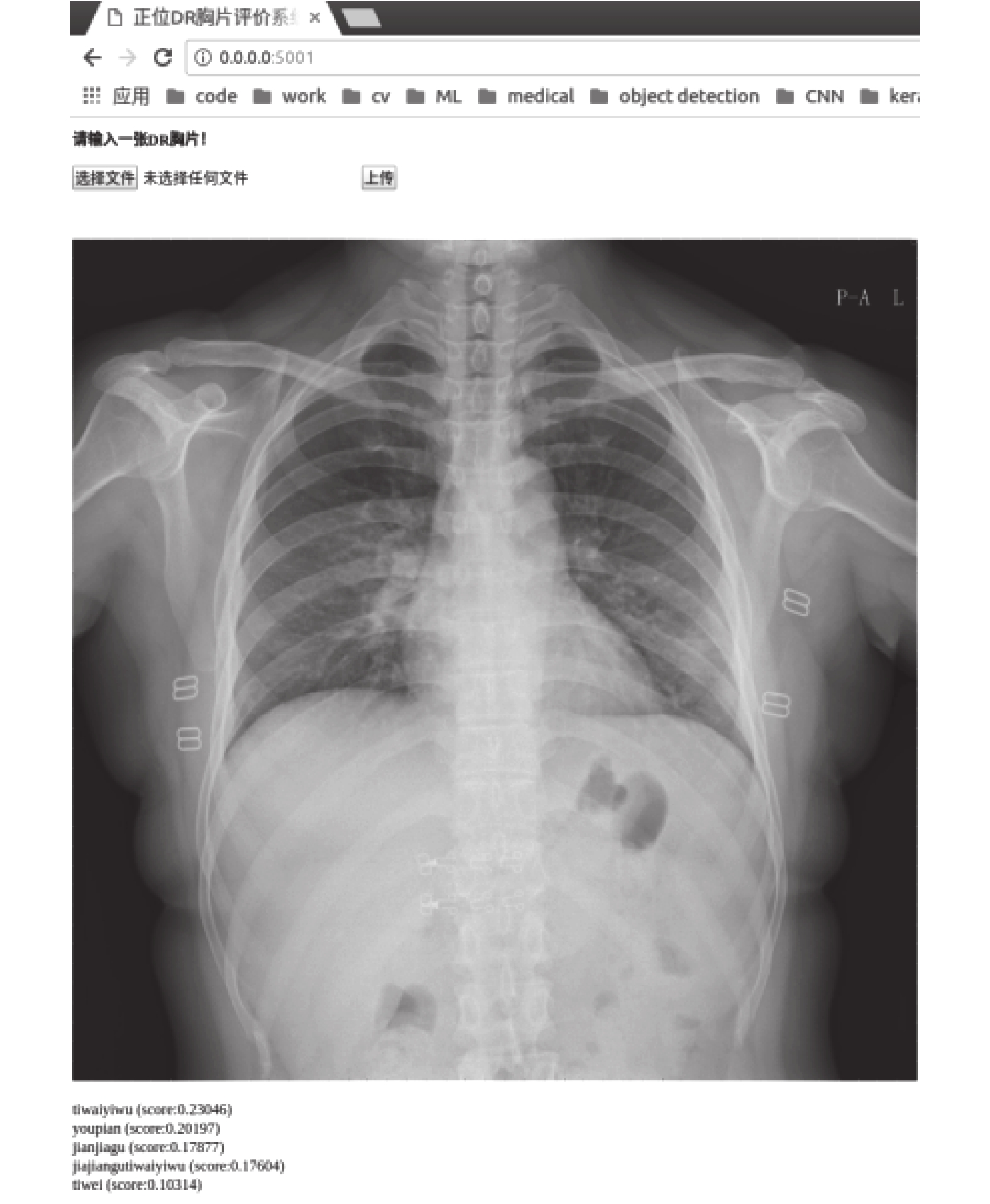

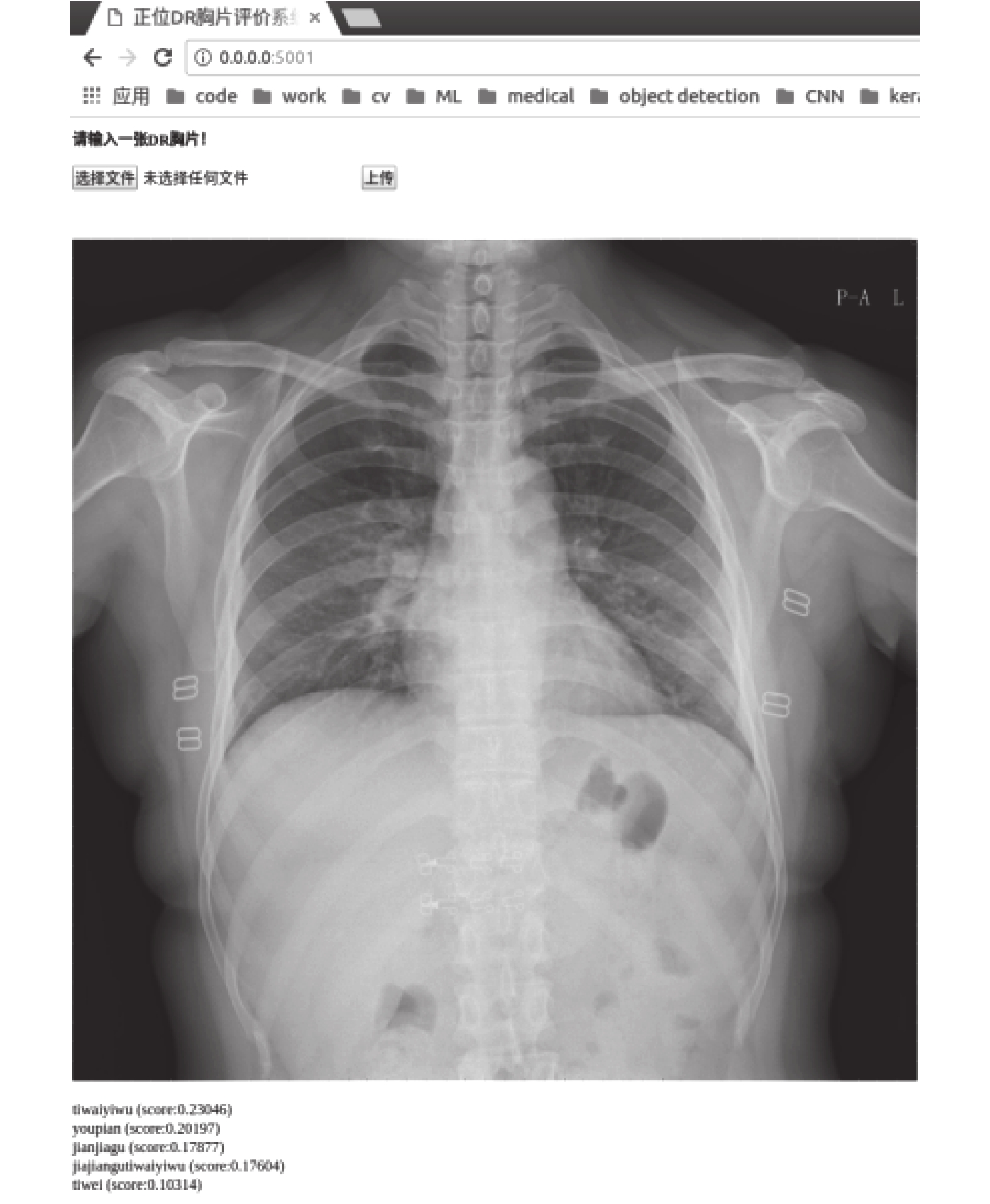

圖 8 所示為使用訓練好的 Inception-V4 分類模型在 web server 界面上展示的一次對有體外異物的正位 DR 胸片影像的識別測試案例。操作方法簡單,只需要打開模型測試生成的對應鏈接,從本地數據庫或云端數據庫選取要測試的胸片,就可以迅速得到測試結果。通過本分類模型測試,結果顯示體外異物的概率識別最大,概率值為 0.856,而無異物和體內異物的概率均小于體外異物的概率。

圖8

異物測試例圖

Figure8.

An example of foreign matter test example

圖8

異物測試例圖

Figure8.

An example of foreign matter test example

(2)判斷體外異物的位置:根據拍片需求,進一步判斷體外異物的位置在肺野區域內部或肺野區域外部。經過第(1)步中的分析,已經可以判斷出是體外異物還是體內異物,而體內異物是在拍攝過程中無法規避的研究點,因此不做進一步詳細研究。但是,體外異物因特征形態多樣,對診斷影響較大,因此需要進一步研究。

通常情況下,拍攝正位 DR 胸片主要是為了診斷肺野內部組織,肺野內部的異物對診斷影響更大;而肺野外部一般不是診斷主要區域,對診斷的影響不是很大。因此,分析體外異物的位置對醫生診斷很有幫助。

本次研究通過控制不同參數的大小對 1 881 張正位 DR 胸片進行模型訓練,其中異物在肺野內部的數據量 960 張,異物在肺野外部的數據量 921 張。在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機從每個類別中抽取數據分別組成訓練集和驗證集,即訓練集數據量為 1 693 張,驗證集為 188 張。模型中對驗證集數據測試得到的實驗結果如表 3 所示。

通過對體外異物位置分類模型中各項參數進行調節,使用模型中驗證集對模型的準確率進行自動測試,發現當參數 N_subimgs = 1 881,N_epochs = 50,batch_size = 5,IMG_WIDTH = IMG_HEIGHT = 1 024,stride_height = stride_width = 30 時,體外異物在肺野內部區域和外部區域兩種類型數據訓練出的二分類器識別精度最高,可以達到 0.923 8。

隨機使用 200 張各類別測試數據對訓練好的模型進行手動測試,對識別到的實際效果與初始分類好的數據庫進行對比分析,同時根據評片事實經驗進行分析,該分類模型的效果基本符合要求。

2.6 鎖骨、肩胛骨部位的圖像處理方法研究與實現

2.6.1 針對鎖骨部位

主要研究是否聳肩、體位是否偏移[23]。聳肩容易導致醫生對患者病情的誤診和漏診[24],體位偏移會從視覺上影響醫生的診斷[25],因此在拍片過程中,有必要對這兩個標準點進行控制,通過相關圖像處理算法計算,正確把控拍片者的體位擺放。

研究方法:

(1)針對聳肩情況:如圖 9 所示,獲取圖像中的連通域[26],并畫出每個連通域的外接矩形框,獲取每個區域的最大最小縱橫坐標值,計算出兩個鎖骨與水平線的夾角,即代表聳肩程度,只要有一個鎖骨夾角超過閾值,就可以判定為聳肩,此時系統會自動提示技師該患者聳肩,技師可以及時提醒患者。通過對數據集中全部 7 270 張圖像進行鎖骨傾斜角測試,統計結果如表 4 所示。

圖9

鎖骨區域研究方法幾何展示

Figure9.

Geometry display of clavicular region research method

圖9

鎖骨區域研究方法幾何展示

Figure9.

Geometry display of clavicular region research method

通過對大量數據的左右鎖骨傾斜角分別進行計算,可以發現 20~30° 之間的情況最多,結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,認為將聳肩閾值定為 30° 是比較合理的,超過 30° 就可以認為受檢者聳肩。

(2)針對體位情況:如圖 9 所示,獲取圖像中所有連通域,并畫出每個連通域的外接矩形框,這樣就可以獲取每個區域的最大最小縱橫坐標值,通過計算左邊鎖骨最大橫坐標和右邊鎖骨最小橫坐標的平均值 a,與拍攝影像的整體橫向中心點 b 進行比較,可以判斷患者在拍片過程中是否有體位偏移。

通過對數據集全部 7 270 張圖像進行體位測試,結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,認為 a-b 的絕對值大小在 150 個像素點范圍內,可認為體位正常;a-b 的絕對值大小超出 150 個像素點范圍,則認為體位有偏移。

2.6.2 針對肩胛骨部位

主要研究肩胛骨與肺野的重合度。技師在拍片過程中,正確的肩胛骨擺放姿勢可以使肩胛骨基本投射在肺野之外。由于肩胛骨的特征和肺野相近,如果兩者重合在一起,會導致醫生很難診斷重合區域的病灶,容易造成漏診和誤診[27]。因此,計算肩胛骨與肺野的重合率很重要,該模塊可以有效協助技師在拍片的時候將重合率盡量控制在合理閾值范圍內。

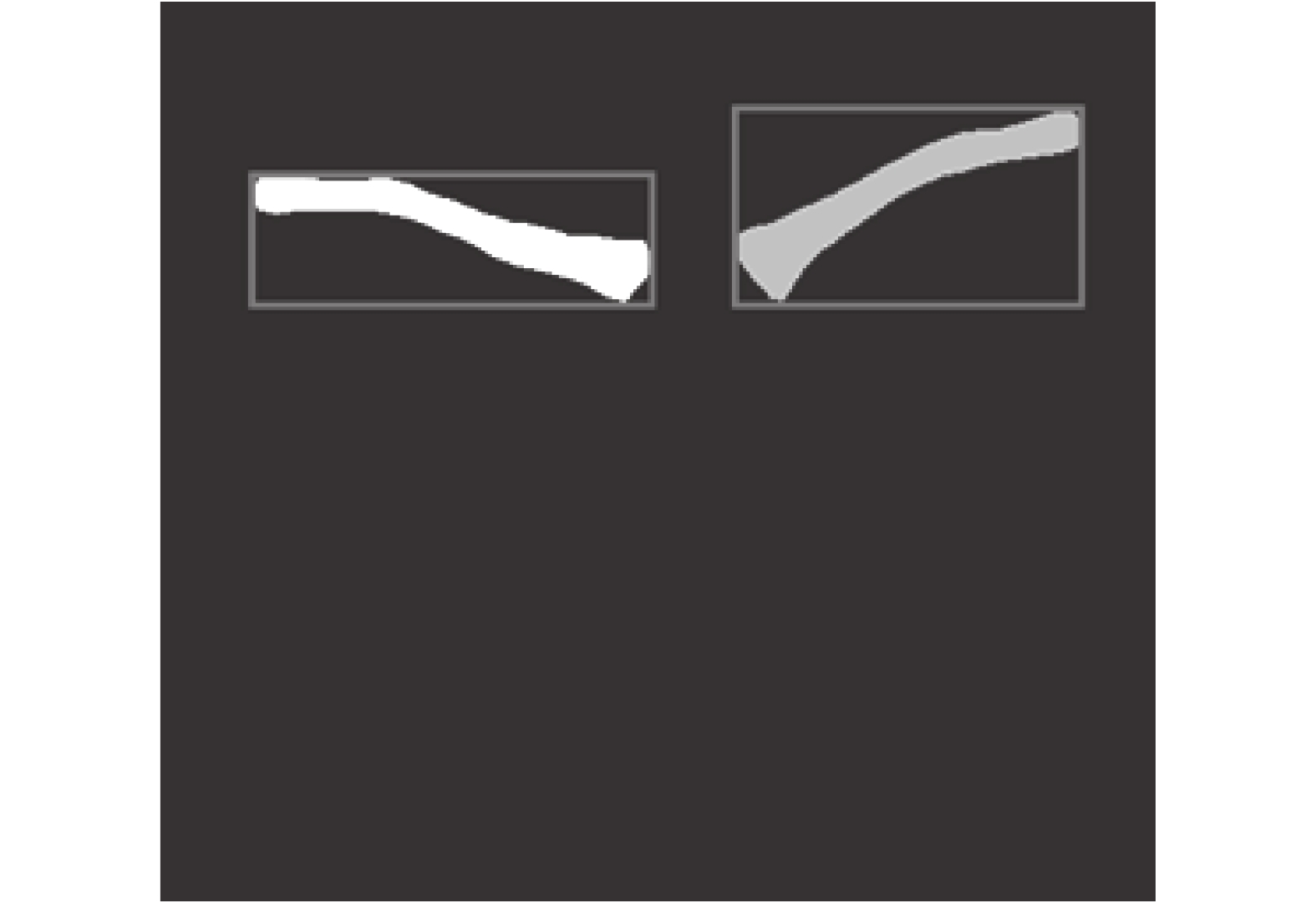

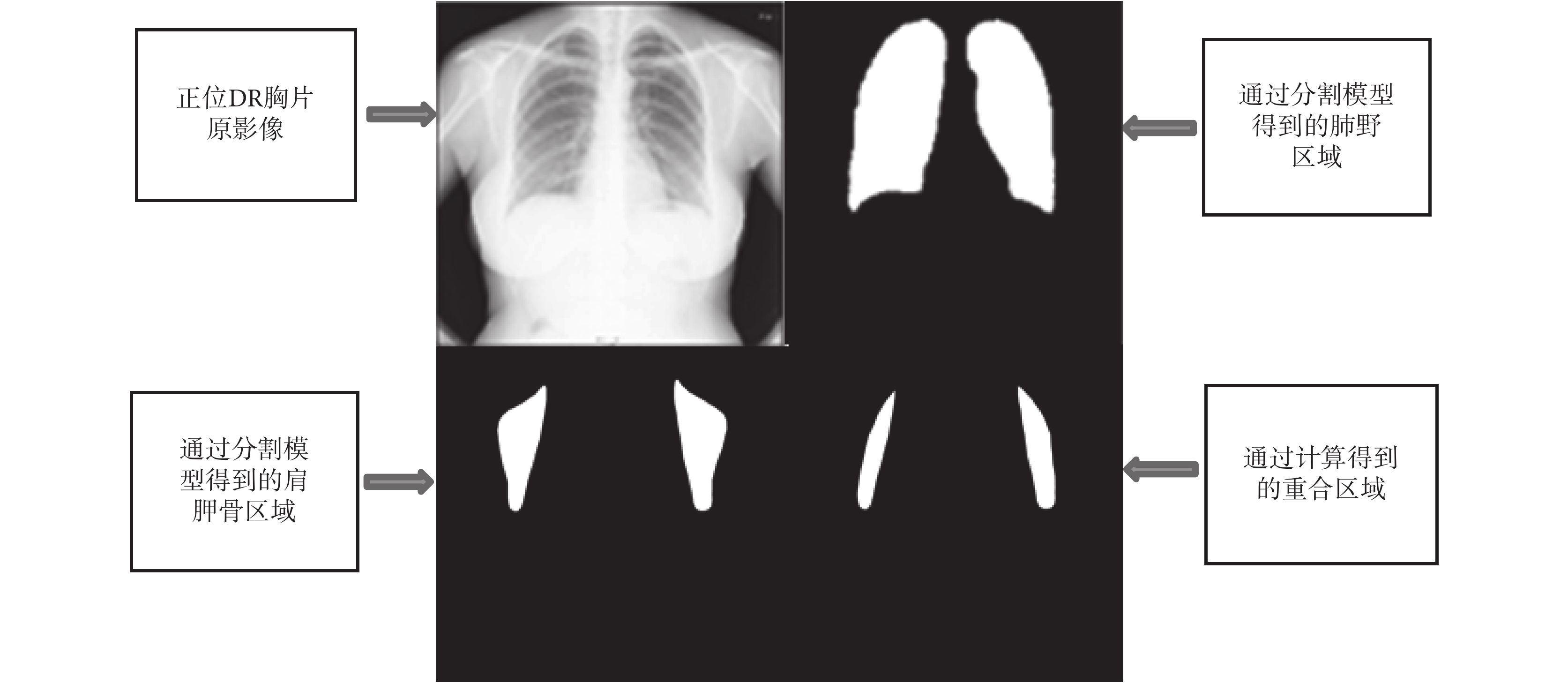

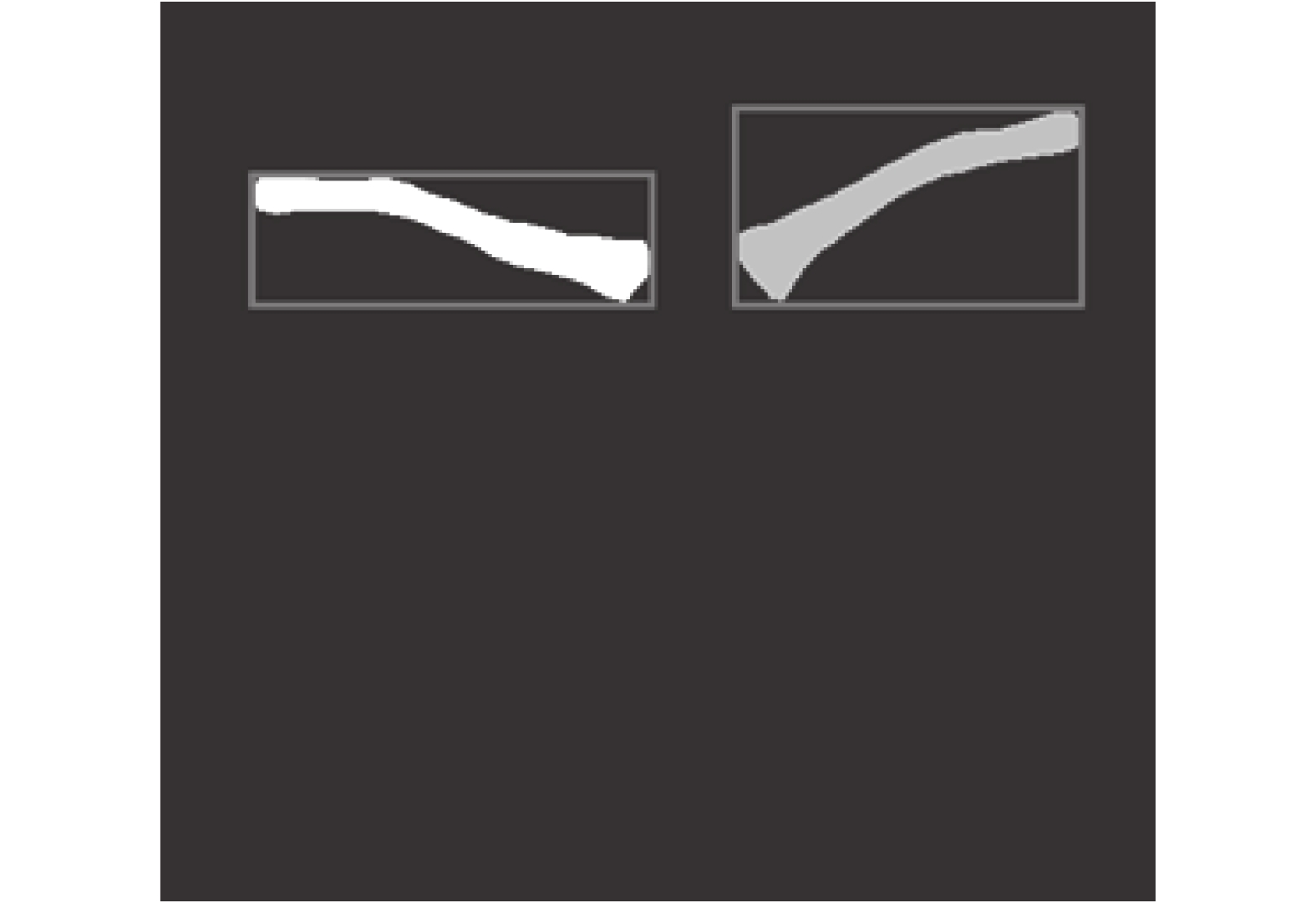

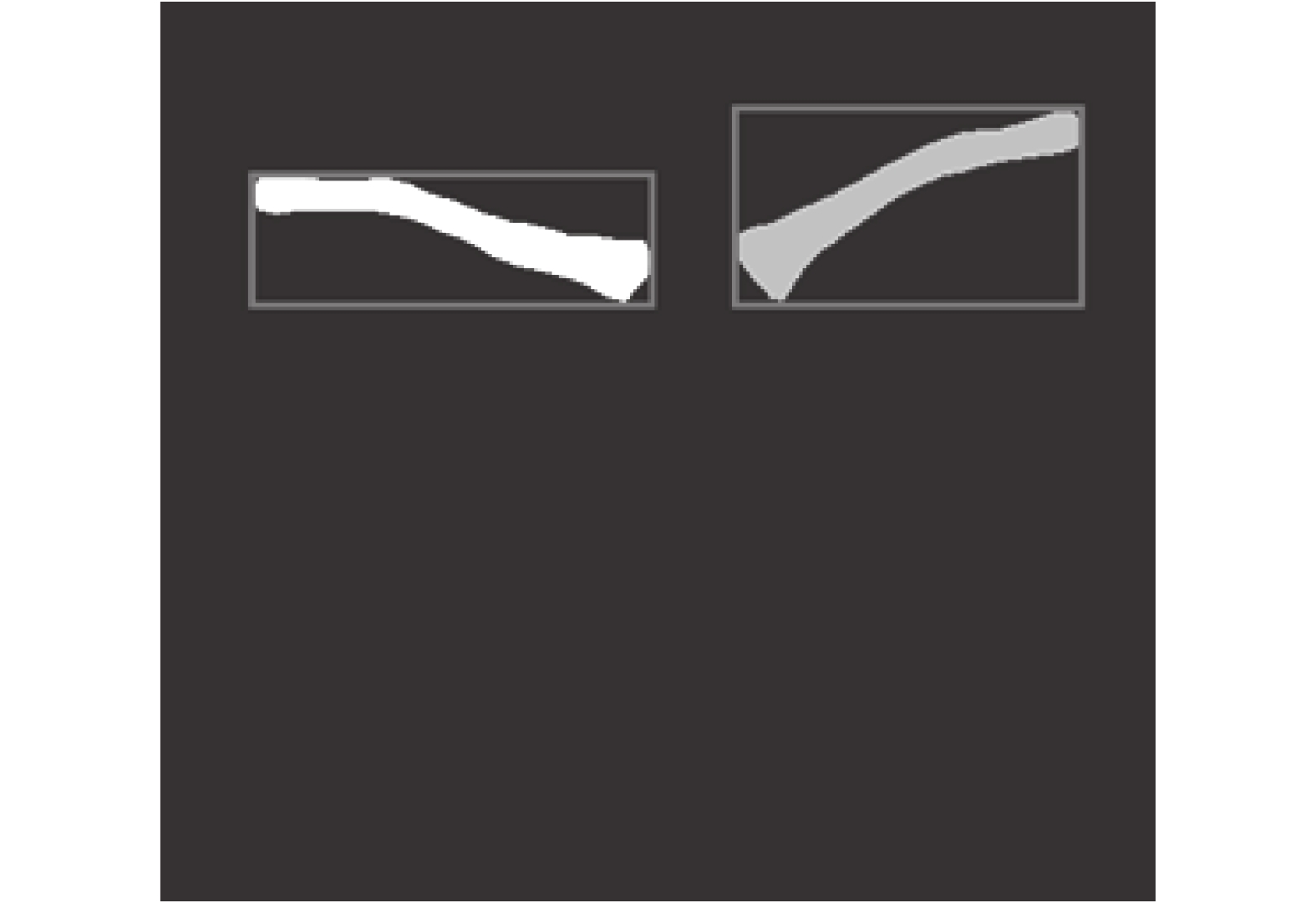

如圖 10 所示,四張小圖依次為為同一案例的正位 DR 胸片原影像、使用本研究中分割模型得到的肺野區域和肩胛骨區域,以及通過計算得到的重合區域。用重合區域面積除以肩胛骨區域面積,就得到了肩胛骨與肺野的重合率。通過對數據集中全部 7 270 張圖像進行重合率測試,發現重合率在 0 至 1/3 范圍內占總比為 0.295 4;重合率在 1/3 至 2/3 范圍內占總比為 0.517 0;重合率在 2/3 至 1 范圍內占總比為 0.187 6。結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,將滿足這三種情況的重合率依次定義為無重合、輕度重合和嚴重重合。

圖10

肩胛骨重合率研究方法

Figure10.

Method of scapula coincidence rate study

圖10

肩胛骨重合率研究方法

Figure10.

Method of scapula coincidence rate study

3 質控平臺展示

3.1 質控場景流程

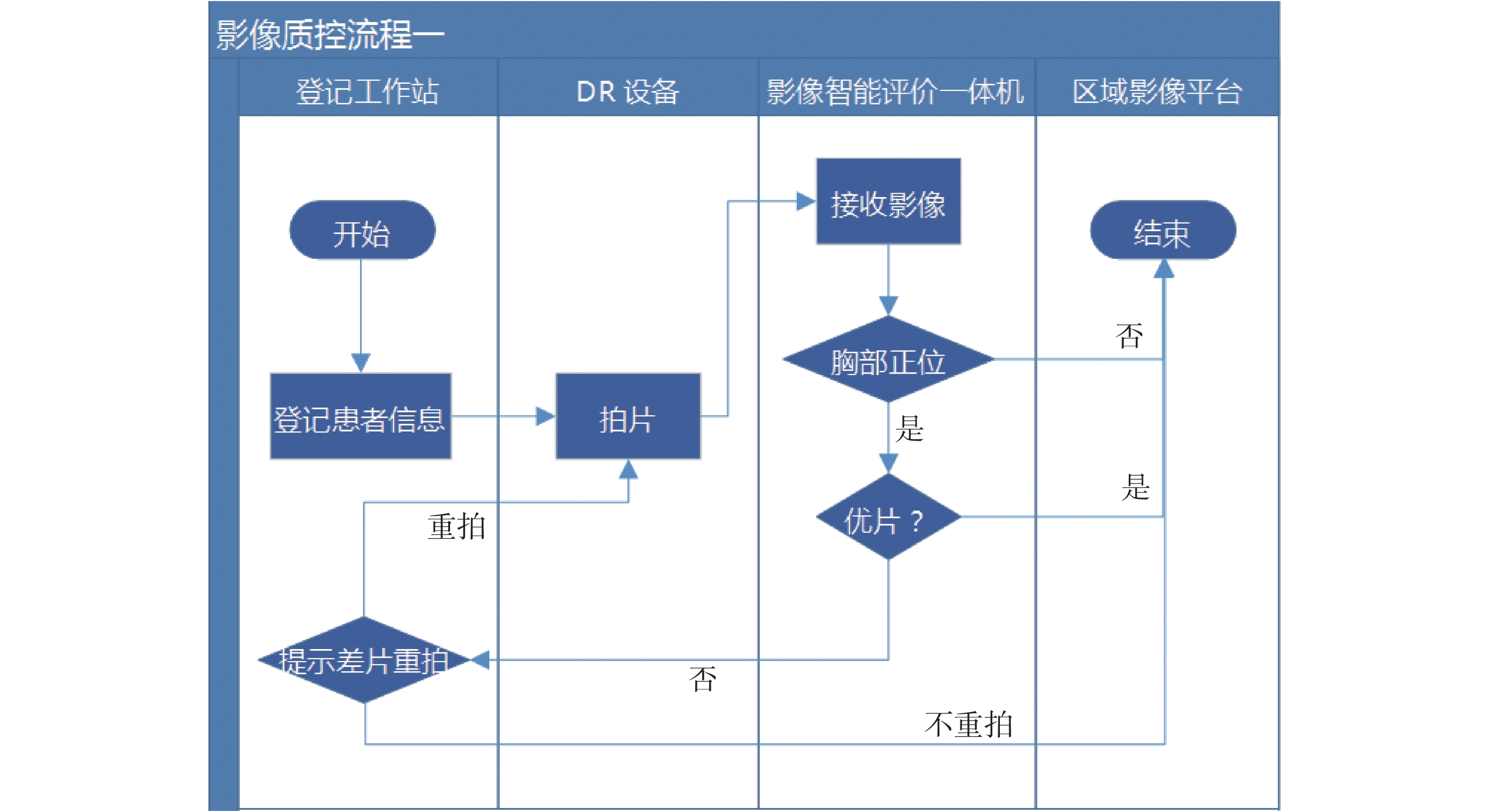

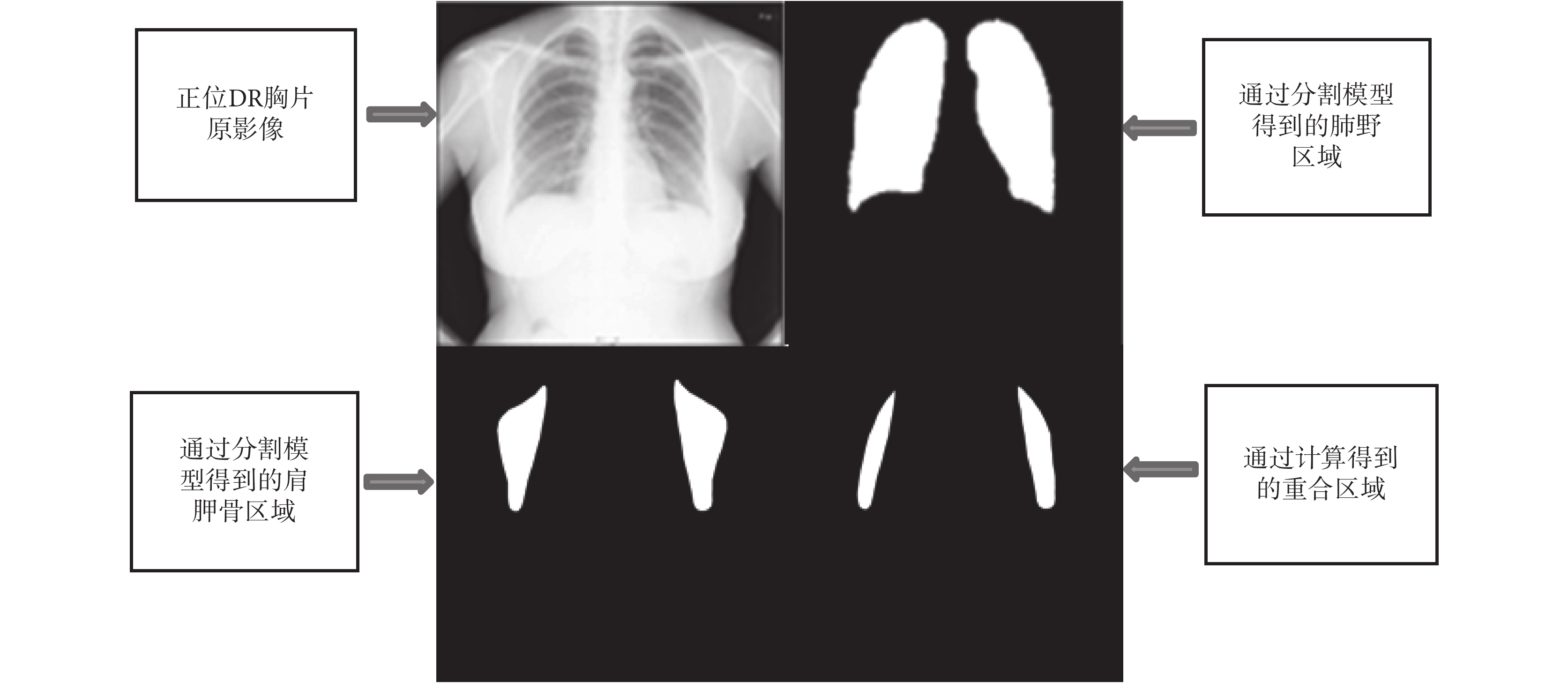

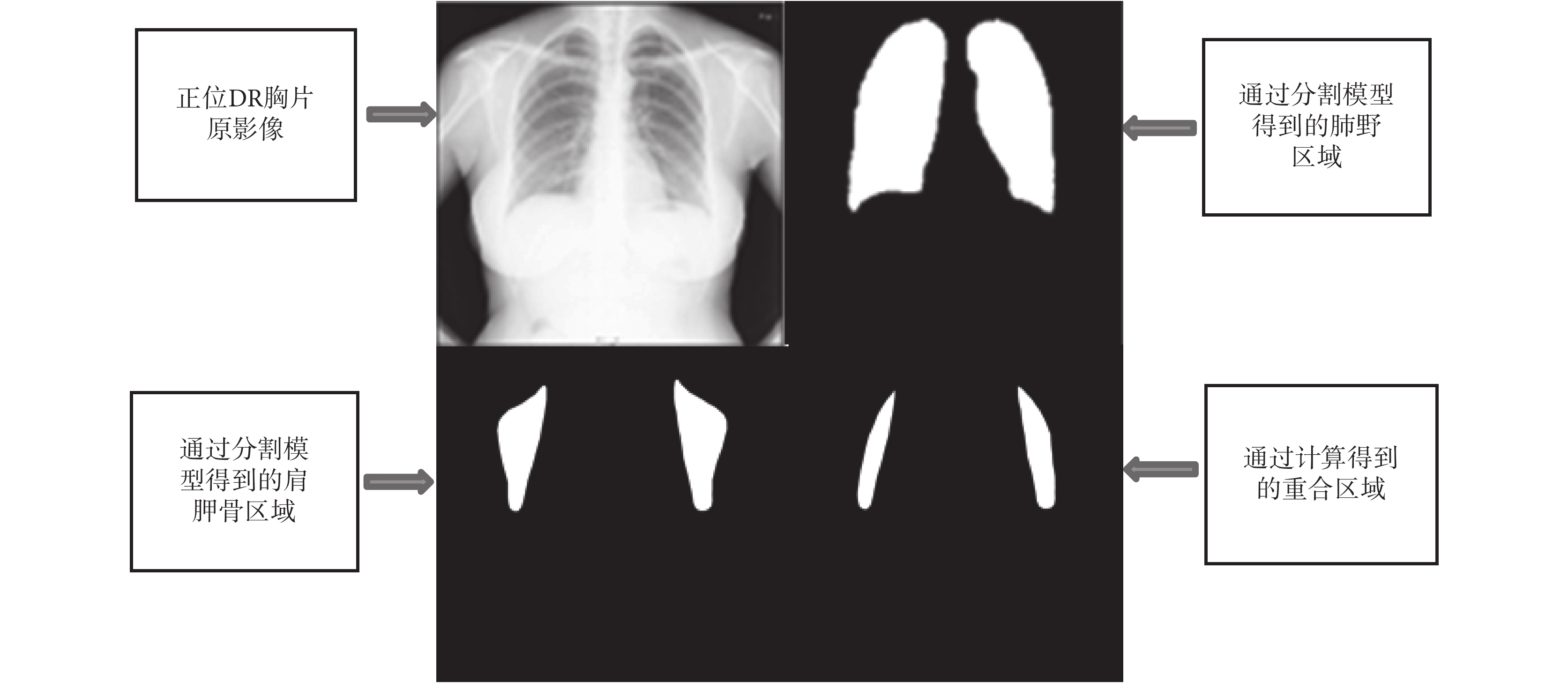

主要將質控場景分為四層,根據相互作用關系,各層依次為:登記工作站層、DR 設備層、影像智能質控評片一體機層和區域影像平臺,具體質控流程如圖 11 所示。

圖11

質控平臺使用場景流程圖

Figure11.

Quality control platform usage scenario

圖11

質控平臺使用場景流程圖

Figure11.

Quality control platform usage scenario

場景流程解析:

(1)基層患者在登記后,到放射科進行影像檢查;

(2)技師拍片完成后,將患者影像發送至正位 DR 影像質控平臺;

(3)正位 DR 影像質控平臺進行智能評片;

(4)評片通過后,將影像上傳至區域影像平臺;

(5)評片未通過,技師工作站提示技師重新拍片;

(6)重拍通過后,將影像上傳至區域影像平臺;

(7)將所有評片數據上傳至影像質控云平臺,用于數據分析和教學等。

3.2 案例展示及分析

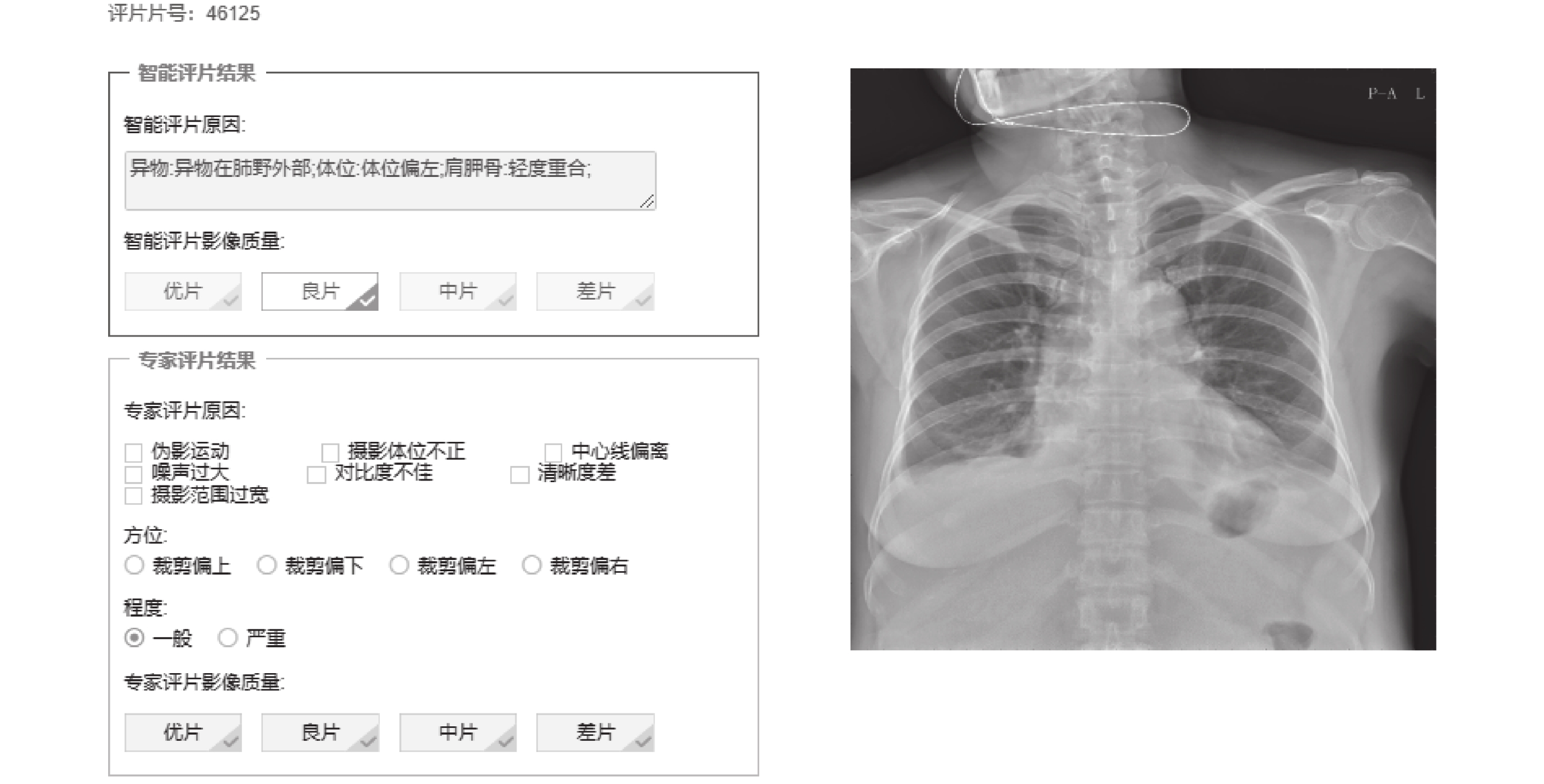

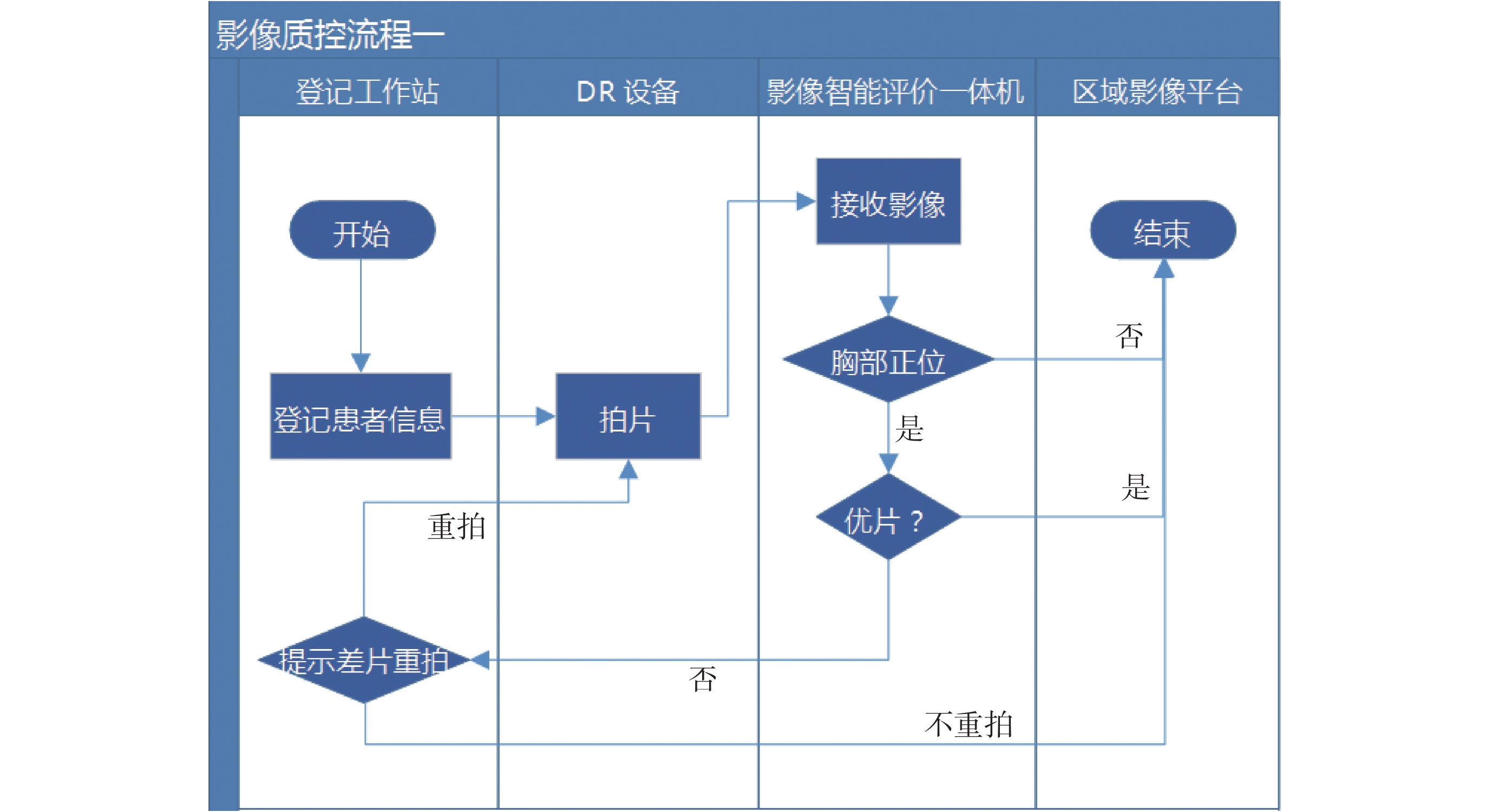

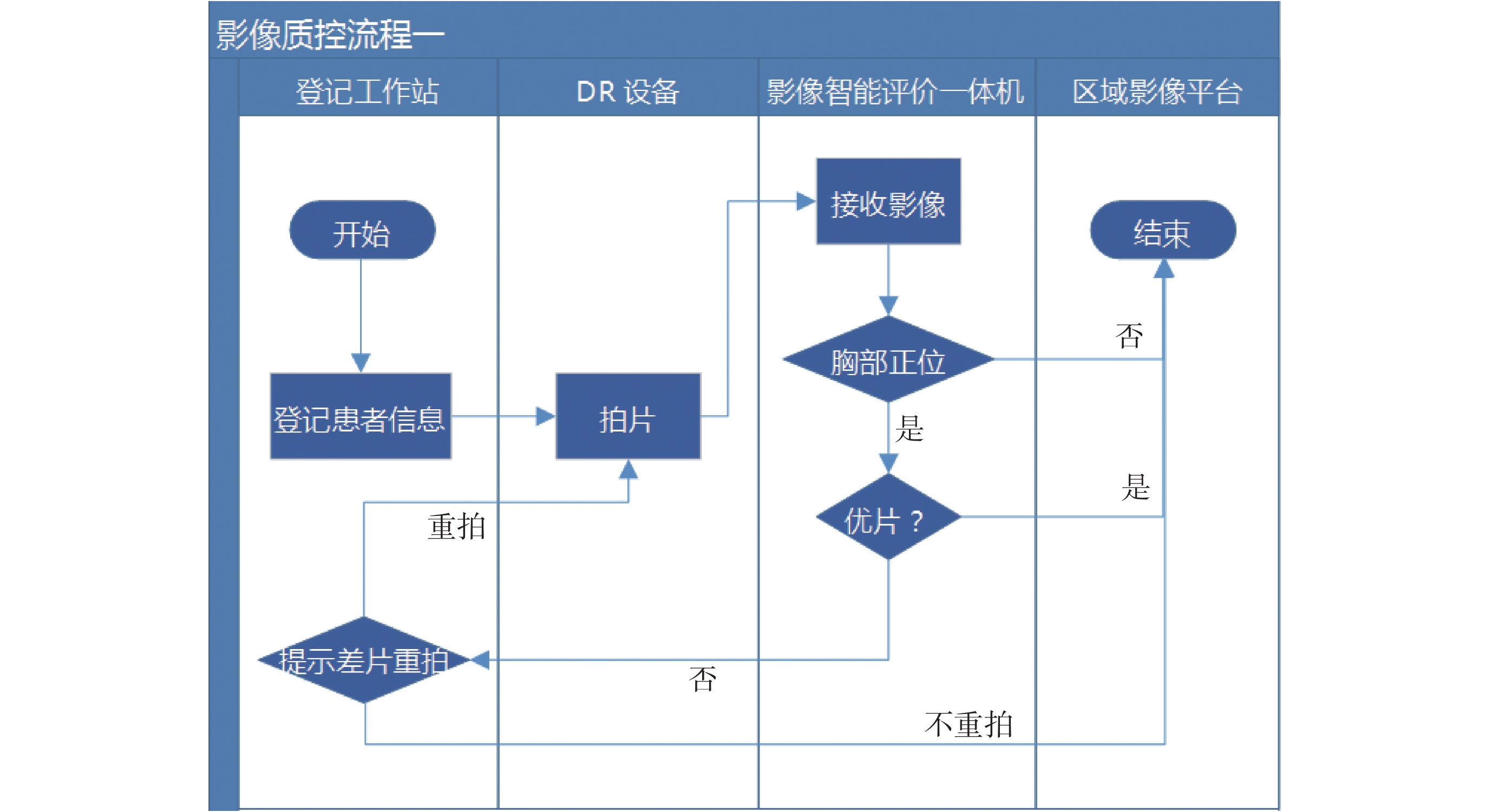

如圖 12 所示,為某位拍片受檢者在醫院放射科拍片現場中,通過質控智能平臺的測試,得到的實際測試結果。可以看到平臺界面上方為智能評片結果及原因分析展示,該框內是經過智能質控系統測試自動生成的結果,不可在界面上進行修改,并且智能測試結果及原因分析是嚴格按照圖 5 中的質控標準信息統計表得到的。界面下方為專家評片結果展示,專家結合主觀評片經驗,并通過手動點擊操作,勾選出專家認為存在問題的評片原因和胸片質量等級。

圖12

質控平臺界面

Figure12.

Quality control platform interface

圖12

質控平臺界面

Figure12.

Quality control platform interface

通過以上案例,可以看到該受檢者存在體外異物,但是體外異物的位置在肺野外部,因此影響很小;體位稍微偏左;無聳肩;肩胛骨與肺野輕度重合。綜合對以上非正常原因進行考量,該胸片在通過智能評片系統測試后,評片等級為“良”,智能評片結果符合實際情況。

4 總結和展望

本文以四川大學華西醫院放射科技師的醫學影像質量主觀評價為基礎,通過對采集到的正位 DR 胸片數據進行標注,結合深度學習圖像分割模型、分類模型和傳統圖像處理算法,開發出了一套能實現輔助拍片功能的智能質控系統,并將該系統成功應用到了華西醫院和其他市、縣級醫院的放射科,有效驗證了該質控系統的可行性與穩定性。

目前,深度學習圖像處理方法在醫學領域的應用正處于發展期,未來深度學習在醫療影像領域將會有更廣闊的應用,每一項技術的成熟和突破都是人們不斷嘗試、創新和完善的過程。當前,無論是計算機硬件技術還是醫學攝影技術,都為深度學習處理醫學影像問題提供了很好的基礎條件。當然,雖然深度學習可以更好地輔助醫生診斷諸多疾病,在診斷環節中幫助醫生快速判斷,為醫生提供建議[28],但它并沒有實現全智能,沒有人類的思維,很難代替人類醫生,畢竟深度學習的研究需要依賴大量數據樣本,而對于疾病而言,其變異性往往是不可控的。因此,深度學習方式在實際應用中依然會面臨很多問題。總之,深度學習的自學習優勢,使得在特征提取的同時,提升了分類效果。相信隨著深度學習方法的不斷成熟和完善,可以在未來的醫學影像分析中為疾病診斷提供更好的輔助作用[29]。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

引言

醫療事業關乎人民的生命健康,利用好龐大的醫療數據對提高醫療服務水平至關重要[1]。目前,醫療數據應用中仍然存在著很多問題,例如:數據類型多種多樣,包括圖、文、視頻、磁等;由于使用的設備不同,數據的質量存在較大差異;數據呈現波動特征,隨時間和特定事件變化;由于個體存在差異,病癥的規律沒有普遍適用性等。醫學影像是醫療數據中十分重要的組成部分,其質量好壞直接影響著臨床診斷和治療。建立有效的圖像質量評價機制,對于臨床醫學圖像處理技術[2]具有重大的應用價值。在圖像質量評價領域中,實現圖像質量評估的核心點是提取出能反映圖像某種特性的特征[3]。圖像質量的評價就是指采用特征提取的方法對圖像質量進行測度[4],評價圖像是否符合相應的標準。

目前國內外針對 X 射線、直接數字平板 X 線成像系統(digital radiography,DR)、計算機體層攝影(computed tomography,CT)和磁共振成像(magnetic resonance imaging,MRI)等各類型醫學影像,已建立了一套社會公認的醫學影像質量標準評價體系和方法,這些質控標準都是國內外醫生和相關專家們經過長期的臨床經驗總結出來的,且具有信息覆蓋全面、合理可行等特點。但是,這些質控標準的實際執行過程只停留在人工參考的層面,并沒有通過計算機算法將這些標準進行量化和智能質控,從而達到真正意義上的輔助拍片效果。因此本研究擬提出具有輔助拍片功能的智能質控系統,對于醫療影像質量的評價和醫療診斷質量的提高都將具有重要意義。

自 2006 年起,深度學習就作為機器學習領域的一個分支出現在人們的視野中[5],它是一種使用多層復雜結構或由多重非線性變換構成的多個處理層進行數據處理的方法。近年來,深度學習在計算機視覺、語音識別、自然語言處理、音頻識別與生物信息學等領域取得了突破性進展[6]。本文研究重點是制定合理可行的胸部正位 DR 醫學影像質控標準,并結合對深度學習領域中的醫療圖像分割算法、圖像分類算法和傳統圖像處理算法的研究,最終實現對正位 DR 胸片的質量評價與控制。本文使用 U-Net 圖像分割模型實現目標區域分割,該模型在其他醫學圖像分割領域取得過優秀的成績;同時使用 Inception-V4 模型實現圖像分類,該模型以其優秀的模塊結構和高效性得到了廣泛應用。

1 質控體系架構設計

根據本文的研究思路,結合實際應用情況,總結出的質控體系架構設計路線如圖 1、圖 2、圖 3 所示。

圖1

正位 DR 數據篩選及區域分割流程

Figure1.

Filter of positive-bit DR data and regional segmentation process

圖1

正位 DR 數據篩選及區域分割流程

Figure1.

Filter of positive-bit DR data and regional segmentation process

圖2

深度學習分類模型對異物的判斷流程

Figure2.

The process of judging the foreign object by the deep learning classifier

圖2

深度學習分類模型對異物的判斷流程

Figure2.

The process of judging the foreign object by the deep learning classifier

圖3

圖像處理算法對拍片擺位的判斷流程

Figure3.

Image processing algorithm for the judgment process of film placement

圖3

圖像處理算法對拍片擺位的判斷流程

Figure3.

Image processing algorithm for the judgment process of film placement

如圖 1 所示,首先篩選出本文要研究的正位 DR 胸片,然后使用深度學習圖像分割模型對左右肺野區域、左右鎖骨區域和左右肩胛骨區域進行分割,便于進一步的深度學習分類模型研究和傳統圖像處理算法研究。

如圖 2 所示,依次使用了兩個深度學習分類模型。首先使用深度學習四分類器實現了異物類型的判斷,然后使用深度學習二分類器對體外異物的位置做出了判斷。

如圖 3 所示,使用傳統圖像處理算法分別對聳肩傾角、體位偏移量和肩胛骨重合度進行計算,提供了對拍攝體位判斷的量化依據。

2 研究方法

2.1 研究模塊

本文研究模塊包括:① 脫敏處理的正位 DR 醫學影像(本研究中使用的所有數據均是對個人敏感信息過濾處理后的純醫學影像)數據[7]收集;② 使用標注工具對研究區域輪廓進行手動標注[8];③ 使用 U-Net 分割模型[9-10]對 DR 正位胸片的左右肺野、左右鎖骨、左右肩胛骨等六個區域進行分割;④ 使用卷積神經網絡(convolutional neural networks,CNN)模型[11-12]針對特定數據進行有效分類判斷,模塊如圖 4 所示。

圖4

醫學影像質控體系研究方法模塊圖

Figure4.

Module diagram of quality control system of medical image

圖4

醫學影像質控體系研究方法模塊圖

Figure4.

Module diagram of quality control system of medical image

2.2 正位 DR 胸片數據質量評價控制標準

本次正位 DR 醫學影像質控體系研究過程中的首要核心任務為確定一套科學可行的質控評價標準,經過不斷實驗測試和改進,最終確定并使用的正位 DR 胸片數據質量評價控制標準如圖 5 所示。

圖5

質控標準信息統計

Figure5.

Statistics of quality control standard information

圖5

質控標準信息統計

Figure5.

Statistics of quality control standard information

圖 5 中的質控標準信息主要包括:異物、體位規范和肩胛骨擺位規范,且質控標準點都是技師在拍片過程中主要關注的評判點,只有當拍片質量都符合這些標準,醫生在閱片過程中才能做出更加精確的診斷。此外,這些質控標準點都可以用相應的深度學習算法和圖像處理算法完成和實現,可行性較高且準確率良好。

2.3 正位 DR 胸片數據收集與標注

2.3.1 數據收集

從四川大學華西醫院放射科[13]收集了 6 770 位受檢者的正位 DR 胸片,收集到的數據包括:優片、體外異物、體內異物[14]、鎖骨聳肩、體位不正、肩胛骨擺位不正[15]等各類情況,且部分受檢者同時存在以上中多種情況;此外,由于體內異物的情況很少存在,因此通過手動制作擴充體內異物數據 500 張,使數據集總數達到 7 270 張。各類別正位 DR 醫學影像具體數量為:2 300 張優片、2 000 張體外異物、1 000 張體內異物、850 張聳肩、1 250 張體位偏移、1 500 張肩胛骨擺位不正。

2.3.2 數據標注

作者團隊和華西醫院放射科技師嚴格圍繞制定的質控標準,使用標注工具對數據中的研究區域進行標注,標注編號依次代表:① 左肺野;② 右肺野;③ 左鎖骨;④ 右鎖骨;⑤ 左肩胛骨;⑥ 右肩胛骨(此處標注的左右是指圖像顯示的左右,與實際人體結構方位相反,但不影響最終智能評片結果),標注效果如圖 6 所示。

圖6

正位 DR 胸片影像標注效果展示

Figure6.

Annotation effect display of positive DR chest image

圖6

正位 DR 胸片影像標注效果展示

Figure6.

Annotation effect display of positive DR chest image

2.4 正位 DR 胸片分割流程

2.4.1 數據集準備

首先,將標注工具生成的 json 文件解析為可用的數據集;然后,制作模型可用的數據集,用于訓練和測試分割模型的各類數據共 6 200 張,其中訓練過程中的數據量為 6 000 張,手動測試集為 200 張,并按照分割模型需要的數據存放規則對訓練集和測試集進行分類歸檔。

2.4.2 深度學習分割模型選擇

近些年,隨著深度學習領域的圖像分類模型、分割模型在圖像處理方面的不斷拓新和應用,誕生出了一系列優秀的圖像分割模型,對于圖像的分析不僅限于圖像的灰度值信息和邊緣信息,而是深入研究圖像更深層次的局部抽象信息,對于圖像特征信息有了更全面的提取和分析。

目前,深度學習圖像分割領域已經誕生了一些表現優秀的圖像分割網絡模型,如全卷積神經網絡(fully convolutional networks,FCN)分割網絡模型[16]、Mask RCNN 目標分割模型[17]和 U-Net 分割模型[18]等。這些模型都有各自的特點,并均在特定領域取得過突出的成績。

本研究使用的是 U-Net 分割模型,該網絡是一個基于 CNN 的圖像分割網絡,主要用于醫學圖像分割,依靠數據增強可以讓標注數據得到更為有效的使用。網絡最初提出時是用于細胞壁分割,之后在肺結節檢測以及眼底視網膜圖像的血管提取等方面都有著出色的表現。該分割模型網絡由收縮路徑和擴張路徑組成。其中,收縮路徑用于獲取上下文信息,擴張路徑用于精確的定位,且兩條路徑相互對稱。該網絡能夠采用極少圖像端對端進行訓練,運行速度非常快,在圖形處理器(graphics processing unit,GPU)上分割一張 512 × 512 的圖像不到一秒即可完成。

2.4.3 模型訓練和測試效果

使用 U-Net 分割模型針對三個不同部位的六個區域分別進行模型訓練,通過不斷測試和調參,調試出符合各自部位的最優模型,針對優片的肺野區域、鎖骨區域、肩胛骨區域等六個區域的圖像分割[19]測試效果如圖 7 所示。

圖7

肺野區域、鎖骨區域、肩胛骨區域分割效果

Figure7.

Segmentation effect of lung field area, clavicular area, and scapula area

圖7

肺野區域、鎖骨區域、肩胛骨區域分割效果

Figure7.

Segmentation effect of lung field area, clavicular area, and scapula area

本次研究通過控制不同參數的大小對 6 000 張正位 DR 胸片進行模型訓練,在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機抽取數據分別組成訓練集和驗證集,即訓練集數據量為 5 400 張,驗證集為 600 張。可控參數包括:① N_subimgs:訓練樣本數量;② N_epochs:訓練次數;③ batch_size:單批訓練樣本數;④ IMG_WIDTH、IMG_HEIGHT:訓練樣本圖像的寬度和高度;⑤ stride_height、stride_width:池化矩陣移動縱向橫向步長;⑥ One_time:單次訓練時間;⑦ AUC:曲線下面積,即受試者操作特征(receiver operating characteristic,ROC)曲線下與坐標軸圍成的面積;⑧ Accuracy:模型準確率。測試得到的實驗結果如表 1 所示。

通過對異物分類模型中各項參數進行調節,使用模型中驗證集對模型準確率的自動測試發現,當參數 N_subimgs = 1 800、N_epochs = 50、batch_size = 2、IMG_WIDTH = 1 024、IMG_HEIGHT = 1 024、stride_height = 30、stride_width = 30 時,肺野和鎖骨的分割精度均最高。當其他參數保持不變,IMG_WIDTH = 512、IMG_HEIGHT = 512 時,肩胛骨的分割精度最高。各區域的分割準確率依次可以達到:肺野為 0.934 6、鎖骨為 0.922 5、肩胛骨為 0.901 8。

隨機使用 200 張測試數據對訓練好的分割模型進行手動測試,對分割出來的實際效果與原手工標注的輪廓進行重合度分析,同時根據評片主觀經驗進行分析,發現該分割模型的效果基本符合要求,針對一些多余或者殘缺的錯誤可以通過傳統圖像后處理算法進行填充修補和消除,從而不斷優化模型。

2.5 肺野部位的 CNN 分類模型研究與實現

2.5.1 分類模型網絡選擇

Inception 網絡是 CNN 分類器進化過程中很重要的里程碑,在其誕生之前,大部分 CNN 網絡僅僅是不斷增加網絡深度以期望得到更佳的分類識別效果,但這樣做只會成倍增加網絡參數,降低計算效率。Inception 網絡最大的創新之處是使用了 Inception 模塊實現了一種具有優良局部拓撲結構的網絡,即對輸入圖像并行地執行多個 1 × 1、3 × 3 或 5 × 5 等不同尺寸的卷積運算或池化操作,通過增加網絡深度和寬度,從而獲取圖像的不同細節信息,并將所有輸出結果拼接為一個非常深的特征圖。

本研究使用的是 Inception-V4 網絡[20],其網絡架構可以用很低的計算成本達到很高的性能,其設計主要沿用了之前 V2、V3 中提到的 CNN 網絡設計原則。Google team 將 V4 網絡執行遷移到了 tensorflow 上來執行,因此可不必再像之前在 DistBelief 上那樣,受限于他們所用系統的內存較小、計算量大等局限而只在幾種可行的范圍里選擇 Inception 通用模塊。簡單地說就是利用 tensorflow 天生的并行性,設計數據并行(data parallel)與模型并行(model parallel)的網絡。

2.5.2 主要研究點的分類模型測試結果及分析

(1)判斷正位 DR 胸片的異物類型:技師在 DR 拍片過程中經常能觀察到一些異物,會在整體或局部影響到醫生的診斷,甚至導致誤診。其中,體內異物是無法避免的情況,常見的有心臟起搏器[21]、胸腔肋骨固定夾和脊椎固定架[22],本模型可以自動檢測出體內異物,有效幫助技師再次確認是否存在體內異物,可以有效防止這類異物造成的誤診。體外異物則是應避免的情況,常見的有內衣、金屬佩戴物等,這類異物形態特征多樣,很容易和某些疾病混淆或者遮擋住某些疾病特征,導致醫生的誤診、漏診。本模型可以有效檢測出體外異物,節約時間成本和醫療資源。

本次研究通過控制不同參數的大小對 3 050 張正位 DR 胸片進行模型訓練,其中無異物數據量 1 300 張,體外異物數據量 800 張,體內異物數據量 500 張,體內外均有異物數據量 450 張。在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機從每個類別中抽取數據分別組成訓練集和驗證集,即訓練集數據量為 2 745 張,驗證集為 305 張。模型中對驗證集數據測試得到的實驗結果如表 2 所示。

通過對異物分類模型中各項參數進行調節,使用模型中驗證集對模型準確率的自動測試發現,當參數N_subimgs = 2 515、N_epochs = 80、batch_size = 5、IMG_WIDTH = 1 024、IMG_HEIGHT = 1 024、stride_height = 30、stride_width = 30 時,判斷正位 DR 胸片中異物類型的四分類器的分類準確率相對最高,可以達到 0.926 5。

隨機使用 200 張各類別測試數據對訓練好的模型進行手動測試,對識別到的實際效果與初始分類好的數據庫進行對比分析,同時根據評片事實經驗進行分析,結論為該分類模型的效果基本符合要求。其中,模型對體外異物和心臟起搏器的檢測準確率較高,但是對胸腔肋骨固定夾、脊椎固定架等異物檢測率較低,這是由于固定夾這類異物的特征和周圍骨頭的特征相近以及數據量少等原因所致。

圖 8 所示為使用訓練好的 Inception-V4 分類模型在 web server 界面上展示的一次對有體外異物的正位 DR 胸片影像的識別測試案例。操作方法簡單,只需要打開模型測試生成的對應鏈接,從本地數據庫或云端數據庫選取要測試的胸片,就可以迅速得到測試結果。通過本分類模型測試,結果顯示體外異物的概率識別最大,概率值為 0.856,而無異物和體內異物的概率均小于體外異物的概率。

圖8

異物測試例圖

Figure8.

An example of foreign matter test example

圖8

異物測試例圖

Figure8.

An example of foreign matter test example

(2)判斷體外異物的位置:根據拍片需求,進一步判斷體外異物的位置在肺野區域內部或肺野區域外部。經過第(1)步中的分析,已經可以判斷出是體外異物還是體內異物,而體內異物是在拍攝過程中無法規避的研究點,因此不做進一步詳細研究。但是,體外異物因特征形態多樣,對診斷影響較大,因此需要進一步研究。

通常情況下,拍攝正位 DR 胸片主要是為了診斷肺野內部組織,肺野內部的異物對診斷影響更大;而肺野外部一般不是診斷主要區域,對診斷的影響不是很大。因此,分析體外異物的位置對醫生診斷很有幫助。

本次研究通過控制不同參數的大小對 1 881 張正位 DR 胸片進行模型訓練,其中異物在肺野內部的數據量 960 張,異物在肺野外部的數據量 921 張。在模型訓練前,模型會自動按照參數設定的 9∶1 數據比例分布,隨機從每個類別中抽取數據分別組成訓練集和驗證集,即訓練集數據量為 1 693 張,驗證集為 188 張。模型中對驗證集數據測試得到的實驗結果如表 3 所示。

通過對體外異物位置分類模型中各項參數進行調節,使用模型中驗證集對模型的準確率進行自動測試,發現當參數 N_subimgs = 1 881,N_epochs = 50,batch_size = 5,IMG_WIDTH = IMG_HEIGHT = 1 024,stride_height = stride_width = 30 時,體外異物在肺野內部區域和外部區域兩種類型數據訓練出的二分類器識別精度最高,可以達到 0.923 8。

隨機使用 200 張各類別測試數據對訓練好的模型進行手動測試,對識別到的實際效果與初始分類好的數據庫進行對比分析,同時根據評片事實經驗進行分析,該分類模型的效果基本符合要求。

2.6 鎖骨、肩胛骨部位的圖像處理方法研究與實現

2.6.1 針對鎖骨部位

主要研究是否聳肩、體位是否偏移[23]。聳肩容易導致醫生對患者病情的誤診和漏診[24],體位偏移會從視覺上影響醫生的診斷[25],因此在拍片過程中,有必要對這兩個標準點進行控制,通過相關圖像處理算法計算,正確把控拍片者的體位擺放。

研究方法:

(1)針對聳肩情況:如圖 9 所示,獲取圖像中的連通域[26],并畫出每個連通域的外接矩形框,獲取每個區域的最大最小縱橫坐標值,計算出兩個鎖骨與水平線的夾角,即代表聳肩程度,只要有一個鎖骨夾角超過閾值,就可以判定為聳肩,此時系統會自動提示技師該患者聳肩,技師可以及時提醒患者。通過對數據集中全部 7 270 張圖像進行鎖骨傾斜角測試,統計結果如表 4 所示。

圖9

鎖骨區域研究方法幾何展示

Figure9.

Geometry display of clavicular region research method

圖9

鎖骨區域研究方法幾何展示

Figure9.

Geometry display of clavicular region research method

通過對大量數據的左右鎖骨傾斜角分別進行計算,可以發現 20~30° 之間的情況最多,結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,認為將聳肩閾值定為 30° 是比較合理的,超過 30° 就可以認為受檢者聳肩。

(2)針對體位情況:如圖 9 所示,獲取圖像中所有連通域,并畫出每個連通域的外接矩形框,這樣就可以獲取每個區域的最大最小縱橫坐標值,通過計算左邊鎖骨最大橫坐標和右邊鎖骨最小橫坐標的平均值 a,與拍攝影像的整體橫向中心點 b 進行比較,可以判斷患者在拍片過程中是否有體位偏移。

通過對數據集全部 7 270 張圖像進行體位測試,結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,認為 a-b 的絕對值大小在 150 個像素點范圍內,可認為體位正常;a-b 的絕對值大小超出 150 個像素點范圍,則認為體位有偏移。

2.6.2 針對肩胛骨部位

主要研究肩胛骨與肺野的重合度。技師在拍片過程中,正確的肩胛骨擺放姿勢可以使肩胛骨基本投射在肺野之外。由于肩胛骨的特征和肺野相近,如果兩者重合在一起,會導致醫生很難診斷重合區域的病灶,容易造成漏診和誤診[27]。因此,計算肩胛骨與肺野的重合率很重要,該模塊可以有效協助技師在拍片的時候將重合率盡量控制在合理閾值范圍內。

如圖 10 所示,四張小圖依次為為同一案例的正位 DR 胸片原影像、使用本研究中分割模型得到的肺野區域和肩胛骨區域,以及通過計算得到的重合區域。用重合區域面積除以肩胛骨區域面積,就得到了肩胛骨與肺野的重合率。通過對數據集中全部 7 270 張圖像進行重合率測試,發現重合率在 0 至 1/3 范圍內占總比為 0.295 4;重合率在 1/3 至 2/3 范圍內占總比為 0.517 0;重合率在 2/3 至 1 范圍內占總比為 0.187 6。結合三甲醫院放射科技師的拍片經驗和對人體結構的科學認證,將滿足這三種情況的重合率依次定義為無重合、輕度重合和嚴重重合。

圖10

肩胛骨重合率研究方法

Figure10.

Method of scapula coincidence rate study

圖10

肩胛骨重合率研究方法

Figure10.

Method of scapula coincidence rate study

3 質控平臺展示

3.1 質控場景流程

主要將質控場景分為四層,根據相互作用關系,各層依次為:登記工作站層、DR 設備層、影像智能質控評片一體機層和區域影像平臺,具體質控流程如圖 11 所示。

圖11

質控平臺使用場景流程圖

Figure11.

Quality control platform usage scenario

圖11

質控平臺使用場景流程圖

Figure11.

Quality control platform usage scenario

場景流程解析:

(1)基層患者在登記后,到放射科進行影像檢查;

(2)技師拍片完成后,將患者影像發送至正位 DR 影像質控平臺;

(3)正位 DR 影像質控平臺進行智能評片;

(4)評片通過后,將影像上傳至區域影像平臺;

(5)評片未通過,技師工作站提示技師重新拍片;

(6)重拍通過后,將影像上傳至區域影像平臺;

(7)將所有評片數據上傳至影像質控云平臺,用于數據分析和教學等。

3.2 案例展示及分析

如圖 12 所示,為某位拍片受檢者在醫院放射科拍片現場中,通過質控智能平臺的測試,得到的實際測試結果。可以看到平臺界面上方為智能評片結果及原因分析展示,該框內是經過智能質控系統測試自動生成的結果,不可在界面上進行修改,并且智能測試結果及原因分析是嚴格按照圖 5 中的質控標準信息統計表得到的。界面下方為專家評片結果展示,專家結合主觀評片經驗,并通過手動點擊操作,勾選出專家認為存在問題的評片原因和胸片質量等級。

圖12

質控平臺界面

Figure12.

Quality control platform interface

圖12

質控平臺界面

Figure12.

Quality control platform interface

通過以上案例,可以看到該受檢者存在體外異物,但是體外異物的位置在肺野外部,因此影響很小;體位稍微偏左;無聳肩;肩胛骨與肺野輕度重合。綜合對以上非正常原因進行考量,該胸片在通過智能評片系統測試后,評片等級為“良”,智能評片結果符合實際情況。

4 總結和展望

本文以四川大學華西醫院放射科技師的醫學影像質量主觀評價為基礎,通過對采集到的正位 DR 胸片數據進行標注,結合深度學習圖像分割模型、分類模型和傳統圖像處理算法,開發出了一套能實現輔助拍片功能的智能質控系統,并將該系統成功應用到了華西醫院和其他市、縣級醫院的放射科,有效驗證了該質控系統的可行性與穩定性。

目前,深度學習圖像處理方法在醫學領域的應用正處于發展期,未來深度學習在醫療影像領域將會有更廣闊的應用,每一項技術的成熟和突破都是人們不斷嘗試、創新和完善的過程。當前,無論是計算機硬件技術還是醫學攝影技術,都為深度學習處理醫學影像問題提供了很好的基礎條件。當然,雖然深度學習可以更好地輔助醫生診斷諸多疾病,在診斷環節中幫助醫生快速判斷,為醫生提供建議[28],但它并沒有實現全智能,沒有人類的思維,很難代替人類醫生,畢竟深度學習的研究需要依賴大量數據樣本,而對于疾病而言,其變異性往往是不可控的。因此,深度學習方式在實際應用中依然會面臨很多問題。總之,深度學習的自學習優勢,使得在特征提取的同時,提升了分類效果。相信隨著深度學習方法的不斷成熟和完善,可以在未來的醫學影像分析中為疾病診斷提供更好的輔助作用[29]。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。