影像融合目前在前列腺癌的診斷中發揮著重要作用,選擇和開發出良好的影像融合算法是實現影像融合的核心任務,決定了所得到的融合圖像質量是否優良,是否能滿足臨床應用的實際需求,因此成為醫學圖像融合的研究熱點之一。為了對醫學影像融合方法進行全面研究,本文對近年來國內外發表的相關文獻進行綜述。對影像融合技術進行分類,將影像融合算法分為傳統融合算法和深度學習融合算法,對一些算法的原理和工作流程進行深入分析對比,總結其優缺點,并介紹了相關的醫學影像數據集。最后,本文對醫學影像融合算法的未來發展趨勢進行了展望,為醫學影像融合技術輔助診斷前列腺癌等重大疾病指明了發展方向。

引用本文: 羅文斌, 王沛, 張一偉, 石更強. 基于影像融合診斷前列腺癌的研究進展. 生物醫學工程學雜志, 2024, 41(5): 1078-1084. doi: 10.7507/1001-5515.202403054 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

0 引言

近年來,前列腺癌(prostate cancer,PCa)發病率在全球范圍內呈上升趨勢,給前列腺癌的診斷帶來巨大的挑戰[1]。在臨床上,前列腺癌的可疑區域可由醫學影像呈現出來,醫生常借助影像資料輔助前列腺穿刺活檢,這是診斷前列腺癌的常用方法,但是僅通過單模態的前列腺影像來評估患者是否患有前列腺癌,容易引起漏診、假陽性等問題[2]。因此,為進一步提高前列腺癌的診斷率,醫學上逐漸將前列腺癌的診斷與人工智能(artificial intelligence,AI)相結合,通過機器學習(machine learning,ML)將多種模態的前列腺影像進行融合,取得了巨大的成功。許多學者提出影像融合技術的構想,通過計算機技術將不同模態影像中的圖像信息整理融合到同一張醫學圖像中。此圖像被稱作融合圖像,從融合圖像中可以得到病變區域的豐富信息,從而輔助前列腺穿刺以提高穿刺成功率。融合影像輔助前列腺癌診斷的關鍵是醫學圖像融合效果,而融合算法的優劣則是影響融合效果的重要因素。

1 醫學影像模態

常見的影像模態有超聲(ultrasound,US)、核磁共振(magnetic resonance imaging,MRI)、計算機斷層掃描(computed tomography,CT)、正電子發射斷層成像(positron emission tomography,PET)和單光子發射計算機斷層成像(single-photon emission computed tomography,SPECT)等[3]。而在前列腺癌的診斷過程中,常采用MRI和US兩種成像,以引導前列腺穿刺手術的進行。

1.1 單模態影像

單模態影像在醫學影像學中通常指采用單一技術來獲取患者體內的影像信息。在前列腺癌的診斷中,MRI成像清晰,圖像完整,但有時會出現偽影且耗時較長,在對患者的前列腺進行MRI檢查時,得到單模態的MRI,此時醫生對病灶位置的把握過于依賴臨床經驗,易造成漏診。在前列腺穿刺中,醫生手握超聲探頭在患者檢查部位實時移動,US成像便捷迅速、實時性好,但得到的圖像分辨率較低,組織的結構邊緣較為模糊,導致前列腺上的腫瘤病灶難以被發現。因此,單模態圖像輔助診斷前列腺癌,對醫生的臨床經驗依賴性較大,難以精確找到病灶,應尋找更為有效的穿刺技術以實現精確診斷。

1.2 融合影像

影像融合是指將兩種或兩種以上的醫學圖像,經過計算機影像處理技術后,最大限度整理各自有效信息融合成高質量影像的過程[4]。而醫學影像融合通常分兩種,即認知融合與基于人工智能的多模態影像融合[5]。前者既依賴醫生的臨床經驗又耗時費力,診斷結果存在主觀性和延后性;后者通過融合算法將不同的單模態影像進行融合,得到融合圖像,既提高了影像的質量,又降低了時間成本。

以前列腺影像融合為例,實際篩查前列腺癌時,通常是在融合影像的引導下,完成前列腺穿刺活檢手術。例如Masaya等[6]、Nam等[7]和Claros等[8]為探究前列腺圖像人工智能融合較認知融合對前列腺癌檢出率更高的猜想,由泌尿科醫生先后采用圖像融合系統和MRI/US認知融合方式對患者進行穿刺,對兩種融合方式的檢出率數據進行分析對比,并深入分析認知融合和人工智能輔助融合各自的特點以及未來圖像融合發展趨勢。結果發現,經計算機技術處理得到的融合影像能夠提供更精準的前列腺可疑區病灶,認知融合則主要憑借醫生長期的臨床經驗,結合前列腺醫學圖像以完成前列腺的穿刺活檢。

2 醫學影像融合方法

為了提高前列腺癌的診斷率,進行前列腺多模態圖像融合是良好的選擇。從醫學信息融合技術的角度,多模態醫學圖像融合(multimodal medical image fusion,MMIF)方法包括傳統融合方法和基于深度學習的融合方法。為進一步探討各類多模態醫學圖像融合方法的區別,圍繞傳統融合和基于深度學習融合兩個方面,從頻率域、空間域、基于深度學習的卷積神經網絡(convolutional neural networks,CNN)與生成對抗網絡(generative adversarial networks,GAN)等四個方面進行論述。

2.1 頻率域融合

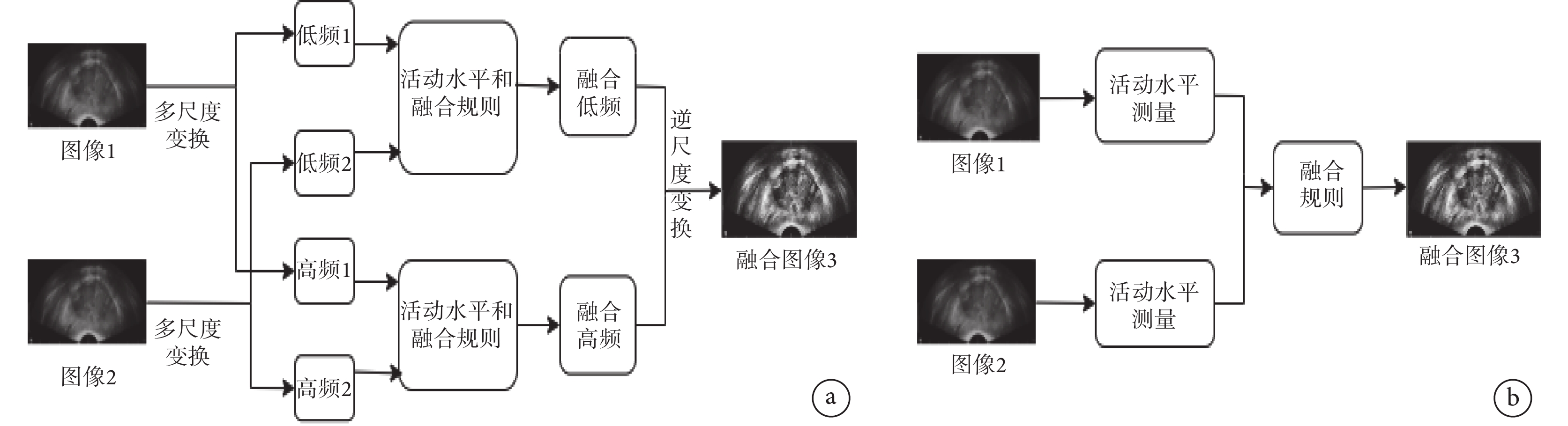

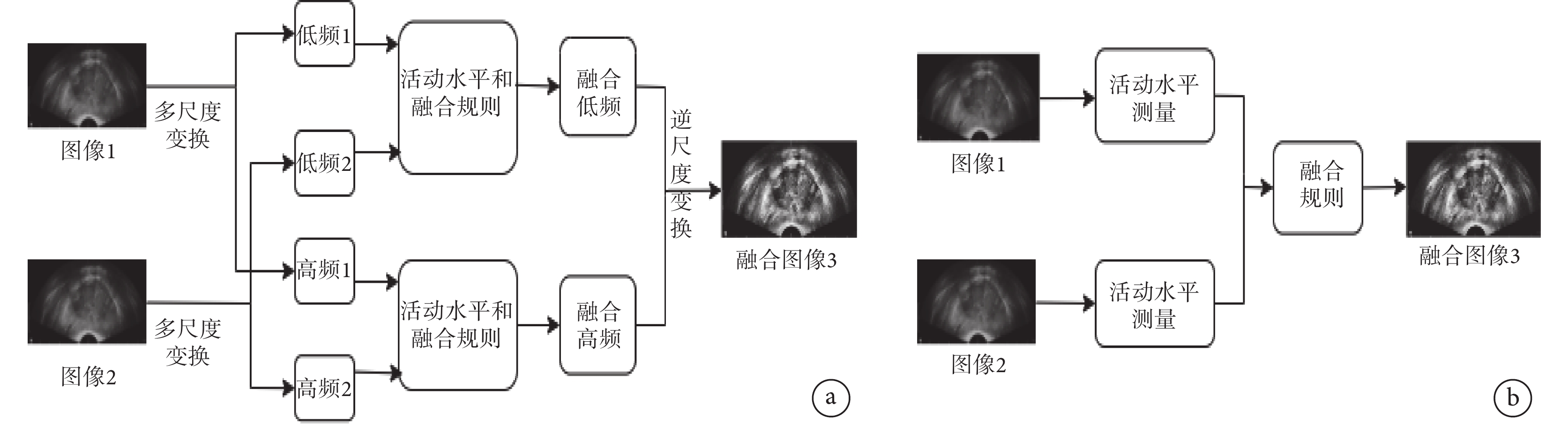

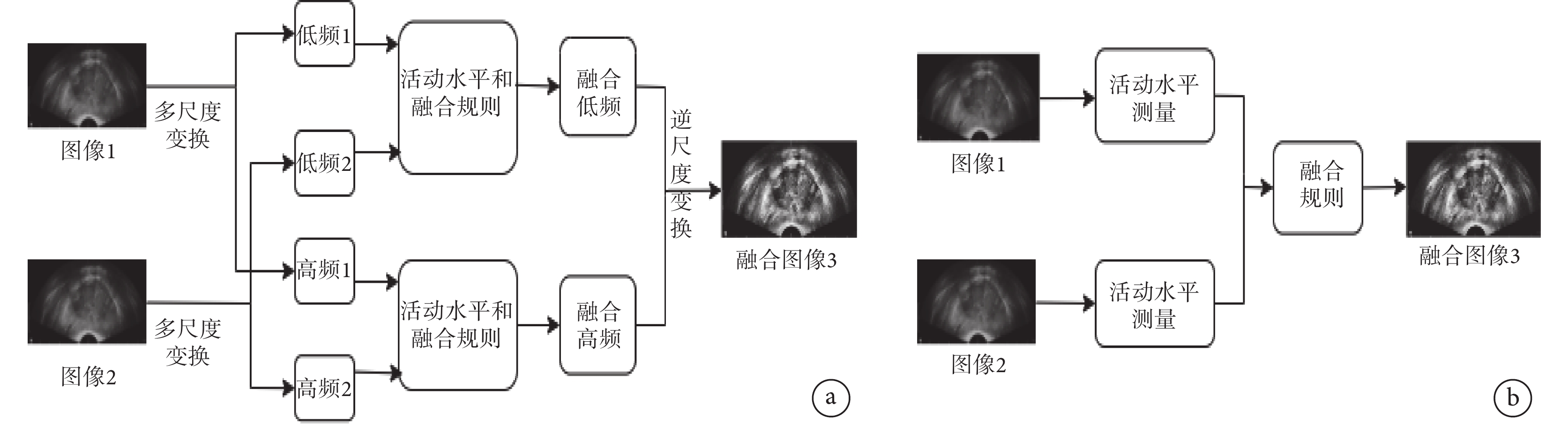

頻率域的融合策略是利用傅里葉變換(Fourier transform,FT)將源圖像轉換至頻域,然后融合這些頻域分量,最后再進行逆傅里葉變換得到融合圖像。頻率域變換實則是對源圖像分解后的頻率系數進行運算,前列腺圖像頻率域變換融合過程如圖1a所示。

圖1

前列腺圖像在兩類傳統變換域中的融合過程

圖1

前列腺圖像在兩類傳統變換域中的融合過程

a. 頻率域變換融合;b. 空間域方法融合

Figure1. Fusion process of prostate images in two kinds of traditional transformation domainsa. frequency domain transform fusion; b. spatial domain method fusion

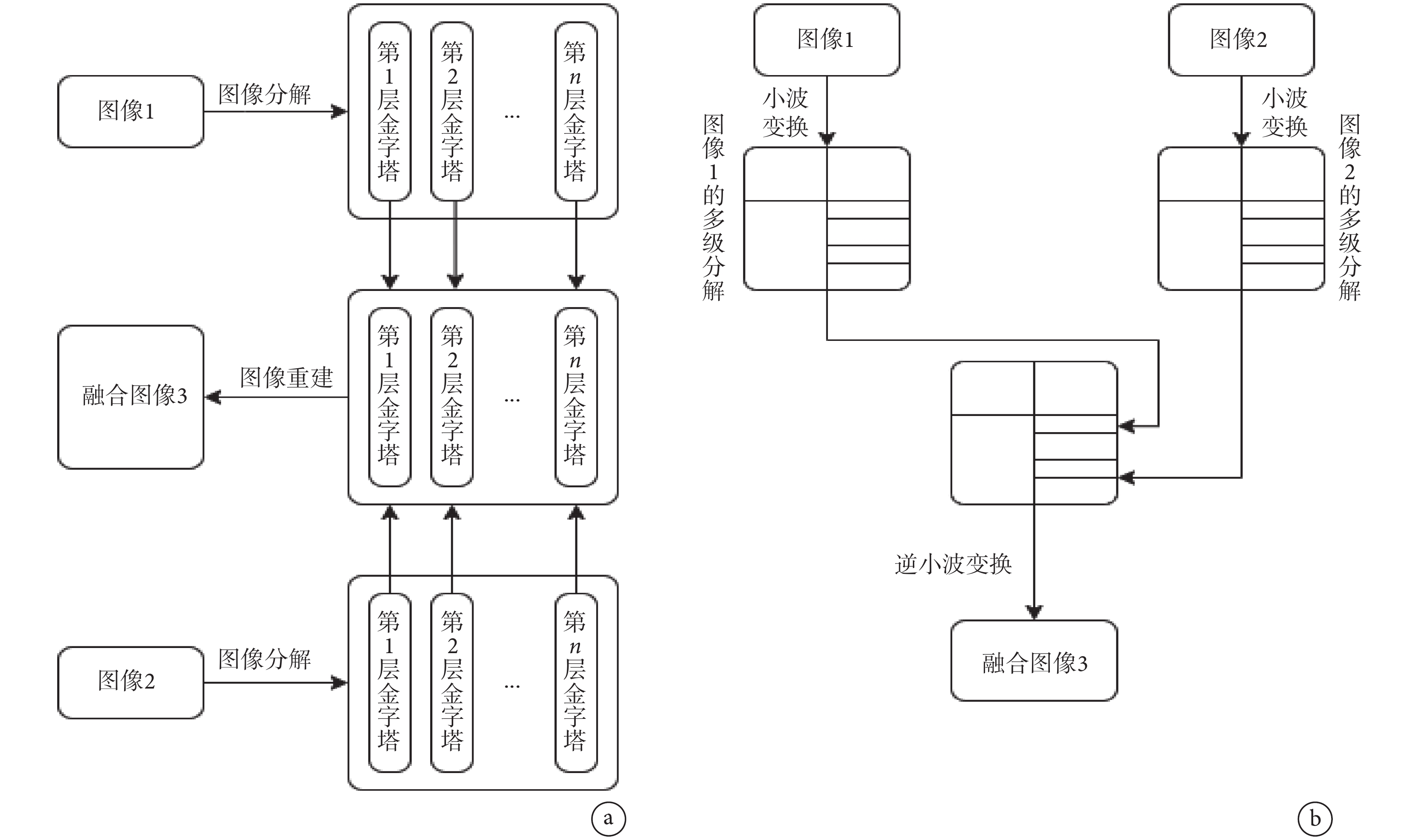

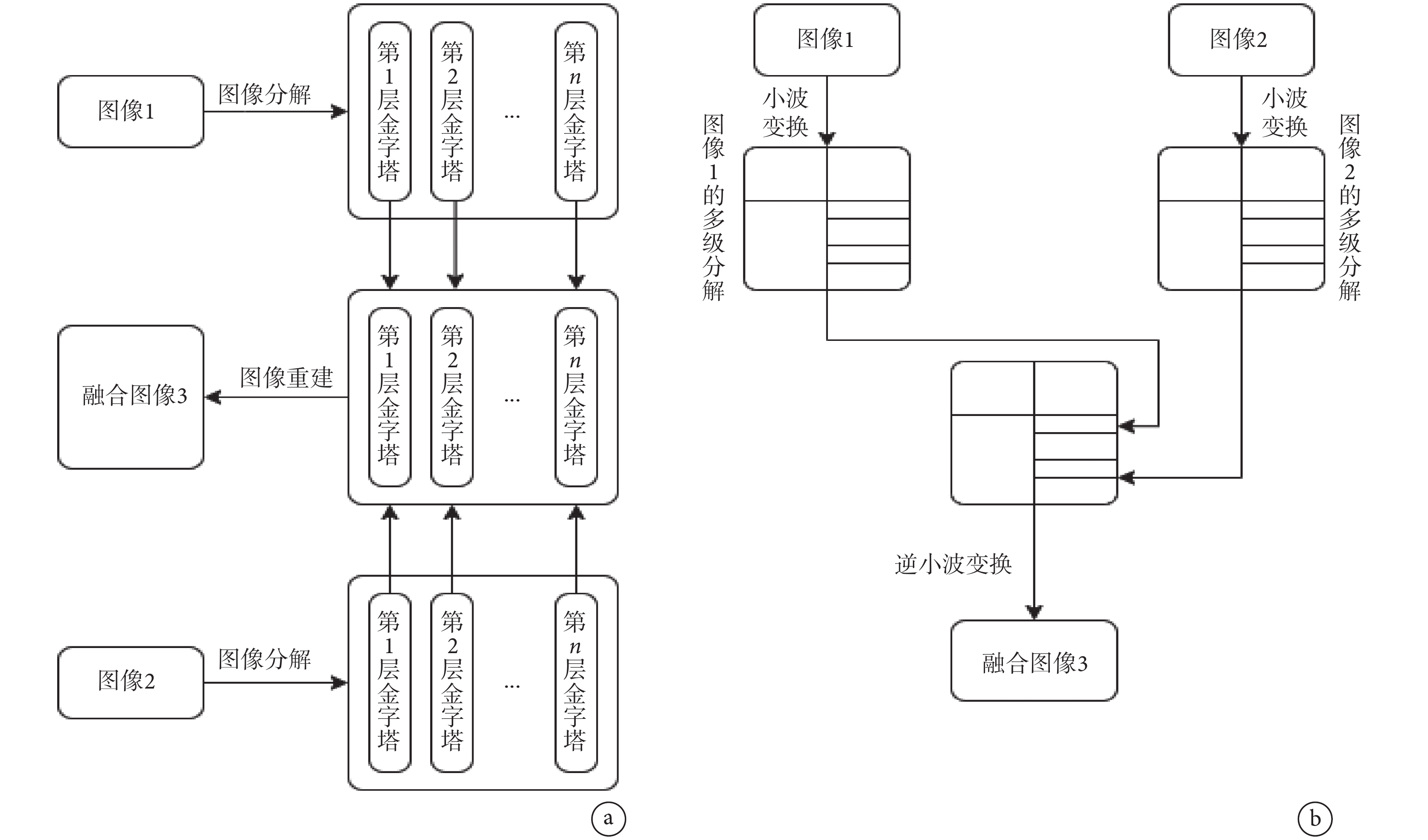

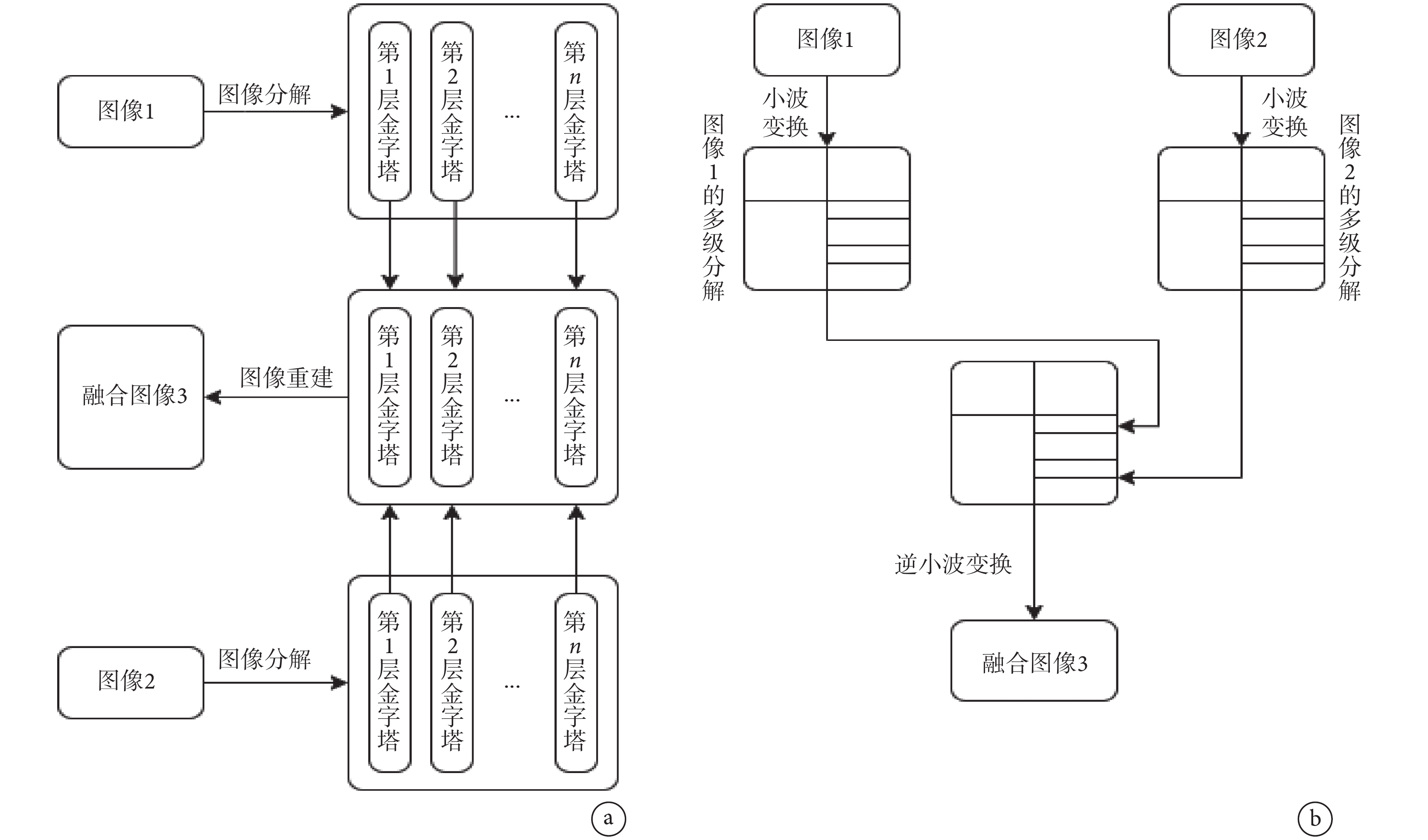

金字塔變換(tower-type filter,TTF)是常見的變換域融合算法之一,過程如圖2a所示,通過行列矩陣對圖像間隔采樣得到許多分辨率逐步降低的圖像,由于圖像經分解后低分辨率系數和高分辨率系數分離,因此圖像特征和細節信息比較突出。在醫學圖像融合過程中,金字塔變換較為常見,例如,拉普拉斯金字塔、斜率金字塔和形態學金字塔等[9]。這些算法運算效率高,融合圖像存在一定優勢。但是,這種融合方法也存在一些劣勢,比如分解方向不明確、分解冗余,以及隨著分解層數增加,分辨率降低,圖像邊界愈發模糊。

圖2

前列腺圖像在兩種常見變換域的融合過程

圖2

前列腺圖像在兩種常見變換域的融合過程

a. 金字塔變換圖像融合;b. 小波變換圖像融合

Figure2. Fusion process of prostate images in two common transform domainsa. pyramid transform image fusion; b. wavelet transform image fusion

很快,小波變換(wavelet transform,WT)的出現彌補了金字塔變換的不足。小波變換如圖2b所示,將醫學圖像分解為代表輪廓邊緣的低頻系數和代表圖像細節的多層三維高頻系數,可清晰反映圖像的局部特征變化,分解圖像無信息冗余,分解方向明確,彌補了金字塔變換的劣勢[10]。例如Syed等[11]采用優化小波變換算法對圖像進行分解,構建優化小波變換模型,最后進行逆優化小波變換重建醫學圖像,在對各種成像數據集進行評估后,驗證了該模型的有效性。還有張魯等[12]也提出了一種改良小波變換網絡模型,該模型由小波變換改造而來,保留了更多的頻率細節。值得注意的是,小波變換作為一種多模態融合方法,對醫學圖像的變換體現了良好的方向性,得到了大多數的頻率信息,但無法選擇變換的方向,也無法保持變換過程中的平移不變性,因此常與其他頻率域變換法結合使用。例如,將輪廓波、曲線波與小波變換結合處理圖像既繼承了分解方向明確的優勢,又具備了分解圖像時平移的不變性。Kumar等[13]將非下采樣輪廓波變換與平穩WT結合構建融合模型,對該模型進行了視覺分析和定量比較,得到的融合圖像與源圖像別無二致,并且圖像邊緣更加清晰,實現了圖像分解時平移不變性的目標。另外,Jamwal等[14]也提出了曲線波變換與脊波小波變換的多模態融合模型,通過相關CT和MRI的數據集評價和驗證了該模型可保留關鍵信息、提高圖像質量的優勢,超過了單獨的小波變換。

2.2 空間域方法

空間域融合的基本策略是在圖像的像素上運行,因它在源圖像上進行,因此得到的融合圖像信噪比(signal to interference plus noise ratio,SINR)低、保真度高。以前列腺US圖像融合為例,其空間域融合過程如圖1b所示。目前該域內的方法有強度/色相飽和度法、簡單最大/最小值法、獨立成分分析法(independent component analysis,ICA)、主成分分析法(principal component analysis,PCA)、加權平均法等[9]。

最大值法和加權平均法是圖像融合最簡便的方法,運算快、操作簡單,但得到的圖像邊緣輪廓模糊不清,失真明顯。獨立成分分析法是一種用于從混合信號中分離出原始獨立成分的信號處理算法,對源圖像進行分解,最后將得到的分量融合成圖像。而主成分分析法則是分解源圖像,提取主要成分融合圖像,這兩種方法的取向偏重不同。主成分分析法作為一種空間域經典算法,將圖像高維數據轉換為低維數據,同時保留原始數據的大部分信息,將降低維度后的信息進行融合。Mohan等[15]提出平穩小波變換與主成分分析相結合融合圖像,在一定程度上呈現了保持邊緣持久性、圖像移位不變性、分辨率高的效果。

2.3 深度學習方法

近年來,隨著人工智能的興起,深度學習涉及了眾多領域,尤其在醫學圖像處理領域取得了巨大的成功。基于深度學習的融合方法大多是基于CNN和基于GAN的融合,這些網絡經過訓練和調優后,獲得了良好的輸入特征[16]。

2.3.1 卷積神經網絡方法

基于CNN融合的方法克服了傳統融合方法在設計復雜特征提取和分類方法上的困難。CNN框架是由眾多的卷積層、池化層和全連接層組成的,它可以高效處理前列腺圖像的領域空間與結構信息[17]。在CNN中,每層都由若干個特征映射組成,這些映射特征被稱為神經元。在多模態圖像融合方面,開發了很多基于CNN框架的源圖像獲取權重圖。Paralic等[18]提出了一種新的基于CNN的方法,將空間數據轉換處理系統(feature manipulate engine,FME)和遷移學習(transfer learning,TL)的概念融入圖像處理模塊中,生成多個增強通道,以有效捕獲COVID-19感染圖像特有的光照和紋理的微小變化特征。Jin等[19]提出基于多目標差分進化和Xception模型的多模態生物醫學融合模型,使用多目標差分進化提取最優特征,利用確定系數和基于能量損失的融合函數增強融合效果,與目前最佳的方法相比,在邊緣強度、融合對稱性、融合因子、互信息分析等方面分別高出1.692 8%、1.197 4%、1.392 8%、1.837 3%。Chen等[20]介紹了利用3DCNN和卷積長短期記憶網絡相結合的方法來檢測腫瘤,不僅提高了診斷精度,而且有望推動醫學圖像分析領域的發展。但其不足性也很明顯,比如數據訓練無針對性、耗時長,基于前列腺醫學圖像的特殊性,一種CNN往往適用于一種醫學圖像的融合,因此,開發出一種普遍適用的融合方法是目前研究的難點。

2.3.2 生成對抗網絡方法

GAN也是深度學習中的一種生成模型,與CNN不同的是,GAN通過對抗學習機制進行訓練并對醫學圖像中的顯著信息建模[15]。不同模態醫學圖像的特征信息不同,為解決融合過程的域差異問題,許多研究者提出了基于GAN網絡框架的融合算法,以增強融合效果。Nabil等[21]提出一種基于GAN的可見光與紅外圖像融合的方法,解決了GAN容易忽略可見光對比度信息和細節紅外紋理信息的問題,提高了融合圖像的質量。Qian等[22]提出一種基于多尺度變換(multi-scale transformation,MST)和GAN的圖像融合框架,該框架提高了融合結果的對比度。GAN通過兩個神經網絡相互博弈進行學習,可在不使用標注數據的基礎上進行生成任務的學習,在持續對抗、不斷學習中,最終實現醫學圖像的融合。總體而言,GAN方法融合效果良好,但圖像細節信息易被其他信息掩蓋,其對抗系統也缺乏穩定性。基于深度學習的融合方法通常是在配準好的源圖像上進行的,但實際中的源圖像均是未配準的。因此,現有的深度學習方法并不適用于直接對源圖像進行融合。在使用深度學習處理圖像前,一般會對源圖像進行配準,但執行配準的算法也存在自身的局限性,比如耗時長、配準精度低等。再者,由于成像方式不一,源圖像分辨率亦有差異。克服不同分辨率、充分綜合多模態圖像中的信息實現良好融合是目前研究的一個難點。綜上所述,多模態醫學圖像融合技術對比詳見表1。

3 相關醫學影像數據集及圖像質量評價指標

3.1 相關醫學影像數據集

在前列腺的多模態圖像融合任務中,研究者往往需要大量數據進行算法模型的驗證,在醫學上常見的數據集有Open Access Series of Imaging Studies(OASIS)、The Cancer Imaging Archive(TCIA)、Alzheimer’s Disease Neuroimaging Initiative(ADNI)和Medical Information Data Analysis System(MIDAS)數據集(見表2)。研究者常采用公開的免費數據集TCIA,以完成算法模型的驗證并對各種融合技術進行融合性能評估[23-25]。

3.2 圖像質量評價指標

無論使用何種圖像融合方法,均需經過圖像分解、融合規則、圖像重構等過程。執行以上任務時,對圖像的特征提取、壓縮、傳輸和重建過程容易引起偽影、失真、過度增強等問題[26]。因此,需要通過特定的圖像質量評估(image quality assessment,IQA)方法來評判圖像融合技術的優劣,評估方法可分為定性評估和定量評估兩大類。

3.2.1 定性分析

在醫學圖像融合中,所謂定性分析是指通過人的視覺感受和視覺分析來評估融合圖像的質量。這種主觀的評估方法不使用任何模型技術,單純依靠評估者的視覺感受和所發表的意見對融合圖像質量進行點評。考慮到圖像大小、空間細節、顏色等參數,此方法在許多實際融合中并不適用,因為這將導致價格昂貴、耗時、操作不便等問題。

3.2.2 定量評價

此分析法基于算法模型,采用一些評價指標,從客觀上定量考校融合圖像的質量,這些評價指標根據參考圖像的適用性可進一步分為參考指標和非參考指標[27-35]。參考指標包括互信息(mutual information,MI)、結構相似指數測量(structural similarity index measure,SSIM)、特征互信息(feature mutual information,FMI)、通用圖像質量指數(universal image quality index,UIQI)、峰值信噪比(peak signal to noise ratio,PSNR)。非參考指標包括熵(entropy,EN)、標準偏差(standard deviation,SD)、空間頻率(spatial frequency,SF)、平均梯度(average gradient,AG)。各評價指標的具體公式及說明參見附件1。

在上述參考指標中,MI用于衡量融合圖像與原始圖像之間的相似程度,可以量化圖像融合的質量,幫助優化圖像融合算法,以實現更好的融合效果;SSIM則旨在測量兩幅圖像之間的結構相似性,特別是在評估圖像結構信息的保留與重建時極具優勢;FMI結合了互信息和特征表示的特點,提供一種更細粒度的圖像相似性度量方式來反映圖像融合后的特征保留程度;至于UIQI,它結合了亮度、對比度和結構信息,旨在提供一個全面的圖像質量度量對圖像融合的效果進行全面的評估,以達到更好的融合效果;此外,PSNR主要基于圖像的像素值比較,而對圖像的亮度、對比度和結構等特征以及特定類型的失真并不敏感,因此在評價圖像融合質量時,還應結合其他指標來進行綜合考量,以獲得更全面的評價結果。

在前述非參考指標中,EN反映了圖像中的信息量,常被用來衡量圖像的復雜度或信息量;SD則常被用來評估圖像的對比度或灰度分布的分散程度;此外,SF分析提供一種直觀的方式來理解圖像中的空間結構變化,但某些情況下一些融合方法可能會導致SF的變化,會引入不自然或不希望的視覺效果,這就需要結合其他評價指標進行綜合考量;AG常用于衡量圖像的清晰度或邊緣的銳利程度,通過比較融合前后圖像的AG值,可以了解融合是否導致了圖像細節的丟失或邊緣的模糊,從而評估融合的效果。

4 總結與展望

本文以前列腺癌的診斷為背景,主要討論了在前列腺癌診斷中影像融合的技術問題。首先,文章描述了多模態圖像融合過程使用的影像模態。之后討論了不同的影像融合方法,描述了一些融合規則的工作流程。從影像融合的頻率域、空間域、深度學習這三個方面,深入分析比較了各種融合方法的優劣。融合圖像的質量評估可采用一系列評估指標進行判斷。在本綜述中,深度學習融合和混合融合的方法相結合比其他融合法更令人滿意,但是在決定哪種融合方法最適合具體病癥時,要考慮許多因素,因此不能草率決定哪種方法最好,要具體情況具體分析。

本文討論了多種多模態影像融合技術。其中,主成分分析算法的計算效率雖然簡單快速,但它易導致圖像光譜受損。頻域融合比標準化融合取得的效果要好,可減少頻譜失真,但是這類技術帶來了更大的信噪比。在以往的經驗中,二次融合可以達到圖像增強的效果,但是經過二次融合后,融合圖像的空間分辨率可能降低。整理文獻發現,混合融合方法可改良融合圖像的對比度、清晰度、紋理和邊緣信息,也能夠從源圖像中捕捉互補信息。即便如此,依舊需要對每種多模態融合方法十分熟悉,進而改進混合融合技術,以期得到非均勻的融合圖像,只是這些技術開發困難,耗時過久。混合融合方法的另一個劣勢是不適合運算大型的數據集。在稀疏表示法中,稀疏系數是衡量融合效果的關鍵參數。為充分保留源圖像的細節信息和圖像邊緣結構,可以通過增強圖像對比度和保留視覺信息的方式實現。但是,該技術也面臨更多的挑戰,比如存在注冊錯誤,幾乎沒有保存圖像細節的能力。深度學習為優化融合過程提供了技術支撐,能根據具體的要求構建算法模型。當面臨多個大型數據集時,深度學習的處理能力優于其他融合技術。但是深度學習融合圖像是一個復雜的多參數動態過程,對硬件設備要求高,訓練一個模型耗時長,而且深度學習算法不適用于小的圖像數據集。

雖然研究者已經提出了數種醫學圖像融合辦法,但是這些辦法依舊存在改進空間。實際臨床應用所需的新的多模態醫學影像融合技術和圖像融合指標還需要深入研究。基于上述不足,對未來研究的建議如下。首先,研究者應當探索新的圖像表示方法和公認的圖像評估指標,研究圖像融合技術的有效性,以推進機器學習中深度學習的進一步發展。其次,在融合前,要通過不斷發展的方法來增強源圖像的感興趣區域。在面對實際的醫學圖像融合問題時,需要研究新的多尺度變換算法用于醫學圖像融合,以及尋找更強大的無參考指標以評估融合圖像的質量。此外,還需改進圖像融合質量輸出,控制好圖像的噪聲。最后,每種醫學成像都會缺少一定信息并含有噪聲,具有計算成本,不同模態的圖像尺寸不同,應該確定合適的解決方案。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:石更強負責論文指導和審閱;羅文斌負責論文寫作與修改;王沛負責查閱與分析文獻;張一偉負責制表與畫圖。

本文附件見本刊網站的電子版本(biomedeng.cn)。

0 引言

近年來,前列腺癌(prostate cancer,PCa)發病率在全球范圍內呈上升趨勢,給前列腺癌的診斷帶來巨大的挑戰[1]。在臨床上,前列腺癌的可疑區域可由醫學影像呈現出來,醫生常借助影像資料輔助前列腺穿刺活檢,這是診斷前列腺癌的常用方法,但是僅通過單模態的前列腺影像來評估患者是否患有前列腺癌,容易引起漏診、假陽性等問題[2]。因此,為進一步提高前列腺癌的診斷率,醫學上逐漸將前列腺癌的診斷與人工智能(artificial intelligence,AI)相結合,通過機器學習(machine learning,ML)將多種模態的前列腺影像進行融合,取得了巨大的成功。許多學者提出影像融合技術的構想,通過計算機技術將不同模態影像中的圖像信息整理融合到同一張醫學圖像中。此圖像被稱作融合圖像,從融合圖像中可以得到病變區域的豐富信息,從而輔助前列腺穿刺以提高穿刺成功率。融合影像輔助前列腺癌診斷的關鍵是醫學圖像融合效果,而融合算法的優劣則是影響融合效果的重要因素。

1 醫學影像模態

常見的影像模態有超聲(ultrasound,US)、核磁共振(magnetic resonance imaging,MRI)、計算機斷層掃描(computed tomography,CT)、正電子發射斷層成像(positron emission tomography,PET)和單光子發射計算機斷層成像(single-photon emission computed tomography,SPECT)等[3]。而在前列腺癌的診斷過程中,常采用MRI和US兩種成像,以引導前列腺穿刺手術的進行。

1.1 單模態影像

單模態影像在醫學影像學中通常指采用單一技術來獲取患者體內的影像信息。在前列腺癌的診斷中,MRI成像清晰,圖像完整,但有時會出現偽影且耗時較長,在對患者的前列腺進行MRI檢查時,得到單模態的MRI,此時醫生對病灶位置的把握過于依賴臨床經驗,易造成漏診。在前列腺穿刺中,醫生手握超聲探頭在患者檢查部位實時移動,US成像便捷迅速、實時性好,但得到的圖像分辨率較低,組織的結構邊緣較為模糊,導致前列腺上的腫瘤病灶難以被發現。因此,單模態圖像輔助診斷前列腺癌,對醫生的臨床經驗依賴性較大,難以精確找到病灶,應尋找更為有效的穿刺技術以實現精確診斷。

1.2 融合影像

影像融合是指將兩種或兩種以上的醫學圖像,經過計算機影像處理技術后,最大限度整理各自有效信息融合成高質量影像的過程[4]。而醫學影像融合通常分兩種,即認知融合與基于人工智能的多模態影像融合[5]。前者既依賴醫生的臨床經驗又耗時費力,診斷結果存在主觀性和延后性;后者通過融合算法將不同的單模態影像進行融合,得到融合圖像,既提高了影像的質量,又降低了時間成本。

以前列腺影像融合為例,實際篩查前列腺癌時,通常是在融合影像的引導下,完成前列腺穿刺活檢手術。例如Masaya等[6]、Nam等[7]和Claros等[8]為探究前列腺圖像人工智能融合較認知融合對前列腺癌檢出率更高的猜想,由泌尿科醫生先后采用圖像融合系統和MRI/US認知融合方式對患者進行穿刺,對兩種融合方式的檢出率數據進行分析對比,并深入分析認知融合和人工智能輔助融合各自的特點以及未來圖像融合發展趨勢。結果發現,經計算機技術處理得到的融合影像能夠提供更精準的前列腺可疑區病灶,認知融合則主要憑借醫生長期的臨床經驗,結合前列腺醫學圖像以完成前列腺的穿刺活檢。

2 醫學影像融合方法

為了提高前列腺癌的診斷率,進行前列腺多模態圖像融合是良好的選擇。從醫學信息融合技術的角度,多模態醫學圖像融合(multimodal medical image fusion,MMIF)方法包括傳統融合方法和基于深度學習的融合方法。為進一步探討各類多模態醫學圖像融合方法的區別,圍繞傳統融合和基于深度學習融合兩個方面,從頻率域、空間域、基于深度學習的卷積神經網絡(convolutional neural networks,CNN)與生成對抗網絡(generative adversarial networks,GAN)等四個方面進行論述。

2.1 頻率域融合

頻率域的融合策略是利用傅里葉變換(Fourier transform,FT)將源圖像轉換至頻域,然后融合這些頻域分量,最后再進行逆傅里葉變換得到融合圖像。頻率域變換實則是對源圖像分解后的頻率系數進行運算,前列腺圖像頻率域變換融合過程如圖1a所示。

圖1

前列腺圖像在兩類傳統變換域中的融合過程

圖1

前列腺圖像在兩類傳統變換域中的融合過程

a. 頻率域變換融合;b. 空間域方法融合

Figure1. Fusion process of prostate images in two kinds of traditional transformation domainsa. frequency domain transform fusion; b. spatial domain method fusion

金字塔變換(tower-type filter,TTF)是常見的變換域融合算法之一,過程如圖2a所示,通過行列矩陣對圖像間隔采樣得到許多分辨率逐步降低的圖像,由于圖像經分解后低分辨率系數和高分辨率系數分離,因此圖像特征和細節信息比較突出。在醫學圖像融合過程中,金字塔變換較為常見,例如,拉普拉斯金字塔、斜率金字塔和形態學金字塔等[9]。這些算法運算效率高,融合圖像存在一定優勢。但是,這種融合方法也存在一些劣勢,比如分解方向不明確、分解冗余,以及隨著分解層數增加,分辨率降低,圖像邊界愈發模糊。

圖2

前列腺圖像在兩種常見變換域的融合過程

圖2

前列腺圖像在兩種常見變換域的融合過程

a. 金字塔變換圖像融合;b. 小波變換圖像融合

Figure2. Fusion process of prostate images in two common transform domainsa. pyramid transform image fusion; b. wavelet transform image fusion

很快,小波變換(wavelet transform,WT)的出現彌補了金字塔變換的不足。小波變換如圖2b所示,將醫學圖像分解為代表輪廓邊緣的低頻系數和代表圖像細節的多層三維高頻系數,可清晰反映圖像的局部特征變化,分解圖像無信息冗余,分解方向明確,彌補了金字塔變換的劣勢[10]。例如Syed等[11]采用優化小波變換算法對圖像進行分解,構建優化小波變換模型,最后進行逆優化小波變換重建醫學圖像,在對各種成像數據集進行評估后,驗證了該模型的有效性。還有張魯等[12]也提出了一種改良小波變換網絡模型,該模型由小波變換改造而來,保留了更多的頻率細節。值得注意的是,小波變換作為一種多模態融合方法,對醫學圖像的變換體現了良好的方向性,得到了大多數的頻率信息,但無法選擇變換的方向,也無法保持變換過程中的平移不變性,因此常與其他頻率域變換法結合使用。例如,將輪廓波、曲線波與小波變換結合處理圖像既繼承了分解方向明確的優勢,又具備了分解圖像時平移的不變性。Kumar等[13]將非下采樣輪廓波變換與平穩WT結合構建融合模型,對該模型進行了視覺分析和定量比較,得到的融合圖像與源圖像別無二致,并且圖像邊緣更加清晰,實現了圖像分解時平移不變性的目標。另外,Jamwal等[14]也提出了曲線波變換與脊波小波變換的多模態融合模型,通過相關CT和MRI的數據集評價和驗證了該模型可保留關鍵信息、提高圖像質量的優勢,超過了單獨的小波變換。

2.2 空間域方法

空間域融合的基本策略是在圖像的像素上運行,因它在源圖像上進行,因此得到的融合圖像信噪比(signal to interference plus noise ratio,SINR)低、保真度高。以前列腺US圖像融合為例,其空間域融合過程如圖1b所示。目前該域內的方法有強度/色相飽和度法、簡單最大/最小值法、獨立成分分析法(independent component analysis,ICA)、主成分分析法(principal component analysis,PCA)、加權平均法等[9]。

最大值法和加權平均法是圖像融合最簡便的方法,運算快、操作簡單,但得到的圖像邊緣輪廓模糊不清,失真明顯。獨立成分分析法是一種用于從混合信號中分離出原始獨立成分的信號處理算法,對源圖像進行分解,最后將得到的分量融合成圖像。而主成分分析法則是分解源圖像,提取主要成分融合圖像,這兩種方法的取向偏重不同。主成分分析法作為一種空間域經典算法,將圖像高維數據轉換為低維數據,同時保留原始數據的大部分信息,將降低維度后的信息進行融合。Mohan等[15]提出平穩小波變換與主成分分析相結合融合圖像,在一定程度上呈現了保持邊緣持久性、圖像移位不變性、分辨率高的效果。

2.3 深度學習方法

近年來,隨著人工智能的興起,深度學習涉及了眾多領域,尤其在醫學圖像處理領域取得了巨大的成功。基于深度學習的融合方法大多是基于CNN和基于GAN的融合,這些網絡經過訓練和調優后,獲得了良好的輸入特征[16]。

2.3.1 卷積神經網絡方法

基于CNN融合的方法克服了傳統融合方法在設計復雜特征提取和分類方法上的困難。CNN框架是由眾多的卷積層、池化層和全連接層組成的,它可以高效處理前列腺圖像的領域空間與結構信息[17]。在CNN中,每層都由若干個特征映射組成,這些映射特征被稱為神經元。在多模態圖像融合方面,開發了很多基于CNN框架的源圖像獲取權重圖。Paralic等[18]提出了一種新的基于CNN的方法,將空間數據轉換處理系統(feature manipulate engine,FME)和遷移學習(transfer learning,TL)的概念融入圖像處理模塊中,生成多個增強通道,以有效捕獲COVID-19感染圖像特有的光照和紋理的微小變化特征。Jin等[19]提出基于多目標差分進化和Xception模型的多模態生物醫學融合模型,使用多目標差分進化提取最優特征,利用確定系數和基于能量損失的融合函數增強融合效果,與目前最佳的方法相比,在邊緣強度、融合對稱性、融合因子、互信息分析等方面分別高出1.692 8%、1.197 4%、1.392 8%、1.837 3%。Chen等[20]介紹了利用3DCNN和卷積長短期記憶網絡相結合的方法來檢測腫瘤,不僅提高了診斷精度,而且有望推動醫學圖像分析領域的發展。但其不足性也很明顯,比如數據訓練無針對性、耗時長,基于前列腺醫學圖像的特殊性,一種CNN往往適用于一種醫學圖像的融合,因此,開發出一種普遍適用的融合方法是目前研究的難點。

2.3.2 生成對抗網絡方法

GAN也是深度學習中的一種生成模型,與CNN不同的是,GAN通過對抗學習機制進行訓練并對醫學圖像中的顯著信息建模[15]。不同模態醫學圖像的特征信息不同,為解決融合過程的域差異問題,許多研究者提出了基于GAN網絡框架的融合算法,以增強融合效果。Nabil等[21]提出一種基于GAN的可見光與紅外圖像融合的方法,解決了GAN容易忽略可見光對比度信息和細節紅外紋理信息的問題,提高了融合圖像的質量。Qian等[22]提出一種基于多尺度變換(multi-scale transformation,MST)和GAN的圖像融合框架,該框架提高了融合結果的對比度。GAN通過兩個神經網絡相互博弈進行學習,可在不使用標注數據的基礎上進行生成任務的學習,在持續對抗、不斷學習中,最終實現醫學圖像的融合。總體而言,GAN方法融合效果良好,但圖像細節信息易被其他信息掩蓋,其對抗系統也缺乏穩定性。基于深度學習的融合方法通常是在配準好的源圖像上進行的,但實際中的源圖像均是未配準的。因此,現有的深度學習方法并不適用于直接對源圖像進行融合。在使用深度學習處理圖像前,一般會對源圖像進行配準,但執行配準的算法也存在自身的局限性,比如耗時長、配準精度低等。再者,由于成像方式不一,源圖像分辨率亦有差異。克服不同分辨率、充分綜合多模態圖像中的信息實現良好融合是目前研究的一個難點。綜上所述,多模態醫學圖像融合技術對比詳見表1。

3 相關醫學影像數據集及圖像質量評價指標

3.1 相關醫學影像數據集

在前列腺的多模態圖像融合任務中,研究者往往需要大量數據進行算法模型的驗證,在醫學上常見的數據集有Open Access Series of Imaging Studies(OASIS)、The Cancer Imaging Archive(TCIA)、Alzheimer’s Disease Neuroimaging Initiative(ADNI)和Medical Information Data Analysis System(MIDAS)數據集(見表2)。研究者常采用公開的免費數據集TCIA,以完成算法模型的驗證并對各種融合技術進行融合性能評估[23-25]。

3.2 圖像質量評價指標

無論使用何種圖像融合方法,均需經過圖像分解、融合規則、圖像重構等過程。執行以上任務時,對圖像的特征提取、壓縮、傳輸和重建過程容易引起偽影、失真、過度增強等問題[26]。因此,需要通過特定的圖像質量評估(image quality assessment,IQA)方法來評判圖像融合技術的優劣,評估方法可分為定性評估和定量評估兩大類。

3.2.1 定性分析

在醫學圖像融合中,所謂定性分析是指通過人的視覺感受和視覺分析來評估融合圖像的質量。這種主觀的評估方法不使用任何模型技術,單純依靠評估者的視覺感受和所發表的意見對融合圖像質量進行點評。考慮到圖像大小、空間細節、顏色等參數,此方法在許多實際融合中并不適用,因為這將導致價格昂貴、耗時、操作不便等問題。

3.2.2 定量評價

此分析法基于算法模型,采用一些評價指標,從客觀上定量考校融合圖像的質量,這些評價指標根據參考圖像的適用性可進一步分為參考指標和非參考指標[27-35]。參考指標包括互信息(mutual information,MI)、結構相似指數測量(structural similarity index measure,SSIM)、特征互信息(feature mutual information,FMI)、通用圖像質量指數(universal image quality index,UIQI)、峰值信噪比(peak signal to noise ratio,PSNR)。非參考指標包括熵(entropy,EN)、標準偏差(standard deviation,SD)、空間頻率(spatial frequency,SF)、平均梯度(average gradient,AG)。各評價指標的具體公式及說明參見附件1。

在上述參考指標中,MI用于衡量融合圖像與原始圖像之間的相似程度,可以量化圖像融合的質量,幫助優化圖像融合算法,以實現更好的融合效果;SSIM則旨在測量兩幅圖像之間的結構相似性,特別是在評估圖像結構信息的保留與重建時極具優勢;FMI結合了互信息和特征表示的特點,提供一種更細粒度的圖像相似性度量方式來反映圖像融合后的特征保留程度;至于UIQI,它結合了亮度、對比度和結構信息,旨在提供一個全面的圖像質量度量對圖像融合的效果進行全面的評估,以達到更好的融合效果;此外,PSNR主要基于圖像的像素值比較,而對圖像的亮度、對比度和結構等特征以及特定類型的失真并不敏感,因此在評價圖像融合質量時,還應結合其他指標來進行綜合考量,以獲得更全面的評價結果。

在前述非參考指標中,EN反映了圖像中的信息量,常被用來衡量圖像的復雜度或信息量;SD則常被用來評估圖像的對比度或灰度分布的分散程度;此外,SF分析提供一種直觀的方式來理解圖像中的空間結構變化,但某些情況下一些融合方法可能會導致SF的變化,會引入不自然或不希望的視覺效果,這就需要結合其他評價指標進行綜合考量;AG常用于衡量圖像的清晰度或邊緣的銳利程度,通過比較融合前后圖像的AG值,可以了解融合是否導致了圖像細節的丟失或邊緣的模糊,從而評估融合的效果。

4 總結與展望

本文以前列腺癌的診斷為背景,主要討論了在前列腺癌診斷中影像融合的技術問題。首先,文章描述了多模態圖像融合過程使用的影像模態。之后討論了不同的影像融合方法,描述了一些融合規則的工作流程。從影像融合的頻率域、空間域、深度學習這三個方面,深入分析比較了各種融合方法的優劣。融合圖像的質量評估可采用一系列評估指標進行判斷。在本綜述中,深度學習融合和混合融合的方法相結合比其他融合法更令人滿意,但是在決定哪種融合方法最適合具體病癥時,要考慮許多因素,因此不能草率決定哪種方法最好,要具體情況具體分析。

本文討論了多種多模態影像融合技術。其中,主成分分析算法的計算效率雖然簡單快速,但它易導致圖像光譜受損。頻域融合比標準化融合取得的效果要好,可減少頻譜失真,但是這類技術帶來了更大的信噪比。在以往的經驗中,二次融合可以達到圖像增強的效果,但是經過二次融合后,融合圖像的空間分辨率可能降低。整理文獻發現,混合融合方法可改良融合圖像的對比度、清晰度、紋理和邊緣信息,也能夠從源圖像中捕捉互補信息。即便如此,依舊需要對每種多模態融合方法十分熟悉,進而改進混合融合技術,以期得到非均勻的融合圖像,只是這些技術開發困難,耗時過久。混合融合方法的另一個劣勢是不適合運算大型的數據集。在稀疏表示法中,稀疏系數是衡量融合效果的關鍵參數。為充分保留源圖像的細節信息和圖像邊緣結構,可以通過增強圖像對比度和保留視覺信息的方式實現。但是,該技術也面臨更多的挑戰,比如存在注冊錯誤,幾乎沒有保存圖像細節的能力。深度學習為優化融合過程提供了技術支撐,能根據具體的要求構建算法模型。當面臨多個大型數據集時,深度學習的處理能力優于其他融合技術。但是深度學習融合圖像是一個復雜的多參數動態過程,對硬件設備要求高,訓練一個模型耗時長,而且深度學習算法不適用于小的圖像數據集。

雖然研究者已經提出了數種醫學圖像融合辦法,但是這些辦法依舊存在改進空間。實際臨床應用所需的新的多模態醫學影像融合技術和圖像融合指標還需要深入研究。基于上述不足,對未來研究的建議如下。首先,研究者應當探索新的圖像表示方法和公認的圖像評估指標,研究圖像融合技術的有效性,以推進機器學習中深度學習的進一步發展。其次,在融合前,要通過不斷發展的方法來增強源圖像的感興趣區域。在面對實際的醫學圖像融合問題時,需要研究新的多尺度變換算法用于醫學圖像融合,以及尋找更強大的無參考指標以評估融合圖像的質量。此外,還需改進圖像融合質量輸出,控制好圖像的噪聲。最后,每種醫學成像都會缺少一定信息并含有噪聲,具有計算成本,不同模態的圖像尺寸不同,應該確定合適的解決方案。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:石更強負責論文指導和審閱;羅文斌負責論文寫作與修改;王沛負責查閱與分析文獻;張一偉負責制表與畫圖。

本文附件見本刊網站的電子版本(biomedeng.cn)。