表征學習在視聽情感識別中是一個備受關注的研究方向,其關鍵在于構建兼具一致性和差異性的有效情態表征,但如何精準實現情態表征仍面臨諸多挑戰,因此本文提出一種基于多頭交叉注意力機制的跨模態視聽情感識別模型。該模型通過多頭交叉注意力架構實現融合特征和模態對齊,并采用分段訓練策略以應對模態缺失問題。此外,為了保留每個模態的獨立信息,本文設計了單模態輔助損失任務并使用了共享參數。最終,在多模態情緒數據集(CREMA-D)上,該模型的宏觀和微觀F1分數分別達到了84.5%和88.2%。研究結果表明,本文模型能有效地捕獲視聽模態內和模態間的特征表示,成功解決了單模態和多模態情緒識別框架的統一性問題,為視聽情感識別提供了一種全新的解決思路。

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

0 引言

面部表情在人類日常交流中起著至關重要的作用[1],通過面部表情準確判斷他人的情緒,不僅能幫助人們更好地理解對方傳達的信息,還能在應對各種情況時提升效率[2]。近年來,隨著社交網絡中短視頻的迅速普及,視聽情感識別成為一個備受關注的研究熱點,并在多個領域展現出非常重要的應用價值[3-6]。情感識別系統通過結合視聽模態,能幫助人們在日常生活中實現準確的交流與互動,因此在多模態系統中,確保聽覺和視覺得到充分和適當地表達,是構建穩健多模態系統的關鍵。

在多模態融合情感分析方法方面,研究人員進行了廣泛的探索。比如,Cai等[7]提出了特征級和模型級融合視覺和聽覺特征策略,通過從人臉特征提取視覺線索與音頻特征相結合,并利用特征拼接可實現特征級融合。隨著研究的不斷深入,特征融合方法變得愈加多樣化[8-10]。例如,Shoaib等[11]在決策級融合中采用乘積規則,將不同模態的分類結果組合在一起;而Kollias等[12]提出了晚期融合方法,通過深度卷積神經網絡將提取的音頻和視覺特征連接起來;這些研究為多模態情感識別的進一步發展奠定了堅實的基礎。

如何在融合過程中有效整合不同模態的共性和差異性,是多模態表征學習面臨的核心挑戰之一。目前,大多數方法仍處于淺層融合階段,側重跨模態一致性,而常常忽略了模態之間的差異性。為了應對這一挑戰,研究者們通常采用共享參數的神經網絡架構來學習各模態的表示[13],隨后再進行融合。例如,Huang等[14]提出了一種雙流模態共享特征提取子網,通過在共享二維和三維特征空間中提取模態共享外觀特征和模態不變關系特征,從而減少模態間變化和模態內變化。有研究表明,通過注意力機制或交叉注意力機制動態關聯不同模態特征,也是提升模型在跨模態任務中靈活性和性能的有效策略[15-17]。此外,還有研究使用雙子空間融合技術,將每個模態投影到兩個子空間[18],以學習更加細致和有效的情態表征。隨著基于注意力機制的轉換器(Transformer)模型的引入[19],研究者們提出了一種單模態和多模態統一的綜合模型[20],顯著改善了多模態情感識別的性能表現,并為解決輸入模態缺失問題提供了創新的解決方案。這些方法的不斷優化,為多模態表征學習領域帶來了新的突破和發展前景。

基于上述研究,本文提出了一種全新的跨模態視聽情緒識別模型,該模型在統一的模型結構中引入跨模態任務,其核心在于通過多頭交叉注意力機制實現跨模態融合,從而在更大程度上保留模態之間和模態內部的語義相關性。此外,本文引入了分段訓練策略,將多模態與單模態特征參數在同一框架下實現無縫整合與共享。這種設計使得該框架不僅在多模態情境下表現出色,還能在模態信息缺失時執行單模態情緒識別,從而顯著提升其適用性和魯棒性。綜上,本文旨在構建一個功能強大且具綜合性的跨模態情感識別網絡,以期滿足復雜多樣的實際應用需求。

1 方法

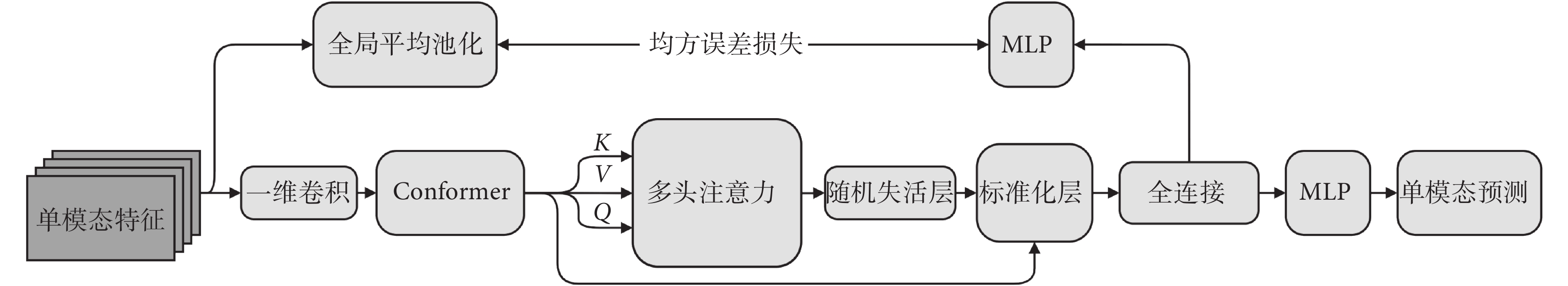

本研究提出了一種融合多頭交叉注意力和單模態重建結構的跨模態視聽情緒識別模型,如圖1所示。該模型由特征提取層、主網絡層及預測層構成。在特征提取層中,分別采用特定的方法從視覺和聽覺輸入中提取出對應特征。主網絡層集成了用于語音識別的卷積增強Transformer(convolution-augmented Transformer for speech recognition,Conformer)模型、一維卷積、多頭跨模態注意力(corss-molde multi-head attention,CMMHA)模塊以及單模態輔助損失任務。借助這些技術與模塊的集成運用,主網絡層可實現不同模態特征維度的對齊,并行處理所有視覺幀和聽覺幀,進一步優化模型表現并提升其泛化能力。在預測層中,模型包含視覺模態預測、聽覺模態預測和視聽模態預測三部分。與兩種單模態預測不同,視聽模態預測在進行分類前,需要將經過處理的視聽特征進行拼接融合,再通過多層感知機(multilayer perceptron,MLP)完成最終的分類任務。這種設計有效提升了模型在多模態情緒識別任務中的表現,為視聽情感識別提供了更為穩健的解決方案。

圖1

網絡整體結構

Figure1.

Overall structure of network

圖1

網絡整體結構

Figure1.

Overall structure of network

1.1 數據集

本研究使用的數據來源于賓夕法尼亞州切尼大學計算機科學相關專業創建并維護的眾包情感多模態演員數據集(crowd-sourced emotional multimodal actors dataset,CREMA-D)[21]。該數據集包含91位演員的7 442個原始剪輯數據集,是研究多模態表達和基本情緒感知的常用資源。這些視頻剪輯包括了演員們在快樂(happy)、悲傷(sad)、憤怒(anger)、恐懼(fear)、厭惡(disgust)和中性(neutral)等一系列基本情緒狀態下,通過面部表情和聲音情感表達進行的演繹,每段視頻均表現了單個人的情緒表達。這些視頻由2 443名參與者以三種方式(僅基于音頻、僅基于視頻以及視聽結合)分別對90個獨立剪輯進行評價,其中95%的剪輯都獲得了至少7位參與者的獨立評價,確保了數據的高質量和可靠性。

1.2 視覺特征

為了精準捕獲視覺特征,本研究采用多任務級聯卷積神經網絡人臉檢測算法[22],對數據集中的每一幀視頻剪輯進行人臉檢測與提取。該方法通過定義邊界框將人臉與背景區域分割開來,再對圖像進行歸一化處理,將其調整至標準尺寸224 × 224 × 3。在特征提取階段,本文引入了預訓練的情感高效網絡(emotion efficiency network,EmotiEffNet)模型[23],該模型已在野外面部表情、效價和喚醒計算數據庫(a database for facial expression, valence, and arousal computing in the wild,AffectNet)上針對情緒識別任務進行了優化[24],具備較強的情感特征提取能力。本研究的幀級面部特征表示由EmotiEffNet模型中分類前的最后一個完全連接層提取,特征數組維數為1 408。隨后,將每個視頻片段所有幀級面部特征表示按行拼接,并進行歸一化處理,最終形成一個尺寸為(Nv × 1 408)的矩陣,其中Nv為視覺幀數,作為本文模型視頻分支的輸入。

1.3 聽覺特征

本文聽覺特征的提取采用的是基于語音到特征向量(wav2vec2.0)模型[25]在多個情感數據集上進行微調后的版本——語音、情感、認知預訓練模型(wav2vec2.0-base-speech_emotion_recognition,wav2vec2.0-BSER)。而在音頻預處理階段,本研究使用了專用工具包[26],將音頻文件轉換為數組格式,并進行歸一化處理,以便后續特征提取。本文引入預訓練模型,并采用編碼器層的最終層歸一化輸出作為聽覺特征,特征數組維數為768。與視覺特征處理相似,本文將所有特征按行拼接后再次歸一化,形成(Na × 768)的聽覺序列矩陣,其中Na為序列長度。作為模型音頻分支的輸入,這種處理方式確保了聽覺特征在多模態情緒識別任務中的高效表示和整合。

1.4 CMMHA模塊

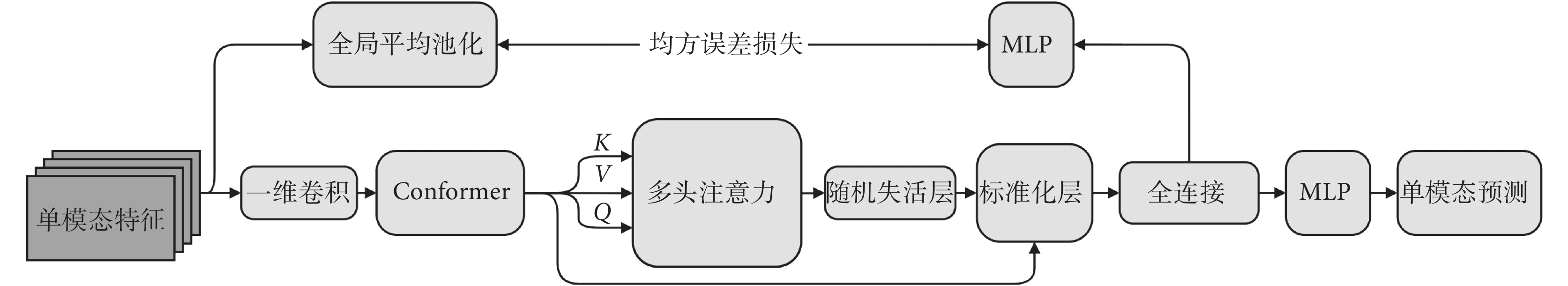

多頭注意力和交叉注意力機制均是自注意力機制的拓展與深化。其中,交叉注意力機制在捕捉局部特征和整合信息方面表現更佳,而多頭注意力機制通過其多角度的特征提取能力,使模型能夠更全面地理解輸入數據的復雜結構與語義信息。在此基礎上,如圖2所示,本研究創新性地提出 CMMHA 模塊,該模塊集成了多頭交叉注意力機制、隨機失活策略以及標準化技術。該模塊用于初步融合視覺序列和聽覺序列,實現跨模態特征的有效交互。本研究將交叉注意力機制擴展至多頭注意力框架內(頭數為5),并在交叉注意力中引入殘差結構。通過將交叉自注意力的計算結果與原始輸入查詢向量進行加權融合,使模型保留了更多的模態原始信息。此項改進旨在更有效地捕捉多模態數據中的豐富信息,從而提升模型在處理復雜數據時的性能。

圖2

多頭交叉注意力結構

Figure2.

Structure of multi-head cross-attention model

圖2

多頭交叉注意力結構

Figure2.

Structure of multi-head cross-attention model

交叉注意力輸入分為三部分:查詢(query,Q)、鍵值(key,K)、賦值(value,V)(分別以符號Q、K、V表示)。其中,K、V為同一模態特征,Q為另一模態特征。

多頭注意力機制在計算時,將各子張量的交叉注意力結果進行拼接,計算公式如式(1)~式(2)所示:

|

|

其中,CA(?)為交叉注意力函數,a、b為權重值,KT為K的轉置,d為特征維度,headi表示第i個注意力頭的輸出,Qi、Ki、Vi為第i個注意力頭的Q、K、V值。Q與KT的點積,經歸一化指數函數(softmax)后與V相乘獲得注意力權重,再與原始Q加權融合,得到交叉注意力函數的輸出headi。最后,將獲取到的5個注意力頭的輸出結果進行拼接,得到多頭交叉注意力輸出結果。

本研究針對兩個模態的特征引入了多頭交叉注意力機制,使每個向量能夠與其它模態的特征相互融合。這種方法不僅實現了不同表征間的潛在信息傳遞,還有效地協同反映了整體情感傾向。

1.5 單模態輔助損失任務

在多模態融合中,若模型過度依賴某一模態,一旦該模態的信息缺失或出現誤差時,可能會導致模型性能大幅下降;而單模態輔助損失任務在緩解模型對特定模態過度依賴方面起到了顯著作用。引入單模態輔助損失任務,能夠有效引導模型深入學習每個模態的獨特特征,從而提升其在不同模態組合及數據情況下的泛化能力。如圖1所示,在主網絡層中,為每個模態分別增設了兩個獨立的組件,以執行單模態輔助損失任務。針對單模態特征表示的輔助損失任務,本文采用MLP模塊作為輔助工具。該任務利用全局平均池化后的輸出表示與MLP輸出表示之間的均方誤差損失作為輔助損失值。本研究僅在單模態訓練階段使用輔助損失,從而豐富模型的損失函數,促使模型更加專注于單模態特征信息的學習。

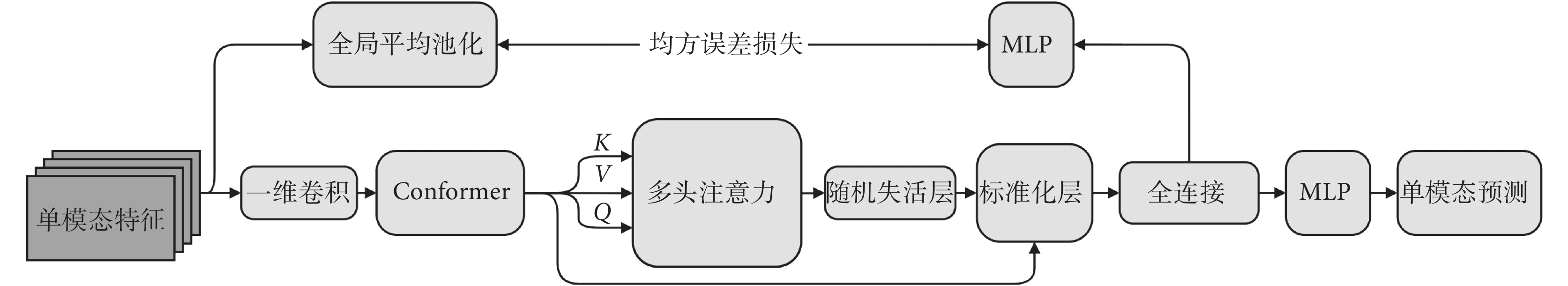

1.6 分段訓練策略

本文采用分段訓練策略來解決模態缺失問題。首先,在第一階段實施單模態輔助損失任務。如圖3所示,該階段分別針對兩個模態進行單模態訓練。在此過程中,CMMHA模塊不進行特征交叉操作,預測層不進行特征拼接,而是專注于訓練和保存單模態特征參數。這種策略旨在通過逐步優化單模態特征,提升模型在多模態信息缺失情況下的魯棒性。

圖3

第一段單模態訓練網絡結構圖

Figure3.

Structure of the first segment of the unimodal training network

圖3

第一段單模態訓練網絡結構圖

Figure3.

Structure of the first segment of the unimodal training network

當面臨整個模態缺失的情況時,則使用此模型來進行單模態情緒識別任務,不繼續第二階段的網絡訓練。此時模型向后傳播的總損失函數如式(3)所示:

|

其中,L為損失值,y為輸入標簽,pred為單模態情緒預測結果,Lpred是交叉熵損失函數,x是全局平均池化輸出,m是輔助損失任務的MLP輸出,α為重構損失的權重(本研究設置為2),LMSE是均方誤差損失函數。

當聽覺與視覺模態數據同時存在時,訓練進入第二階段,即凍結主網絡層參數,僅對預測層網絡結構參數進行訓練。此時模型向后傳播的總損失函數如式(4)所示:

|

z表示多模態情緒預測結果。本研究中采用分段訓練和模態共享的策略,通過充分挖掘不同模態之間的相關性,顯著減少模型參數數量,同時提升模型的性能和泛化能力。該策略在保留單模態信息的基礎上,能夠有效融合多模態信息,實現了視聽數據的跨模態表示,為解決模態缺失問題提供了一種有效的解決方案。

2 實驗設置

2.1 評價指標

對于多分類任務來說,僅靠單一的準確率無法全面評估整個模型性能表現,為直觀地表現出算法的有效性,本文采用準確率(accuracy,Acc)、宏觀召回率(macro recall,Ma-Rec)、宏觀精準率(macro precision,Ma-Pre)、宏觀F1分數(macro F1 score,Ma-F1)、微觀召回率(micro recall,Mi-Rec)、微觀精準率(micro precision,Mi-Pre)、微觀F1分數(micro F1 score,Mi-F1)等7個評價指標來評估視聽情緒識別模型在不同方面的性能表現。其中,微觀聚焦方法側重于對每個單獨樣本或數據點的性能進行分析,而宏觀評估則關注對每個類別或組的整體表現。在多分類任務中,結合宏觀和微觀評估方法能夠為分類模型的性能提供更加全面的視角和洞察力。這些評估指標不僅有助于更全面、更具魯棒性地評估模型性能,還能深入理解模型在不同維度上的表現,從而為模型的改進與優化提供指導。

2.2 實驗設定

為確保多分類任務的有效性,本文進行了5次實驗,并取實驗結果的平均值作為評估依據。在每次試驗中,隨機將70%的數據用于訓練集,15%的數據用于驗證集,另外15%的數據用于測試集。將這5次隨機劃分的結果保存,以便在其他實驗中使用,并選取最接近5次實驗平均值的一次劃分方式來進行消融實驗。本文利用每個模型5次實驗中各項指標的平均值,對模型性能展開評估。對于預測層和輔助損失任務的MLP模塊,采用3層全連接結構實現,其中輸入層和輸出節點根據實際情況進行調整,隱藏層設置為256個節點。實驗將訓練次數設置為20輪,批次大小為8,學習率大小設置為5 × 10–6,優化器采用自適應學習率優化算法。

3 實驗結果與分析

3.1 模型評估

3.1.1 注意力加權參數優化實驗

為了探究多頭交叉注意力中加權相加的最優權重值,本文進行了多組實驗進行對比分析,以確定最佳參數。實驗中,參數a代表初步融合后的加權值,而參數b則表示原始數據Q的加權值。本文通過對比分析模態交叉后的單模態與視聽模態的預測結果,深入探討了不同權重組合對模型性能的影響。

如表1所示,本文將參數劃分為5種情況進行分析,其中加粗字體為最優值。根據表1中數據分析,視聽模態和聽覺模態加權方式為(0.5,0.5)時結果最優,視覺模態加權方式為(0.7,0.3)時結果最優。這可能是由于在經過交叉融合后,不同模態的信息已經得到了較高程度地整合。通過相加操作,可以進一步將融合后的信息與原始信息結合,增強對多模態特征的表達能力,從而提升模型對關鍵信息的關注度。在狀態融合后,加權值在0.5~0.7之間表現最佳。值得注意的是,在(0.5,0.5)加權方式下,視覺模態的預測結果與最高值僅有微小差距,而聽覺模態和視聽模態的預測結果均達到最高值。綜合分析來看,采用(0.5,0.5)的加權方式是最優選擇。

3.1.2 特征方法對比實驗

本文實驗中,采用了兩個功能強大的視聽框架作為基線模型,對每個模型均進行了5次數據集隨機劃分,并將5次實驗的平均結果(average value,Avg)和標準差(standard deviation,SD)用于對比分析。

基線模型1:文獻[13]提出一個多功能視聽學習(versatile audio-visual learning,VAVL)框架,該框架通過視聽共享層、共享層上的殘差連接和單模態重建任務,有效地學習視聽特征表示,從而實現了多模態數據的高效表征。

基線模型2:文獻[16]設計出一種基于Transformer框架的輔助Transformer(auxiliary Transformer,AF)。該模型通過Transformer層生成跨模態表示,再通過特征拼接的方式實現兩個模態間的特征融合。

這兩個基線模型均采用了視覺幾何組網絡(visual geometry group network,VGG)作為視覺特征提取方法,并使用低級描述符進行聽覺特征提取。在實驗中,本文將這兩個模型的特征提取器替換為本文提出的視覺特征提取器和聽覺特征提取器(在表2中簡稱為替換后)。

如表2所示,本文所采用的特征提取器在提取特征方面表現出了顯著效果,以加粗字體顯示。在每個模型5次實驗中,SD均不超過3。在這種情況下,兩個基線模型在使用特征提取器后,整體性能和準確率均有明顯提升:AF和VAVL模型的各項指標均有較大幅度的提升。這種性能提升的原因可能在于,wav2vec2.0-BSER和EmotiEffNet這兩種網絡結構專為情感識別任務設計,能夠更全面、深入地捕捉到與情緒特征相關的細微變化,從而對情緒分類結果產生積極影響,使模型在不同情感類別間實現更為有效地區分。值得注意的是,即使在相同的特征提取器下,本研究所提出的模型性能仍優于基線模型。這主要歸因于本文CMMHA模塊在跨模態特征融合和分段訓練在融合兩種模態特征方面的高效性。這一結果進一步證實了本文所提出模型在情感識別任務中的卓越性能及其優異的適應能力。

3.1.3 組件消融實驗

為了更清晰地理解模型的工作機制,并明確哪些組件對提升模型性能至關重要,本研究在CREMA-D數據集上采用了一種數據集劃分效果最接近平均值的劃分策略。通過逐步添加模型中的關鍵組件,評估它們對整體性能的貢獻。具體實驗設置為:依次引入CMMHA模塊、分段訓練策略以及單模態輔助損失任務,并對實驗結果進行詳細分析。這種分步實驗方法能夠更系統地評估每個組件在提升模型性能方面所發揮的作用。

如表3所示,CMMHA模塊、分段訓練策略和單模態輔助損失任務的引入,對模型整體性能均產生了不同程度的提升,其中CMMHA模塊和分段訓練策略尤為關鍵。具體而言,添加CMMHA模塊和分段訓練策略后,Ma-F1和Mi-F1均有較高提升,雖然單模態輔助損失任務在Ma-F1的提升幅度相對較小,但Mi-F1實現了有效提升。這一結果主要歸因于CMMHA模塊在提取跨模態有效特征以及模態間關聯性表示方面發揮了重要作用;分段訓練策略有效捕捉了特定模態的異質性特征,在一定程度上引導了多模態融合的方向;而單模態輔助損失任務在分段訓練過程中,幫助捕獲單模態的特異性參數,豐富了模型的損失函數。這些結果表明,CMMHA模塊、分段訓練策略和單模態輔助損失任務的引入,對模型的性能提升起到了至關重要的作用,為其在跨模態情感識別任務中的表現提供了有力支持。

3.2 對比實驗

為了全面驗證視聽情緒識別模型的整體性能,本研究選取了近年備受關注且較為經典的多模態情緒識別模型進行對比分析,分別是經典的多模態轉換器(multimodal Transformer,Mult)[27]、多模態梯形網絡(multimodal ladder network,mult ladder net)[28],以及基于注意力和深度度量學習的跨模態音視頻融合多模態情感識別網絡(multimodal emotion recognition using cross modal audio-video fusion with attention and deep metric learning,deep attention model)[29],以及前文提到的AF和VAVL模型。這些對比模型均在CREMA-D數據集上展現了卓越的性能,且作為該領域的代表性模型已獲得廣泛認可。通過與這些模型的對比分析,可以更準確地評估本文所提出模型在多模態情緒識別中的改進與優勢。

如表4所示,加粗字體為最優結果。實驗結果與基線模型進行對比后顯示,在模型的整體性能方面,無論是在Ma-F1、Mi-F1等指標上,還是在情緒識別準確率方面,本文所提出的模型均展現出卓越的性能。該模型不僅優于經典的Mult網絡,而且相較于近年的其他模型,其性能表現也更為出色,實驗結果進一步證實了本模型在視聽情緒識別領域的高準確率和有效性。

如表5所示,盡管大部分情緒分類結果和整體準確率均超越了基線模型,但在單個情緒識別中,sad情緒的準確率相對略低。為探討這一現象,本研究對數據集進行了深入分析,由于本文采用的CREMA-D數據集標簽基于投票制分布,導致sad、disgust、fear和neutral情緒在標簽百分比分布上相對接近。這種投票制標簽分布的特性,使得sad和neutral情緒容易被誤判為其他情緒,從而影響了其識別準確率。因此,相較于anger和happy情緒,sad、disgust、fear和neutral情緒的識別準確率略顯不足。

4 結論

本文提出了一種跨模態視聽情緒識別模型,該模型巧妙融合了多頭交叉注意力機制、單模態輔助損失任務、分段訓練策略以及MLP分類器。本研究在CREMA-D數據集上的視聽模態情緒識別任務中取得了最佳性能:其中Ma-F1達到了84.5%, Mi-F1高達88.1%,準確率也達到了88.29%。與基線模型相比,本文模型所引入的分段訓練策略展現出顯著優勢,能夠更有效地捕獲并保留聽覺與視覺輸入中獨特的特征表示,從而提升了情緒識別的準確率。本研究不僅在多情感識別任務中表現卓越的性能,而且在僅有單一模態數據的情況下也能實現高效地情緒識別,這一特性使得該模型在實際應用中具有更高的靈活性和魯棒性。本研究為多模態情緒識別中的模態融合提供了一種創新思路,有效地豐富了特征表示的方法,期待未來能將這一框架推廣至更多模態的情感識別任務中,以進一步驗證其泛化能力和實際應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:王子瓊完成實驗設計與執行、數據采集與分析、論文初稿撰寫;趙德春指導論文寫作,提出修改意見;秦璐、陳毅和沈宇辰參與文獻資料整理、收集和數據分析。

0 引言

面部表情在人類日常交流中起著至關重要的作用[1],通過面部表情準確判斷他人的情緒,不僅能幫助人們更好地理解對方傳達的信息,還能在應對各種情況時提升效率[2]。近年來,隨著社交網絡中短視頻的迅速普及,視聽情感識別成為一個備受關注的研究熱點,并在多個領域展現出非常重要的應用價值[3-6]。情感識別系統通過結合視聽模態,能幫助人們在日常生活中實現準確的交流與互動,因此在多模態系統中,確保聽覺和視覺得到充分和適當地表達,是構建穩健多模態系統的關鍵。

在多模態融合情感分析方法方面,研究人員進行了廣泛的探索。比如,Cai等[7]提出了特征級和模型級融合視覺和聽覺特征策略,通過從人臉特征提取視覺線索與音頻特征相結合,并利用特征拼接可實現特征級融合。隨著研究的不斷深入,特征融合方法變得愈加多樣化[8-10]。例如,Shoaib等[11]在決策級融合中采用乘積規則,將不同模態的分類結果組合在一起;而Kollias等[12]提出了晚期融合方法,通過深度卷積神經網絡將提取的音頻和視覺特征連接起來;這些研究為多模態情感識別的進一步發展奠定了堅實的基礎。

如何在融合過程中有效整合不同模態的共性和差異性,是多模態表征學習面臨的核心挑戰之一。目前,大多數方法仍處于淺層融合階段,側重跨模態一致性,而常常忽略了模態之間的差異性。為了應對這一挑戰,研究者們通常采用共享參數的神經網絡架構來學習各模態的表示[13],隨后再進行融合。例如,Huang等[14]提出了一種雙流模態共享特征提取子網,通過在共享二維和三維特征空間中提取模態共享外觀特征和模態不變關系特征,從而減少模態間變化和模態內變化。有研究表明,通過注意力機制或交叉注意力機制動態關聯不同模態特征,也是提升模型在跨模態任務中靈活性和性能的有效策略[15-17]。此外,還有研究使用雙子空間融合技術,將每個模態投影到兩個子空間[18],以學習更加細致和有效的情態表征。隨著基于注意力機制的轉換器(Transformer)模型的引入[19],研究者們提出了一種單模態和多模態統一的綜合模型[20],顯著改善了多模態情感識別的性能表現,并為解決輸入模態缺失問題提供了創新的解決方案。這些方法的不斷優化,為多模態表征學習領域帶來了新的突破和發展前景。

基于上述研究,本文提出了一種全新的跨模態視聽情緒識別模型,該模型在統一的模型結構中引入跨模態任務,其核心在于通過多頭交叉注意力機制實現跨模態融合,從而在更大程度上保留模態之間和模態內部的語義相關性。此外,本文引入了分段訓練策略,將多模態與單模態特征參數在同一框架下實現無縫整合與共享。這種設計使得該框架不僅在多模態情境下表現出色,還能在模態信息缺失時執行單模態情緒識別,從而顯著提升其適用性和魯棒性。綜上,本文旨在構建一個功能強大且具綜合性的跨模態情感識別網絡,以期滿足復雜多樣的實際應用需求。

1 方法

本研究提出了一種融合多頭交叉注意力和單模態重建結構的跨模態視聽情緒識別模型,如圖1所示。該模型由特征提取層、主網絡層及預測層構成。在特征提取層中,分別采用特定的方法從視覺和聽覺輸入中提取出對應特征。主網絡層集成了用于語音識別的卷積增強Transformer(convolution-augmented Transformer for speech recognition,Conformer)模型、一維卷積、多頭跨模態注意力(corss-molde multi-head attention,CMMHA)模塊以及單模態輔助損失任務。借助這些技術與模塊的集成運用,主網絡層可實現不同模態特征維度的對齊,并行處理所有視覺幀和聽覺幀,進一步優化模型表現并提升其泛化能力。在預測層中,模型包含視覺模態預測、聽覺模態預測和視聽模態預測三部分。與兩種單模態預測不同,視聽模態預測在進行分類前,需要將經過處理的視聽特征進行拼接融合,再通過多層感知機(multilayer perceptron,MLP)完成最終的分類任務。這種設計有效提升了模型在多模態情緒識別任務中的表現,為視聽情感識別提供了更為穩健的解決方案。

圖1

網絡整體結構

Figure1.

Overall structure of network

圖1

網絡整體結構

Figure1.

Overall structure of network

1.1 數據集

本研究使用的數據來源于賓夕法尼亞州切尼大學計算機科學相關專業創建并維護的眾包情感多模態演員數據集(crowd-sourced emotional multimodal actors dataset,CREMA-D)[21]。該數據集包含91位演員的7 442個原始剪輯數據集,是研究多模態表達和基本情緒感知的常用資源。這些視頻剪輯包括了演員們在快樂(happy)、悲傷(sad)、憤怒(anger)、恐懼(fear)、厭惡(disgust)和中性(neutral)等一系列基本情緒狀態下,通過面部表情和聲音情感表達進行的演繹,每段視頻均表現了單個人的情緒表達。這些視頻由2 443名參與者以三種方式(僅基于音頻、僅基于視頻以及視聽結合)分別對90個獨立剪輯進行評價,其中95%的剪輯都獲得了至少7位參與者的獨立評價,確保了數據的高質量和可靠性。

1.2 視覺特征

為了精準捕獲視覺特征,本研究采用多任務級聯卷積神經網絡人臉檢測算法[22],對數據集中的每一幀視頻剪輯進行人臉檢測與提取。該方法通過定義邊界框將人臉與背景區域分割開來,再對圖像進行歸一化處理,將其調整至標準尺寸224 × 224 × 3。在特征提取階段,本文引入了預訓練的情感高效網絡(emotion efficiency network,EmotiEffNet)模型[23],該模型已在野外面部表情、效價和喚醒計算數據庫(a database for facial expression, valence, and arousal computing in the wild,AffectNet)上針對情緒識別任務進行了優化[24],具備較強的情感特征提取能力。本研究的幀級面部特征表示由EmotiEffNet模型中分類前的最后一個完全連接層提取,特征數組維數為1 408。隨后,將每個視頻片段所有幀級面部特征表示按行拼接,并進行歸一化處理,最終形成一個尺寸為(Nv × 1 408)的矩陣,其中Nv為視覺幀數,作為本文模型視頻分支的輸入。

1.3 聽覺特征

本文聽覺特征的提取采用的是基于語音到特征向量(wav2vec2.0)模型[25]在多個情感數據集上進行微調后的版本——語音、情感、認知預訓練模型(wav2vec2.0-base-speech_emotion_recognition,wav2vec2.0-BSER)。而在音頻預處理階段,本研究使用了專用工具包[26],將音頻文件轉換為數組格式,并進行歸一化處理,以便后續特征提取。本文引入預訓練模型,并采用編碼器層的最終層歸一化輸出作為聽覺特征,特征數組維數為768。與視覺特征處理相似,本文將所有特征按行拼接后再次歸一化,形成(Na × 768)的聽覺序列矩陣,其中Na為序列長度。作為模型音頻分支的輸入,這種處理方式確保了聽覺特征在多模態情緒識別任務中的高效表示和整合。

1.4 CMMHA模塊

多頭注意力和交叉注意力機制均是自注意力機制的拓展與深化。其中,交叉注意力機制在捕捉局部特征和整合信息方面表現更佳,而多頭注意力機制通過其多角度的特征提取能力,使模型能夠更全面地理解輸入數據的復雜結構與語義信息。在此基礎上,如圖2所示,本研究創新性地提出 CMMHA 模塊,該模塊集成了多頭交叉注意力機制、隨機失活策略以及標準化技術。該模塊用于初步融合視覺序列和聽覺序列,實現跨模態特征的有效交互。本研究將交叉注意力機制擴展至多頭注意力框架內(頭數為5),并在交叉注意力中引入殘差結構。通過將交叉自注意力的計算結果與原始輸入查詢向量進行加權融合,使模型保留了更多的模態原始信息。此項改進旨在更有效地捕捉多模態數據中的豐富信息,從而提升模型在處理復雜數據時的性能。

圖2

多頭交叉注意力結構

Figure2.

Structure of multi-head cross-attention model

圖2

多頭交叉注意力結構

Figure2.

Structure of multi-head cross-attention model

交叉注意力輸入分為三部分:查詢(query,Q)、鍵值(key,K)、賦值(value,V)(分別以符號Q、K、V表示)。其中,K、V為同一模態特征,Q為另一模態特征。

多頭注意力機制在計算時,將各子張量的交叉注意力結果進行拼接,計算公式如式(1)~式(2)所示:

|

|

其中,CA(?)為交叉注意力函數,a、b為權重值,KT為K的轉置,d為特征維度,headi表示第i個注意力頭的輸出,Qi、Ki、Vi為第i個注意力頭的Q、K、V值。Q與KT的點積,經歸一化指數函數(softmax)后與V相乘獲得注意力權重,再與原始Q加權融合,得到交叉注意力函數的輸出headi。最后,將獲取到的5個注意力頭的輸出結果進行拼接,得到多頭交叉注意力輸出結果。

本研究針對兩個模態的特征引入了多頭交叉注意力機制,使每個向量能夠與其它模態的特征相互融合。這種方法不僅實現了不同表征間的潛在信息傳遞,還有效地協同反映了整體情感傾向。

1.5 單模態輔助損失任務

在多模態融合中,若模型過度依賴某一模態,一旦該模態的信息缺失或出現誤差時,可能會導致模型性能大幅下降;而單模態輔助損失任務在緩解模型對特定模態過度依賴方面起到了顯著作用。引入單模態輔助損失任務,能夠有效引導模型深入學習每個模態的獨特特征,從而提升其在不同模態組合及數據情況下的泛化能力。如圖1所示,在主網絡層中,為每個模態分別增設了兩個獨立的組件,以執行單模態輔助損失任務。針對單模態特征表示的輔助損失任務,本文采用MLP模塊作為輔助工具。該任務利用全局平均池化后的輸出表示與MLP輸出表示之間的均方誤差損失作為輔助損失值。本研究僅在單模態訓練階段使用輔助損失,從而豐富模型的損失函數,促使模型更加專注于單模態特征信息的學習。

1.6 分段訓練策略

本文采用分段訓練策略來解決模態缺失問題。首先,在第一階段實施單模態輔助損失任務。如圖3所示,該階段分別針對兩個模態進行單模態訓練。在此過程中,CMMHA模塊不進行特征交叉操作,預測層不進行特征拼接,而是專注于訓練和保存單模態特征參數。這種策略旨在通過逐步優化單模態特征,提升模型在多模態信息缺失情況下的魯棒性。

圖3

第一段單模態訓練網絡結構圖

Figure3.

Structure of the first segment of the unimodal training network

圖3

第一段單模態訓練網絡結構圖

Figure3.

Structure of the first segment of the unimodal training network

當面臨整個模態缺失的情況時,則使用此模型來進行單模態情緒識別任務,不繼續第二階段的網絡訓練。此時模型向后傳播的總損失函數如式(3)所示:

|

其中,L為損失值,y為輸入標簽,pred為單模態情緒預測結果,Lpred是交叉熵損失函數,x是全局平均池化輸出,m是輔助損失任務的MLP輸出,α為重構損失的權重(本研究設置為2),LMSE是均方誤差損失函數。

當聽覺與視覺模態數據同時存在時,訓練進入第二階段,即凍結主網絡層參數,僅對預測層網絡結構參數進行訓練。此時模型向后傳播的總損失函數如式(4)所示:

|

z表示多模態情緒預測結果。本研究中采用分段訓練和模態共享的策略,通過充分挖掘不同模態之間的相關性,顯著減少模型參數數量,同時提升模型的性能和泛化能力。該策略在保留單模態信息的基礎上,能夠有效融合多模態信息,實現了視聽數據的跨模態表示,為解決模態缺失問題提供了一種有效的解決方案。

2 實驗設置

2.1 評價指標

對于多分類任務來說,僅靠單一的準確率無法全面評估整個模型性能表現,為直觀地表現出算法的有效性,本文采用準確率(accuracy,Acc)、宏觀召回率(macro recall,Ma-Rec)、宏觀精準率(macro precision,Ma-Pre)、宏觀F1分數(macro F1 score,Ma-F1)、微觀召回率(micro recall,Mi-Rec)、微觀精準率(micro precision,Mi-Pre)、微觀F1分數(micro F1 score,Mi-F1)等7個評價指標來評估視聽情緒識別模型在不同方面的性能表現。其中,微觀聚焦方法側重于對每個單獨樣本或數據點的性能進行分析,而宏觀評估則關注對每個類別或組的整體表現。在多分類任務中,結合宏觀和微觀評估方法能夠為分類模型的性能提供更加全面的視角和洞察力。這些評估指標不僅有助于更全面、更具魯棒性地評估模型性能,還能深入理解模型在不同維度上的表現,從而為模型的改進與優化提供指導。

2.2 實驗設定

為確保多分類任務的有效性,本文進行了5次實驗,并取實驗結果的平均值作為評估依據。在每次試驗中,隨機將70%的數據用于訓練集,15%的數據用于驗證集,另外15%的數據用于測試集。將這5次隨機劃分的結果保存,以便在其他實驗中使用,并選取最接近5次實驗平均值的一次劃分方式來進行消融實驗。本文利用每個模型5次實驗中各項指標的平均值,對模型性能展開評估。對于預測層和輔助損失任務的MLP模塊,采用3層全連接結構實現,其中輸入層和輸出節點根據實際情況進行調整,隱藏層設置為256個節點。實驗將訓練次數設置為20輪,批次大小為8,學習率大小設置為5 × 10–6,優化器采用自適應學習率優化算法。

3 實驗結果與分析

3.1 模型評估

3.1.1 注意力加權參數優化實驗

為了探究多頭交叉注意力中加權相加的最優權重值,本文進行了多組實驗進行對比分析,以確定最佳參數。實驗中,參數a代表初步融合后的加權值,而參數b則表示原始數據Q的加權值。本文通過對比分析模態交叉后的單模態與視聽模態的預測結果,深入探討了不同權重組合對模型性能的影響。

如表1所示,本文將參數劃分為5種情況進行分析,其中加粗字體為最優值。根據表1中數據分析,視聽模態和聽覺模態加權方式為(0.5,0.5)時結果最優,視覺模態加權方式為(0.7,0.3)時結果最優。這可能是由于在經過交叉融合后,不同模態的信息已經得到了較高程度地整合。通過相加操作,可以進一步將融合后的信息與原始信息結合,增強對多模態特征的表達能力,從而提升模型對關鍵信息的關注度。在狀態融合后,加權值在0.5~0.7之間表現最佳。值得注意的是,在(0.5,0.5)加權方式下,視覺模態的預測結果與最高值僅有微小差距,而聽覺模態和視聽模態的預測結果均達到最高值。綜合分析來看,采用(0.5,0.5)的加權方式是最優選擇。

3.1.2 特征方法對比實驗

本文實驗中,采用了兩個功能強大的視聽框架作為基線模型,對每個模型均進行了5次數據集隨機劃分,并將5次實驗的平均結果(average value,Avg)和標準差(standard deviation,SD)用于對比分析。

基線模型1:文獻[13]提出一個多功能視聽學習(versatile audio-visual learning,VAVL)框架,該框架通過視聽共享層、共享層上的殘差連接和單模態重建任務,有效地學習視聽特征表示,從而實現了多模態數據的高效表征。

基線模型2:文獻[16]設計出一種基于Transformer框架的輔助Transformer(auxiliary Transformer,AF)。該模型通過Transformer層生成跨模態表示,再通過特征拼接的方式實現兩個模態間的特征融合。

這兩個基線模型均采用了視覺幾何組網絡(visual geometry group network,VGG)作為視覺特征提取方法,并使用低級描述符進行聽覺特征提取。在實驗中,本文將這兩個模型的特征提取器替換為本文提出的視覺特征提取器和聽覺特征提取器(在表2中簡稱為替換后)。

如表2所示,本文所采用的特征提取器在提取特征方面表現出了顯著效果,以加粗字體顯示。在每個模型5次實驗中,SD均不超過3。在這種情況下,兩個基線模型在使用特征提取器后,整體性能和準確率均有明顯提升:AF和VAVL模型的各項指標均有較大幅度的提升。這種性能提升的原因可能在于,wav2vec2.0-BSER和EmotiEffNet這兩種網絡結構專為情感識別任務設計,能夠更全面、深入地捕捉到與情緒特征相關的細微變化,從而對情緒分類結果產生積極影響,使模型在不同情感類別間實現更為有效地區分。值得注意的是,即使在相同的特征提取器下,本研究所提出的模型性能仍優于基線模型。這主要歸因于本文CMMHA模塊在跨模態特征融合和分段訓練在融合兩種模態特征方面的高效性。這一結果進一步證實了本文所提出模型在情感識別任務中的卓越性能及其優異的適應能力。

3.1.3 組件消融實驗

為了更清晰地理解模型的工作機制,并明確哪些組件對提升模型性能至關重要,本研究在CREMA-D數據集上采用了一種數據集劃分效果最接近平均值的劃分策略。通過逐步添加模型中的關鍵組件,評估它們對整體性能的貢獻。具體實驗設置為:依次引入CMMHA模塊、分段訓練策略以及單模態輔助損失任務,并對實驗結果進行詳細分析。這種分步實驗方法能夠更系統地評估每個組件在提升模型性能方面所發揮的作用。

如表3所示,CMMHA模塊、分段訓練策略和單模態輔助損失任務的引入,對模型整體性能均產生了不同程度的提升,其中CMMHA模塊和分段訓練策略尤為關鍵。具體而言,添加CMMHA模塊和分段訓練策略后,Ma-F1和Mi-F1均有較高提升,雖然單模態輔助損失任務在Ma-F1的提升幅度相對較小,但Mi-F1實現了有效提升。這一結果主要歸因于CMMHA模塊在提取跨模態有效特征以及模態間關聯性表示方面發揮了重要作用;分段訓練策略有效捕捉了特定模態的異質性特征,在一定程度上引導了多模態融合的方向;而單模態輔助損失任務在分段訓練過程中,幫助捕獲單模態的特異性參數,豐富了模型的損失函數。這些結果表明,CMMHA模塊、分段訓練策略和單模態輔助損失任務的引入,對模型的性能提升起到了至關重要的作用,為其在跨模態情感識別任務中的表現提供了有力支持。

3.2 對比實驗

為了全面驗證視聽情緒識別模型的整體性能,本研究選取了近年備受關注且較為經典的多模態情緒識別模型進行對比分析,分別是經典的多模態轉換器(multimodal Transformer,Mult)[27]、多模態梯形網絡(multimodal ladder network,mult ladder net)[28],以及基于注意力和深度度量學習的跨模態音視頻融合多模態情感識別網絡(multimodal emotion recognition using cross modal audio-video fusion with attention and deep metric learning,deep attention model)[29],以及前文提到的AF和VAVL模型。這些對比模型均在CREMA-D數據集上展現了卓越的性能,且作為該領域的代表性模型已獲得廣泛認可。通過與這些模型的對比分析,可以更準確地評估本文所提出模型在多模態情緒識別中的改進與優勢。

如表4所示,加粗字體為最優結果。實驗結果與基線模型進行對比后顯示,在模型的整體性能方面,無論是在Ma-F1、Mi-F1等指標上,還是在情緒識別準確率方面,本文所提出的模型均展現出卓越的性能。該模型不僅優于經典的Mult網絡,而且相較于近年的其他模型,其性能表現也更為出色,實驗結果進一步證實了本模型在視聽情緒識別領域的高準確率和有效性。

如表5所示,盡管大部分情緒分類結果和整體準確率均超越了基線模型,但在單個情緒識別中,sad情緒的準確率相對略低。為探討這一現象,本研究對數據集進行了深入分析,由于本文采用的CREMA-D數據集標簽基于投票制分布,導致sad、disgust、fear和neutral情緒在標簽百分比分布上相對接近。這種投票制標簽分布的特性,使得sad和neutral情緒容易被誤判為其他情緒,從而影響了其識別準確率。因此,相較于anger和happy情緒,sad、disgust、fear和neutral情緒的識別準確率略顯不足。

4 結論

本文提出了一種跨模態視聽情緒識別模型,該模型巧妙融合了多頭交叉注意力機制、單模態輔助損失任務、分段訓練策略以及MLP分類器。本研究在CREMA-D數據集上的視聽模態情緒識別任務中取得了最佳性能:其中Ma-F1達到了84.5%, Mi-F1高達88.1%,準確率也達到了88.29%。與基線模型相比,本文模型所引入的分段訓練策略展現出顯著優勢,能夠更有效地捕獲并保留聽覺與視覺輸入中獨特的特征表示,從而提升了情緒識別的準確率。本研究不僅在多情感識別任務中表現卓越的性能,而且在僅有單一模態數據的情況下也能實現高效地情緒識別,這一特性使得該模型在實際應用中具有更高的靈活性和魯棒性。本研究為多模態情緒識別中的模態融合提供了一種創新思路,有效地豐富了特征表示的方法,期待未來能將這一框架推廣至更多模態的情感識別任務中,以進一步驗證其泛化能力和實際應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:王子瓊完成實驗設計與執行、數據采集與分析、論文初稿撰寫;趙德春指導論文寫作,提出修改意見;秦璐、陳毅和沈宇辰參與文獻資料整理、收集和數據分析。