基于深度學習的微創手術工具檢測與跟蹤技術在微創外科手術中的應用是目前的一個研究熱點。本文首先對微創手術工具檢測與跟蹤的相關技術內容進行系統闡述,主要介紹了基于深度學習算法的優勢。然后,本文概述了基于完全監督的深度神經網絡手術工具檢測與跟蹤算法以及新興的基于弱監督的深度神經網絡手術工具檢測與跟蹤的算法,重點歸納了基于深度卷積神經網絡及遞歸神經網絡的幾種典型算法框架及其流程圖,以便相關領域的科研工作者更系統地了解目前研究進展,同時可為微創外科手術醫生選擇導航技術時提供參考。最后,本文為基于深度學習的微創手術工具檢測與跟蹤技術的進一步研究提供了一個大致的方向。

引用本文: 劉玉瑩, 趙子健. 基于深度學習的微創手術工具檢測與跟蹤研究綜述. 生物醫學工程學雜志, 2019, 36(5): 870-878. doi: 10.7507/1001-5515.201904061 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

引言

微創外科手術(minimally invasive surgeries, MIS)與傳統外科手術相比具有許多優勢,例如:創傷小、疼痛少、術后恢復時間短等,現已成為通用的外科手術選擇[1]。但 MIS 采用間接觀察和操縱的方式,使得深度感知復雜化、手術視野和操作空間狹窄,降低了醫生的手眼協調,因而可能會在實際操作中對器官或組織造成損傷,所以需要以其他手段獲取額外信息來監測在體內移動的手術工具,而微創手術工具檢測與跟蹤算法就可以為 MIS 中的操作導航提供這樣的重要信息。微創手術工具的檢測與跟蹤算法可以確定微創手術工具的位置和空間姿態,為執行手術的臨床醫生或機器人提供精確實時的導航,使手術過程更順利安全。

微創手術工具檢測與跟蹤,有基于硬件和基于視覺的兩種解決方式,但由于基于視覺的解決方式,既簡單又不需要額外的設備,現已成為目前主要的研究方向。通過系統軟件,基于視覺的解決方式可以直接對圖像中的手術工具進行某些特征提取,即可檢測與跟蹤微創手術工具在圖像中的位置,從而為微創手術工具操縱提供導航。

值得一提的是,現在微創手術工具檢測與跟蹤技術日趨發展成熟,既有從傳統的自行設計特征、分類器,發展到現在的基于深度學習的端到端(end to end)算法;也有基于深度學習的從先檢測后跟蹤,發展到檢測與跟蹤融為一體的算法。本文主要介紹了基于完全監督深度學習神經網絡和基于弱監督深度學習神經網絡的微創手術工具檢測與跟蹤算法,以便相關領域的科研工作者更系統地了解目前研究進展,同時為微創外科手術醫生選擇合適的導航技術提供參考。最后,本文為基于深度學習的微創手術工具檢測與跟蹤技術的進一步研究提供了一個大致的方向。

1 深度學習理論

目前微創手術工具檢測與跟蹤算法可以被劃分為生成式(generative model)模型和判別式(discriminative model)模型兩大類別[2]。生成式模型主要有基于特征匹配的方法、基于貝葉斯跟蹤的方法以及運動檢測的方法等[3-4]。判別式模型則采用模式分類方法,例如:支持向量機(support vector machine,SVM)、隨機森林、大部分基于深度學習的方法等[4-5]。判別式模型因為能夠明顯地區分背景和前景的信息,逐漸在微創手術工具檢測與跟蹤領域占據主流地位。

上文所提到的生成式模型中所有的方法和判別式模型中的 SVM 及隨機森林方法通常有較多的局限,比如:需要手工設計特征,不精確且耗費人力;難以構建高級的語義信息;無法應用于復雜場景等。但是基于深度學習的模型以人工神經網絡為架構對數據進行表征學習,具有學習能力強、特征表達能力高效、語義特征更高級的特點,所以從 2013 年以來研究者們普遍關注怎樣解決基于深度學習的微創手術工具檢測與跟蹤問題[6]。

解決基于深度學習的微創手術工具檢測與跟蹤問題與解決基于深度學習的車輛檢測與跟蹤問題不同,前者存在目標更容易丟失、數據集更少、場景更加復雜等難題。同時微創手術工具的數據集也會因為遮擋、鏡面反射、手術場景中出血或煙霧導致信息丟失,進而影響微創手術工具檢測與跟蹤的測試效果[2]。多年來研究者們直面難題,搭建全新的深度神經網絡,或者將用于解決各種醫學圖像分割或識別問題中的深度神經網絡進一步拓展應用在基于深度學習的微創手術工具檢測與跟蹤任務中[7]。研究者們的努力使得基于深度學習的微創手術工具檢測與跟蹤技術不斷發展,至今已有多種基于深度學習的微創手術工具檢測與跟蹤算法被應用于 MIS 中。

現在基于深度學習的微創手術工具檢測與跟蹤算法中有兩種主流深度神經網絡模型:完全監督深度神經網絡模型和弱監督深度神經網絡模型。下面介紹近年來基于深度學習的微創手術工具檢測與跟蹤算法中測試效果較好的基于完全監督深度神經網絡和基于弱監督深度神經網絡的微創手術工具檢測與跟蹤算法。

2 基于完全監督深度神經網絡的微創手術工具檢測與跟蹤算法

2.1 以卷積神經網絡為骨干的經典算法

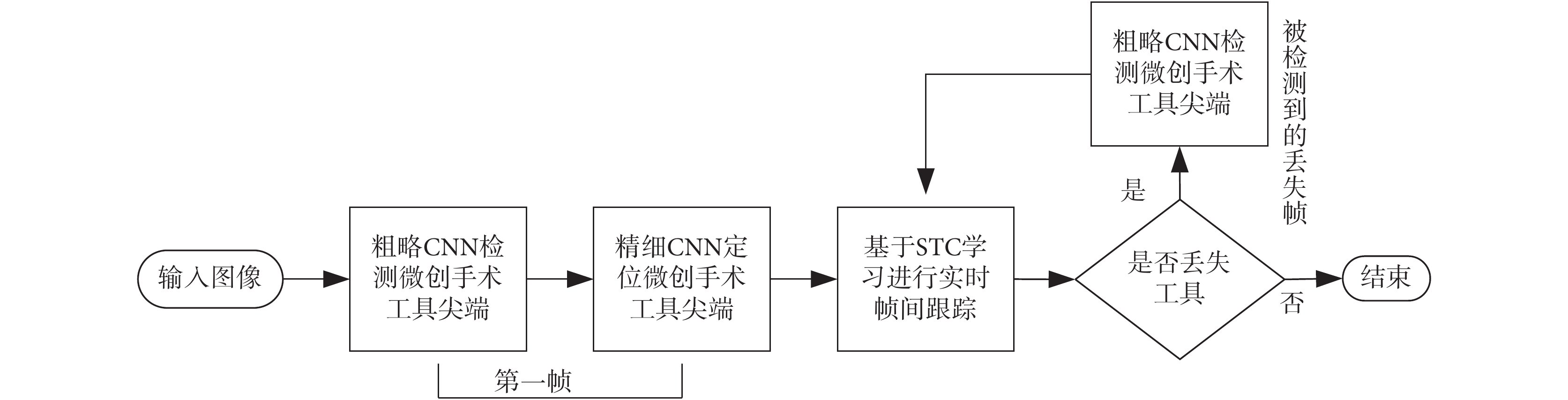

2.1.1 卷積神經網絡結合線段檢測

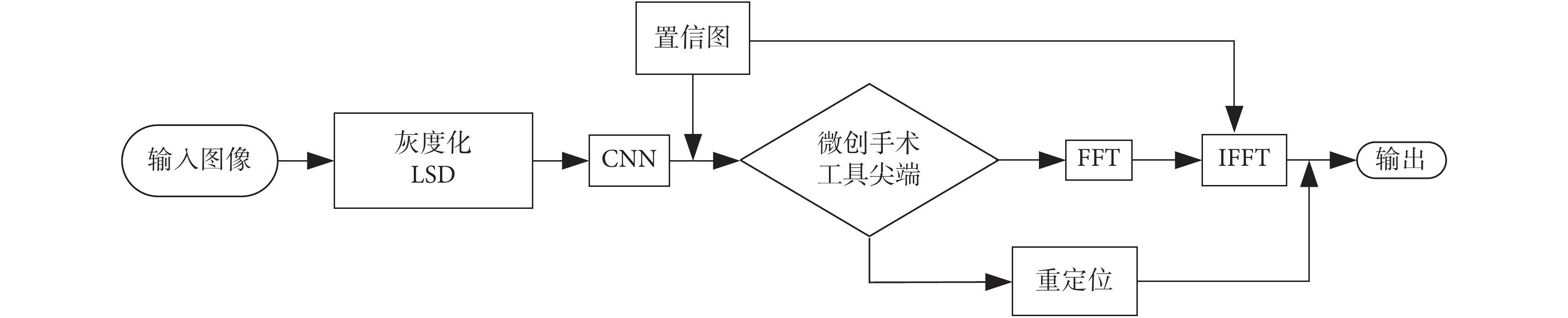

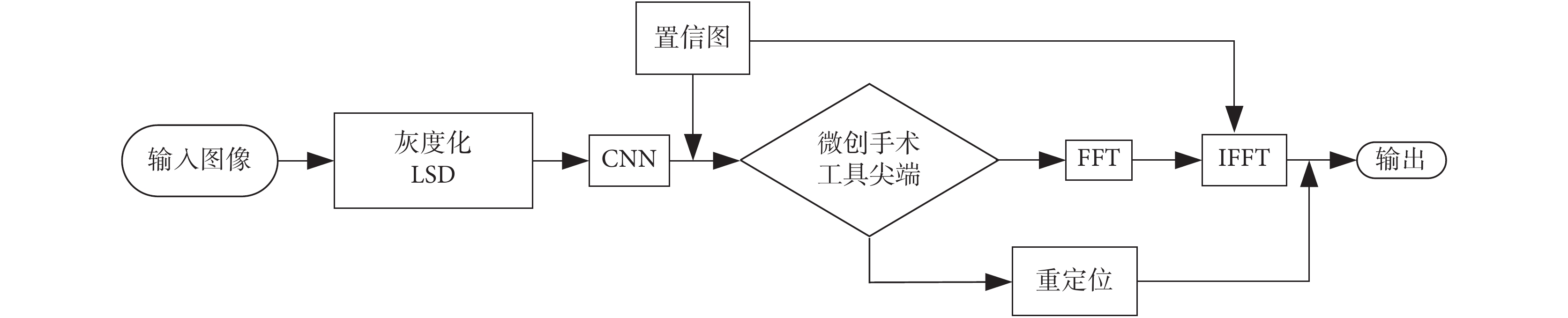

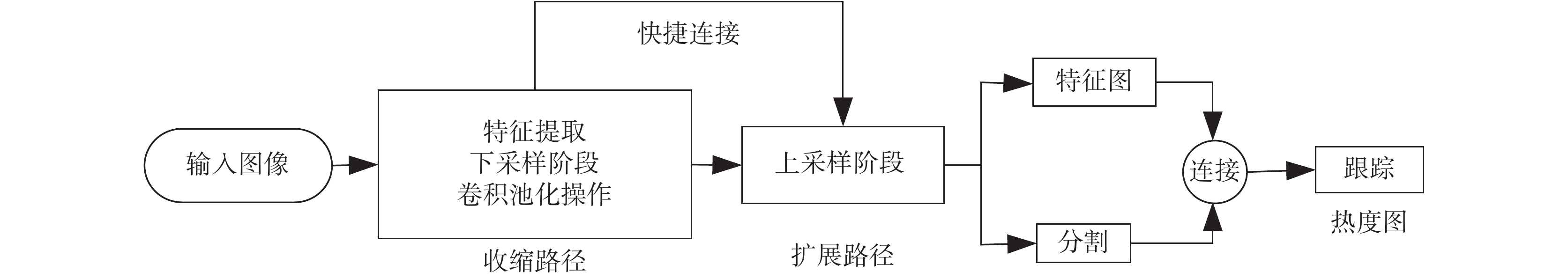

神經網絡的層數并不是越深越好,過深的神經網絡會帶來一系列的問題,比如圖像細節信息丟失、更新困難、定位更加復雜等。適當深度的神經網絡層數結合經典算法取得的效果或許更佳,例如 Chen 等[8]提出了一種卷積神經網絡(convolutional neural network,CNN)結合傳統線段檢測(line segment detection,LSD)的微創手術工具檢測與跟蹤算法。該研究使用了 CNN 檢測和時空上下文(spatio-temporal context,STC)學習跟蹤算法,在視頻幀之間進行微創手術工具的檢測與跟蹤。在檢測之前,先用 LSD 來檢測微創手術工具外觀的線段并標記它們,然后使用有標記的圖像作為數據集來訓練 CNN,這些線段的位置有助于快速準確地檢測微創手術工具的尖端。最后使用 STC 學習算法逐幀跟蹤微創手術工具,STC 關鍵點在于有效利用快速傅里葉變換(fast fourier transform,FFT)和逆快速傅里葉變換(inverse fast fourier transform,IFFT)。實驗結果表明,在微創手術工具檢測與跟蹤任務中,Chen 等[8]提出的方法具有先進的二維跟蹤性能,準確率為 93.2%,處理速度達到了 25 幀/s,故而該方法適合用于對實時性要求不是很高,但是對準確率要求較高的 MIS 中。如圖1 所示是其微創手術工具檢測與跟蹤算法流程圖。

圖1

CNN 結合 LSD 的微創手術工具檢測與跟蹤算法

Figure1.

CNN combined with LSD for minimally invasive surgical tool detection and tracking algorithm

圖1

CNN 結合 LSD 的微創手術工具檢測與跟蹤算法

Figure1.

CNN combined with LSD for minimally invasive surgical tool detection and tracking algorithm

2.1.2 卷積神經網絡結合支持向量機以及隱馬爾科夫模型

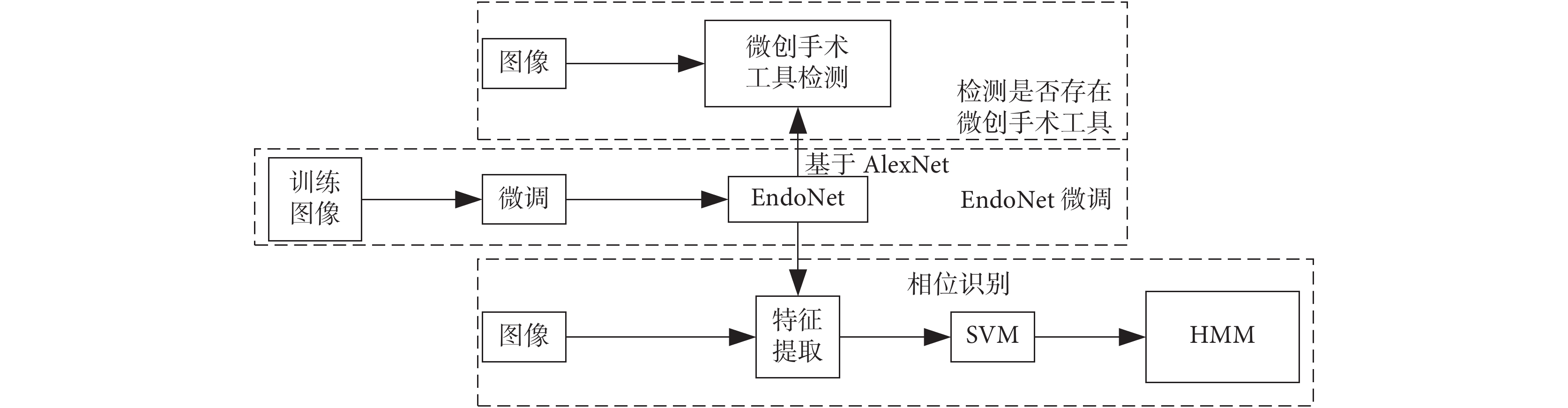

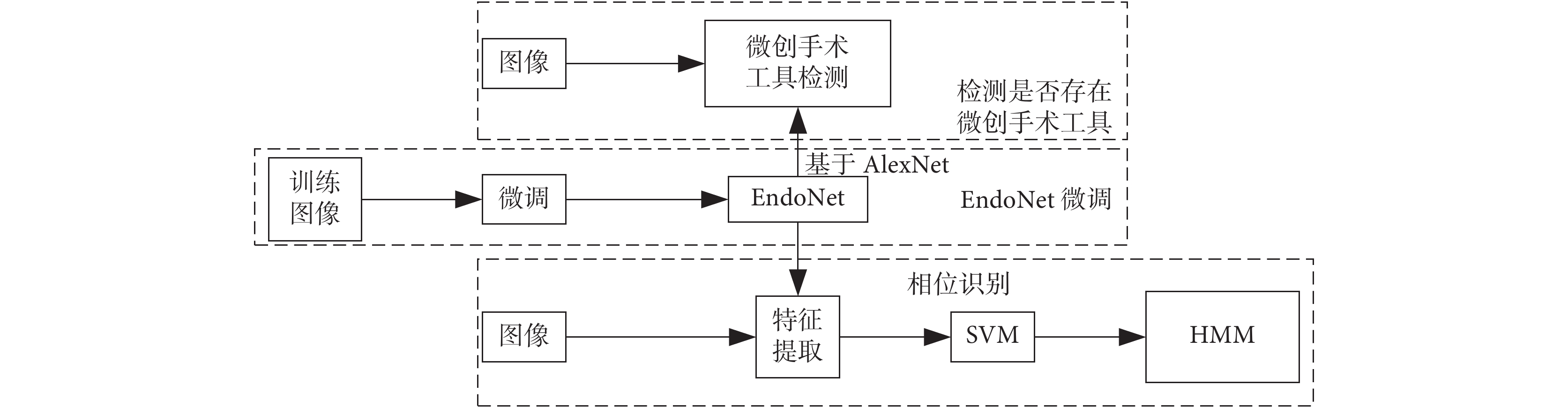

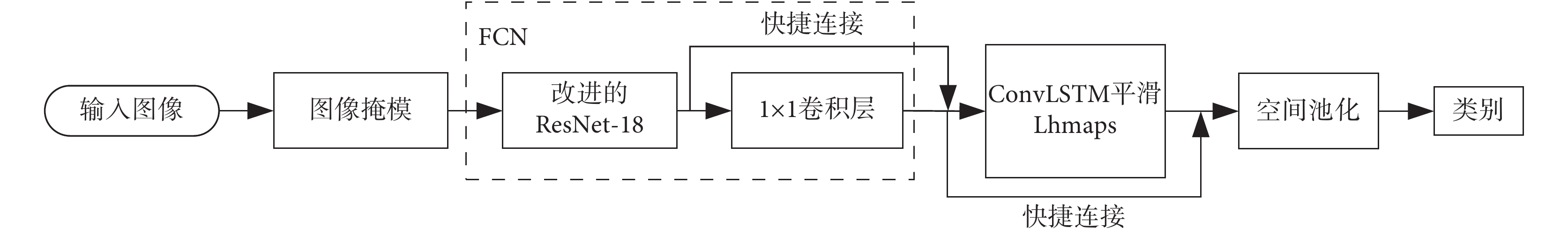

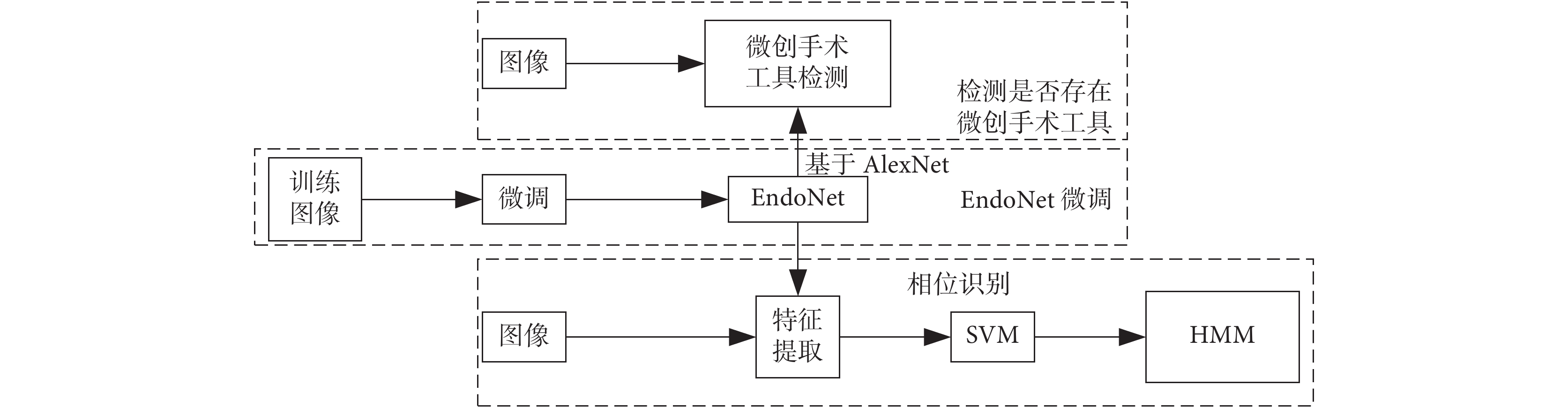

2017 年,Sahu 等[9]提出了用改進亞歷克斯網絡(AlexNet)結合隨機森林實現微創手術工具的檢測,Twinanda 等[4]則提出了將 AlexNet 改進用于解決微創手術工具檢測與跟蹤問題。Twinanda 等[4]所提出算法的流程如圖2 所示:輸入訓練圖像后首先通過微調過程訓練內網絡(EndoNet),EndoNet 就是 AlexNet 的擴展。在 EndoNet 被訓練之后,用于微創手術工具檢測與跟蹤任務。對于微創手術工具的存在檢測,EndoNet 給出的置信度直接用于執行任務;對于微創手術工具的跟蹤,EndoNet 用于從圖像中提取微創手術工具的視覺特征,然后將這些特征傳遞給 SVM 和分層隱馬爾科夫模型(hidden markov model,HMM)以完成微創手術工具檢測與跟蹤。雖然 Twinanda 等[4]給出的測試結果中顯示無法達到當前實時的標準(大于 20 幀/s),但 Twinanda 等[4]和斯特拉斯堡大學醫院(University Hospital of Strasbourg,HUS)建立了膽囊切除術數據集(Cholec80 Dataset)(網址為:http://camma.u-strasbg.fr/datasets),Cholec80 數據集包含了 13 名外科醫生進行的 80 個膽囊切除手術的視頻。因為在基于深度學習的微創手術檢測與跟蹤領域,可用于訓練的數據集非常稀少,所以 Twinanda 等[4]為研究者們的研究帶來了極大的便利。

圖2

CNN 結合 SVM 以及 HMM 的微創手術工具檢測與跟蹤算法

Figure2.

CNN combined with SVM and HMM for minimally invasive surgical tool detection and tracking algorithm

圖2

CNN 結合 SVM 以及 HMM 的微創手術工具檢測與跟蹤算法

Figure2.

CNN combined with SVM and HMM for minimally invasive surgical tool detection and tracking algorithm

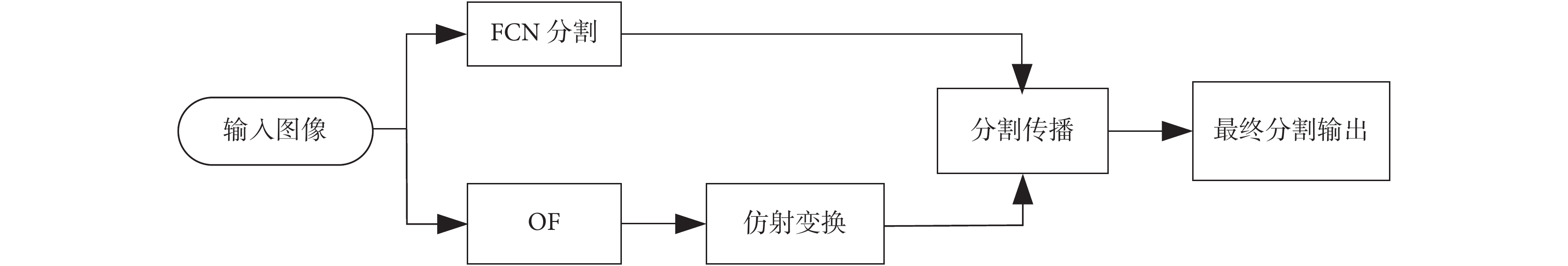

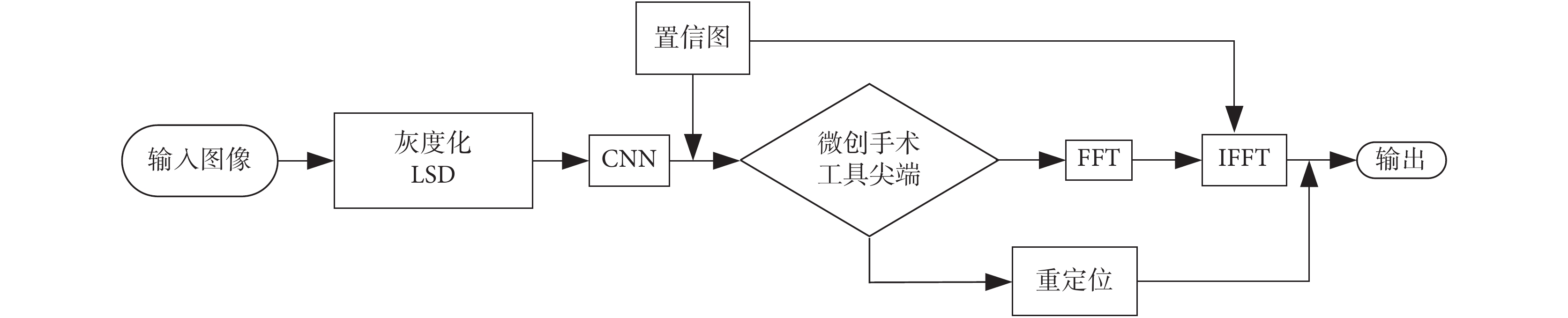

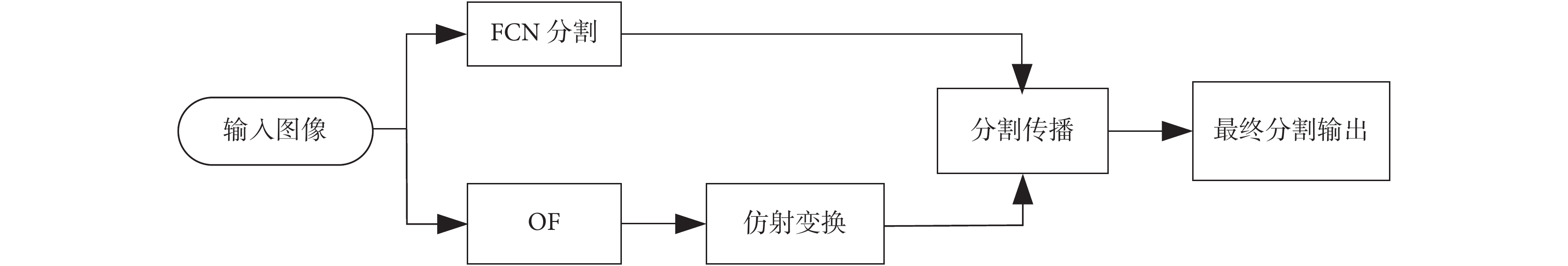

2.1.3 全卷積網絡結合光流跟蹤

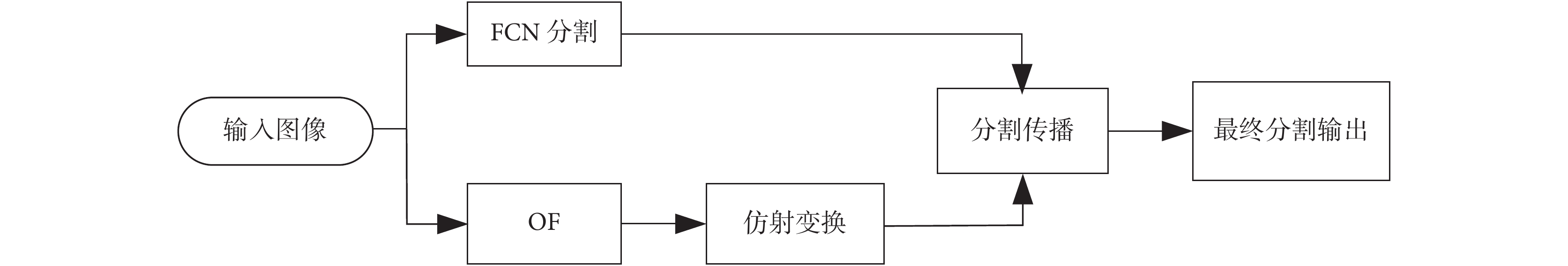

全卷積網絡(fully convolutional networks, FCN)被提出之后,García-Peraza-Herrera 等[10]基于 FCN 進行改進,提出了一種 FCN 結合光流(optical flow,OF)跟蹤的微創手術工具檢測與跟蹤算法。該方法先利用微調的 FCN 驗證 FCN 解決微創手術工具檢測與跟蹤問題的可行性,結果證明微調的 FCN 雖然達不到實時的要求,但是精度最高達到了 83.7%,所以該課題組繼續研究利用 OF 跟蹤加快速度。FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法最終達到了在精度為 88.3% 時,速度為 30 幀/s,比較適合用于較慢的 MIS 視頻數據集。如圖3 所示為 FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法流程圖。

圖3

FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法

Figure3.

FCN combined with OF tracking for minimally invasive surgical tool detection and tracking algorithm

圖3

FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法

Figure3.

FCN combined with OF tracking for minimally invasive surgical tool detection and tracking algorithm

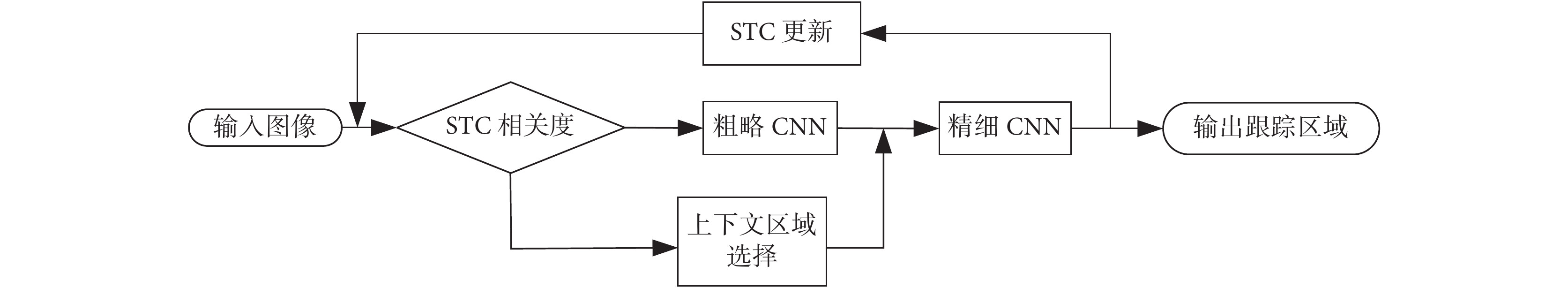

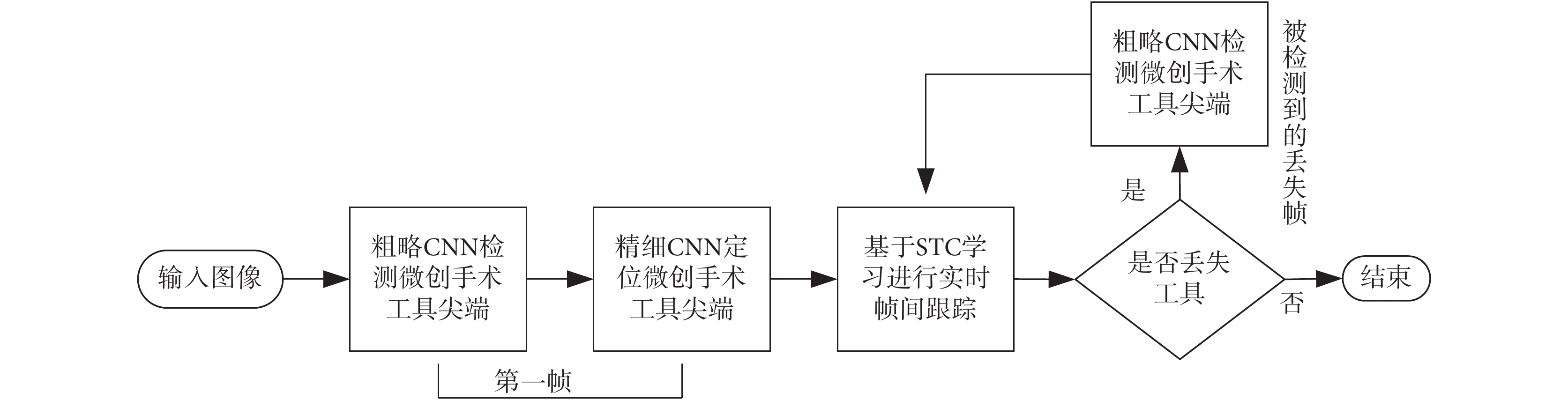

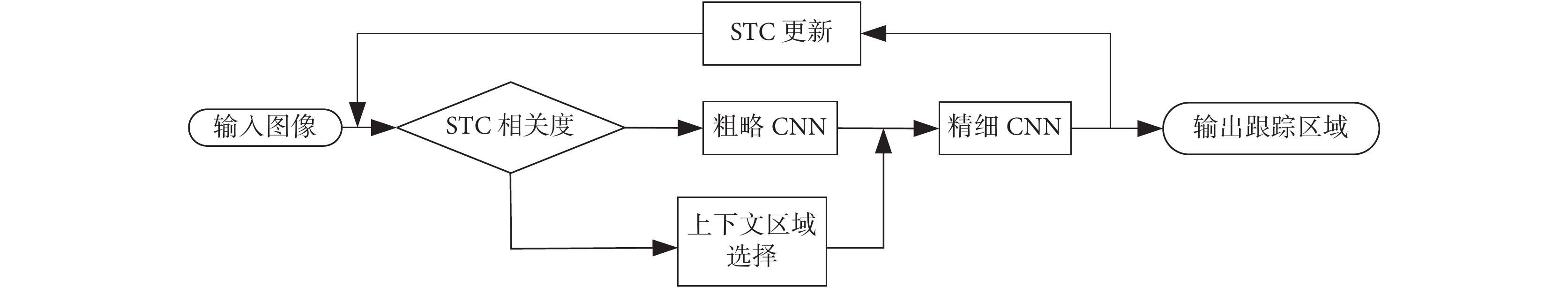

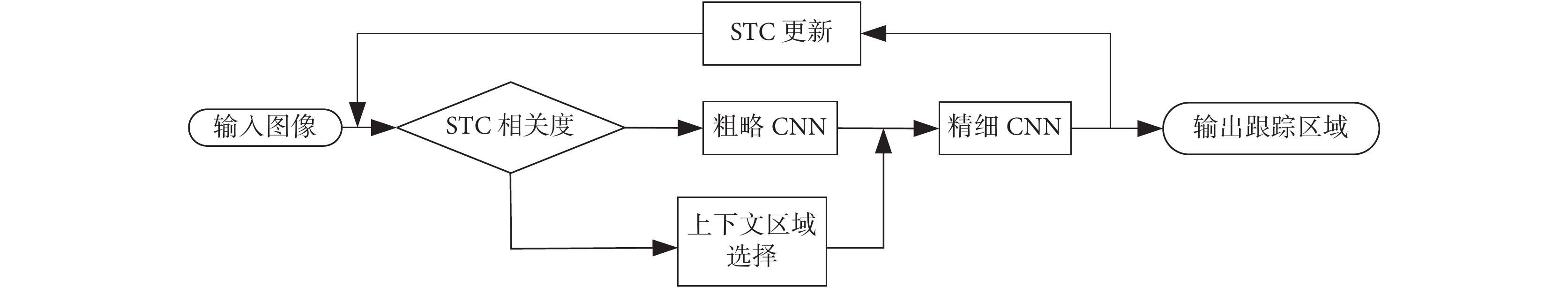

2.2 基于從粗略到精細級聯卷積神經網絡的算法

Zhao 等[11]提出了一種基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法,該文獻中設計了兩個級聯的 CNN 用于微創手術工具的粗略定位和精細定位。粗略 CNN 是一個分類網絡,精細 CNN 是微創手術工具尖端區域的回歸網絡,通過更新 STC 使得兩個 CNN 協同工作以用于微創手術工具的檢測與跟蹤。基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法在冒煙、遮擋等 MIS 場景中都得到了不錯的效果,比較適用于復雜的 MIS 場景,但是其速度還有待于提高。如圖4 所示是基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法流程圖。

圖4

基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法

Figure4.

Minimally invasive surgical tool detection and tracking algorithm based on coarse to fine cascade CNN

圖4

基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法

Figure4.

Minimally invasive surgical tool detection and tracking algorithm based on coarse to fine cascade CNN

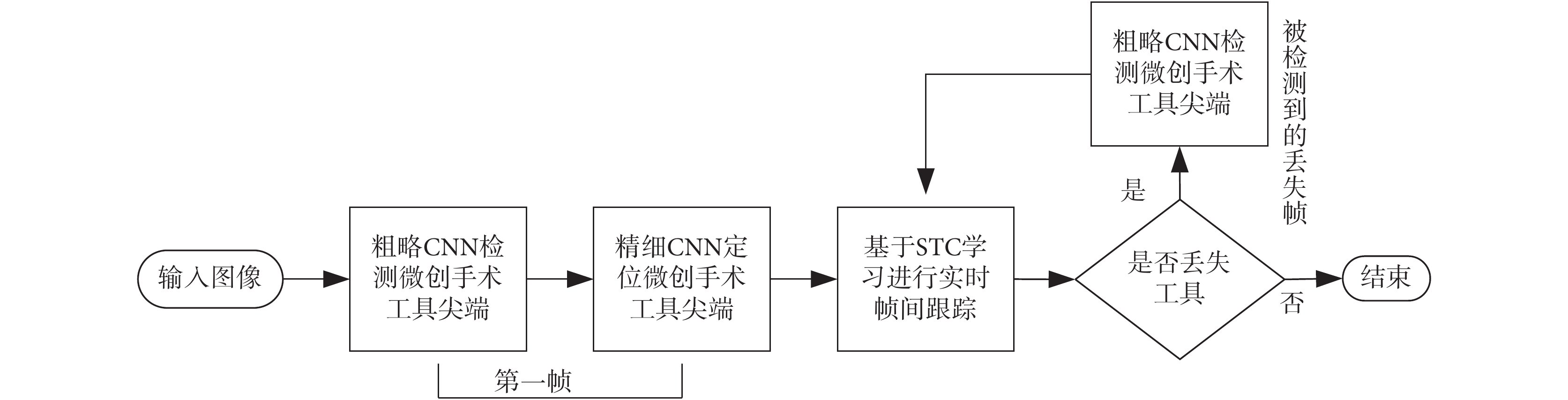

Zhao 等[12]基于 AlexNet、視覺幾何組(visual geometry group,VGG)網絡和谷歌網(GoogLeNet)提出的從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法帶有一個空間轉換網絡(spatial transformer network,STN),可用于精確定位微創手術工具的位置,該算法比較適用于對精度要求高且場景比較復雜的 MIS,如圖5 所示是該算法的流程圖。由于先經過一個粗略 CNN,再經過一個精細 CNN 的思路可以加快檢測微創手術工具尖端的速度,縮小精細 CNN 的檢測范圍,所以研究者們在搭建網絡結構時可以使用這個思路加快對微創手術工具尖端位置的檢測。

圖5

基于從粗略 CNN 到精細 STN 級聯的微創手術工具檢測與跟蹤算法

Figure5.

Minimally invasive surgical tool detection and tracking algorithm based on coarse CNN to fine STN cascade

圖5

基于從粗略 CNN 到精細 STN 級聯的微創手術工具檢測與跟蹤算法

Figure5.

Minimally invasive surgical tool detection and tracking algorithm based on coarse CNN to fine STN cascade

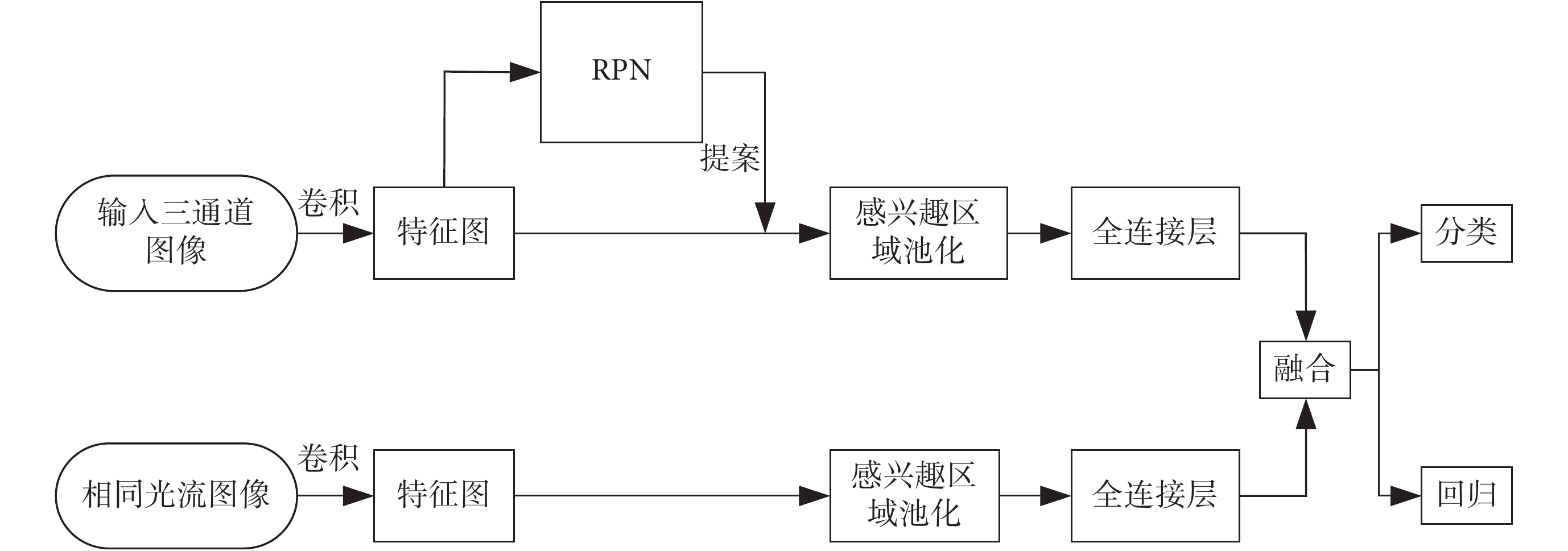

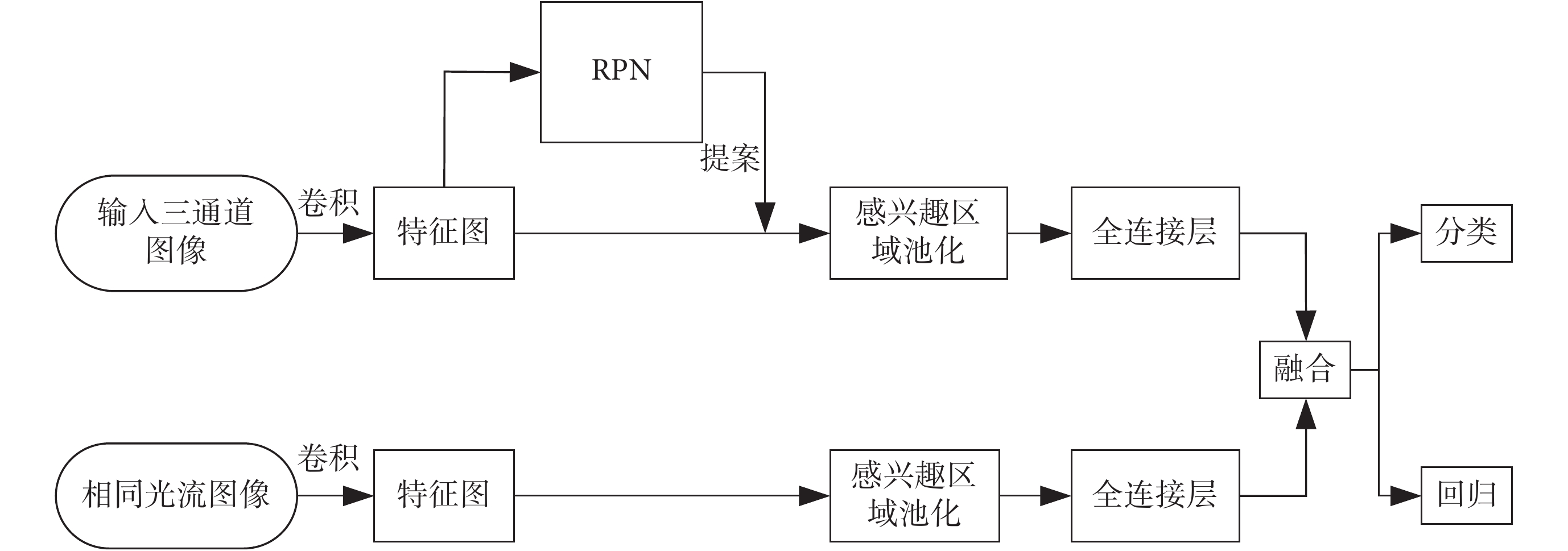

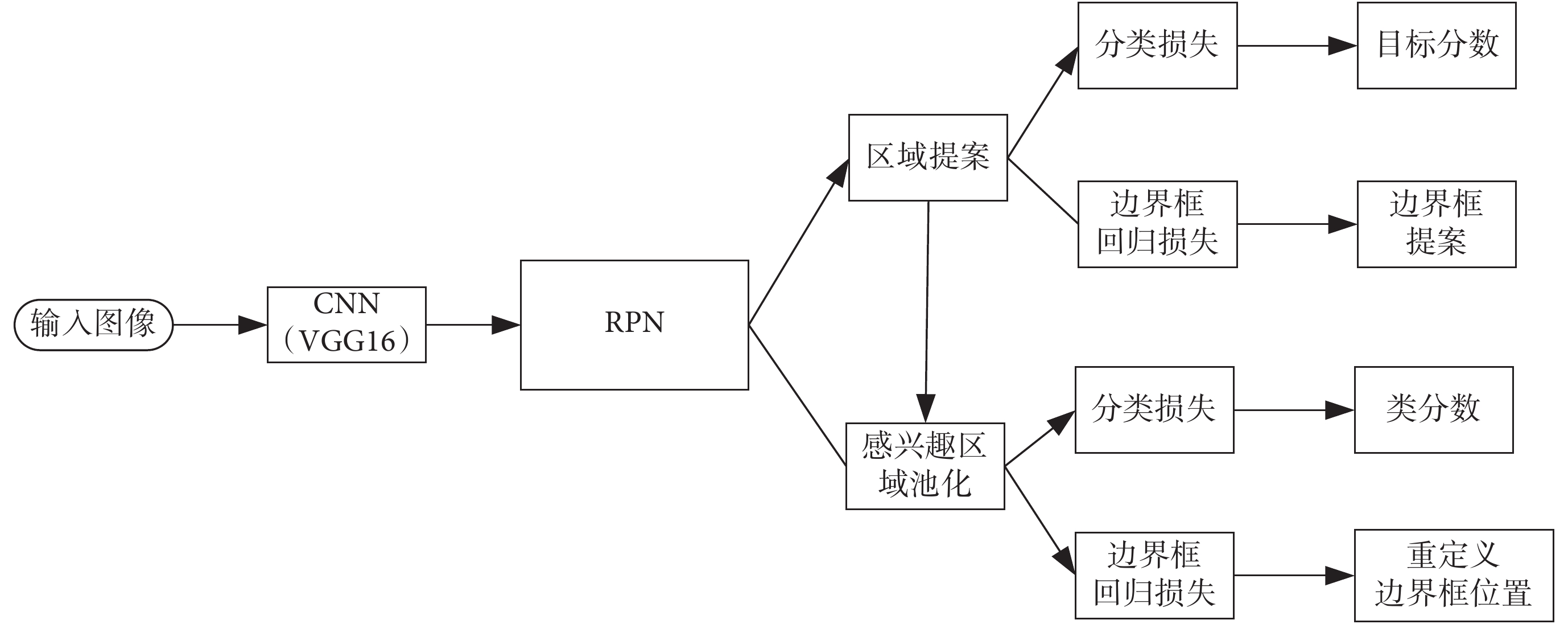

2.3 基于區域提案的兩階段卷積神經網絡算法

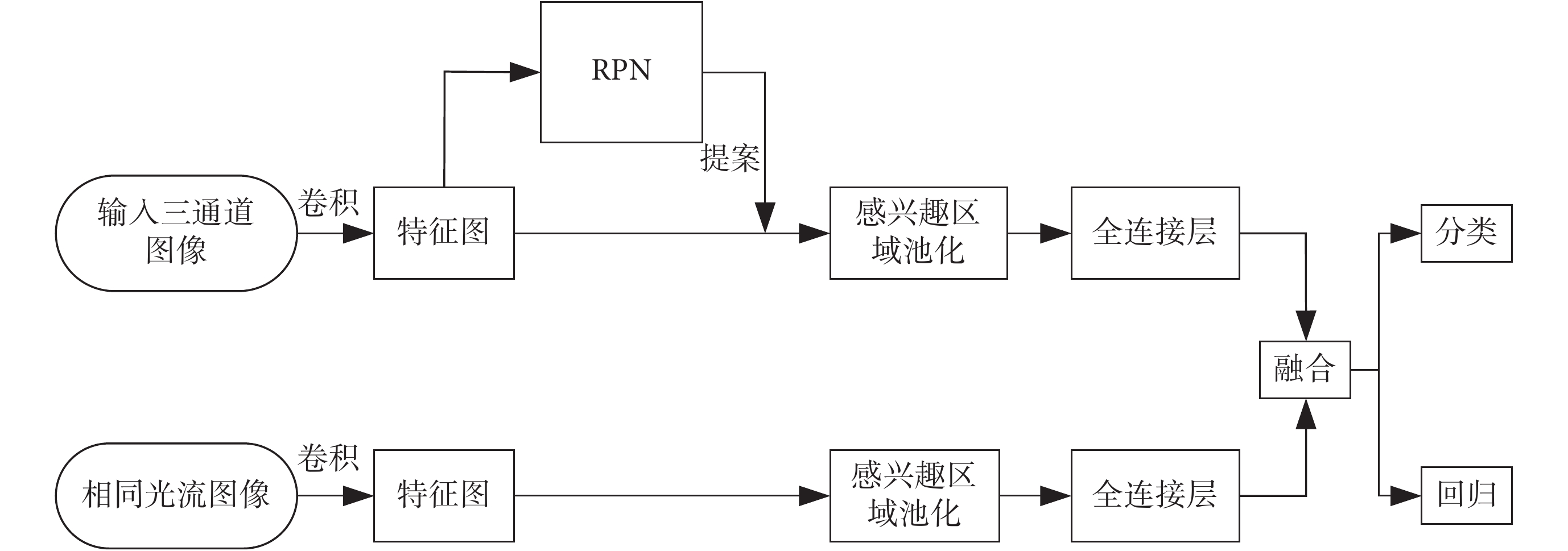

2017 年 Sarikaya 等[13]提出了一種通過改進更快的區域卷積神經網絡(faster regions with convolutional neural network,Faster R-CNN)完成微創手術工具檢測與跟蹤的算法,該算法利用區域提議網絡(regional proposal network,RPN)和多模式雙流 CNN,以融合預測圖像和時間運動線索進而對微創手術工具檢測與跟蹤。Faster R-CNN 是典型的兩階段 CNN,雖然比一階段的 CNN 精度較高,但是比較費時,遠遠達不到實時的標準,改進 Faster R-CNN 后實驗結果的平均精度為 91%,速度為 10 幀/s。值得一提的是 Sarikaya 等[13]提供了來自美國紐約州布法羅羅斯威爾帕克癌癥研究所(Roswell Park Cancer Institute,RPCI)的 10 名外科醫生在達芬奇外科系統 (dVSS) 上執行 6 種不同任務的 MIS 視頻,視頻中的每幀配有微創手術工具的注釋,這代表著該數據集可以直接使用不用額外處理,為研究者們帶來了極大的便利。如圖6 所示為基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法流程圖。

圖6

基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法

Figure6.

Detection and tracking algorithm of multi-mode dual-stream minimally invasive surgery tool based on Faster R-CNN

圖6

基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法

Figure6.

Detection and tracking algorithm of multi-mode dual-stream minimally invasive surgery tool based on Faster R-CNN

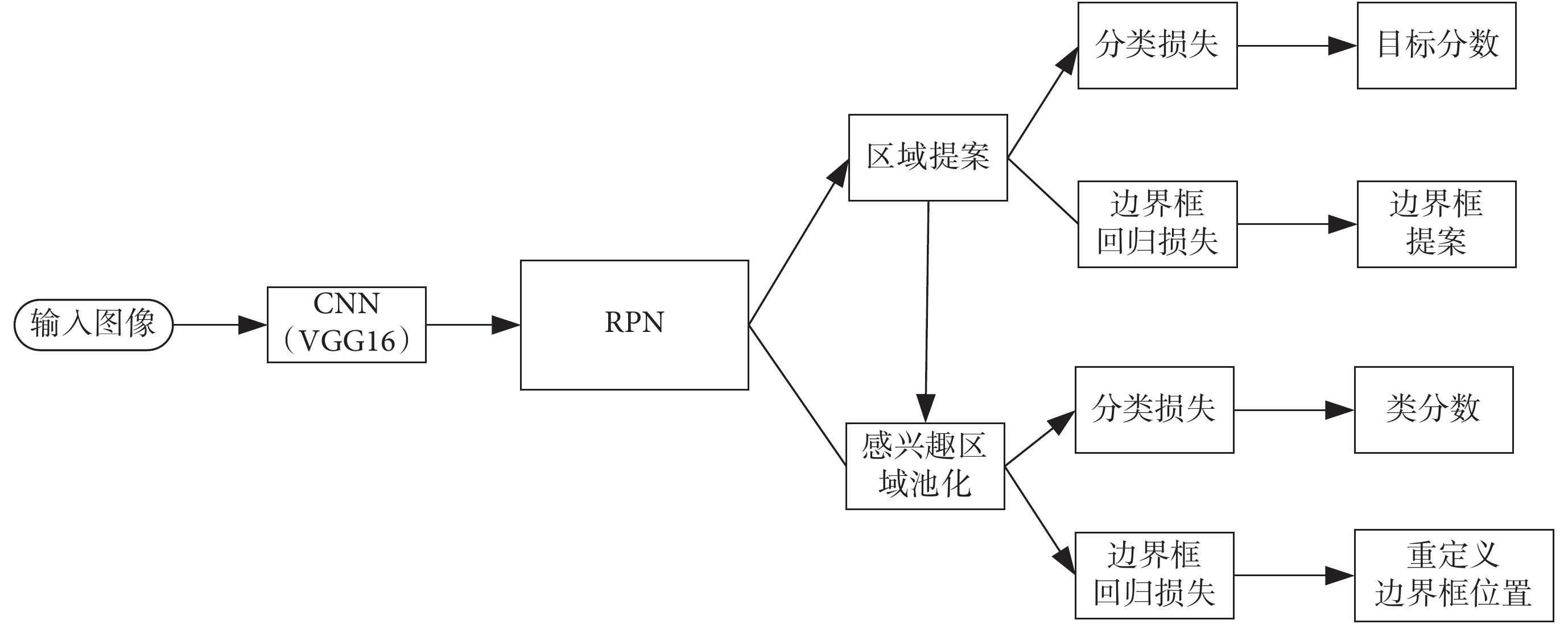

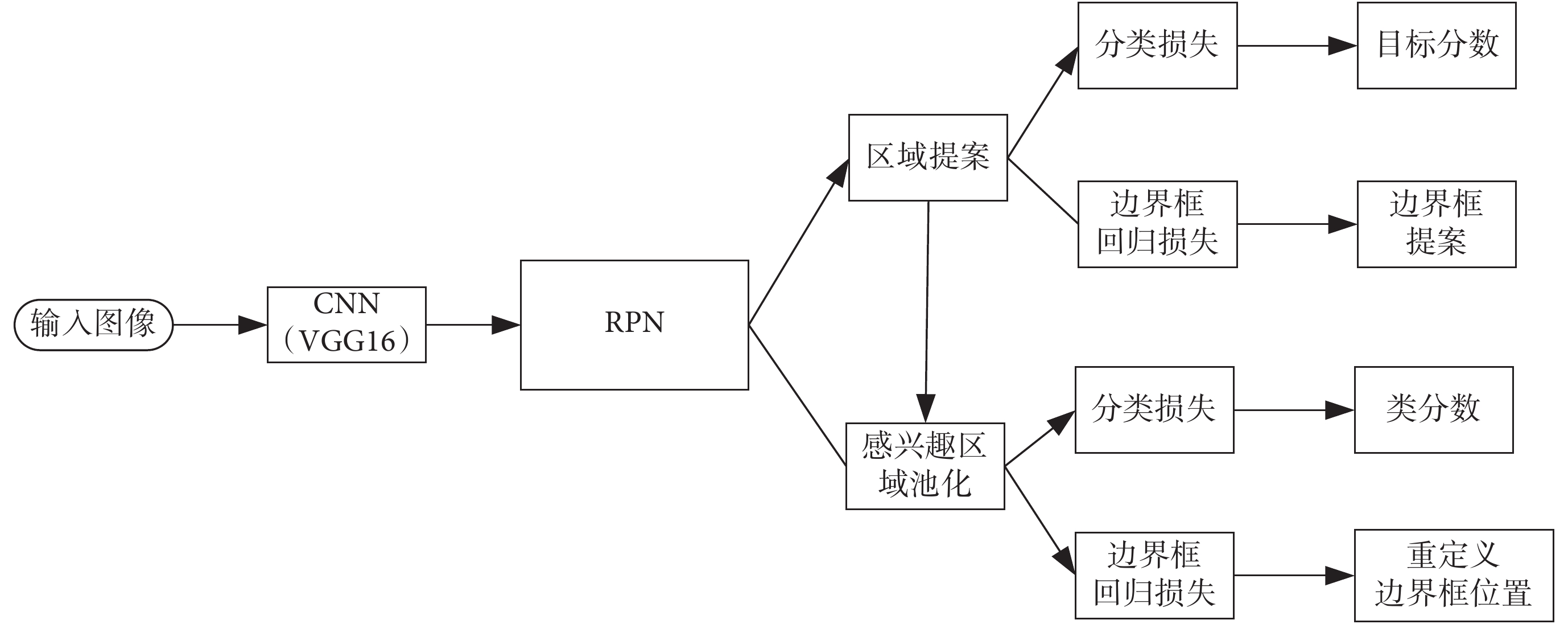

2018 年 Jin 等[14]提出的微創手術工具檢測與跟蹤算法也是基于 Faster R-CNN 的兩階段框架,是端到端的訓練,即輸入視頻幀,直接輸出 MIS 中所用 7 個微創手術工具周圍邊界框的空間坐標,具體的流程圖如圖 7 所示。結果表明,基于 Faster R-CNN 的微創手術工具檢測與跟蹤算法雖然精度只提升到了 81.8%,速度也只有 5 幀/s,但是 Jin 等[14]創造性地提出了一個 MIS 效果評估模塊,可以用微創手術工具的時間軌跡和運動軌跡以自動評價 MIS 效果,而且該算法還在檢測微創手術工具存在任務中超越了 EndoNet 算法。

圖7

基于 Faster R-CNN 的微創手術工具檢測跟蹤算法

Figure7.

Minimally invasive surgery tool detection and tracking algorithm based on Faster R-CNN

圖7

基于 Faster R-CNN 的微創手術工具檢測跟蹤算法

Figure7.

Minimally invasive surgery tool detection and tracking algorithm based on Faster R-CNN

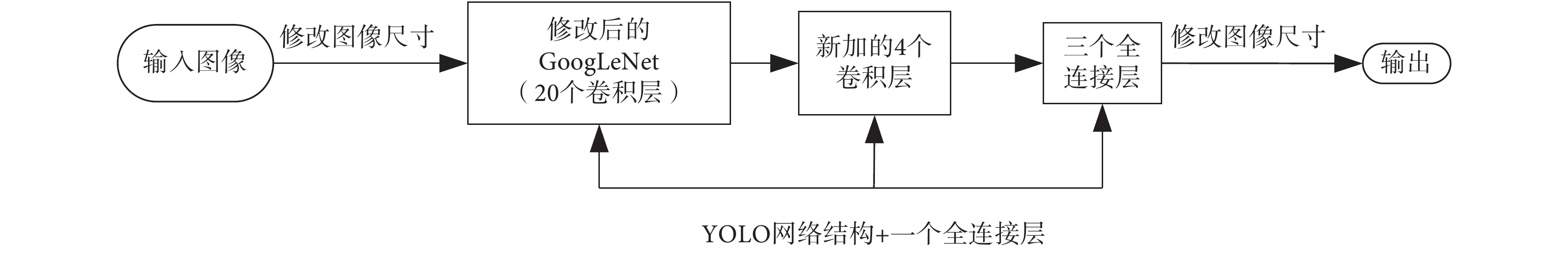

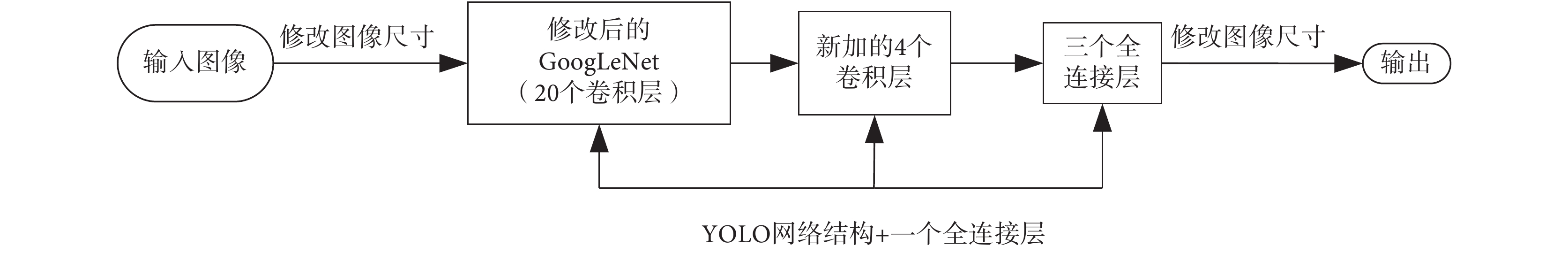

2.4 基于回歸的一階段卷積神經網絡算法

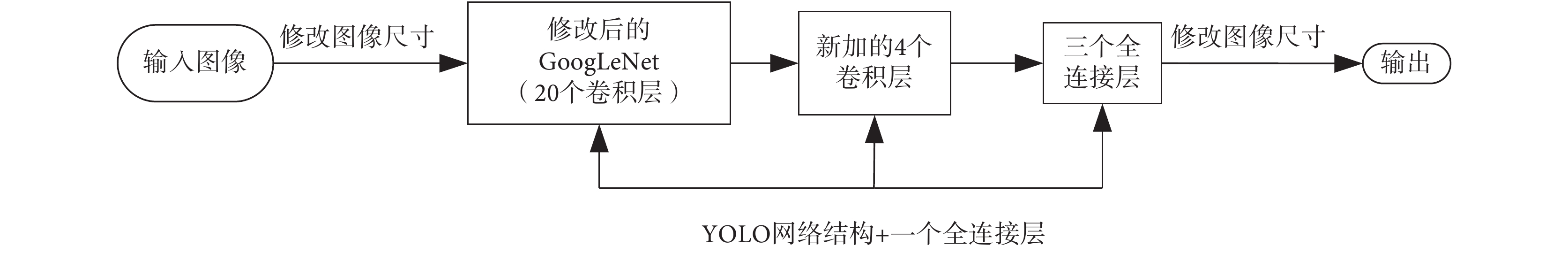

上述基于區域提案的兩階段 CNN 算法,雖然其準確度較高,但是遠達不到實時的要求,所以 Choi 等[15]提出了基于回歸的一階段 CNN 算法實現微創手術工具檢測與跟蹤任務。2017 年 Choi 等[15]在 Redmon 等[16]提出的你只能看一眼(you only look once,YOLO)網絡結構的最后一層添加一個全連接層,通過下采樣減少參數的數量,將檢測與跟蹤看成一個簡單的回歸問題,設計了一種能夠實時檢測與跟蹤微創手術工具的 CNN 算法。在添加的全連接層中使用了丟棄(dropout),該層將來自前一層的所有輸出值連接到神經網絡,以防止訓練數據過度擬合。基于回歸的一階段 CNN 算法的實驗結果雖然平均精度為 72.26%,容易錯檢誤檢小型微創手術工具,但是微創手術工具的檢測速度為 48.9 幀/s,增強了一階段 CNN 效率方面的優勢,實時性較高,適用于較大型的微創手術工具檢測與跟蹤。如圖8 所示是改進后的 YOLO 網絡結構。

圖8

改進后的 YOLO 網絡結構

Figure8.

Improved YOLO network structure

圖8

改進后的 YOLO 網絡結構

Figure8.

Improved YOLO network structure

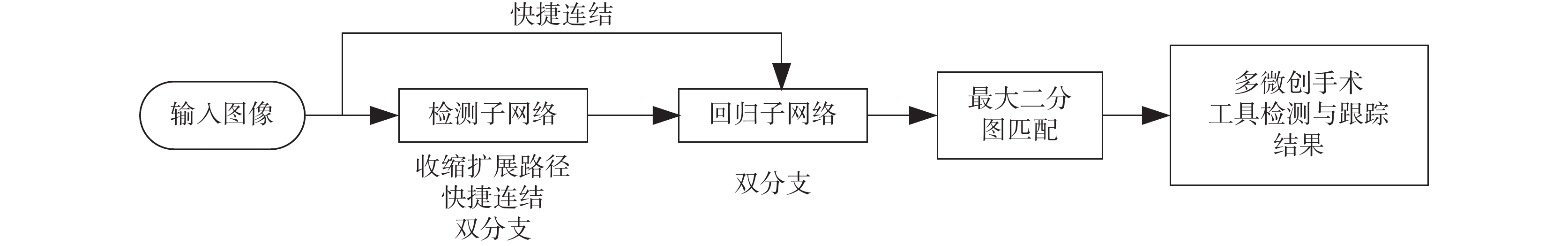

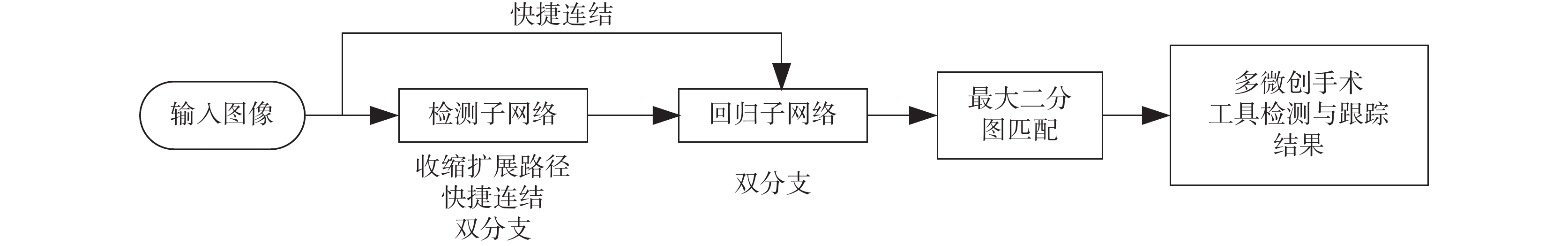

2.5 基于先收縮后擴展路徑的卷積神經網絡算法

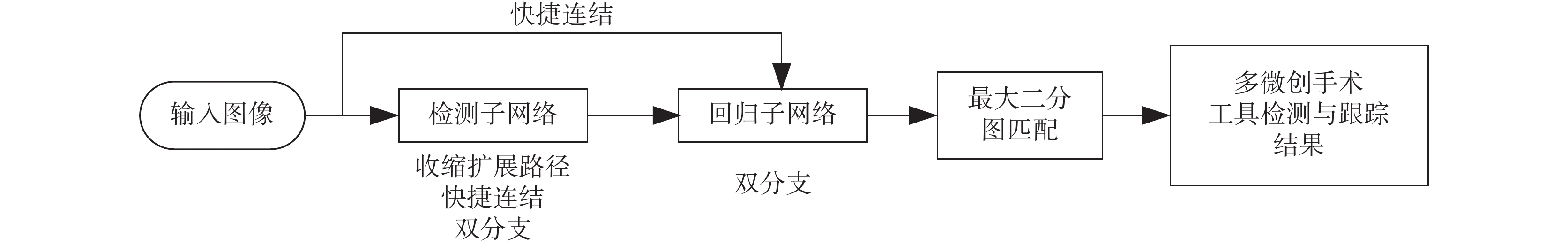

Kurmann 等[17]受 U 型網絡(U-Net)啟發提出了一種新穎的基于先收縮后擴展(shrink before expand,SBE)路徑的 CNN 算法,該算法的網絡結構共用 5 個下采樣(特征數加倍)和 5 個上采樣(特征數減半)階段,每個階段有卷積層、激活層和采樣層,最后用全連接層擴展最底層,該算法在測試時不需要滑動窗口從而減少了計算量,而且可以同時檢測與跟蹤多個微創手術工具。2019 年 Gao 等[18] 提出的算法與 Kurmann 等[17]提出的算法類似,而 Du 等[19]受 Twinanda 等[4]和 U-Net 的啟發提出了一種更好的基于 SBE 路徑和雙分支 CNN 的算法,該算法的網絡結構由 FCN 檢測和回歸網絡構成,還融合殘差網絡快捷連結優化輸出精度,由深度學習技術提供動力,沒有來自機器人的任何直接運動學信息。基于 SBE 路徑和雙分支 CNN 算法的實驗結果表明精度在 90% 以上,對新型微創手術工具檢測與跟蹤具有一定的通用性,在煙霧模擬下具有較好的魯棒性,具有處理真實 MIS 場景的能力,不足之處是處理速度沒有達到實時的標準。如圖9 所示是基于 SBE 路徑和雙分支 CNN 算法的流程圖。

圖9

基于 SBE 路徑和雙分支 CNN 的微創手術工具檢測與跟蹤算法

Figure9.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and dual-branch CNN

圖9

基于 SBE 路徑和雙分支 CNN 的微創手術工具檢測與跟蹤算法

Figure9.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and dual-branch CNN

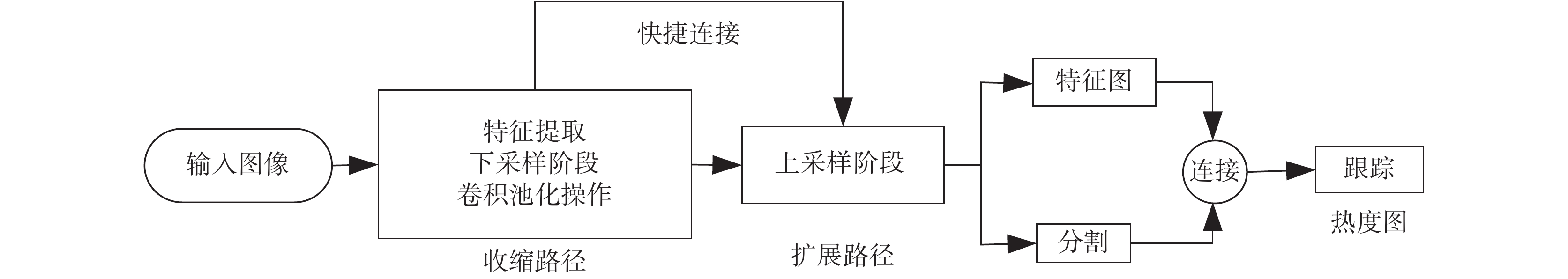

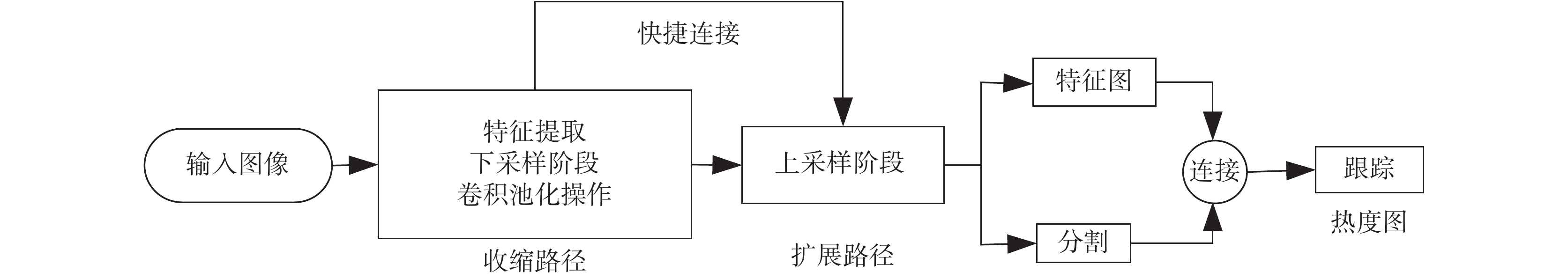

Laina 等[20]提出了利用 SBE 路徑的新算法,通過利用微創手術工具分割和定位之間的相互依賴性,將微創手術工具二維(two dimensional,2D)姿勢估計重新建模表示為熱度圖回歸問題,進而通過深度學習實現分割任務和定位任務同時魯棒回歸,完成微創手術工具檢測與跟蹤任務。通過實驗證明,重新建模熱度圖回歸問題比直接回歸微創手術工具的位置更具優勢。基于 SBE 路徑的 CNN 結構由 He 等[21]提出的完全卷積殘差網絡改進而來,對微創手術工具的分割輸出和定位輸出進行連接后直接端到端訓練,僅依賴于上下文信息而無需任何后處理技術,該方法精度達到了 92.6%,每幀處理速度為 56 ms,實現了精度高、速度較快。如圖10 所示是基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法流程圖。

圖10

基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法

Figure10.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and CNN

圖10

基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法

Figure10.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and CNN

2.6 基于卷積神經網絡結合遞歸神經網絡的算法

由于 MIS 過程是按時間順序展開的,所以 2017 年 Mishra 等[22]提出了一種較為創新的算法用于微創手術工具檢測與跟蹤任務的檢測部分,該算法使用殘差網絡(ResNet)從微創手術工具圖像中提取高度視覺特征,并利用長短期記憶(long short-term memory,LSTM)網絡來編碼時間信息,以捕獲 ResNet-50 所提取出的高度視覺特征時間連接性,達到提高預測準確性的目的。LSTM 是遞歸神經網絡(recurrent neural network,RNN)中應用最廣泛的神經網絡。該 CNN 結合 LSTM 的算法獲得了 88.75%的平均準確度,每幀處理速度為 2.45 ms,適用于對精度要求不高,但對實時性要求較高的 MIS。值得特別指出的是,Mishra 等[22]在文獻中不但為后續研究者提供了 CNN 結合 LSTM 的研究思路,還公布了可供參考的開源代碼。

CNN 結合 RNN 算法的計算復雜性阻止了其結構端到端訓練,某一步驟結果的好壞會影響到下一步驟,從而影響整個訓練的結果,但是好在許多微創手術工具彼此非常相似,通常可以根據之前時刻的事件進行區分,所以應結合時間背景訓練 CNN 以提取最有用的視覺特征。Hajj 等[23]提出了一種新的增強策略,即通過逐步增加訓練好的弱分類器來同時豐富系統的 CNN 和 RNN 部分,提高微創手術工具檢測與跟蹤算法的平均精度,其中精度最高可達 97.89%。該研究在實驗部分用 18 種 CNN 對 28 種微創手術工具檢測與跟蹤結果進行對比評價,以供后續研究者們參考。

3 基于弱監督的深度神經網絡微創手術工具檢測與跟蹤算法

前面綜述的所有算法都是基于完全監督的深度神經網絡微創手術工具檢測與跟蹤算法,但是完全監督模型要求在訓練時使用空間信息完全標注的數據,目前可供微創手術工具檢測與跟蹤領域作為訓練數據集及測試數據集的標準數據庫十分稀少。除了之前所提 Cholec80 數據集和 2016 年計算機輔助干預的建模和監測會議挑戰發布的公開數據集(m2cai16-tool)(網址:http://camma.u-strasbg.fr/m2cai2016/index.php/tool-presence-detection-challenge-results/) 可以直接用以訓練外,其他數據集都需要人工完全標注數據,且可能存在標注人員不專業或浪費人力等問題。完全監督模型限制了可用數據集的大小和微創手術工具檢測與跟蹤算法的泛化,于是研究者們為了避免完全監督中需人工完全標注數據的弊端,嘗試了弱監督模型,弱監督模型在訓練時僅需要對圖像級別標注數據進行訓練,不需要任何空間標注,這為缺少完全標注數據集的微創手術工具檢測與跟蹤領域的發展帶來了新契機。目前弱監督也被應用于醫學圖像中癌癥區域的檢測等任務[24-25],但遺憾的是相比較于完全監督模型,弱監督模型出現的時間較晚,與之的相關的參考文獻還較少,發展不夠成熟,而且還達不到實時性的要求。

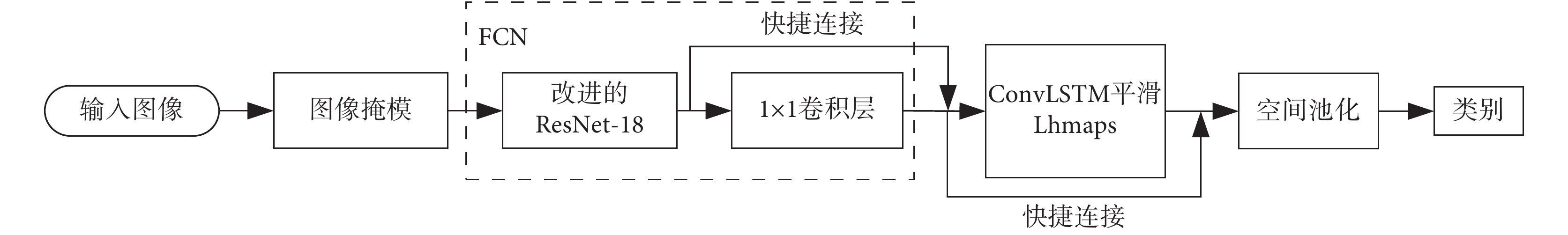

基于弱監督的目標檢測文獻[26-27],Vardazaryan 等[28]構建出一種 FCN 結構,該網絡結構是改進的 ResNet-18,刪除了完全連接的層以保留空間信息并允許研究者們在沒有明確空間標注的數據集下對微創手術工具檢測與跟蹤,而且是端到端的訓練,即上一步驟的誤差不會影響下一步驟,測試結果平均精度為 88.8%。

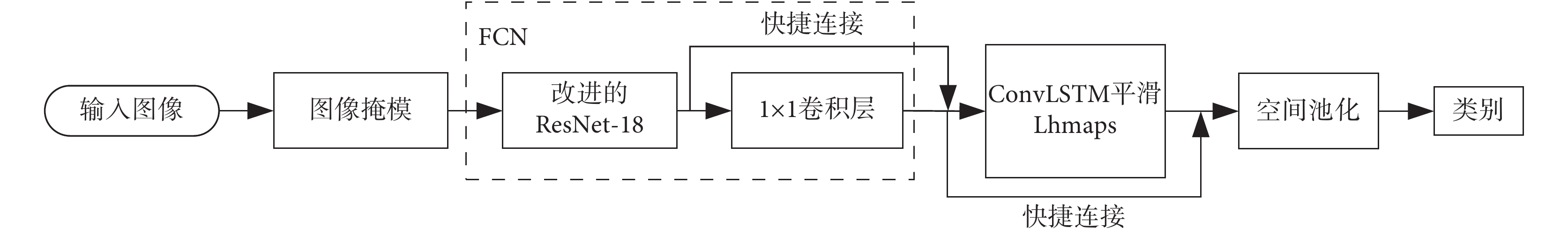

Nwoye 等[29]提出了一種用于微創手術工具檢測與跟蹤的弱監督 CNN 結合卷積長短時記憶(ConvLSTM)網絡算法,該算法僅在微創手術工具二進制存在標簽上進行弱監督,再使用 ConvLSTM 網絡來模擬微創手術工具運動中的時間依賴性,并利用 ConvLSTM 網絡的時空性能來平滑定位熱度圖(Lhmaps)中的類峰值激活。基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法提出了 ConvLSTM 網絡的思路,測試結果平均精度提升到 92.9%,適用于對精度要求較高的 MIS,也證明了基于弱監督的深度神經網絡足以用于基于深度學習的微創手術工具檢測與跟蹤算法,該算法流程圖如圖11 所示。

圖11

基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法

Figure11.

Weakly supervised CNN combined with ConvLSTM for minimally invasive surgical tool detection and tracking algorithm

圖11

基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法

Figure11.

Weakly supervised CNN combined with ConvLSTM for minimally invasive surgical tool detection and tracking algorithm

4 總結及展望

本綜述主要總結了多種基于深度學習的微創手術工具檢測與跟蹤算法,目前基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法在 MIS 中應用比較成熟,精度較高且速度較快;基于 CNN 結合 RNN 算法在精度方面還有很大的提升空間,需要研究者們繼續探索;解決數據集完全標注問題的基于弱監督的深度神經網絡微創手術工具檢測與跟蹤算法是比較新的研究方向,精度比較高,但是達不到實時性的要求。如圖12 所示為基于深度學習的微創手術工具檢測與跟蹤算法總結圖。本綜述比較分析了多種微創手術工具檢測與跟蹤算法的測試結果、適用范圍及優缺點,以便相關領域的科研工作者更系統地了解目前研究進展,同時可為微創外科手術醫生選擇合適的導航技術提供參考。

圖12

基于深度學習的微創手術工具檢測與跟蹤算法總結

Figure12.

Summary of detection and tracking algorithm for minimally invasive surgical tool based on deep learning

圖12

基于深度學習的微創手術工具檢測與跟蹤算法總結

Figure12.

Summary of detection and tracking algorithm for minimally invasive surgical tool based on deep learning

目前已有的基于深度學習的微創手術工具檢測與跟蹤算法還需在準確度和實時性方面實現整體提升,因此未來的微創手術工具檢測與跟蹤算法或將有以下發展方向:

(1)有效融合特征。有效的特征是解決微創手術工具檢測與跟蹤問題的基礎,所以可將多種深度學習特征融合到所有網絡結構中,使測試結果更加準確。

(2)實現長時間跟蹤。設計一個更好的目標模型更新,重新找到所需跟蹤的微創手術工具或找到合適的神經網絡相互結合,解決在微創手術工具跟蹤過程中目標丟失的問題。

(3)由完全監督向弱監督甚至無監督深度學習發展。如何借助生成對抗網絡、自編碼器等實現無監督模型以增強實時性,或將是微創手術工具檢測與跟蹤領域研究的難點和重點。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

引言

微創外科手術(minimally invasive surgeries, MIS)與傳統外科手術相比具有許多優勢,例如:創傷小、疼痛少、術后恢復時間短等,現已成為通用的外科手術選擇[1]。但 MIS 采用間接觀察和操縱的方式,使得深度感知復雜化、手術視野和操作空間狹窄,降低了醫生的手眼協調,因而可能會在實際操作中對器官或組織造成損傷,所以需要以其他手段獲取額外信息來監測在體內移動的手術工具,而微創手術工具檢測與跟蹤算法就可以為 MIS 中的操作導航提供這樣的重要信息。微創手術工具的檢測與跟蹤算法可以確定微創手術工具的位置和空間姿態,為執行手術的臨床醫生或機器人提供精確實時的導航,使手術過程更順利安全。

微創手術工具檢測與跟蹤,有基于硬件和基于視覺的兩種解決方式,但由于基于視覺的解決方式,既簡單又不需要額外的設備,現已成為目前主要的研究方向。通過系統軟件,基于視覺的解決方式可以直接對圖像中的手術工具進行某些特征提取,即可檢測與跟蹤微創手術工具在圖像中的位置,從而為微創手術工具操縱提供導航。

值得一提的是,現在微創手術工具檢測與跟蹤技術日趨發展成熟,既有從傳統的自行設計特征、分類器,發展到現在的基于深度學習的端到端(end to end)算法;也有基于深度學習的從先檢測后跟蹤,發展到檢測與跟蹤融為一體的算法。本文主要介紹了基于完全監督深度學習神經網絡和基于弱監督深度學習神經網絡的微創手術工具檢測與跟蹤算法,以便相關領域的科研工作者更系統地了解目前研究進展,同時為微創外科手術醫生選擇合適的導航技術提供參考。最后,本文為基于深度學習的微創手術工具檢測與跟蹤技術的進一步研究提供了一個大致的方向。

1 深度學習理論

目前微創手術工具檢測與跟蹤算法可以被劃分為生成式(generative model)模型和判別式(discriminative model)模型兩大類別[2]。生成式模型主要有基于特征匹配的方法、基于貝葉斯跟蹤的方法以及運動檢測的方法等[3-4]。判別式模型則采用模式分類方法,例如:支持向量機(support vector machine,SVM)、隨機森林、大部分基于深度學習的方法等[4-5]。判別式模型因為能夠明顯地區分背景和前景的信息,逐漸在微創手術工具檢測與跟蹤領域占據主流地位。

上文所提到的生成式模型中所有的方法和判別式模型中的 SVM 及隨機森林方法通常有較多的局限,比如:需要手工設計特征,不精確且耗費人力;難以構建高級的語義信息;無法應用于復雜場景等。但是基于深度學習的模型以人工神經網絡為架構對數據進行表征學習,具有學習能力強、特征表達能力高效、語義特征更高級的特點,所以從 2013 年以來研究者們普遍關注怎樣解決基于深度學習的微創手術工具檢測與跟蹤問題[6]。

解決基于深度學習的微創手術工具檢測與跟蹤問題與解決基于深度學習的車輛檢測與跟蹤問題不同,前者存在目標更容易丟失、數據集更少、場景更加復雜等難題。同時微創手術工具的數據集也會因為遮擋、鏡面反射、手術場景中出血或煙霧導致信息丟失,進而影響微創手術工具檢測與跟蹤的測試效果[2]。多年來研究者們直面難題,搭建全新的深度神經網絡,或者將用于解決各種醫學圖像分割或識別問題中的深度神經網絡進一步拓展應用在基于深度學習的微創手術工具檢測與跟蹤任務中[7]。研究者們的努力使得基于深度學習的微創手術工具檢測與跟蹤技術不斷發展,至今已有多種基于深度學習的微創手術工具檢測與跟蹤算法被應用于 MIS 中。

現在基于深度學習的微創手術工具檢測與跟蹤算法中有兩種主流深度神經網絡模型:完全監督深度神經網絡模型和弱監督深度神經網絡模型。下面介紹近年來基于深度學習的微創手術工具檢測與跟蹤算法中測試效果較好的基于完全監督深度神經網絡和基于弱監督深度神經網絡的微創手術工具檢測與跟蹤算法。

2 基于完全監督深度神經網絡的微創手術工具檢測與跟蹤算法

2.1 以卷積神經網絡為骨干的經典算法

2.1.1 卷積神經網絡結合線段檢測

神經網絡的層數并不是越深越好,過深的神經網絡會帶來一系列的問題,比如圖像細節信息丟失、更新困難、定位更加復雜等。適當深度的神經網絡層數結合經典算法取得的效果或許更佳,例如 Chen 等[8]提出了一種卷積神經網絡(convolutional neural network,CNN)結合傳統線段檢測(line segment detection,LSD)的微創手術工具檢測與跟蹤算法。該研究使用了 CNN 檢測和時空上下文(spatio-temporal context,STC)學習跟蹤算法,在視頻幀之間進行微創手術工具的檢測與跟蹤。在檢測之前,先用 LSD 來檢測微創手術工具外觀的線段并標記它們,然后使用有標記的圖像作為數據集來訓練 CNN,這些線段的位置有助于快速準確地檢測微創手術工具的尖端。最后使用 STC 學習算法逐幀跟蹤微創手術工具,STC 關鍵點在于有效利用快速傅里葉變換(fast fourier transform,FFT)和逆快速傅里葉變換(inverse fast fourier transform,IFFT)。實驗結果表明,在微創手術工具檢測與跟蹤任務中,Chen 等[8]提出的方法具有先進的二維跟蹤性能,準確率為 93.2%,處理速度達到了 25 幀/s,故而該方法適合用于對實時性要求不是很高,但是對準確率要求較高的 MIS 中。如圖1 所示是其微創手術工具檢測與跟蹤算法流程圖。

圖1

CNN 結合 LSD 的微創手術工具檢測與跟蹤算法

Figure1.

CNN combined with LSD for minimally invasive surgical tool detection and tracking algorithm

圖1

CNN 結合 LSD 的微創手術工具檢測與跟蹤算法

Figure1.

CNN combined with LSD for minimally invasive surgical tool detection and tracking algorithm

2.1.2 卷積神經網絡結合支持向量機以及隱馬爾科夫模型

2017 年,Sahu 等[9]提出了用改進亞歷克斯網絡(AlexNet)結合隨機森林實現微創手術工具的檢測,Twinanda 等[4]則提出了將 AlexNet 改進用于解決微創手術工具檢測與跟蹤問題。Twinanda 等[4]所提出算法的流程如圖2 所示:輸入訓練圖像后首先通過微調過程訓練內網絡(EndoNet),EndoNet 就是 AlexNet 的擴展。在 EndoNet 被訓練之后,用于微創手術工具檢測與跟蹤任務。對于微創手術工具的存在檢測,EndoNet 給出的置信度直接用于執行任務;對于微創手術工具的跟蹤,EndoNet 用于從圖像中提取微創手術工具的視覺特征,然后將這些特征傳遞給 SVM 和分層隱馬爾科夫模型(hidden markov model,HMM)以完成微創手術工具檢測與跟蹤。雖然 Twinanda 等[4]給出的測試結果中顯示無法達到當前實時的標準(大于 20 幀/s),但 Twinanda 等[4]和斯特拉斯堡大學醫院(University Hospital of Strasbourg,HUS)建立了膽囊切除術數據集(Cholec80 Dataset)(網址為:http://camma.u-strasbg.fr/datasets),Cholec80 數據集包含了 13 名外科醫生進行的 80 個膽囊切除手術的視頻。因為在基于深度學習的微創手術檢測與跟蹤領域,可用于訓練的數據集非常稀少,所以 Twinanda 等[4]為研究者們的研究帶來了極大的便利。

圖2

CNN 結合 SVM 以及 HMM 的微創手術工具檢測與跟蹤算法

Figure2.

CNN combined with SVM and HMM for minimally invasive surgical tool detection and tracking algorithm

圖2

CNN 結合 SVM 以及 HMM 的微創手術工具檢測與跟蹤算法

Figure2.

CNN combined with SVM and HMM for minimally invasive surgical tool detection and tracking algorithm

2.1.3 全卷積網絡結合光流跟蹤

全卷積網絡(fully convolutional networks, FCN)被提出之后,García-Peraza-Herrera 等[10]基于 FCN 進行改進,提出了一種 FCN 結合光流(optical flow,OF)跟蹤的微創手術工具檢測與跟蹤算法。該方法先利用微調的 FCN 驗證 FCN 解決微創手術工具檢測與跟蹤問題的可行性,結果證明微調的 FCN 雖然達不到實時的要求,但是精度最高達到了 83.7%,所以該課題組繼續研究利用 OF 跟蹤加快速度。FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法最終達到了在精度為 88.3% 時,速度為 30 幀/s,比較適合用于較慢的 MIS 視頻數據集。如圖3 所示為 FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法流程圖。

圖3

FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法

Figure3.

FCN combined with OF tracking for minimally invasive surgical tool detection and tracking algorithm

圖3

FCN 結合 OF 跟蹤的微創手術工具檢測與跟蹤算法

Figure3.

FCN combined with OF tracking for minimally invasive surgical tool detection and tracking algorithm

2.2 基于從粗略到精細級聯卷積神經網絡的算法

Zhao 等[11]提出了一種基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法,該文獻中設計了兩個級聯的 CNN 用于微創手術工具的粗略定位和精細定位。粗略 CNN 是一個分類網絡,精細 CNN 是微創手術工具尖端區域的回歸網絡,通過更新 STC 使得兩個 CNN 協同工作以用于微創手術工具的檢測與跟蹤。基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法在冒煙、遮擋等 MIS 場景中都得到了不錯的效果,比較適用于復雜的 MIS 場景,但是其速度還有待于提高。如圖4 所示是基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法流程圖。

圖4

基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法

Figure4.

Minimally invasive surgical tool detection and tracking algorithm based on coarse to fine cascade CNN

圖4

基于從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法

Figure4.

Minimally invasive surgical tool detection and tracking algorithm based on coarse to fine cascade CNN

Zhao 等[12]基于 AlexNet、視覺幾何組(visual geometry group,VGG)網絡和谷歌網(GoogLeNet)提出的從粗略到精細級聯 CNN 的微創手術工具檢測與跟蹤算法帶有一個空間轉換網絡(spatial transformer network,STN),可用于精確定位微創手術工具的位置,該算法比較適用于對精度要求高且場景比較復雜的 MIS,如圖5 所示是該算法的流程圖。由于先經過一個粗略 CNN,再經過一個精細 CNN 的思路可以加快檢測微創手術工具尖端的速度,縮小精細 CNN 的檢測范圍,所以研究者們在搭建網絡結構時可以使用這個思路加快對微創手術工具尖端位置的檢測。

圖5

基于從粗略 CNN 到精細 STN 級聯的微創手術工具檢測與跟蹤算法

Figure5.

Minimally invasive surgical tool detection and tracking algorithm based on coarse CNN to fine STN cascade

圖5

基于從粗略 CNN 到精細 STN 級聯的微創手術工具檢測與跟蹤算法

Figure5.

Minimally invasive surgical tool detection and tracking algorithm based on coarse CNN to fine STN cascade

2.3 基于區域提案的兩階段卷積神經網絡算法

2017 年 Sarikaya 等[13]提出了一種通過改進更快的區域卷積神經網絡(faster regions with convolutional neural network,Faster R-CNN)完成微創手術工具檢測與跟蹤的算法,該算法利用區域提議網絡(regional proposal network,RPN)和多模式雙流 CNN,以融合預測圖像和時間運動線索進而對微創手術工具檢測與跟蹤。Faster R-CNN 是典型的兩階段 CNN,雖然比一階段的 CNN 精度較高,但是比較費時,遠遠達不到實時的標準,改進 Faster R-CNN 后實驗結果的平均精度為 91%,速度為 10 幀/s。值得一提的是 Sarikaya 等[13]提供了來自美國紐約州布法羅羅斯威爾帕克癌癥研究所(Roswell Park Cancer Institute,RPCI)的 10 名外科醫生在達芬奇外科系統 (dVSS) 上執行 6 種不同任務的 MIS 視頻,視頻中的每幀配有微創手術工具的注釋,這代表著該數據集可以直接使用不用額外處理,為研究者們帶來了極大的便利。如圖6 所示為基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法流程圖。

圖6

基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法

Figure6.

Detection and tracking algorithm of multi-mode dual-stream minimally invasive surgery tool based on Faster R-CNN

圖6

基于 Faster R-CNN 的多模式雙流微創手術工具檢測與跟蹤算法

Figure6.

Detection and tracking algorithm of multi-mode dual-stream minimally invasive surgery tool based on Faster R-CNN

2018 年 Jin 等[14]提出的微創手術工具檢測與跟蹤算法也是基于 Faster R-CNN 的兩階段框架,是端到端的訓練,即輸入視頻幀,直接輸出 MIS 中所用 7 個微創手術工具周圍邊界框的空間坐標,具體的流程圖如圖 7 所示。結果表明,基于 Faster R-CNN 的微創手術工具檢測與跟蹤算法雖然精度只提升到了 81.8%,速度也只有 5 幀/s,但是 Jin 等[14]創造性地提出了一個 MIS 效果評估模塊,可以用微創手術工具的時間軌跡和運動軌跡以自動評價 MIS 效果,而且該算法還在檢測微創手術工具存在任務中超越了 EndoNet 算法。

圖7

基于 Faster R-CNN 的微創手術工具檢測跟蹤算法

Figure7.

Minimally invasive surgery tool detection and tracking algorithm based on Faster R-CNN

圖7

基于 Faster R-CNN 的微創手術工具檢測跟蹤算法

Figure7.

Minimally invasive surgery tool detection and tracking algorithm based on Faster R-CNN

2.4 基于回歸的一階段卷積神經網絡算法

上述基于區域提案的兩階段 CNN 算法,雖然其準確度較高,但是遠達不到實時的要求,所以 Choi 等[15]提出了基于回歸的一階段 CNN 算法實現微創手術工具檢測與跟蹤任務。2017 年 Choi 等[15]在 Redmon 等[16]提出的你只能看一眼(you only look once,YOLO)網絡結構的最后一層添加一個全連接層,通過下采樣減少參數的數量,將檢測與跟蹤看成一個簡單的回歸問題,設計了一種能夠實時檢測與跟蹤微創手術工具的 CNN 算法。在添加的全連接層中使用了丟棄(dropout),該層將來自前一層的所有輸出值連接到神經網絡,以防止訓練數據過度擬合。基于回歸的一階段 CNN 算法的實驗結果雖然平均精度為 72.26%,容易錯檢誤檢小型微創手術工具,但是微創手術工具的檢測速度為 48.9 幀/s,增強了一階段 CNN 效率方面的優勢,實時性較高,適用于較大型的微創手術工具檢測與跟蹤。如圖8 所示是改進后的 YOLO 網絡結構。

圖8

改進后的 YOLO 網絡結構

Figure8.

Improved YOLO network structure

圖8

改進后的 YOLO 網絡結構

Figure8.

Improved YOLO network structure

2.5 基于先收縮后擴展路徑的卷積神經網絡算法

Kurmann 等[17]受 U 型網絡(U-Net)啟發提出了一種新穎的基于先收縮后擴展(shrink before expand,SBE)路徑的 CNN 算法,該算法的網絡結構共用 5 個下采樣(特征數加倍)和 5 個上采樣(特征數減半)階段,每個階段有卷積層、激活層和采樣層,最后用全連接層擴展最底層,該算法在測試時不需要滑動窗口從而減少了計算量,而且可以同時檢測與跟蹤多個微創手術工具。2019 年 Gao 等[18] 提出的算法與 Kurmann 等[17]提出的算法類似,而 Du 等[19]受 Twinanda 等[4]和 U-Net 的啟發提出了一種更好的基于 SBE 路徑和雙分支 CNN 的算法,該算法的網絡結構由 FCN 檢測和回歸網絡構成,還融合殘差網絡快捷連結優化輸出精度,由深度學習技術提供動力,沒有來自機器人的任何直接運動學信息。基于 SBE 路徑和雙分支 CNN 算法的實驗結果表明精度在 90% 以上,對新型微創手術工具檢測與跟蹤具有一定的通用性,在煙霧模擬下具有較好的魯棒性,具有處理真實 MIS 場景的能力,不足之處是處理速度沒有達到實時的標準。如圖9 所示是基于 SBE 路徑和雙分支 CNN 算法的流程圖。

圖9

基于 SBE 路徑和雙分支 CNN 的微創手術工具檢測與跟蹤算法

Figure9.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and dual-branch CNN

圖9

基于 SBE 路徑和雙分支 CNN 的微創手術工具檢測與跟蹤算法

Figure9.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and dual-branch CNN

Laina 等[20]提出了利用 SBE 路徑的新算法,通過利用微創手術工具分割和定位之間的相互依賴性,將微創手術工具二維(two dimensional,2D)姿勢估計重新建模表示為熱度圖回歸問題,進而通過深度學習實現分割任務和定位任務同時魯棒回歸,完成微創手術工具檢測與跟蹤任務。通過實驗證明,重新建模熱度圖回歸問題比直接回歸微創手術工具的位置更具優勢。基于 SBE 路徑的 CNN 結構由 He 等[21]提出的完全卷積殘差網絡改進而來,對微創手術工具的分割輸出和定位輸出進行連接后直接端到端訓練,僅依賴于上下文信息而無需任何后處理技術,該方法精度達到了 92.6%,每幀處理速度為 56 ms,實現了精度高、速度較快。如圖10 所示是基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法流程圖。

圖10

基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法

Figure10.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and CNN

圖10

基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法

Figure10.

Minimally invasive surgical tool detection and tracking algorithm based on SBE path and CNN

2.6 基于卷積神經網絡結合遞歸神經網絡的算法

由于 MIS 過程是按時間順序展開的,所以 2017 年 Mishra 等[22]提出了一種較為創新的算法用于微創手術工具檢測與跟蹤任務的檢測部分,該算法使用殘差網絡(ResNet)從微創手術工具圖像中提取高度視覺特征,并利用長短期記憶(long short-term memory,LSTM)網絡來編碼時間信息,以捕獲 ResNet-50 所提取出的高度視覺特征時間連接性,達到提高預測準確性的目的。LSTM 是遞歸神經網絡(recurrent neural network,RNN)中應用最廣泛的神經網絡。該 CNN 結合 LSTM 的算法獲得了 88.75%的平均準確度,每幀處理速度為 2.45 ms,適用于對精度要求不高,但對實時性要求較高的 MIS。值得特別指出的是,Mishra 等[22]在文獻中不但為后續研究者提供了 CNN 結合 LSTM 的研究思路,還公布了可供參考的開源代碼。

CNN 結合 RNN 算法的計算復雜性阻止了其結構端到端訓練,某一步驟結果的好壞會影響到下一步驟,從而影響整個訓練的結果,但是好在許多微創手術工具彼此非常相似,通常可以根據之前時刻的事件進行區分,所以應結合時間背景訓練 CNN 以提取最有用的視覺特征。Hajj 等[23]提出了一種新的增強策略,即通過逐步增加訓練好的弱分類器來同時豐富系統的 CNN 和 RNN 部分,提高微創手術工具檢測與跟蹤算法的平均精度,其中精度最高可達 97.89%。該研究在實驗部分用 18 種 CNN 對 28 種微創手術工具檢測與跟蹤結果進行對比評價,以供后續研究者們參考。

3 基于弱監督的深度神經網絡微創手術工具檢測與跟蹤算法

前面綜述的所有算法都是基于完全監督的深度神經網絡微創手術工具檢測與跟蹤算法,但是完全監督模型要求在訓練時使用空間信息完全標注的數據,目前可供微創手術工具檢測與跟蹤領域作為訓練數據集及測試數據集的標準數據庫十分稀少。除了之前所提 Cholec80 數據集和 2016 年計算機輔助干預的建模和監測會議挑戰發布的公開數據集(m2cai16-tool)(網址:http://camma.u-strasbg.fr/m2cai2016/index.php/tool-presence-detection-challenge-results/) 可以直接用以訓練外,其他數據集都需要人工完全標注數據,且可能存在標注人員不專業或浪費人力等問題。完全監督模型限制了可用數據集的大小和微創手術工具檢測與跟蹤算法的泛化,于是研究者們為了避免完全監督中需人工完全標注數據的弊端,嘗試了弱監督模型,弱監督模型在訓練時僅需要對圖像級別標注數據進行訓練,不需要任何空間標注,這為缺少完全標注數據集的微創手術工具檢測與跟蹤領域的發展帶來了新契機。目前弱監督也被應用于醫學圖像中癌癥區域的檢測等任務[24-25],但遺憾的是相比較于完全監督模型,弱監督模型出現的時間較晚,與之的相關的參考文獻還較少,發展不夠成熟,而且還達不到實時性的要求。

基于弱監督的目標檢測文獻[26-27],Vardazaryan 等[28]構建出一種 FCN 結構,該網絡結構是改進的 ResNet-18,刪除了完全連接的層以保留空間信息并允許研究者們在沒有明確空間標注的數據集下對微創手術工具檢測與跟蹤,而且是端到端的訓練,即上一步驟的誤差不會影響下一步驟,測試結果平均精度為 88.8%。

Nwoye 等[29]提出了一種用于微創手術工具檢測與跟蹤的弱監督 CNN 結合卷積長短時記憶(ConvLSTM)網絡算法,該算法僅在微創手術工具二進制存在標簽上進行弱監督,再使用 ConvLSTM 網絡來模擬微創手術工具運動中的時間依賴性,并利用 ConvLSTM 網絡的時空性能來平滑定位熱度圖(Lhmaps)中的類峰值激活。基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法提出了 ConvLSTM 網絡的思路,測試結果平均精度提升到 92.9%,適用于對精度要求較高的 MIS,也證明了基于弱監督的深度神經網絡足以用于基于深度學習的微創手術工具檢測與跟蹤算法,該算法流程圖如圖11 所示。

圖11

基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法

Figure11.

Weakly supervised CNN combined with ConvLSTM for minimally invasive surgical tool detection and tracking algorithm

圖11

基于弱監督 CNN 結合 ConvLSTM 的微創手術工具檢測與跟蹤算法

Figure11.

Weakly supervised CNN combined with ConvLSTM for minimally invasive surgical tool detection and tracking algorithm

4 總結及展望

本綜述主要總結了多種基于深度學習的微創手術工具檢測與跟蹤算法,目前基于 SBE 路徑的 CNN 微創手術工具檢測與跟蹤算法在 MIS 中應用比較成熟,精度較高且速度較快;基于 CNN 結合 RNN 算法在精度方面還有很大的提升空間,需要研究者們繼續探索;解決數據集完全標注問題的基于弱監督的深度神經網絡微創手術工具檢測與跟蹤算法是比較新的研究方向,精度比較高,但是達不到實時性的要求。如圖12 所示為基于深度學習的微創手術工具檢測與跟蹤算法總結圖。本綜述比較分析了多種微創手術工具檢測與跟蹤算法的測試結果、適用范圍及優缺點,以便相關領域的科研工作者更系統地了解目前研究進展,同時可為微創外科手術醫生選擇合適的導航技術提供參考。

圖12

基于深度學習的微創手術工具檢測與跟蹤算法總結

Figure12.

Summary of detection and tracking algorithm for minimally invasive surgical tool based on deep learning

圖12

基于深度學習的微創手術工具檢測與跟蹤算法總結

Figure12.

Summary of detection and tracking algorithm for minimally invasive surgical tool based on deep learning

目前已有的基于深度學習的微創手術工具檢測與跟蹤算法還需在準確度和實時性方面實現整體提升,因此未來的微創手術工具檢測與跟蹤算法或將有以下發展方向:

(1)有效融合特征。有效的特征是解決微創手術工具檢測與跟蹤問題的基礎,所以可將多種深度學習特征融合到所有網絡結構中,使測試結果更加準確。

(2)實現長時間跟蹤。設計一個更好的目標模型更新,重新找到所需跟蹤的微創手術工具或找到合適的神經網絡相互結合,解決在微創手術工具跟蹤過程中目標丟失的問題。

(3)由完全監督向弱監督甚至無監督深度學習發展。如何借助生成對抗網絡、自編碼器等實現無監督模型以增強實時性,或將是微創手術工具檢測與跟蹤領域研究的難點和重點。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。