皮膚癌是一個重要的公共衛生問題,計算機輔助診斷技術可以有效地減輕這一負擔。在采用計算機輔助診斷時,準確識別皮膚病變類型至關重要。為此,本文提出一種基于Swin-T與ConvNeXt的多級注意力逐級融合模型,采用分層Swin-T與ConvNeXt分別提取全局與局部特征,并提出殘差通道注意力與空間注意力模塊進一步提取有效特征;利用多級注意力機制對多尺度全局與局部特征進行處理;針對淺層特征因離分類器較遠而丟失的問題,采用逐級聚合的思想,提出逐級倒置殘差融合模塊動態調整提取的特征信息。本文通過均衡采樣策略以及焦點損失,解決皮膚病變類別不平衡的問題。在ISIC2018、ISIC2019數據集上進行測試,其準確率、精確率、召回率和F1-Score分別是96.01%、93.67%、92.65%、93.11%與92.79%、91.52%、88.90%、90.15%。與Swin-T相比,準確率分別提升了3.60%和1.66%;與ConvNeXt相比,準確率分別提升了2.87%和3.45%。實驗表明,本文提出的方法能夠準確分類皮膚病變圖像,為皮膚癌的診斷提供了新的解決方案。

引用本文: 王澤彤, 張俊華, 王肖. Swin-T與ConvNeXt多級融合的皮膚病變分類. 生物醫學工程學雜志, 2024, 41(3): 544-551. doi: 10.7507/1001-5515.202305025 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

0 引言

皮膚癌是一種常見且危害巨大的惡性腫瘤,其發病率逐年增加[1]。常見的皮膚病變包括8種類型,其中,黑色素痣(melanocytic nevus,NV)、良性角化病(seborrheic keratosis,BKL)、光化性角化病(actinic keratosis/early intraepidermal carcinoma,AKEIC)、血管源性病變(vascular lesion,VASC)和皮膚纖維瘤(dermatofibroma,DF)屬于良性病變;而黑色素瘤(melanoma,MEL)、基底細胞癌(basal cell carcinoma,BCC)則為惡性病變。惡性黑色素瘤危害是最嚴重的,每年僅在美國就導致10 000人死亡。早期發現可通過簡單手術治愈,但晚期診斷會面臨更高的死亡風險。臨床上皮膚鏡檢查是一種有效手段,可檢測黑色素瘤和其他色素性皮膚病變。專業醫生可通過皮膚鏡圖像外觀和形態特征區分不同病變類型,然而其主觀性和可變性可能導致誤診和漏診[2]。

為應對皮膚病的誤診和漏診問題,計算機輔助診斷技術正逐漸成為主流。傳統方法通常涉及病變區域的分割、特征提取和分類。Celebi等[3]利用基于閾值分的分割算法和支持向量機(support vector machines,SVM)分類器,取得了良好的效果。Ganster等[4]采用ABCD準則提取特征,將黑色素瘤的識別準確率提高至85%~91%,明顯改善了早期識別能力。隨著深度卷積神經網絡(convolutional neural networks,CNN)的興起,它在自然圖像分類中表現出色,在醫學圖像分析中的應用也日益凸顯。Yu等[5]使用深度CNN成功識別黑色素瘤,平均準確率達到85.5%。Codella等[6]結合稀疏編碼、深度學習和SVM,將3類皮膚病變圖像分類的準確率提升至93.1%。Esteva等[7]采用遷移學習和微調Inception V3,對三類皮膚病變圖像進行分類,精度達到71.2%。Kawahara等[8]使用預訓練的AlexNet網絡進行黑色素瘤檢測,準確率達到85.8%。盡管CNN能提取重要局部特征信息,但在提取全局特征方面存在局限。Ayas等[9]將Swin-T與遷移學習結合,成功地在ISIC-2019數據集中識別出8種皮膚病變類型,準確率達到82.3%。

本文提出了一種基于Swin-T[10]與ConvNeXt[11]多級注意力逐級融合(Swin-T–ConvNeXt multi-level attention hierarchical fusion,S-C-MAHF)模型用于皮膚病變分類。采用分層Swin-T與ConvNeXt分別提取全局與局部特征,并提出殘差通道注意力(residual channel attention,Res-CA)與殘差空間注意力(residual spatial attention,Res-SA)模塊進一步提取有效特征;利用多級注意力機制(multi-level attention,MLA)對多尺度全局與局部特征進行處理;針對淺層特征因離分類器較遠而丟失的問題,采用逐級聚合的思想,提出逐級倒置殘差融合(hierarchical inverted residual fusion,HIRF)模塊動態調整提取的特征信息。該算法旨在解決現有皮膚病變分類方法在精度和難度上的瓶頸問題,為醫生準確診斷皮膚病變程度提供可靠的分析支持。

1 算法描述

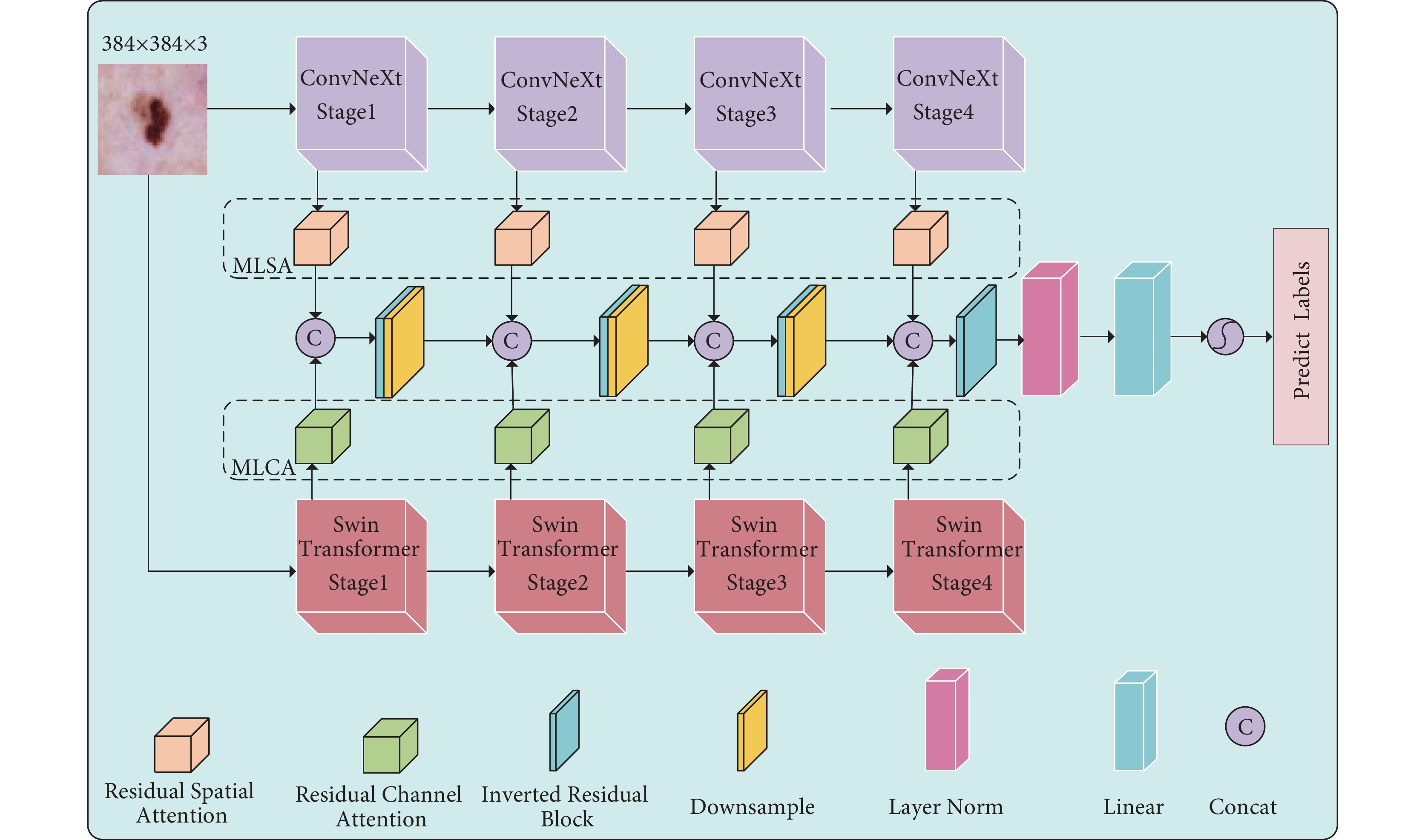

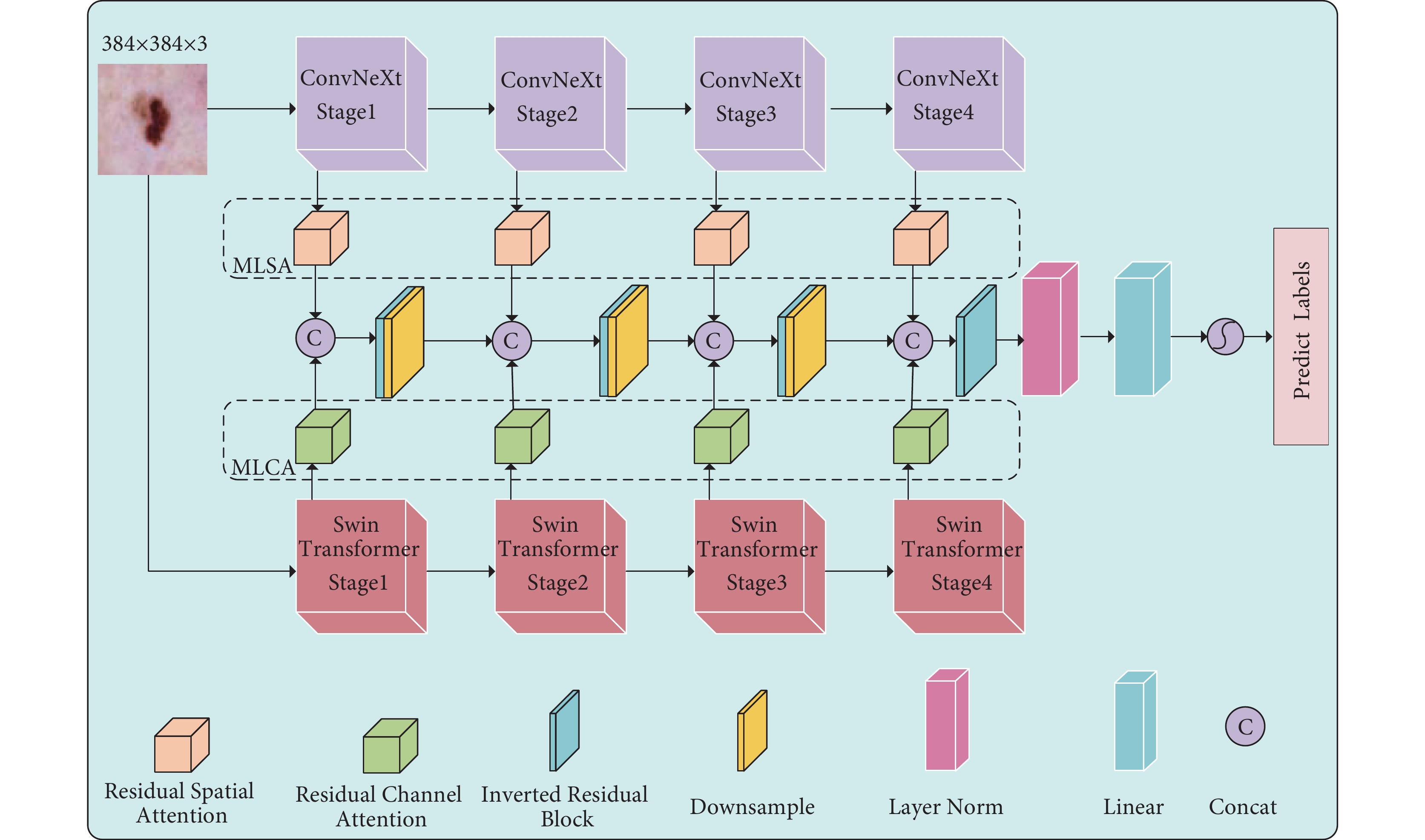

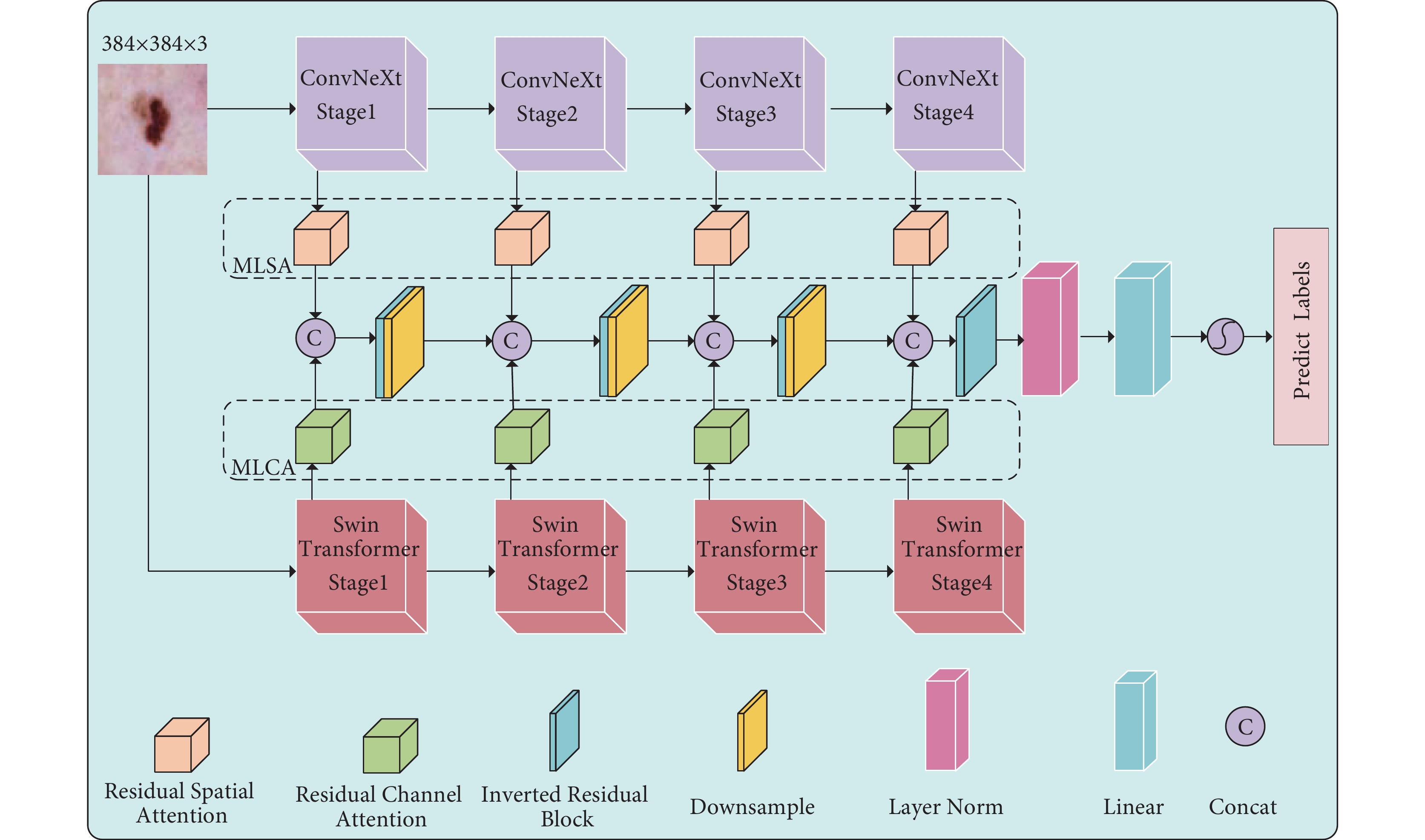

S-C-MAHF結構如圖1所示。該模型由分層ConvNeXt、分層Swin-T、MLA和HIRF組成。分層Swin-T和ConvNeXt編碼器采用遷移學習方法,使用在Image-21K數據集中預訓練的權重。MLA包含多級空間注意力(multi-level spatial attention,MLSA)和多級通道注意力(multi-level channel attention,MLCA)兩個模塊,MLSA通過Res-SA動態調整局部特征圖之間的權重,加強皮膚病變特征空間位置的提取,而MLCA則利用Res-CA在全局特征圖之間動態調整權重,加強皮膚病變特征通道之間的聯系。HIRF通過逐級融合多尺度特征的方法,實現皮膚病變特征的融合。

圖1

網絡整體結構圖

Figure1.

Overall network structure diagram

圖1

網絡整體結構圖

Figure1.

Overall network structure diagram

1.1 殘差注意力

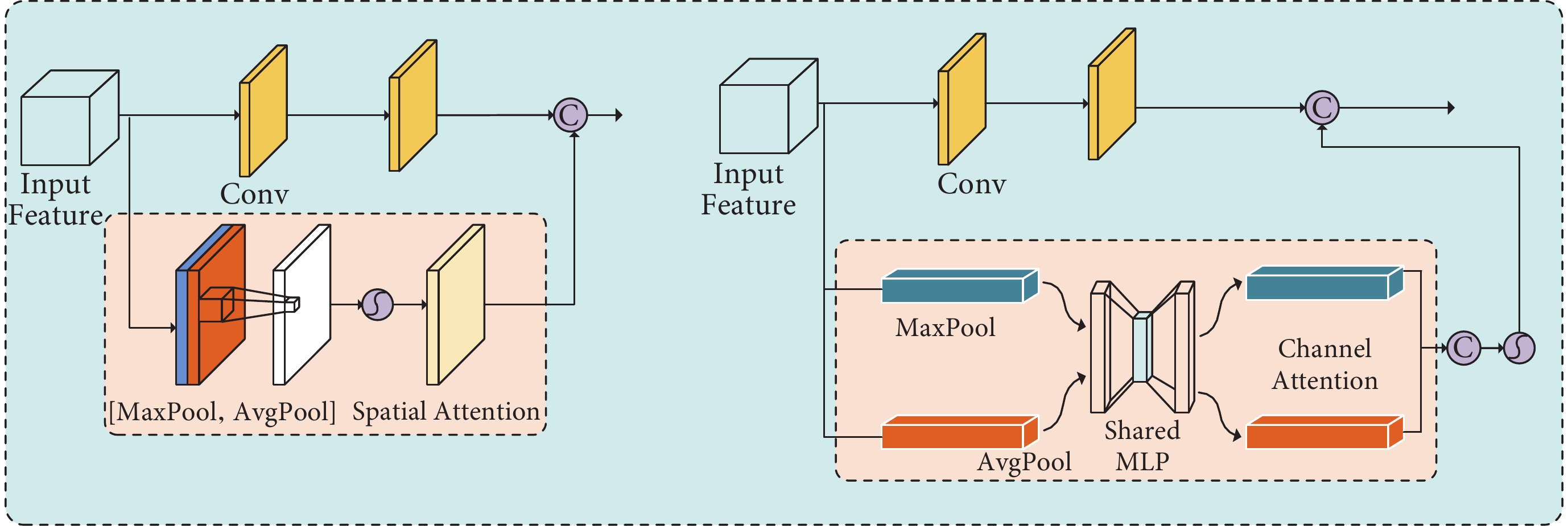

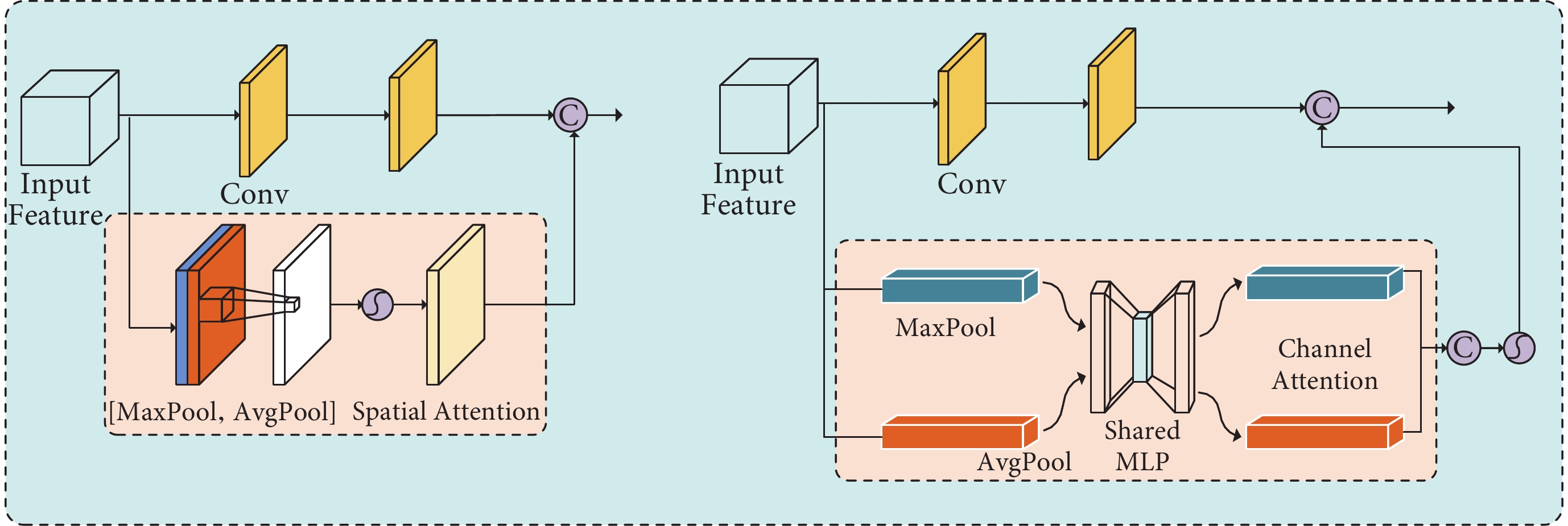

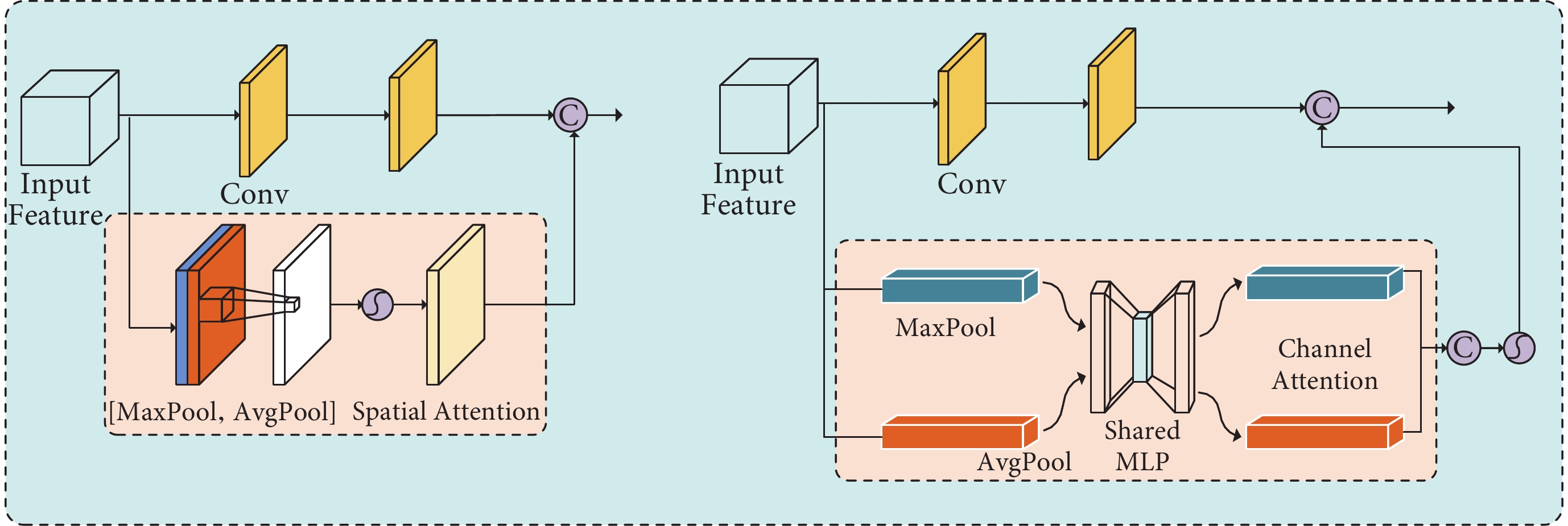

在皮膚病變分類中,同一類型的皮膚病變之間存在顯著的特征差異,包括大小、形狀、顏色和紋理等方面。為了增強網絡對皮膚病變圖像特征的學習能力,本文引入了空間注意力(spatial attention,SA)[12]和通道注意力(channel attention,CA),以突出重要信息并抑制次要信息。因此,本文設計了Res-SA和Res-CA,分別用于對ConvNeXt和Swin-T提取的多尺度特征進行進一步的提取,以提高模型對皮膚病變區域的關注度。由于CNN網絡主要關注輸入圖像的局部特征,本文通過SA對局部特征進行加權處理,以提高對病變區域的關注度,并引入殘差結構以加速網絡收斂速度和防止梯度消失。而Transformer網絡提取的全局特征主要關注整體圖像特征,因此本文通過CA對全局特征進行增強,調節不同通道特征之間的權重,將更多的關注力集中在更重要的特征通道上,同時也引入殘差結構。Res-SA與Res-CA如圖2所示。Res-SA公式見式(1):

圖2

殘差空間注意力(左)和殘差通道注意力(右)

Figure2.

Residual spatial attention (Left) and residual channel attention (Right)

圖2

殘差空間注意力(左)和殘差通道注意力(右)

Figure2.

Residual spatial attention (Left) and residual channel attention (Right)

|

Res-CA公式見式(2):

|

1.2 多級注意力

在皮膚病變圖像分類中,專業醫生通常手動提取兩種特征:粗略特征(如大小、形狀、顏色變化和邊緣)和細節特征(如紋理、血管模式、結構組織和光環效應)。本文模型利用CNN和Transformer分別提取局部和全局特征,每類特征都包括四種不同尺度的信息。為增強粗略特征提取,采用MLCA對多尺度局部特征進行多層次自適應處理;為增強細節特征提取,引入MLSA對多尺度全局特征進行多層次自適應處理,提高病變特征區域清晰度。MLCA和MLSA的具體處理過程如圖1所示,為皮膚病變圖像分類提供了更全面且準確的特征表達。

1.3 逐級倒置殘差融合塊

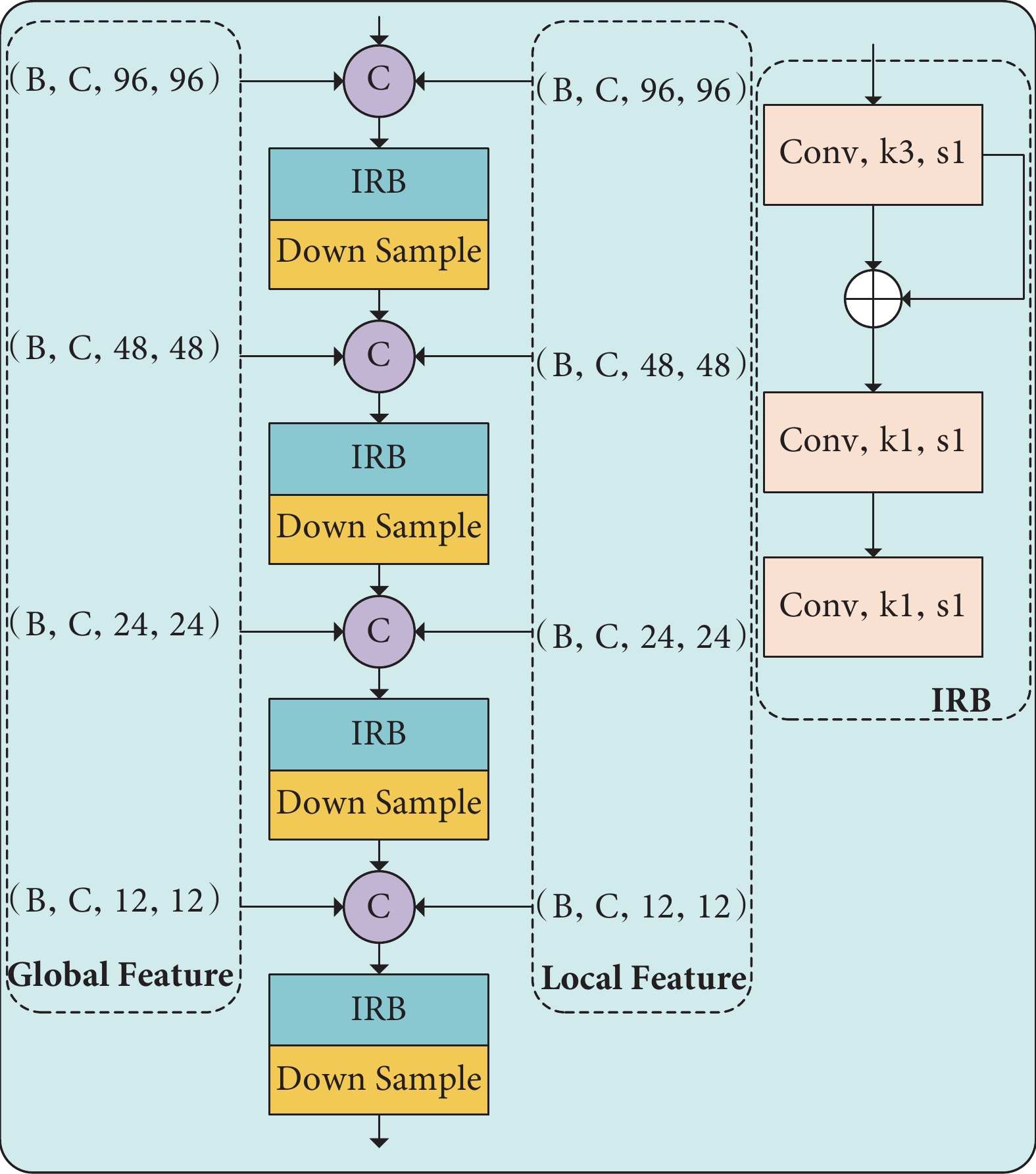

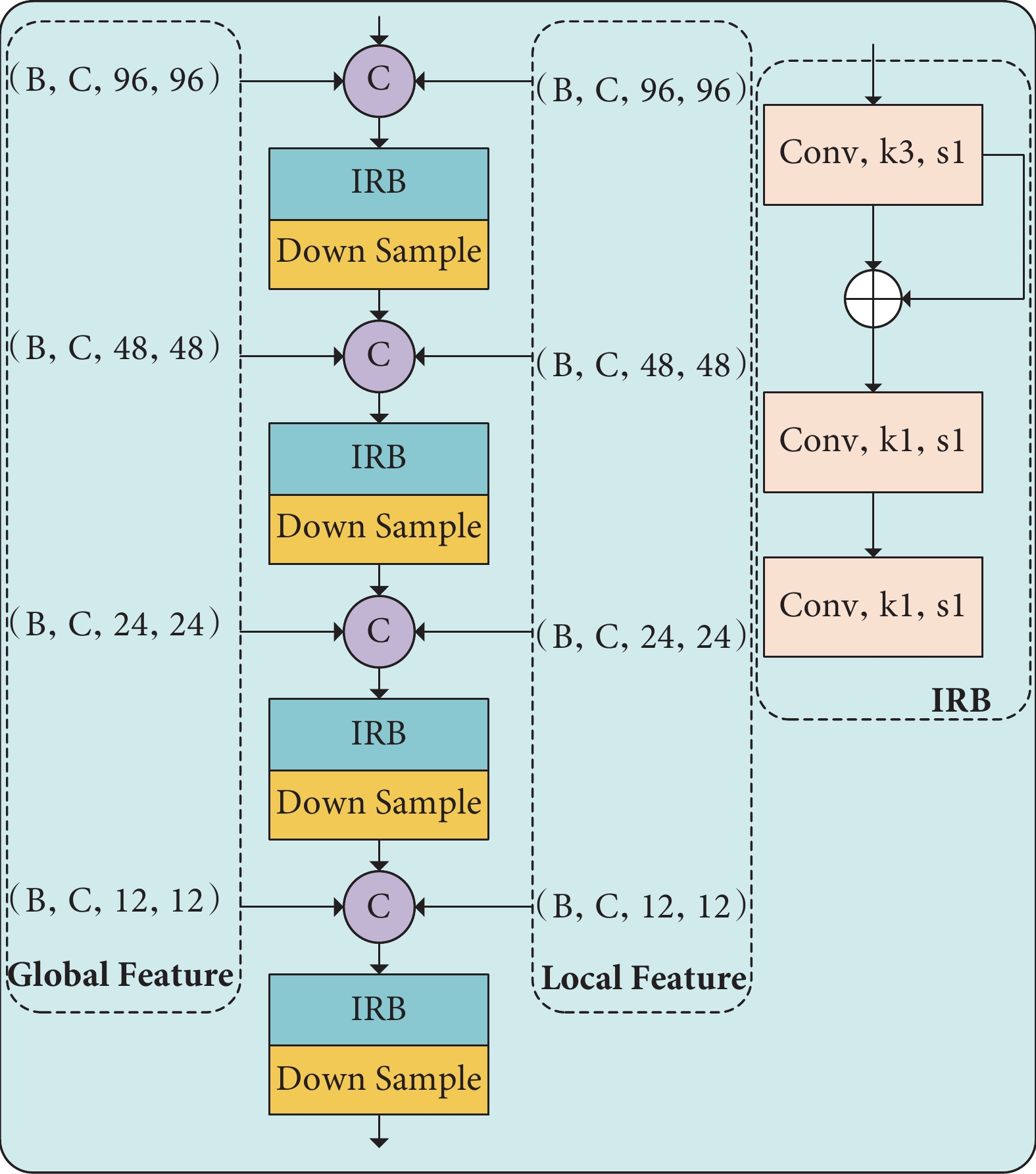

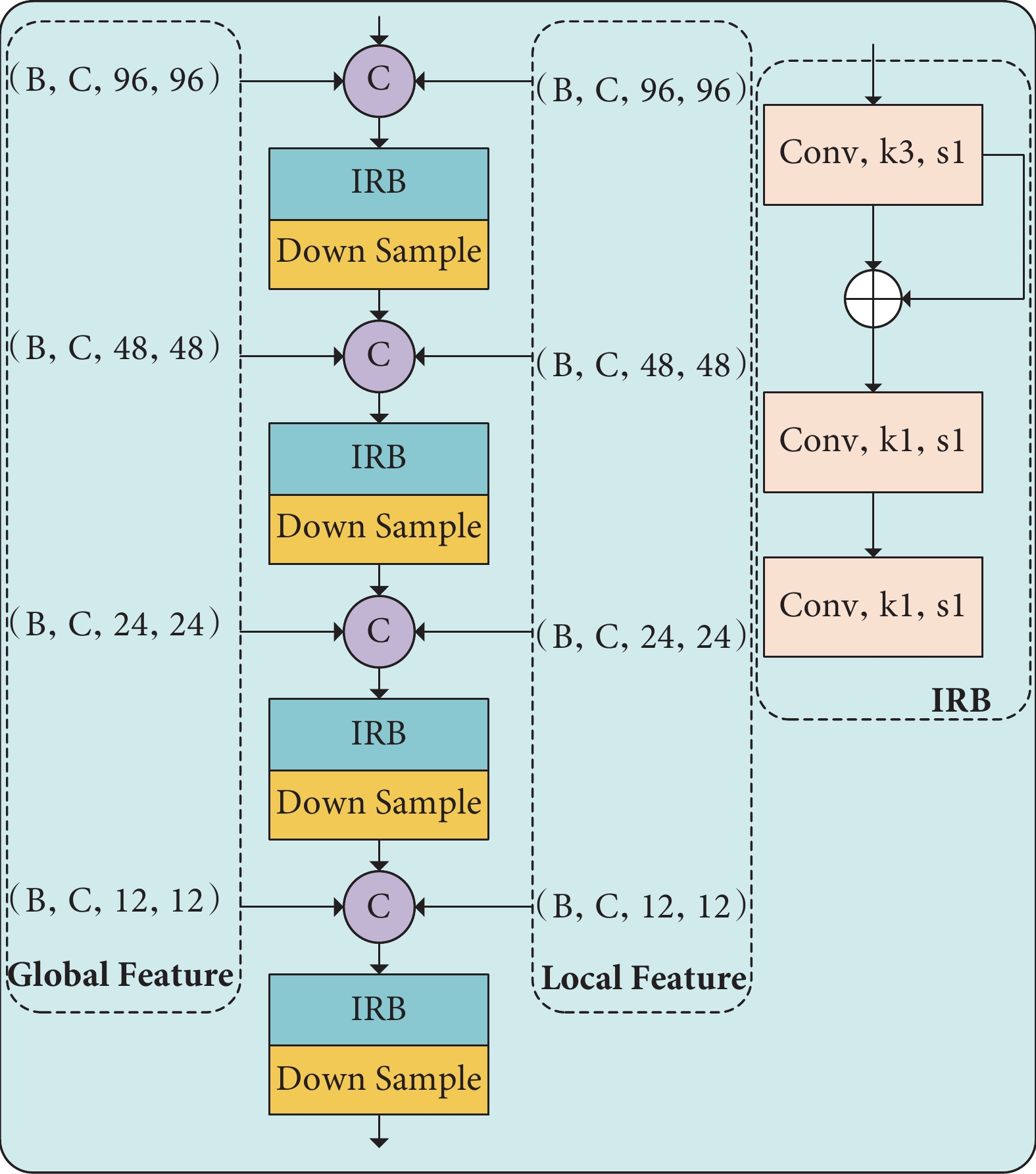

在皮膚病變圖像分析中,高分辨率特征圖和低分辨率特征圖展現出各自獨特的特性。高分辨率特征圖涵蓋了豐富的空間細節特征,能夠更準確地定位皮膚病變的區域;而低分辨率特征圖則包含更深層次的語義信息,有助于識別病變的嚴重程度。因此,在皮膚病變圖像分析任務中,我們可以充分發揮這兩種特征圖的優勢,以獲得更為準確的結果和更出色的性能。由于本模型采用了ConvNeXt與Swin-T分別提取全局特征與局部特征,并隨后采用分級編碼結構輸出多尺度特征,因而能夠更全面地捕捉和表達皮膚病變的復雜特征,提高了特征表示的豐富性和準確性。為了有效融合多尺度的全局與局部特征,本文提出了HIRF模塊,其結構如圖3(右)所示。HIRF先使用拼接操作對同級別的全局與局部特征進行拼接;接著采用倒置殘差模塊[13](inverted residual block,IRB)對特征進行融合并降低通道數,IRB如圖3(左)所示;最后,通過下采樣操作將融合后的特征與下一級特征拼接在一起。

圖3

逐級倒置殘差融合塊

Figure3.

Hierarchical inverted residual fusion

圖3

逐級倒置殘差融合塊

Figure3.

Hierarchical inverted residual fusion

1.4 焦點損失函數及均衡采樣策略

不同皮膚病變類型的發病率存在顯著差異,導致圖像數據不均衡,模型在訓練中可能偏向于常見類型。為解決這一問題,我們采用焦點損失函數[14]和均衡采樣策略,用以提高模型性能。損失函數公式如式(3)所示,類別采樣率如表1所示。

|

其中,Pt是第t類預測樣本的概率,αt和γ是超參數。本文設定αt設為1,γ設置為2。

2 實驗結果及分析

2.1 實驗環境、數據集及評價標準

本實驗采用Python 3.7和PyTorch 1.10進行編程。實驗設備包括CPU(64 GB)和GPU(NVIDIA GeForce RTX 3090,24 GB顯存)。訓練過程中,初始學習率設為1e-4,當準確率達到0.80時衰減至1e-5。為防止過擬合,引入了L2正則化,設置權重衰減系數為0.000 2。實驗使用了國際皮膚成像協會(International Skin Imaging Collaboration,ISIC)2018[15]和2019[16]年的公開數據集,按0.80∶0.05∶0.15的比例劃分為訓練集、驗證集和測試集。我們評估了四個常見的多分類任務評價指標:準確率(Acc)、精確率(Pre)、召回率(Recall)和F1值,并與最先進的模型進行了比較分析。

2.2 消融實驗

本節詳細分析了所提出模型各個模塊在皮膚病變分類性能中的貢獻,包括分層ConvNeXt編碼器、分層Swin-T編碼器、MLSA、MLCA、HIRF以及損失函數。本文在ISIC2018和ISIC2019數據集中對這些模塊進行了消融研究。

本研究總共設計七種不同的模塊組合進行實驗,具體如下:M1為分層ConvNeXt編碼器,不添加任何模塊;M2在M1的基礎上添加了MLSA;M3為分層Swin-T編碼器,不添加任何模塊;M4在M3的基礎上添加了MLCA;M5為M2與M4融合共同提取特征,對于全局特征與局部特征的融合采用簡單的拼接操作與下采樣操作;M6在M5的基礎上使用了HIRF融合全局與局部特征;M7在M6的基礎上使用Focal Loss作為損失函數,即本文提出的方法。消融實驗結果如表2所示,最優值加粗表示。MLSA和MLCA對多尺度局部與全局特征分級處理,使得模型更深入地關注皮膚病變圖像的關鍵信息,從而顯著提升了模型的準確率與F1值;Swin-T與ConvNeXt的結合,不僅提取了皮膚病變的大小、顏色等基本特征,還捕捉了皮膚病變的紋理、血管等細微特征,提升了模型的準確率,同時也權衡了Pre與Recall值;HIRF有效聚合多尺度上下文信息,進一步提升了模型的準確率與F1值。消融實驗驗證了本文所提模塊的有效性和所提方法的合理性。

2.3 可視化分析

2.3.1 熱力圖分析

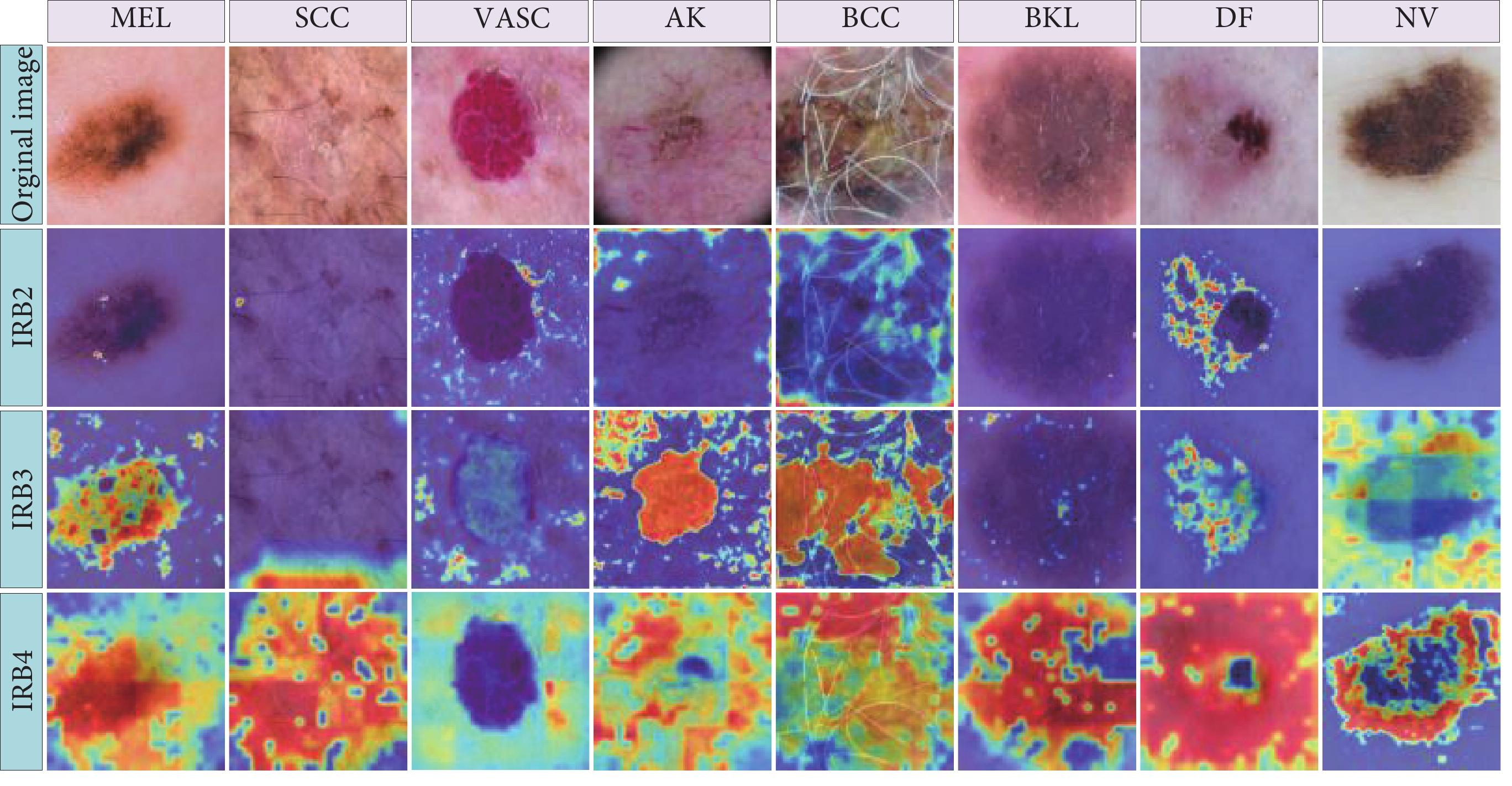

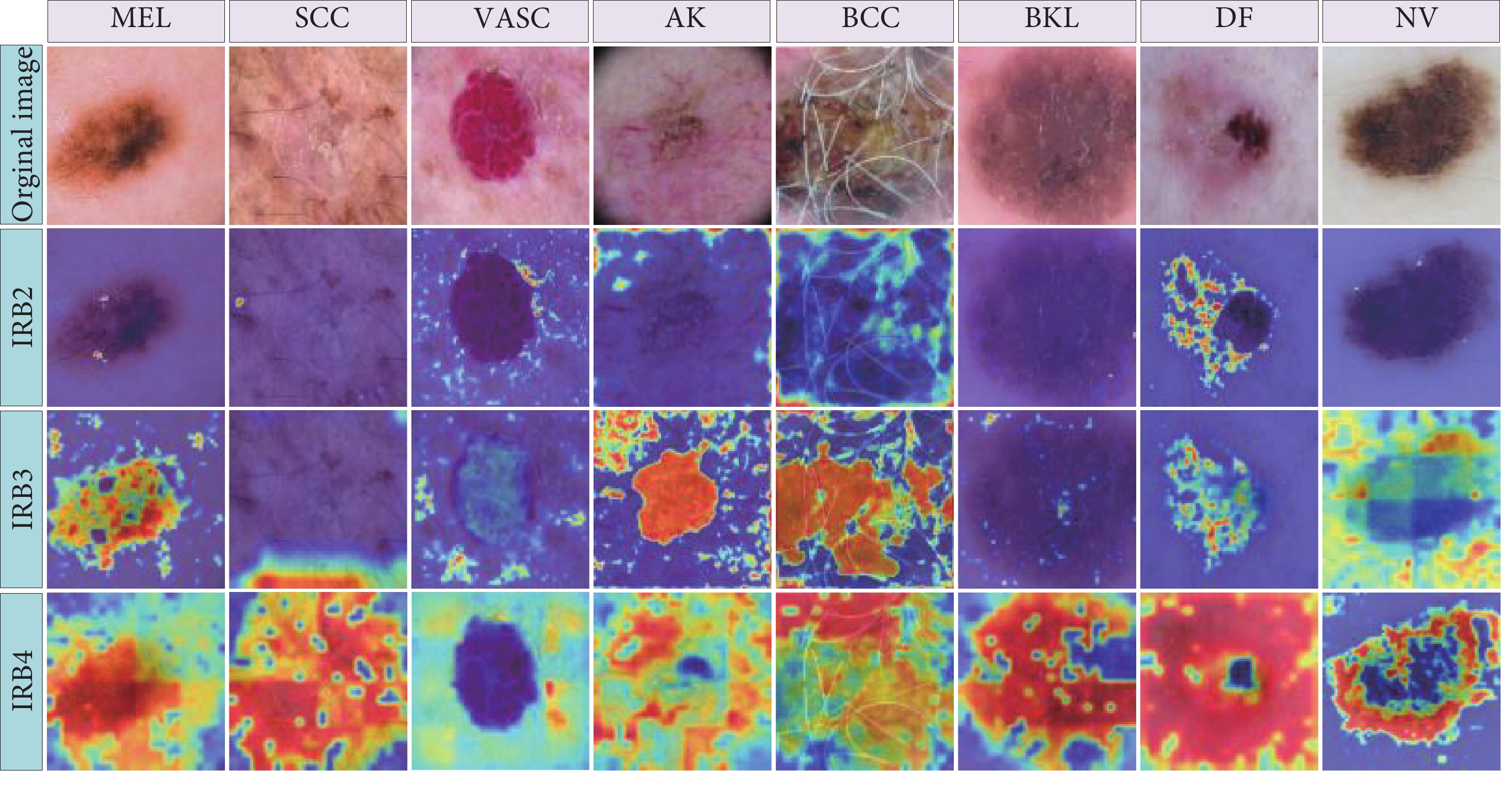

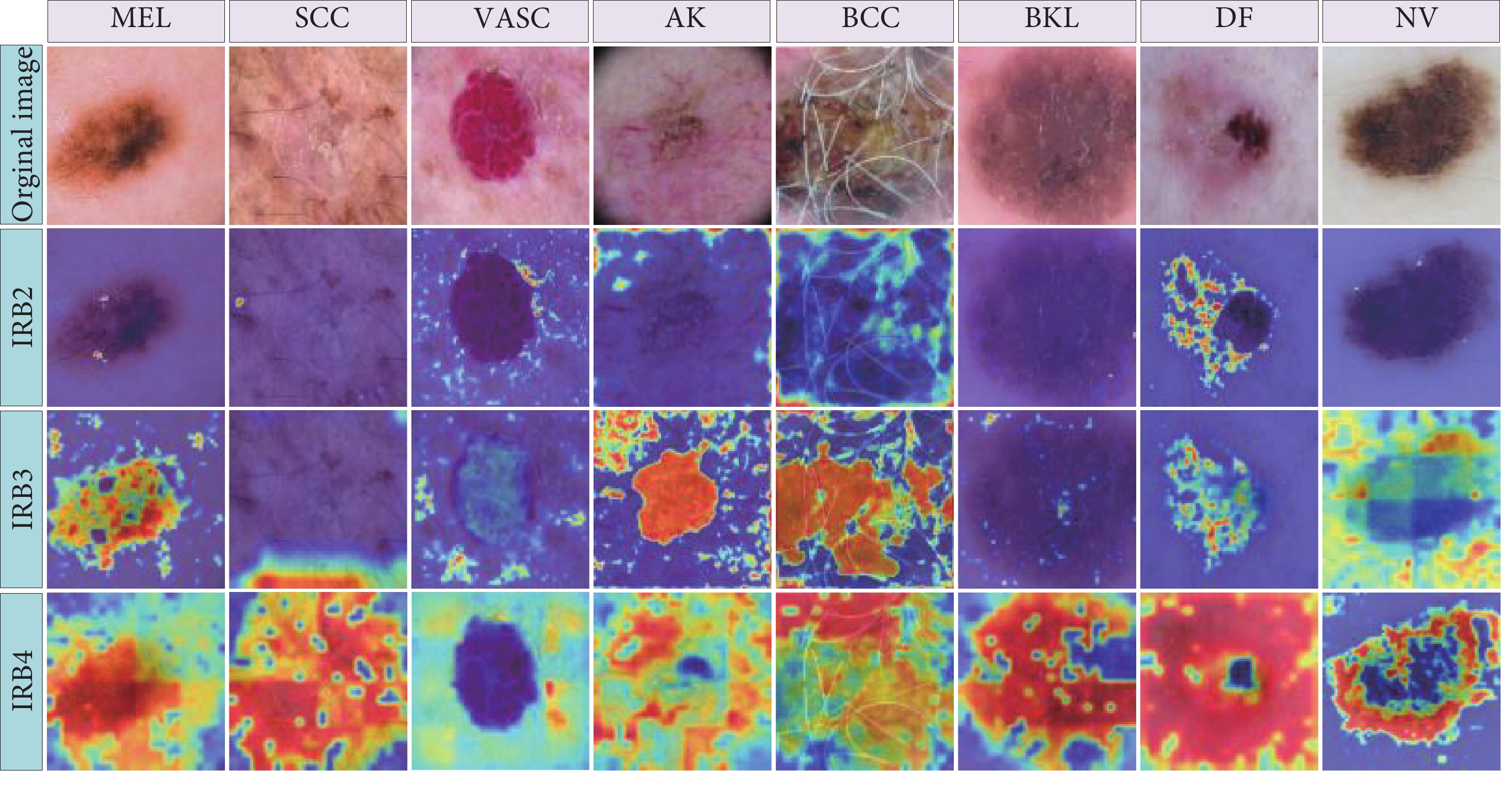

表2的數據顯示,本文所提出的模型在ISIC2018和ISIC2019兩個數據集中均取得了顯著的性能提升。具體而言,在準確率、精確度、召回率和F1值方面,相較于ConvNeXt,分別取得了2.87%、4.96%、3.96%、4.54%和3.45%、7.27%、3.19%、5.30%的提升;而與Swin-T相比,分別取得了3.60%、8.84%、7.08%、8.22%和1.66%、1.81%、5.53%、4.05%的提升。數據分析進一步證明了本文提出的模型在皮膚病變圖像分類任務上的卓越性能。為了深入研究各個模塊的功能,我們在研究中采用了可視化熱力圖進行更詳細的分析。針對8種皮膚病變圖像,通過模型選取IRB2、IRB3和IRB4提取的特征圖進行可視化分析,結果如圖4所示。

圖4

HIRF各層特征熱力圖

Figure4.

Heatmap of various layers' feature in HIRF

圖4

HIRF各層特征熱力圖

Figure4.

Heatmap of various layers' feature in HIRF

在BCC圖像中,由于皮膚病變區域受毛發的嚴重干擾,特別是在IRB2層面,影響較為顯著。然而,隨著特征層級的逐漸加深,這種干擾逐漸減少,IRB4層已經明顯地關注到了皮膚病變區域。而在MEL、SCC和BKL圖像中,由于皮膚病變區域受到皮膚顏色的影響,導致在IRB2層面難以有效提取到病變特征,但在IRB3與IRB4中,模型逐漸成功提取到了皮膚病變的特征。

總體而言,在皮膚病變特征的提取過程中,本文模型呈現出由淺層到深層逐漸提取皮膚病變特征的趨勢。與此同時,通過引入Swin-T,模型能夠捕獲到皮膚病變遠距離特征之間的聯系,最終實現了對皮膚病變的準確分類。這一過程的綜合效果在不同類型的皮膚病變圖像中均得到體現,為醫學圖像領域的進一步研究提供了有益的啟示。

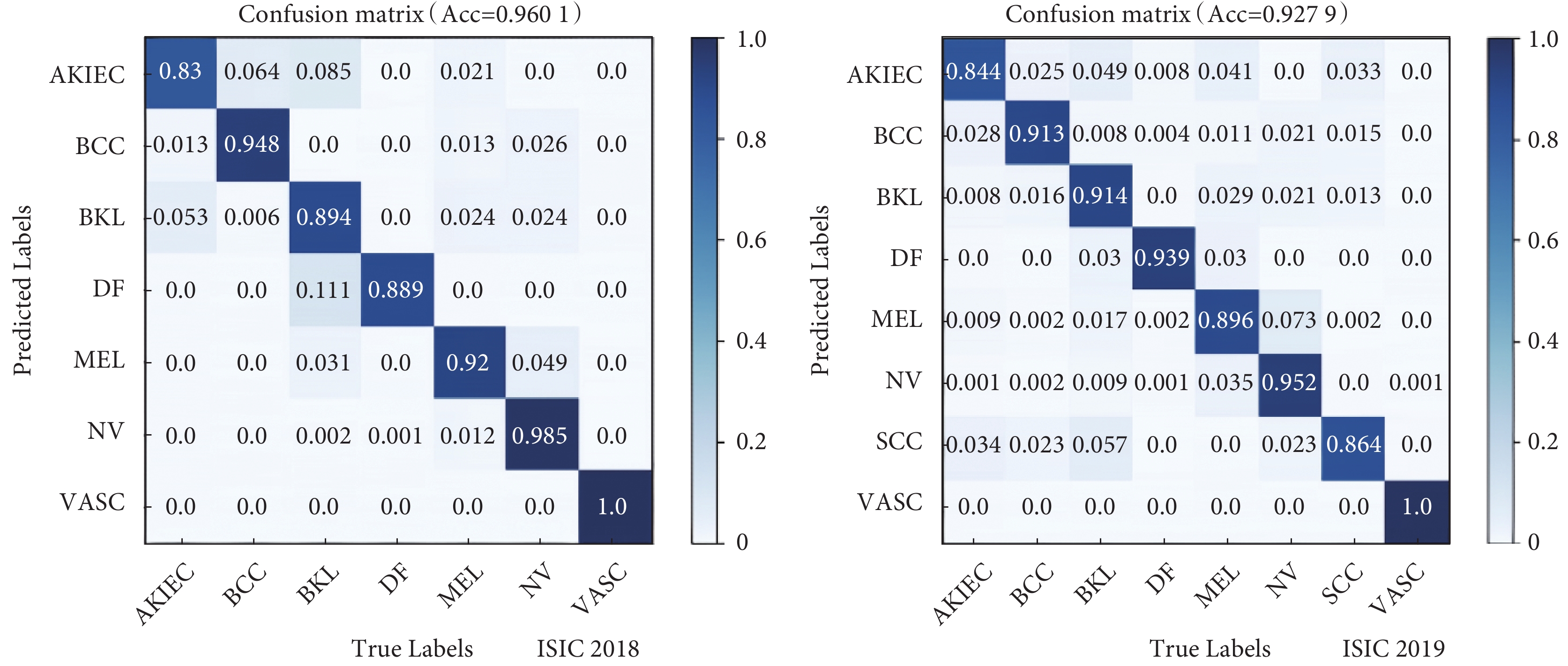

2.3.2 混淆矩陣

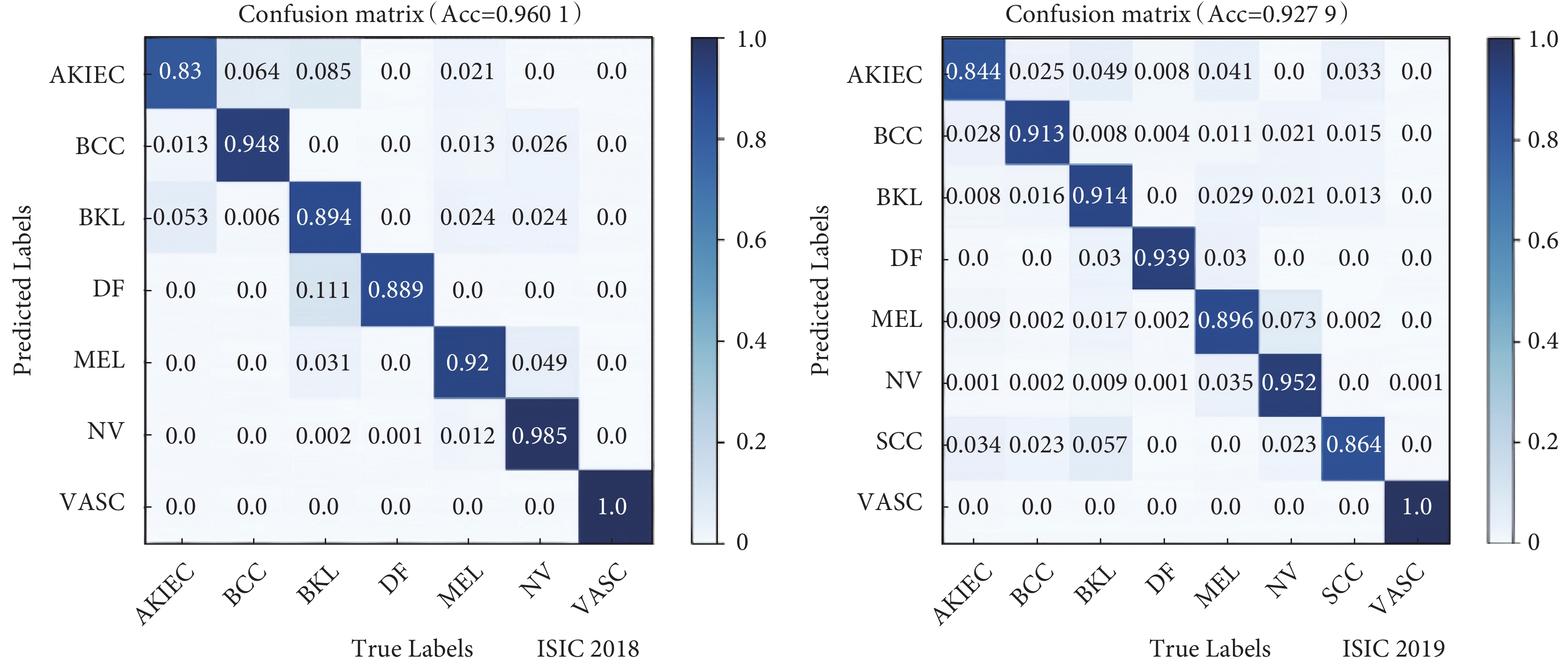

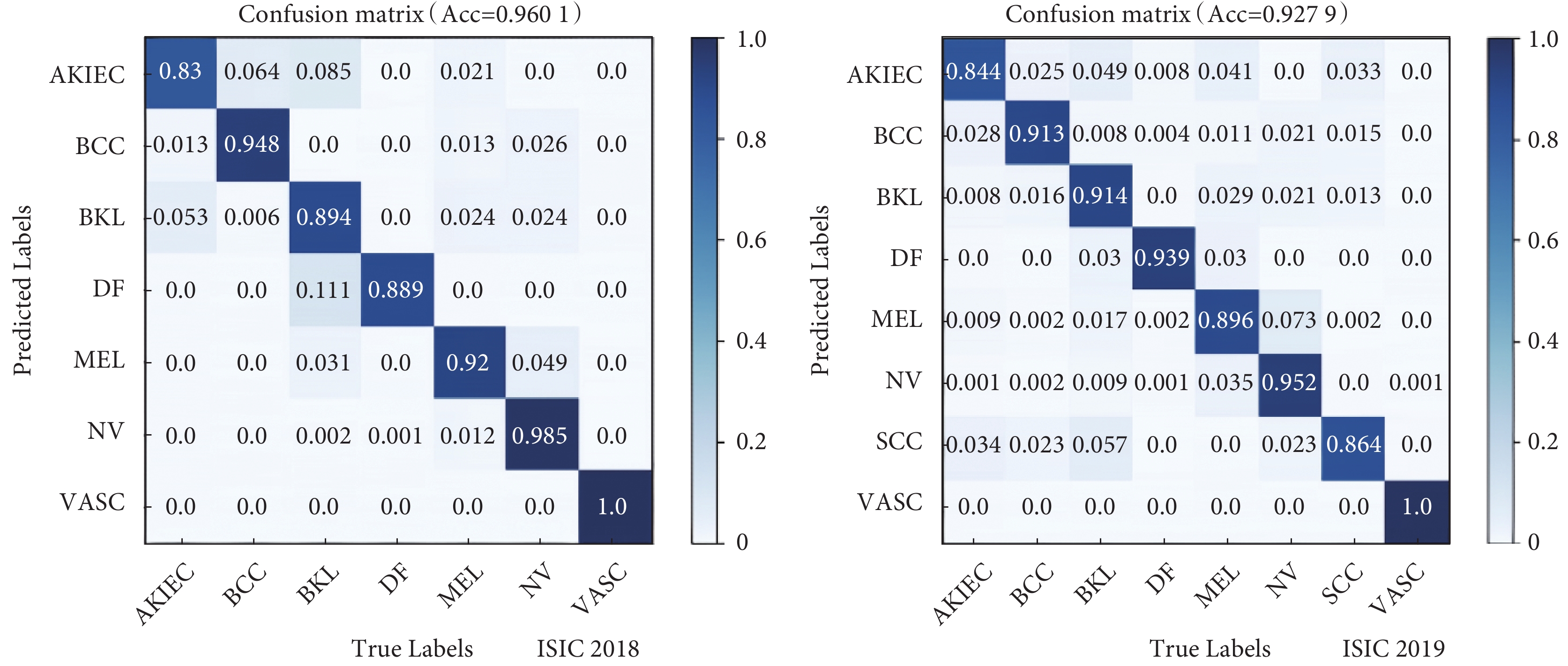

如表2所示,本文模型在ISIC2018和ISIC2019測試集上分別取得了96.01%和92.79%的準確率,為了深入揭示本文模型在各個皮膚病變類別上的分類性能,通過混淆矩陣進行了可視化分析(見圖5)。混淆矩陣的結果清晰地展示了本文模型在不同皮膚病變類別上的分類表現,其中對角線值反映了皮膚病變的分類準確率,而非對角線值則表示被錯誤標記為其他樣本的比例。

圖5

ISIC2018、ISIC2019數據集分類結果混淆矩陣

Figure5.

Confusion matrix of classification results in ISIC2018 and ISIC2019 datasets

圖5

ISIC2018、ISIC2019數據集分類結果混淆矩陣

Figure5.

Confusion matrix of classification results in ISIC2018 and ISIC2019 datasets

2.4 對比實驗

為了全面評估本文提出的模型在皮膚鏡圖像分類任務中的性能,將之與DenseNet121[17]、DenseNet201[17]、ResNet101[18]、ResNet152[18]、ConvNeXt,Swin-T等方法進行了對比,并獲得了各種方法的量化指標,結果如表3所示。在兩個數據集上,本文模型的準確率、精確率、召回率和F1值均取得了最優成績。高準確率通常表明分類模型在整體樣本中的正確分類比例較高,即模型在整個樣本中分類準確性較為顯著。然而,準確率并不能充分反映模型的全面性能,尤其在數據集類別存在不平衡的情況下。相反,高召回率意味著模型能夠有效捕獲正例樣本,最大限度地減少漏檢的發生。在醫學圖像分類等領域,對于重要的陽性樣本,高召回率至關重要,因為它表示模型能夠及時識別出存在病變的情況,降低漏檢的風險。以上性能指標充分證明了本文模型在皮膚病變圖像分類任務中表現卓越,具備準確而可靠的分類能力。

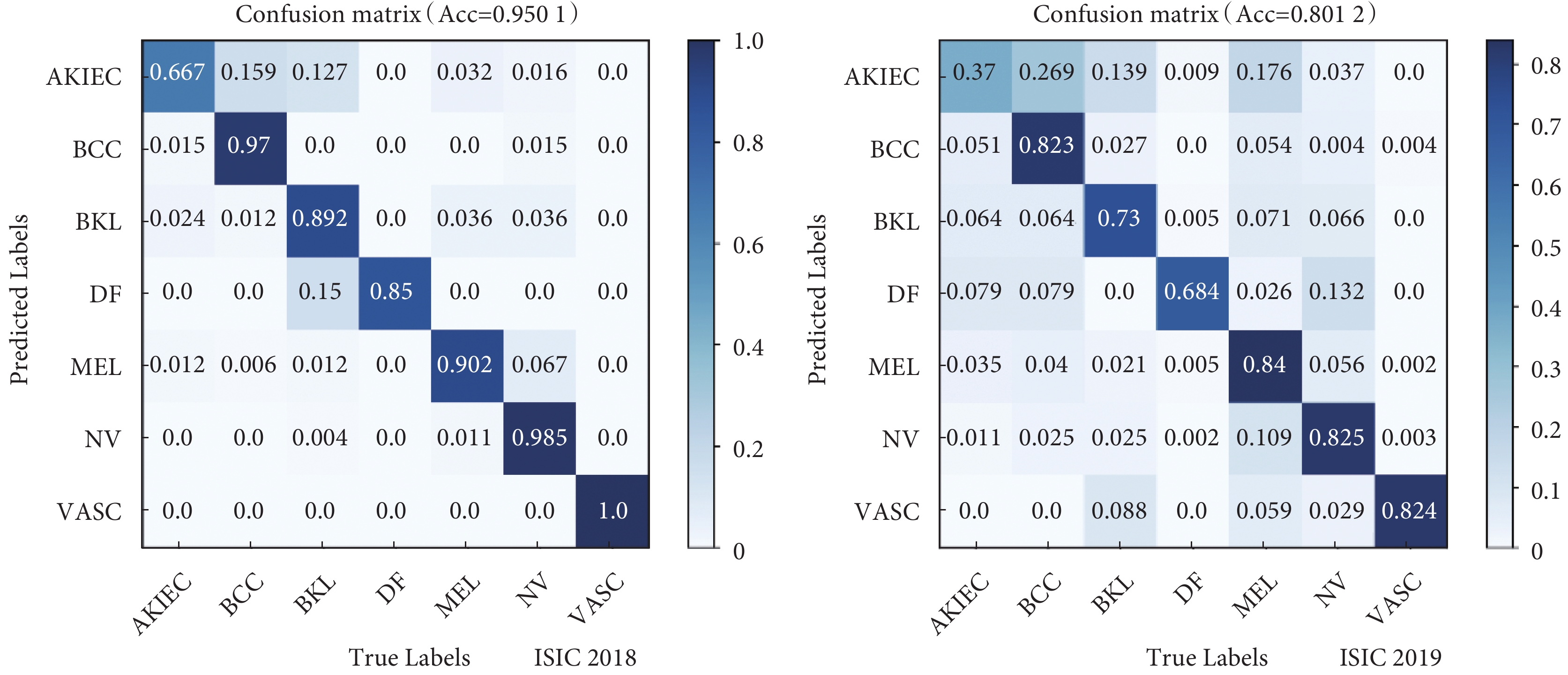

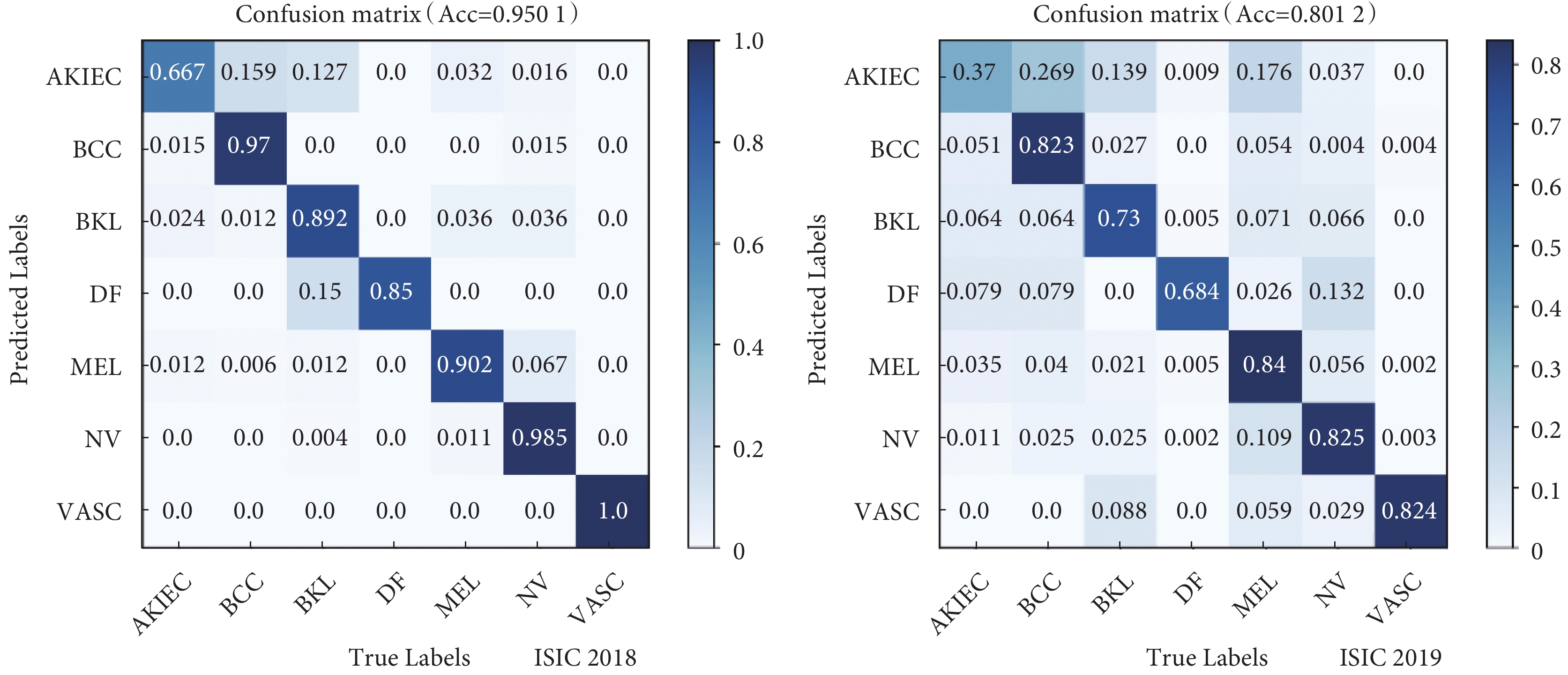

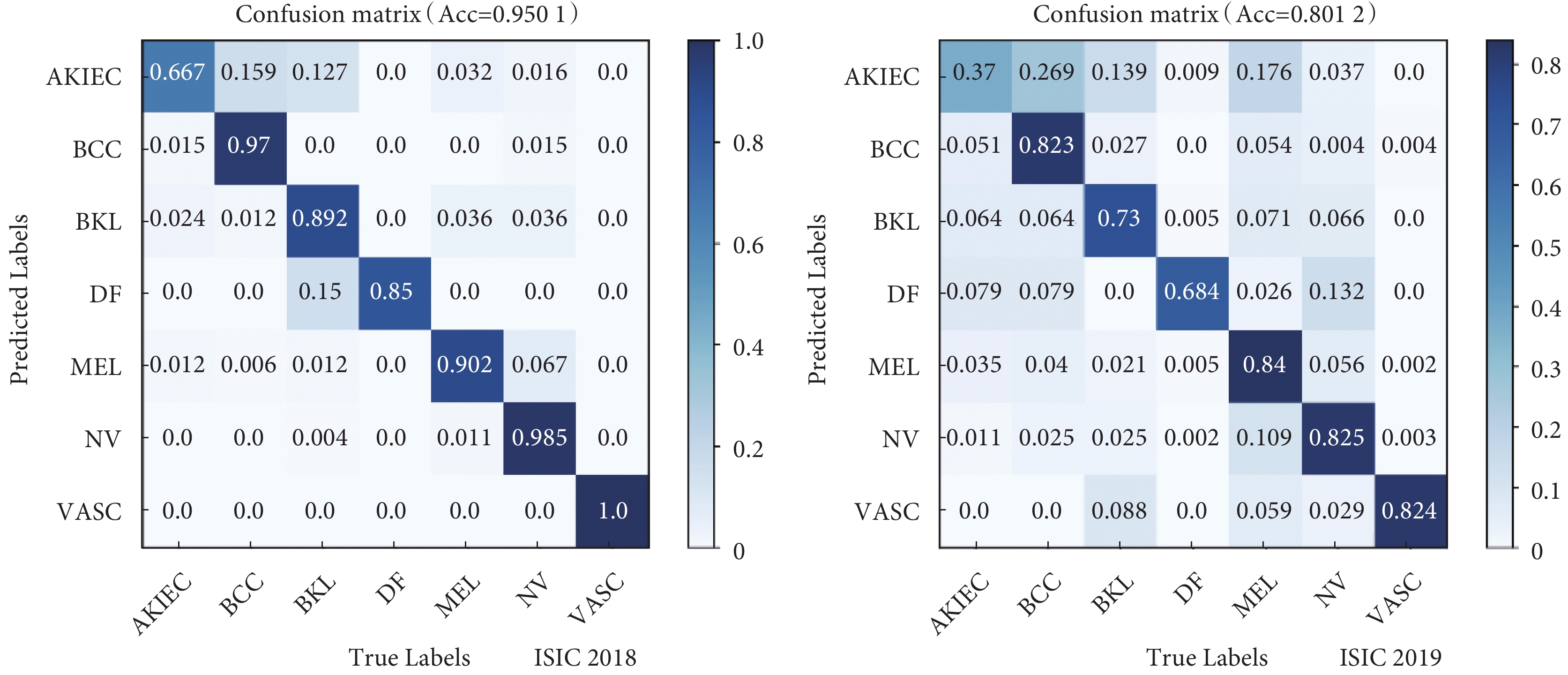

2.5 模型交叉實驗對比

為了驗證模型的泛化性能,本文采用兩個數據集進行相互交叉訓練和測試,實驗結果如圖6所示。在ISIC-2018和ISIC-2019測試集中,本文模型的準確率分別為95.01%和80.12%。值得注意的是,ISIC-2019數據集包含了25 331張圖像,而ISIC-2018僅包含了10 015張圖像,ISIC-2019中數據更為全面和多樣,從而導致ISIC-2019中測試準確率僅為80.12%,而ISIC-2018中準確率為95.01%。由此可見,本文模型在數據足夠豐富的情況下,具有較高的泛化性。

圖6

ISIC2018、ISIC2019數據集交叉測試混淆矩陣

Figure6.

Cross-test confusion matrix in ISIC2018 and ISIC2019 datasets

圖6

ISIC2018、ISIC2019數據集交叉測試混淆矩陣

Figure6.

Cross-test confusion matrix in ISIC2018 and ISIC2019 datasets

2.6 性能對比

為了評估本文模型的分類性能,我們使用浮點運算量、參數量和幀率三個指標,并與Swin-T和ConvNeXt模型進行了比較(見表4)。結果顯示,本文模型未達到Swin-T和ConvNeXt模型的性能水平。但是,結合前文結果,本文模型在準確率方面明顯優于Swin-T和ConvNeXt。考慮到當前大模型訓練的趨勢,犧牲一部分性能以換取更高的準確率是合理的。對于皮膚病變圖像分類任務,本文模型每秒處理44張圖像,顯著超越了傳統分類方法,同時保持了準確性,為實時應用提供了強大的支持。

2.7 與其他論文結果對比

表5展示了本文模型與其他皮膚病變分類模型[19-27]的準確率對比。從表中可以明顯看出,本文模型在皮膚病變圖像分類中取得了最佳的準確率,彰顯它在該領域具有卓越性能。

3 結論

關于皮膚病變圖像計算輔助分類問題,本文提出了S-C-MAHF算法。本算法采用分層的ConvNeXt和Swin-T編碼器,分別用于提取病變圖像的局部特征和全局特征。隨后,通過MLSA與MLCA對多尺度局部和全局特征進行進一步的處理,以捕捉空間與通道特征之間的關系。通過引入注意力機制,使得模型能夠動態地捕捉跨層次的信息,更有效地提取圖像的全局和局部特征。最終,通過HIRF進行多尺度特征融合,以實現對病變圖像的準確分類。在圖像預處理階段,我們采用圖像增強技術來提高皮膚病變圖像的多樣性,防止模型過擬合。同時,通過均衡采樣策略調整病變圖像輸入的差異性,解決不平衡數據集的問題。實驗結果表明,以準確率、精確率、召回率和F1值為評價指標,本文提出的算法在ISIC2018和ISIC2019數據集上取得了顯著的分類成果。準確率分別為96.01%和92.79%,F1值分別為93.11%和90.15%。與最新的皮膚病變圖像分類網絡相比,本文算法表現出一定的提升。研究表明,采用本文算法在皮膚病變圖像分類任務中能夠獲得更為準確的結果,具有對皮膚鏡圖像進行診斷的潛在應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:王澤彤負責方法和算法設計以及論文的撰寫;張俊華負責實驗評估和論文審校;王肖負責資料收集和數據整理。

0 引言

皮膚癌是一種常見且危害巨大的惡性腫瘤,其發病率逐年增加[1]。常見的皮膚病變包括8種類型,其中,黑色素痣(melanocytic nevus,NV)、良性角化病(seborrheic keratosis,BKL)、光化性角化病(actinic keratosis/early intraepidermal carcinoma,AKEIC)、血管源性病變(vascular lesion,VASC)和皮膚纖維瘤(dermatofibroma,DF)屬于良性病變;而黑色素瘤(melanoma,MEL)、基底細胞癌(basal cell carcinoma,BCC)則為惡性病變。惡性黑色素瘤危害是最嚴重的,每年僅在美國就導致10 000人死亡。早期發現可通過簡單手術治愈,但晚期診斷會面臨更高的死亡風險。臨床上皮膚鏡檢查是一種有效手段,可檢測黑色素瘤和其他色素性皮膚病變。專業醫生可通過皮膚鏡圖像外觀和形態特征區分不同病變類型,然而其主觀性和可變性可能導致誤診和漏診[2]。

為應對皮膚病的誤診和漏診問題,計算機輔助診斷技術正逐漸成為主流。傳統方法通常涉及病變區域的分割、特征提取和分類。Celebi等[3]利用基于閾值分的分割算法和支持向量機(support vector machines,SVM)分類器,取得了良好的效果。Ganster等[4]采用ABCD準則提取特征,將黑色素瘤的識別準確率提高至85%~91%,明顯改善了早期識別能力。隨著深度卷積神經網絡(convolutional neural networks,CNN)的興起,它在自然圖像分類中表現出色,在醫學圖像分析中的應用也日益凸顯。Yu等[5]使用深度CNN成功識別黑色素瘤,平均準確率達到85.5%。Codella等[6]結合稀疏編碼、深度學習和SVM,將3類皮膚病變圖像分類的準確率提升至93.1%。Esteva等[7]采用遷移學習和微調Inception V3,對三類皮膚病變圖像進行分類,精度達到71.2%。Kawahara等[8]使用預訓練的AlexNet網絡進行黑色素瘤檢測,準確率達到85.8%。盡管CNN能提取重要局部特征信息,但在提取全局特征方面存在局限。Ayas等[9]將Swin-T與遷移學習結合,成功地在ISIC-2019數據集中識別出8種皮膚病變類型,準確率達到82.3%。

本文提出了一種基于Swin-T[10]與ConvNeXt[11]多級注意力逐級融合(Swin-T–ConvNeXt multi-level attention hierarchical fusion,S-C-MAHF)模型用于皮膚病變分類。采用分層Swin-T與ConvNeXt分別提取全局與局部特征,并提出殘差通道注意力(residual channel attention,Res-CA)與殘差空間注意力(residual spatial attention,Res-SA)模塊進一步提取有效特征;利用多級注意力機制(multi-level attention,MLA)對多尺度全局與局部特征進行處理;針對淺層特征因離分類器較遠而丟失的問題,采用逐級聚合的思想,提出逐級倒置殘差融合(hierarchical inverted residual fusion,HIRF)模塊動態調整提取的特征信息。該算法旨在解決現有皮膚病變分類方法在精度和難度上的瓶頸問題,為醫生準確診斷皮膚病變程度提供可靠的分析支持。

1 算法描述

S-C-MAHF結構如圖1所示。該模型由分層ConvNeXt、分層Swin-T、MLA和HIRF組成。分層Swin-T和ConvNeXt編碼器采用遷移學習方法,使用在Image-21K數據集中預訓練的權重。MLA包含多級空間注意力(multi-level spatial attention,MLSA)和多級通道注意力(multi-level channel attention,MLCA)兩個模塊,MLSA通過Res-SA動態調整局部特征圖之間的權重,加強皮膚病變特征空間位置的提取,而MLCA則利用Res-CA在全局特征圖之間動態調整權重,加強皮膚病變特征通道之間的聯系。HIRF通過逐級融合多尺度特征的方法,實現皮膚病變特征的融合。

圖1

網絡整體結構圖

Figure1.

Overall network structure diagram

圖1

網絡整體結構圖

Figure1.

Overall network structure diagram

1.1 殘差注意力

在皮膚病變分類中,同一類型的皮膚病變之間存在顯著的特征差異,包括大小、形狀、顏色和紋理等方面。為了增強網絡對皮膚病變圖像特征的學習能力,本文引入了空間注意力(spatial attention,SA)[12]和通道注意力(channel attention,CA),以突出重要信息并抑制次要信息。因此,本文設計了Res-SA和Res-CA,分別用于對ConvNeXt和Swin-T提取的多尺度特征進行進一步的提取,以提高模型對皮膚病變區域的關注度。由于CNN網絡主要關注輸入圖像的局部特征,本文通過SA對局部特征進行加權處理,以提高對病變區域的關注度,并引入殘差結構以加速網絡收斂速度和防止梯度消失。而Transformer網絡提取的全局特征主要關注整體圖像特征,因此本文通過CA對全局特征進行增強,調節不同通道特征之間的權重,將更多的關注力集中在更重要的特征通道上,同時也引入殘差結構。Res-SA與Res-CA如圖2所示。Res-SA公式見式(1):

圖2

殘差空間注意力(左)和殘差通道注意力(右)

Figure2.

Residual spatial attention (Left) and residual channel attention (Right)

圖2

殘差空間注意力(左)和殘差通道注意力(右)

Figure2.

Residual spatial attention (Left) and residual channel attention (Right)

|

Res-CA公式見式(2):

|

1.2 多級注意力

在皮膚病變圖像分類中,專業醫生通常手動提取兩種特征:粗略特征(如大小、形狀、顏色變化和邊緣)和細節特征(如紋理、血管模式、結構組織和光環效應)。本文模型利用CNN和Transformer分別提取局部和全局特征,每類特征都包括四種不同尺度的信息。為增強粗略特征提取,采用MLCA對多尺度局部特征進行多層次自適應處理;為增強細節特征提取,引入MLSA對多尺度全局特征進行多層次自適應處理,提高病變特征區域清晰度。MLCA和MLSA的具體處理過程如圖1所示,為皮膚病變圖像分類提供了更全面且準確的特征表達。

1.3 逐級倒置殘差融合塊

在皮膚病變圖像分析中,高分辨率特征圖和低分辨率特征圖展現出各自獨特的特性。高分辨率特征圖涵蓋了豐富的空間細節特征,能夠更準確地定位皮膚病變的區域;而低分辨率特征圖則包含更深層次的語義信息,有助于識別病變的嚴重程度。因此,在皮膚病變圖像分析任務中,我們可以充分發揮這兩種特征圖的優勢,以獲得更為準確的結果和更出色的性能。由于本模型采用了ConvNeXt與Swin-T分別提取全局特征與局部特征,并隨后采用分級編碼結構輸出多尺度特征,因而能夠更全面地捕捉和表達皮膚病變的復雜特征,提高了特征表示的豐富性和準確性。為了有效融合多尺度的全局與局部特征,本文提出了HIRF模塊,其結構如圖3(右)所示。HIRF先使用拼接操作對同級別的全局與局部特征進行拼接;接著采用倒置殘差模塊[13](inverted residual block,IRB)對特征進行融合并降低通道數,IRB如圖3(左)所示;最后,通過下采樣操作將融合后的特征與下一級特征拼接在一起。

圖3

逐級倒置殘差融合塊

Figure3.

Hierarchical inverted residual fusion

圖3

逐級倒置殘差融合塊

Figure3.

Hierarchical inverted residual fusion

1.4 焦點損失函數及均衡采樣策略

不同皮膚病變類型的發病率存在顯著差異,導致圖像數據不均衡,模型在訓練中可能偏向于常見類型。為解決這一問題,我們采用焦點損失函數[14]和均衡采樣策略,用以提高模型性能。損失函數公式如式(3)所示,類別采樣率如表1所示。

|

其中,Pt是第t類預測樣本的概率,αt和γ是超參數。本文設定αt設為1,γ設置為2。

2 實驗結果及分析

2.1 實驗環境、數據集及評價標準

本實驗采用Python 3.7和PyTorch 1.10進行編程。實驗設備包括CPU(64 GB)和GPU(NVIDIA GeForce RTX 3090,24 GB顯存)。訓練過程中,初始學習率設為1e-4,當準確率達到0.80時衰減至1e-5。為防止過擬合,引入了L2正則化,設置權重衰減系數為0.000 2。實驗使用了國際皮膚成像協會(International Skin Imaging Collaboration,ISIC)2018[15]和2019[16]年的公開數據集,按0.80∶0.05∶0.15的比例劃分為訓練集、驗證集和測試集。我們評估了四個常見的多分類任務評價指標:準確率(Acc)、精確率(Pre)、召回率(Recall)和F1值,并與最先進的模型進行了比較分析。

2.2 消融實驗

本節詳細分析了所提出模型各個模塊在皮膚病變分類性能中的貢獻,包括分層ConvNeXt編碼器、分層Swin-T編碼器、MLSA、MLCA、HIRF以及損失函數。本文在ISIC2018和ISIC2019數據集中對這些模塊進行了消融研究。

本研究總共設計七種不同的模塊組合進行實驗,具體如下:M1為分層ConvNeXt編碼器,不添加任何模塊;M2在M1的基礎上添加了MLSA;M3為分層Swin-T編碼器,不添加任何模塊;M4在M3的基礎上添加了MLCA;M5為M2與M4融合共同提取特征,對于全局特征與局部特征的融合采用簡單的拼接操作與下采樣操作;M6在M5的基礎上使用了HIRF融合全局與局部特征;M7在M6的基礎上使用Focal Loss作為損失函數,即本文提出的方法。消融實驗結果如表2所示,最優值加粗表示。MLSA和MLCA對多尺度局部與全局特征分級處理,使得模型更深入地關注皮膚病變圖像的關鍵信息,從而顯著提升了模型的準確率與F1值;Swin-T與ConvNeXt的結合,不僅提取了皮膚病變的大小、顏色等基本特征,還捕捉了皮膚病變的紋理、血管等細微特征,提升了模型的準確率,同時也權衡了Pre與Recall值;HIRF有效聚合多尺度上下文信息,進一步提升了模型的準確率與F1值。消融實驗驗證了本文所提模塊的有效性和所提方法的合理性。

2.3 可視化分析

2.3.1 熱力圖分析

表2的數據顯示,本文所提出的模型在ISIC2018和ISIC2019兩個數據集中均取得了顯著的性能提升。具體而言,在準確率、精確度、召回率和F1值方面,相較于ConvNeXt,分別取得了2.87%、4.96%、3.96%、4.54%和3.45%、7.27%、3.19%、5.30%的提升;而與Swin-T相比,分別取得了3.60%、8.84%、7.08%、8.22%和1.66%、1.81%、5.53%、4.05%的提升。數據分析進一步證明了本文提出的模型在皮膚病變圖像分類任務上的卓越性能。為了深入研究各個模塊的功能,我們在研究中采用了可視化熱力圖進行更詳細的分析。針對8種皮膚病變圖像,通過模型選取IRB2、IRB3和IRB4提取的特征圖進行可視化分析,結果如圖4所示。

圖4

HIRF各層特征熱力圖

Figure4.

Heatmap of various layers' feature in HIRF

圖4

HIRF各層特征熱力圖

Figure4.

Heatmap of various layers' feature in HIRF

在BCC圖像中,由于皮膚病變區域受毛發的嚴重干擾,特別是在IRB2層面,影響較為顯著。然而,隨著特征層級的逐漸加深,這種干擾逐漸減少,IRB4層已經明顯地關注到了皮膚病變區域。而在MEL、SCC和BKL圖像中,由于皮膚病變區域受到皮膚顏色的影響,導致在IRB2層面難以有效提取到病變特征,但在IRB3與IRB4中,模型逐漸成功提取到了皮膚病變的特征。

總體而言,在皮膚病變特征的提取過程中,本文模型呈現出由淺層到深層逐漸提取皮膚病變特征的趨勢。與此同時,通過引入Swin-T,模型能夠捕獲到皮膚病變遠距離特征之間的聯系,最終實現了對皮膚病變的準確分類。這一過程的綜合效果在不同類型的皮膚病變圖像中均得到體現,為醫學圖像領域的進一步研究提供了有益的啟示。

2.3.2 混淆矩陣

如表2所示,本文模型在ISIC2018和ISIC2019測試集上分別取得了96.01%和92.79%的準確率,為了深入揭示本文模型在各個皮膚病變類別上的分類性能,通過混淆矩陣進行了可視化分析(見圖5)。混淆矩陣的結果清晰地展示了本文模型在不同皮膚病變類別上的分類表現,其中對角線值反映了皮膚病變的分類準確率,而非對角線值則表示被錯誤標記為其他樣本的比例。

圖5

ISIC2018、ISIC2019數據集分類結果混淆矩陣

Figure5.

Confusion matrix of classification results in ISIC2018 and ISIC2019 datasets

圖5

ISIC2018、ISIC2019數據集分類結果混淆矩陣

Figure5.

Confusion matrix of classification results in ISIC2018 and ISIC2019 datasets

2.4 對比實驗

為了全面評估本文提出的模型在皮膚鏡圖像分類任務中的性能,將之與DenseNet121[17]、DenseNet201[17]、ResNet101[18]、ResNet152[18]、ConvNeXt,Swin-T等方法進行了對比,并獲得了各種方法的量化指標,結果如表3所示。在兩個數據集上,本文模型的準確率、精確率、召回率和F1值均取得了最優成績。高準確率通常表明分類模型在整體樣本中的正確分類比例較高,即模型在整個樣本中分類準確性較為顯著。然而,準確率并不能充分反映模型的全面性能,尤其在數據集類別存在不平衡的情況下。相反,高召回率意味著模型能夠有效捕獲正例樣本,最大限度地減少漏檢的發生。在醫學圖像分類等領域,對于重要的陽性樣本,高召回率至關重要,因為它表示模型能夠及時識別出存在病變的情況,降低漏檢的風險。以上性能指標充分證明了本文模型在皮膚病變圖像分類任務中表現卓越,具備準確而可靠的分類能力。

2.5 模型交叉實驗對比

為了驗證模型的泛化性能,本文采用兩個數據集進行相互交叉訓練和測試,實驗結果如圖6所示。在ISIC-2018和ISIC-2019測試集中,本文模型的準確率分別為95.01%和80.12%。值得注意的是,ISIC-2019數據集包含了25 331張圖像,而ISIC-2018僅包含了10 015張圖像,ISIC-2019中數據更為全面和多樣,從而導致ISIC-2019中測試準確率僅為80.12%,而ISIC-2018中準確率為95.01%。由此可見,本文模型在數據足夠豐富的情況下,具有較高的泛化性。

圖6

ISIC2018、ISIC2019數據集交叉測試混淆矩陣

Figure6.

Cross-test confusion matrix in ISIC2018 and ISIC2019 datasets

圖6

ISIC2018、ISIC2019數據集交叉測試混淆矩陣

Figure6.

Cross-test confusion matrix in ISIC2018 and ISIC2019 datasets

2.6 性能對比

為了評估本文模型的分類性能,我們使用浮點運算量、參數量和幀率三個指標,并與Swin-T和ConvNeXt模型進行了比較(見表4)。結果顯示,本文模型未達到Swin-T和ConvNeXt模型的性能水平。但是,結合前文結果,本文模型在準確率方面明顯優于Swin-T和ConvNeXt。考慮到當前大模型訓練的趨勢,犧牲一部分性能以換取更高的準確率是合理的。對于皮膚病變圖像分類任務,本文模型每秒處理44張圖像,顯著超越了傳統分類方法,同時保持了準確性,為實時應用提供了強大的支持。

2.7 與其他論文結果對比

表5展示了本文模型與其他皮膚病變分類模型[19-27]的準確率對比。從表中可以明顯看出,本文模型在皮膚病變圖像分類中取得了最佳的準確率,彰顯它在該領域具有卓越性能。

3 結論

關于皮膚病變圖像計算輔助分類問題,本文提出了S-C-MAHF算法。本算法采用分層的ConvNeXt和Swin-T編碼器,分別用于提取病變圖像的局部特征和全局特征。隨后,通過MLSA與MLCA對多尺度局部和全局特征進行進一步的處理,以捕捉空間與通道特征之間的關系。通過引入注意力機制,使得模型能夠動態地捕捉跨層次的信息,更有效地提取圖像的全局和局部特征。最終,通過HIRF進行多尺度特征融合,以實現對病變圖像的準確分類。在圖像預處理階段,我們采用圖像增強技術來提高皮膚病變圖像的多樣性,防止模型過擬合。同時,通過均衡采樣策略調整病變圖像輸入的差異性,解決不平衡數據集的問題。實驗結果表明,以準確率、精確率、召回率和F1值為評價指標,本文提出的算法在ISIC2018和ISIC2019數據集上取得了顯著的分類成果。準確率分別為96.01%和92.79%,F1值分別為93.11%和90.15%。與最新的皮膚病變圖像分類網絡相比,本文算法表現出一定的提升。研究表明,采用本文算法在皮膚病變圖像分類任務中能夠獲得更為準確的結果,具有對皮膚鏡圖像進行診斷的潛在應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:王澤彤負責方法和算法設計以及論文的撰寫;張俊華負責實驗評估和論文審校;王肖負責資料收集和數據整理。