計算機斷層成像(CT)是肺腺癌診斷與評估的重要工具,利用CT圖像預測肺腺癌患者手術后的無復發生存期(RFS)對于術后治療方案的制定具有重要意義。針對CT圖像的肺腺癌RFS精準預測難題,本文提出了一種基于自監督預訓練和多任務學習的肺腺癌RFS預測方法。采用“圖像變換—圖像恢復”的自監督學習策略,在公開肺部CT數據集上對3D-UNet網絡進行自監督預訓練解析肺部圖像的通用視覺特征,通過分割與分類的多任務學習策略進一步優化網絡特征提取能力,引導網絡提取與RFS相關的圖像特征,同時設計多尺度特征聚合模塊以充分聚合多尺度的圖像特征,最后借助前饋神經網絡預測肺腺癌RFS風險評分。通過十折交叉驗證評估所提方法的預測性能。結果顯示,所提方法預測RFS的一致性指數(C-index)與預測三年內是否復發的曲線下面積(AUC)分別達到0.691 ± 0.076與0.707 ± 0.082,預測性能優于現有方法。綜上,本研究所提方法在肺腺癌患者RFS預測方面表現出潛在的優越性,有望為個體化治療方案的制定提供可靠依據。

引用本文: 胡倫瑜, 夏威, 李瓊, 高欣. 基于自監督預訓練和多任務學習的肺腺癌無復發生存期預測. 生物醫學工程學雜志, 2024, 41(2): 205-212. doi: 10.7507/1001-5515.202309060 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

0 引言

肺癌是我國發病數最高的惡性腫瘤[1],其中,肺腺癌是肺癌中最常見的組織學類型,占40%~45%[2]。手術切除是肺腺癌首選的治療手段,但術后復發風險較高[3]。肺腺癌患者術后無復發生存期(recurrence-free survival,RFS)的精準預測,可為臨床制定個體化術后隨訪與治療方案提供重要依據[4],提高患者生存率。

計算機斷層掃描(computed tomography,CT)是肺腺癌診斷與評估的重要工具,包含了關聯RFS的影像特征[5]。Xie等[6]利用影像組學方法,從CT圖像的腫瘤區域提取一階統計特征、形狀特征、紋理特征構建了肺腺癌RFS預測模型。然而,影像組學特征提取依賴于腫瘤區域的人工精細勾畫[6-9],這不僅費時費力且可重復性不高,不利于成果的臨床推廣應用;此外,影像組學方法依賴手工設計的特征,特征提取挖掘的信息有限[10],難以實現RFS的精準預測。

與影像組學相比,深度學習方法無需勾畫腫瘤區域,利用神經網絡從影像數據中自動提取針對特定任務的深層圖像特征,減少人工干預的同時,可提升模型準確度[11-13]。深度學習方法通常采用端到端的模型訓練策略,但RFS屬于生存類數據[14],存在較多的刪失(患者隨訪期內未復發或失訪),致使有確切生存時間的樣本較少,難以為端到端的模型訓練提供充足的數據支撐。部分研究將RFS預測簡化為分類任務[15-17],但這種策略僅能二分類預測患者在某一時間點內是否復發,所建模型的臨床價值極為有限。為了解決這一問題,研究者們先采用預訓練的神經網絡模型提取圖像特征,然后借助可利用刪失數據的Cox比例風險(Cox proportional hazard,CPH)模型[18]預測RFS。在基于神經網絡預訓練的圖像特征提取方面,Baek等[19]利用腫瘤分割任務對UNet網絡進行預訓練,然后提取網絡瓶頸層中的圖像特征,然而僅基于分割任務的預訓練會使網絡過度關注腫瘤邊界信息,忽略包含潛在生存預測信息的瘤內與瘤周區域;Liu等[20]利用二維(two-dimensional,2D)自然圖像數據集ImageNet對VGG-19網絡進行預訓練,然后提取CT圖像切片中的圖像特征,但自然圖像與CT圖像具有明顯差異,預訓練模型既無法理解腫瘤解剖結構,也無法挖掘腫瘤整體的三維(three-dimensional,3D)圖像特征[21]。此外,CPH模型屬于廣義線性模型,僅能對輸入特征進行線性組合,無法擬合CT圖像特征與RFS間可能存在的復雜非線性關系,導致其預測準確度受限。

針對現有研究的不足,本文提出一種基于自監督預訓練和多任務學習的肺腺癌RFS預測方法。首先,將3D-UNet作為骨干網絡,利用公開的肺部CT數據集進行自監督預訓練,使網絡充分理解肺部CT圖像中腫瘤3D解剖結構;利用分割與分類結合的多任務學習策略優化網絡的特征提取能力:腫瘤分割任務使網絡有效關注腫瘤區域,并利用包含腫瘤和瘤周的全局圖像預測與RFS相關的腫瘤病理高低危類別,引導網絡提取與RFS相關的全局圖像特征;然后,設計多尺度特征聚合模塊充分聚合來自不同網絡層的圖像特征;最后,基于CPH模型和前饋神經網絡,設計了一種具有非線性擬合能力的RFS預測網絡,以聚合特征為輸入預測RFS的風險評分。

1 數據與預處理

1.1 數據來源

本文收集了2010年至2018年間在中山大學腫瘤防治中心(中心1)以及中山大學附屬第一醫院(中心2)接受手術切除的924名T0-1期肺腺癌患者數據,其中773例患者來自中心1,151例患者來自中心2。每例患者的數據包括術前肺部CT圖像與隨訪信息。術前肺部CT圖像層厚為0.70~1.50 mm;通過門診記錄和電話訪談進行隨訪,收集患者RFS與復發狀態。在患者術后兩年內每三個月進行一次隨訪,之后每年進行一次隨訪。對于在隨訪期間發生復發轉移的患者,其RFS定義為發生復發轉移的日期與手術日期之間的時間間隔;對于信息刪失的患者,其RFS為最后一次隨訪的日期與手術日期之間的時間間隔。中心1患者的RFS范圍為69~3 547天(中位時間為1 869天),復發人數為143人(18.5%);中心2患者的RFS范圍為403~3 583天(中位時間為1 583天),復發人數為43人(28.5%)。為了獲得CT影像中腫瘤區域的標注模板,首先采用深度學習分割模型nnUNet[22]對腫瘤進行自動的粗分割,再由具有14年經驗的放射科醫生使用MITK 2022.04軟件修正自動分割結果。此外,根據患者術后或術中冷凍切片的病理評估結果確定腫瘤病理高低危分組:將預后較好[23]的非典型腺瘤性增生、原位腺癌、微浸潤性腺癌與貼壁型為主的浸潤性腺癌劃分為低危組,將其他類型劃分為高危組。

本文使用十折交叉驗證對所提方法進行評估。將整體數據集平均劃分為十組,在每次驗證中,使用其中的九組作為訓練集,剩余一組作為測試集,如此循環十次保證所有患者數據都經過獨立測試,最終報道測試的平均結果。

1.2 數據預處理

首先,為了解決不同CT圖像間的各向異性問題,利用線性插值將圖像的體素尺寸統一重采樣為1 mm × 1 mm × 1 mm。然后,為了降低骨骼、胸壁的干擾以及提高圖像的對比度,對圖像強度值進行窗寬窗位調整,將強度值裁剪至[?1 024, 400]。為了提高模型穩定性和加快訓練收斂速度,通過線性歸一化操作將圖像強度值歸一化至[0, 1]。最后,從每一例CT圖像中基于腫瘤標注模板計算的腫瘤中心點裁剪32 × 32 × 32的圖像塊作為網絡的輸入。

2 方法

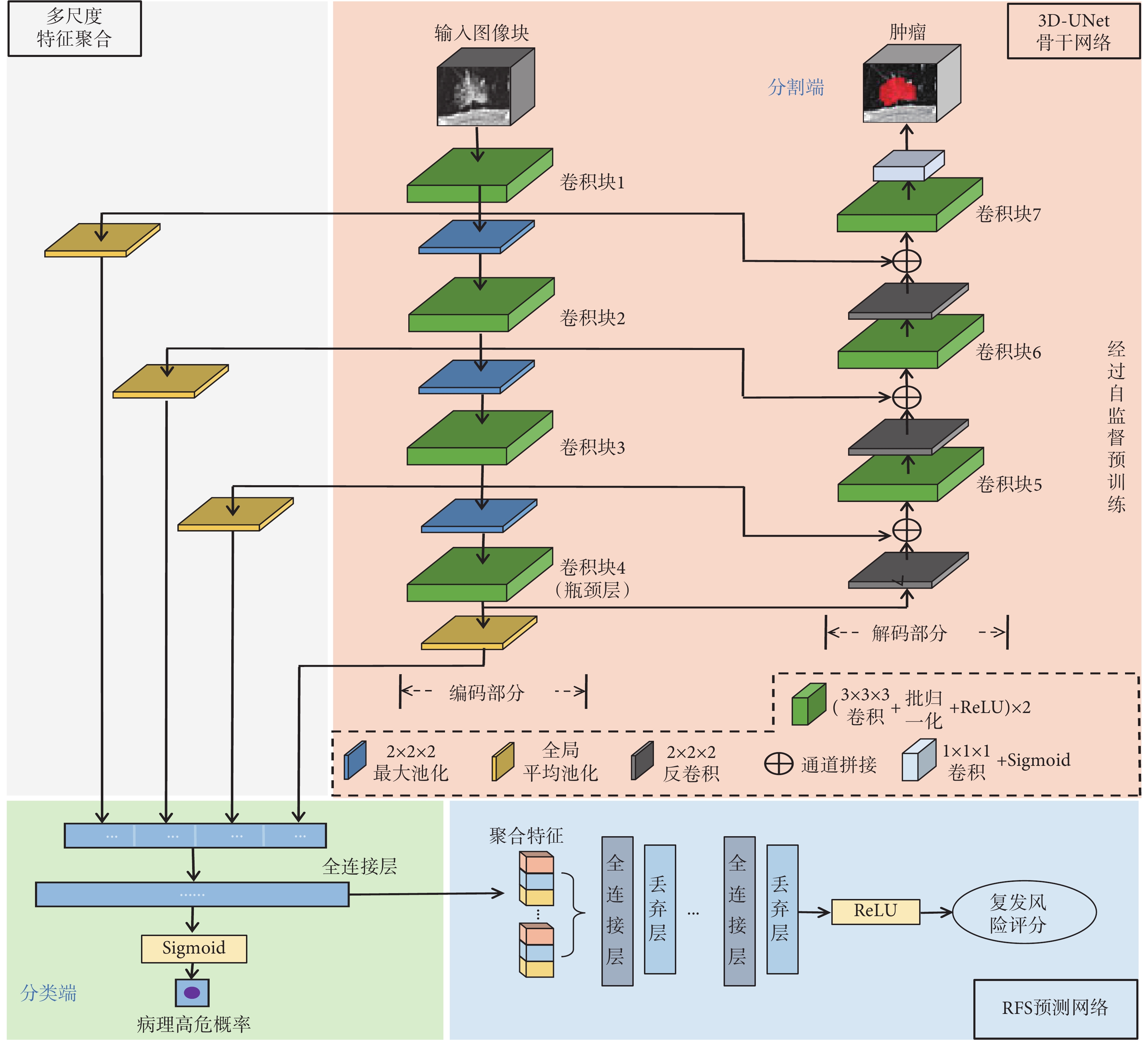

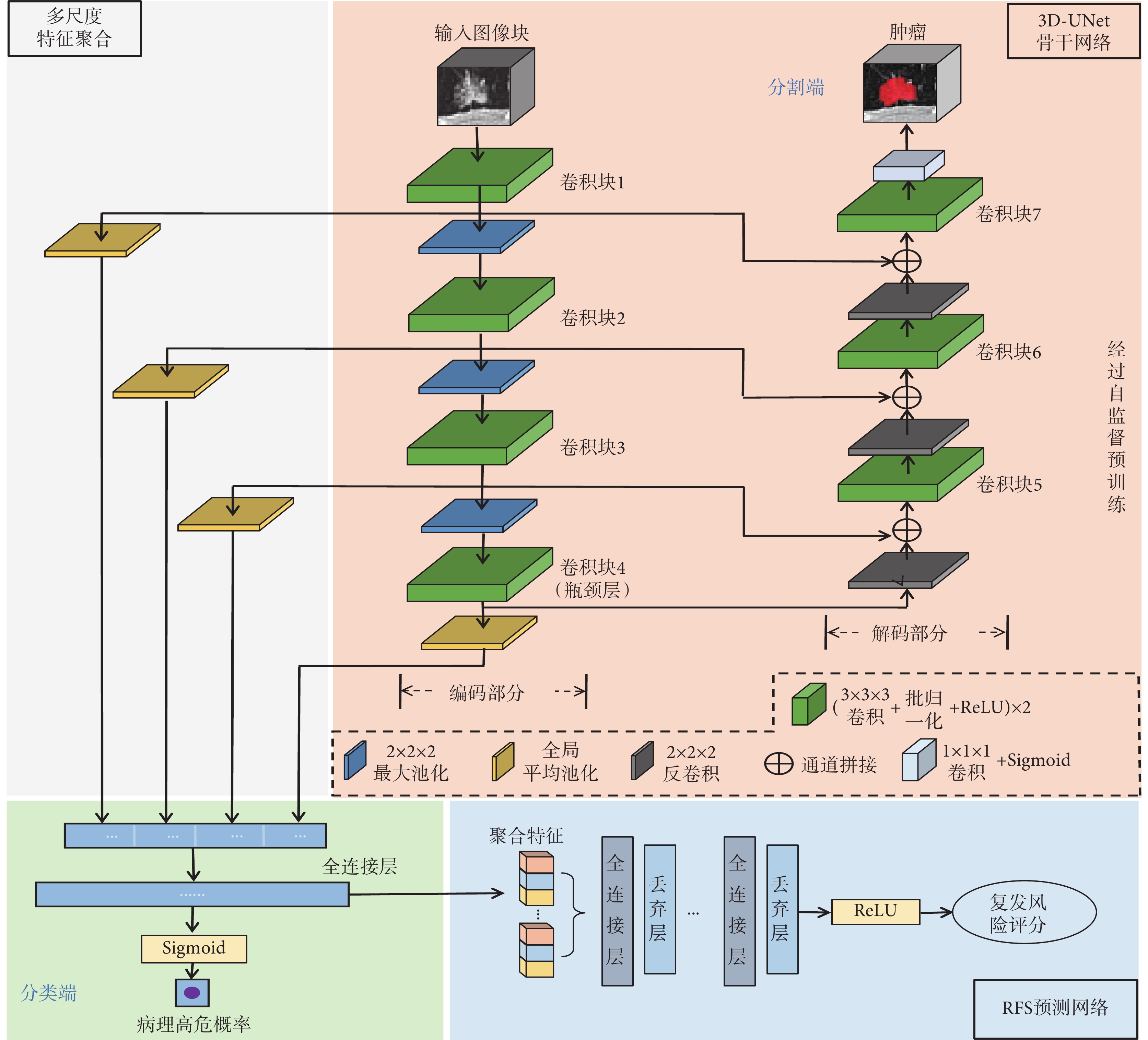

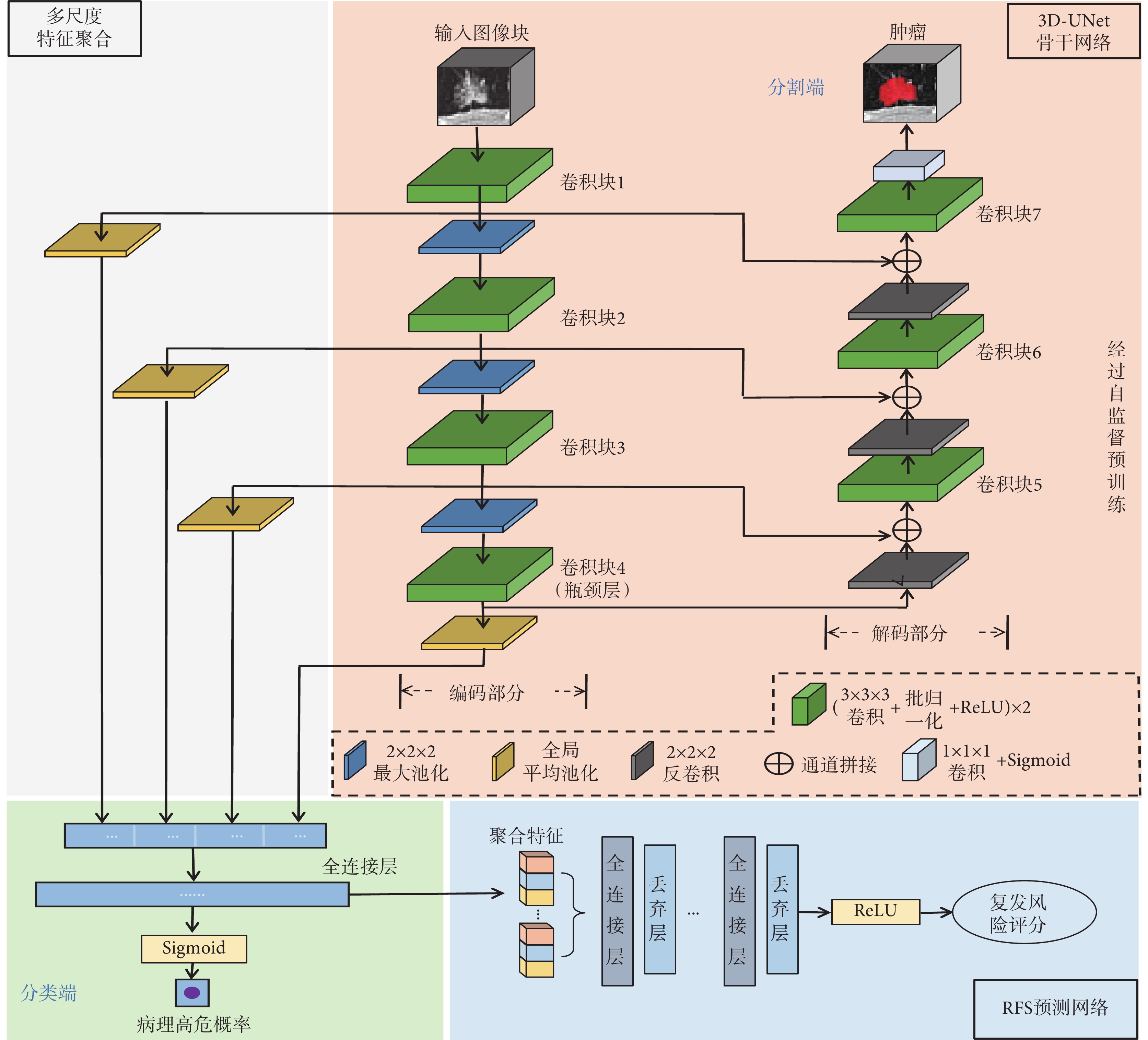

本文提出的肺腺癌RFS預測方法整體框架與網絡結構如圖1所示。圖像輸入經自監督預訓練的3D-UNet骨干網絡后,在網絡的分類和分割端分別輸出病理分類和腫瘤分割結果實現多任務學習,從而提取與RFS相關的圖像特征。將來自網絡不同層次的圖像特征通過多尺度特征聚合模塊進行聚合,然后輸入RFS預測網絡以輸出最終的復發風險評分。

圖1

所提方法的整體框架與網絡結構

Figure1.

Overall framework and network structure of the proposed method

圖1

所提方法的整體框架與網絡結構

Figure1.

Overall framework and network structure of the proposed method

2.1 自監督預訓練

自監督預訓練可以通過設定合理的學習目標,有效地利用大量無標注數據訓練網絡,使網絡學習數據中與特定任務通用的特征信息,從而提升下游任務收益[24]。針對圖像類數據,“模型起源”(models genesis,MG)方法[25]采取了“圖像變換—圖像恢復”的自監督學習思路,將無標注的3D圖像本身作為標簽,訓練3D-UNet網絡恢復經過復雜變換的圖像,從中學習到圖像通用的視覺特征信息。因此,本文利用MG方法在公開肺部數據集上對3D-UNet網絡進行自監督預訓練,通過肺部CT圖像的恢復任務,使網絡解析肺部CT圖像中常見的解剖結構,從而提升網絡對肺部圖像的特征提取能力,作為本文后續RFS精準預測的基礎。

自監督預訓練具體流程圖見附件1。首先,在每一例預處理后的完整肺部CT圖像中,隨機裁剪32個能夠反映肺部解剖結構信息的(包含肺組織并且不包含空氣)、尺寸為32 × 32 × 32的圖像塊作為原始圖像塊。每一個原始圖像塊x經過一系列圖像變換操作得到變換圖像塊  ,再利用圖像恢復網絡對其恢復得到恢復圖像塊

,再利用圖像恢復網絡對其恢復得到恢復圖像塊  。利用量化恢復圖像塊

。利用量化恢復圖像塊  與原始圖像塊x差異的損失函數

與原始圖像塊x差異的損失函數  訓練網絡,使之具備將變換后圖像塊

訓練網絡,使之具備將變換后圖像塊  恢復為原始圖像塊x的能力。

恢復為原始圖像塊x的能力。

圖像變換部分共包含四種操作:強度值非線性變換、局部像素重排、內部掩碼變換、外部掩碼變換。對每一個輸入圖像塊采用隨機的不同變換方式組合得到更加多樣的變換,增加網絡恢復圖像的難度,使網絡從圖像的外觀、紋理、上下文等多個角度得到訓練,進而學習全面的肺部解剖結構特征。各項變換操作的具體細節見附件2。

圖像恢復部分采用3D-UNet網絡對經過復雜變換的圖像進行恢復。訓練中通過優化損失函數使網絡獲得圖像恢復能力,由于均方誤差(mean squared error,MSE)損失的計算量小,適用于大型數據集的訓練,因此本文以MSE損失作為圖像恢復任務的損失函數,計算過程如下:

|

其中, 為圖像塊中的體素數量,

為圖像塊中的體素數量, 為體素的真實強度值,

為體素的真實強度值, 為對應的體素經網絡所恢復出的強度值。

為對應的體素經網絡所恢復出的強度值。

為了保證網絡從自監督學習中獲得的特征提取能力的泛化性,本文自監督預訓練在肺結節檢測競賽(Lung Nodule Analysis 2016,LUNA16)公開數據集[26]上進行。LUNA16數據集共納入888例圖像層厚為0.60~2.50 mm的肺部CT圖像,并劃分出了若干子集,本文將其中0~4號子集作為預訓練的訓練集,將5~6號子集作為驗證集。

2.2 分割與分類多任務學習

將自監督預訓練后的3D-UNet作為骨干網絡進行分割和分類的多任務學習,進一步優化網絡對肺部圖像的特征提取能力:腫瘤分割任務使網絡有效關注腫瘤區域,降低骨骼及肺部其他組織的干擾;與RFS高度相關的腫瘤高低危分類[23]任務引導網絡挖掘與RFS相關的圖像特征。

圖像輸入骨干網絡后,分別在分割端與分類端輸出腫瘤分割與病理分類的結果,具體網絡結構如圖1所示。骨干網絡由編碼、解碼部分組成。編碼部分包含四個卷積塊(卷積塊1~4),其輸出通道數由64逐步翻倍至512,塊之間連接2 × 2 × 2步長為2的最大池化層以進行特征圖下采樣,每個塊內包括兩個3 × 3 × 3卷積,每個卷積后連接批歸一化層(batch normalization,BN)以及ReLU激活層。Baek等[19]的研究證明,預訓練后的3D-UNet網絡瓶頸層(卷積塊4)匯聚了豐富的生存信息,因此該研究使用了瓶頸層的圖像特征進行后續的生存期預測。然而,網絡瓶頸層的圖像特征屬于深層特征,雖然包含充分的全局信息并具有較強的語義表達能力,但分辨率較低,對肺部空間幾何細節信息的表征較弱;而網絡編碼部分的淺層網絡層的圖像特征雖然感受野較小,但其分辨率較高,幾何細節信息表征能力強。為了充分利用網絡中不同層次的圖像特征,本文提出多尺度特征聚合模塊,將來自瓶頸層與編碼部分三個淺層卷積塊(卷積塊1~3)的圖像特征聚合后再進行病理高低危分類以及后續的RFS預測。由于該模塊與編碼部分相連,額外的復雜卷積設計不僅會影響骨干網絡從自監督預訓練中獲得的學習能力,還會增加過擬合風險,因此本文對該模塊進行輕量化設計,模塊僅由三個全局平均池化層組成,其結構如圖1所示。首先對于編碼部分不同層次的每一個卷積塊,將其長、寬、高、通道數分別為w、h、l、n的特征圖  通過全局平均池化(global average pooling,GAP)壓縮至長度為n的一維特征映射

通過全局平均池化(global average pooling,GAP)壓縮至長度為n的一維特征映射  ,具體計算過程如下:

,具體計算過程如下:

|

然后將各層特征圖的一維特征映射進行串聯拼接,并通過兩個維度分別為1 024和1的全連接層與Sigmoid激活層,在分類端輸出患者為病理高危的預測概率。網絡的解碼部分包含三個與編碼部分相同結構的卷積塊(卷積塊5~7),輸出通道數由512逐步減半至64。每個卷積塊之前,特征圖由2 × 2 × 2步長為2的反卷積進行上采樣,然后與編碼部分中尺寸相同的對應層特征圖進行通道拼接,最終通過1 × 1 × 1卷積與Sigmoid激活層在分割端輸出腫瘤分割結果。

本文多任務學習的損失函數由分割任務損失、分類任務損失兩部分構成。首先,利用Dice Loss作為分割任務的損失函數,具體計算過程如下:

|

其中 是網絡預測分割結果,

是網絡預測分割結果, 是標準分割結果。其次,在分類任務中,由于一般的二分類交叉熵損失函數難以克服本文不同類間樣本數量嚴重不均衡及易學習樣本占比過大的問題,本文利用Focal Loss[27]作為損失函數進行優化,計算過程如下:

是標準分割結果。其次,在分類任務中,由于一般的二分類交叉熵損失函數難以克服本文不同類間樣本數量嚴重不均衡及易學習樣本占比過大的問題,本文利用Focal Loss[27]作為損失函數進行優化,計算過程如下:

|

其中 是平衡正負樣本占比的權重因子,正樣本的權重為

是平衡正負樣本占比的權重因子,正樣本的權重為 ,負樣本的權重為

,負樣本的權重為 ;

; 是聚焦因子,用以降低易學習樣本的損失貢獻,增加難學習樣本的損失比例;

是聚焦因子,用以降低易學習樣本的損失貢獻,增加難學習樣本的損失比例; 是網絡預測當前樣本為正樣本的概率,范圍在0~1之間。因此綜上,本文多任務學習的損失函數為:

是網絡預測當前樣本為正樣本的概率,范圍在0~1之間。因此綜上,本文多任務學習的損失函數為:

|

2.3 基于特征非線性擬合的RFS預測

RFS預測屬于生存分析任務,RFS是生存數據,存在數據刪失情況,需要同時考慮復發狀態以及復發時間,因此傳統回歸方法無法對RFS進行預測。現有研究常使用CPH模型進行生存分析,然而真實的醫學數據通常難以滿足CPH模型對特征的線性比例假設,這會導致其預測準確性和泛化性較差,因此本文基于前饋神經網絡構建具有非線性擬合能力的RFS預測網絡以提高RFS預測性能。網絡以聚合特征作為輸入,通過各神經元節點的權重和ReLU激活層確定輸入特征與輸出復發風險之間的復雜非線性關系,具體結構如圖1所示。網絡由若干隱層組成,每個隱層首先包含一個全連接層,后接丟棄層(Dropout)減少神經元個數避免過擬合。通過網格超參搜索法確定網絡最終由四個隱層組成,神經元節點數分別為32、8、8、1。

RFS預測網絡訓練所用損失函數由兩部分組成。首先,使用負對數平均似然函數[28]  作為損失的主要部分,其計算過程如下:

作為損失的主要部分,其計算過程如下:

|

其中  為網絡輸出的復發風險評分,

為網絡輸出的復發風險評分, 為在時間點

為在時間點  內發生復發轉移的患者數量,

內發生復發轉移的患者數量, 表示在時間點

表示在時間點  尚未發生復發轉移的患者的集合。為了控制網絡復雜度,防止過擬合,增加

尚未發生復發轉移的患者的集合。為了控制網絡復雜度,防止過擬合,增加  正則化懲罰項:

正則化懲罰項:

|

其中  是正則化系數,

是正則化系數, 是網絡權重。綜上,進行RFS預測時網絡所用損失函數為:

是網絡權重。綜上,進行RFS預測時網絡所用損失函數為:

|

3 實驗結果與分析

3.1 評價指標

本文采用一致性指數(concordance index,C-index)評價RFS預測性能,其數值越大代表預測越準確。部分算法僅能對患者是否在某一時間點內復發進行二分類預測,如預測三年RFS(即預測患者在三年內是否復發)。為了對比,本文也利用所提方法預測三年RFS,并使用受試者工作特征曲線(receiver operating characteristic curve,ROC)下的面積(area under curve,AUC)作為評估指標。

3.2 實驗環境與設置

本文在Ubuntu 20.05(Canonical Inc.,美國)操作系統的深度學習框架PyTorch 1.10(Facebook Inc.,美國)上進行深度神經網絡的訓練,計算機具體配置為:顯卡(NVIDIA GeForce RTX 3090 Ti,Nvidia Inc.,美國)、中央處理器器(Intel Xeon Silver 4210 CPU,Inter Inc.,美國)。自監督預訓練、多任務學習與RFS預測訓練環節中的具體超參設置見附件3。

3.3 對比實驗結果

為了驗證所提方法的性能,本文將所提方法與基于影像組學的Xie等[6]和基于深度學習的Hosny等[15]、Liu等[20]現有肺腺癌RFS預測方法進行了對比,預測性能見表1。所提方法的各項指標在十折交叉實驗中取得最優結果:C-index比Xie等[6]的方法提高了0.048,比Liu等[20]的方法提高了0.029;AUC比Hosny等[15]的方法提高了0.048,比Xie等[6]的方法提高了0.045,比Liu等[20]的方法提高了0.024。具體而言,Hosny等[15]的方法僅能對固定時間點的RFS進行預測,臨床應用價值有限,且該方法的AUC結果最低,說明端到端的CNN模型在預測RFS時表現較差。Xie等[6]方法的AUC結果超過上述深度學習方法,證明影像組學方法在肺腺癌RFS預測任務上具有較好的表現,但由于影像組學特征局限于人工勾畫的腫瘤區域,且特征由固定公式計算,忽略了瘤周區域的預測信息,再加上CPH模型無法擬合特征的非線性關系,因此該方法的RFS預測性能仍然有限。Liu等[20]的深度學習方法可實現完整的RFS預測,且C-index與AUC結果皆超過上述方法,說明深度神經網絡可以通過在2D自然圖像數據集上的預訓練來獲得一定的特征提取能力,但由于2D自然圖像數據與3D CT圖像存在區別,提取的特征用以預測RFS性能依舊受限。本研究所提方法通過一系列定制的學習任務有針對性地提高了網絡特征提取能力,并通過前饋神經網絡擬合RFS與特征間的非線性關系,從而克服了上述方法的缺陷,實現了最優的RFS預測性能。

3.4 消融實驗結果

為了驗證所提方法中各策略與模塊的有效性,基于所提完整方法分別構建去除多任務學習(方法1)、去除自監督預訓練(方法2)、去除多尺度特征聚合(方法3)、以“CPH模型”代替RFS預測網絡(方法4)的四種方法進行消融實驗,各方法預測RFS的結果如表2所示。由結果可見,任一策略與模塊的缺失都導致了預測性能的下降,這證明了其有效性,它們協同工作可提高RFS預測性能。

方法1與所提方法的性能差距最為明顯,表明多任務學習對性能提升的貢獻程度最高。為了進一步驗證多任務學習的有效性,本文實現了僅基于腫瘤高低危分類任務引導的RFS預測方法(方法5)。方法5的C-index為0.679 ± 0.078、AUC為0.696 ± 0.085,預測性能低于所提方法,說明相較于分類單任務,分割與分類多任務學習可令網絡更有效地挖掘與RFS相關的特征信息,提高后續RFS預測性能。

3.5 可視化分析

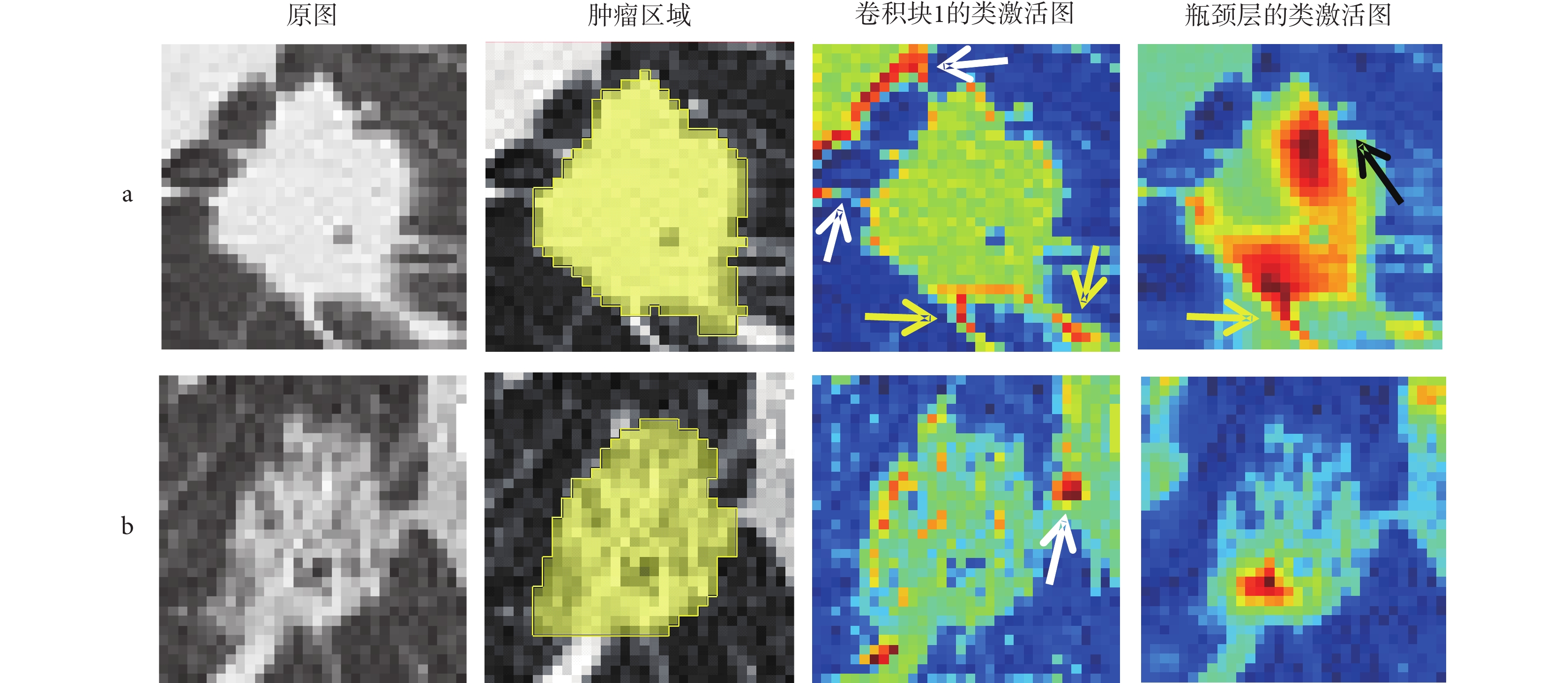

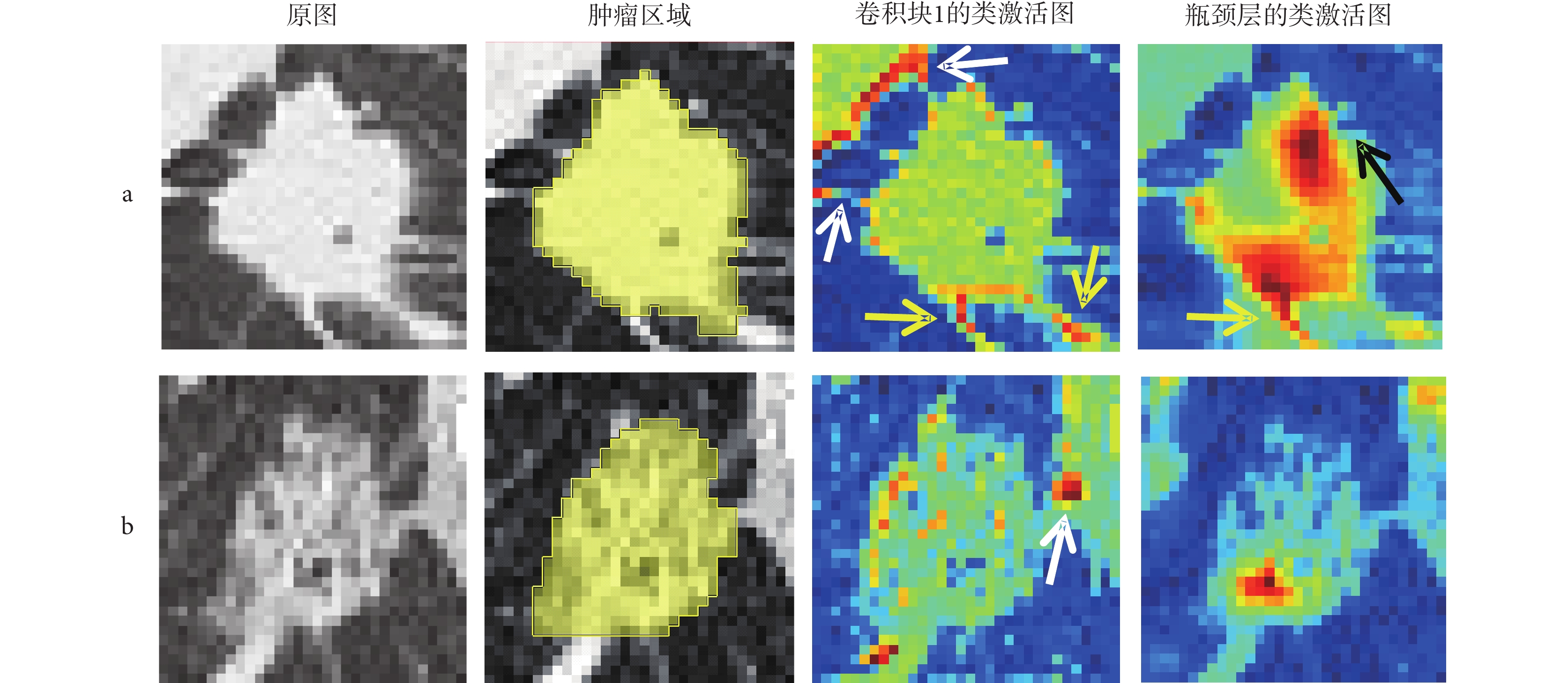

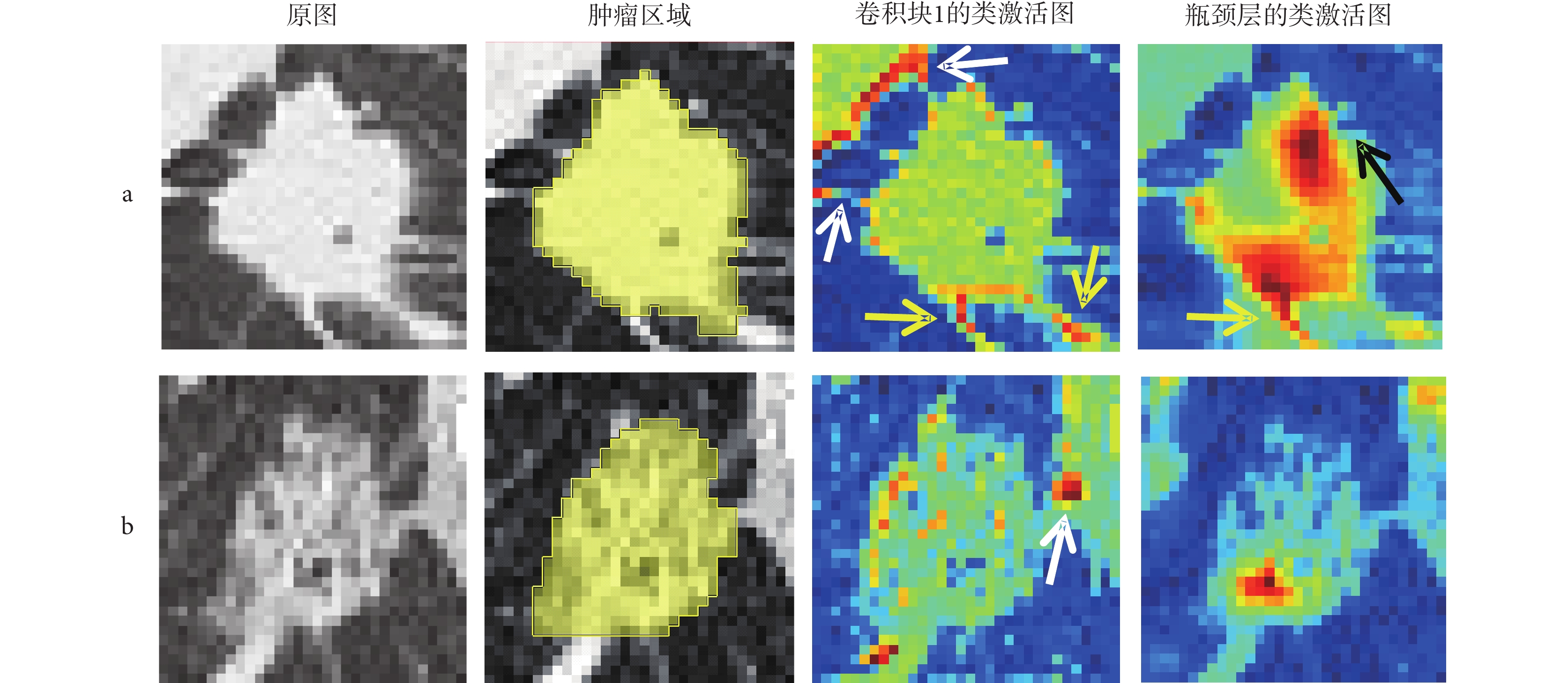

為了進一步展現所提方法的可解釋性,本文使用Grad-CAM方法[29]生成類激活圖(見圖2),視覺強化患者CT圖像中與復發相關的重要區域。圖中2a和2b行分別是隨機選取的一例RFS小于一年的術后早期復發患者和一例隨訪期大于五年且在隨訪期間未復發患者的圖像,各行的第一、二列分別為原始輸入圖像和手工標注的腫瘤區域圖像,第三、四列分別為骨干網絡淺網絡層(卷積塊1)和深網絡層(瓶頸層)輸出的類激活圖,類激活圖中越接近于紅色的高亮表示該區域對網絡分類決策的貢獻越大,白色箭頭指向胸膜牽拉區域,黃色箭頭指向腫瘤的毛刺,黑色箭頭指向腫瘤分葉處。

圖2

兩例不同復發情況患者的圖像

圖2

兩例不同復發情況患者的圖像

a. 術后早期復發患者;b. 術后無復發患者

Figure2. Images of two patients with different recurrence statusa. patient with early postoperative recurrence; b. patient with no postoperative recurrence

在術后早期復發患者的圖像中,腫瘤表現為實性并且伴有毛刺、分葉征以及胸膜牽拉等在早期研究中已被證實與高復發風險相關的征象[30]。在該患者淺網絡層輸出的類激活圖中,高亮區域與腫瘤區域高度重合,表明網絡經過分割任務的訓練后能夠精準識別并定位腫瘤區域,同時,部分高亮區域分布于腫瘤毛刺與胸膜牽拉區域。當網絡層加深到達瓶頸層后腫瘤內部高亮區域大面積加深,進一步集中至毛刺與分葉處,表明網絡能夠重點關注與高復發風險相關的腫瘤征象信息,這與臨床實踐相符。在無復發患者的圖像中,腫瘤表現為低風險的磨玻璃狀,且雖然該腫瘤與胸膜存在連接,但磨玻璃狀的腫瘤難以造成高危害的胸膜侵犯[31]。在該患者淺、深層網絡輸出的類激活圖中,腫瘤邊緣、內部和與胸膜連接處高亮的面積占比遠小于術后早期復發患者的情況,說明網絡從圖像中獲取的與高復發風險相關的信息少,這與該患者實際的良好術后情況相符。綜上所述,所提方法的可視化結果直觀地說明了該方法自動挖掘CT圖像中與復發相關信息的過程具有高度的臨床可解釋性,對不同復發情況的患者具有良好的區分性能。

此外,由圖2可知不同深度的網絡層包含著不同類型的信息,相較于Baek等[19]僅利用單一的瓶頸層特征進行RFS預測,本文設計的多尺度特征聚合模塊可充分聚合來自不同網絡層的多尺度圖像特征。并且,類激活圖中腫瘤周邊組織的高亮說明了瘤周區域同樣蘊含預測信息,所提方法的圖像輸入方式可充分利用該部分信息,這也有助于預測性能的提高。

4 結論

本文提出了一種全新的肺腺癌RFS預測方法,結合自監督預訓練與多任務學習策略深入挖掘與RFS相關的CT圖像特征,再利用多尺度特征融合模塊充分聚合多尺度的包含不同信息的圖像特征,最后設計了一種具有非線性擬合能力的RFS預測網絡,利用聚合特征完成RFS預測。本文通過消融實驗證明了所提方法中各策略與模塊的有效性,并通過與相關研究的對比實驗證明了所提方法在預測準確性與泛化性方面超越了現有的肺腺癌RFS預測方法,有望為肺腺癌患者個體化治療方案的制定提供有效依據,具有較高的臨床應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:胡倫瑜負責本文算法程序設計、結果記錄分析以及論文撰寫;夏威負責實驗指導、數據分析指導以及論文審閱修訂;李瓊負責本文工作的臨床指導;高欣負責論文審閱修訂與總體指導。

倫理聲明:本研究通過了中山大學腫瘤防治中心倫理委員會的審批(批文編號:B2022-293-01)。

本文附件見本刊網站的電子版本(biomedeng.cn)。

0 引言

肺癌是我國發病數最高的惡性腫瘤[1],其中,肺腺癌是肺癌中最常見的組織學類型,占40%~45%[2]。手術切除是肺腺癌首選的治療手段,但術后復發風險較高[3]。肺腺癌患者術后無復發生存期(recurrence-free survival,RFS)的精準預測,可為臨床制定個體化術后隨訪與治療方案提供重要依據[4],提高患者生存率。

計算機斷層掃描(computed tomography,CT)是肺腺癌診斷與評估的重要工具,包含了關聯RFS的影像特征[5]。Xie等[6]利用影像組學方法,從CT圖像的腫瘤區域提取一階統計特征、形狀特征、紋理特征構建了肺腺癌RFS預測模型。然而,影像組學特征提取依賴于腫瘤區域的人工精細勾畫[6-9],這不僅費時費力且可重復性不高,不利于成果的臨床推廣應用;此外,影像組學方法依賴手工設計的特征,特征提取挖掘的信息有限[10],難以實現RFS的精準預測。

與影像組學相比,深度學習方法無需勾畫腫瘤區域,利用神經網絡從影像數據中自動提取針對特定任務的深層圖像特征,減少人工干預的同時,可提升模型準確度[11-13]。深度學習方法通常采用端到端的模型訓練策略,但RFS屬于生存類數據[14],存在較多的刪失(患者隨訪期內未復發或失訪),致使有確切生存時間的樣本較少,難以為端到端的模型訓練提供充足的數據支撐。部分研究將RFS預測簡化為分類任務[15-17],但這種策略僅能二分類預測患者在某一時間點內是否復發,所建模型的臨床價值極為有限。為了解決這一問題,研究者們先采用預訓練的神經網絡模型提取圖像特征,然后借助可利用刪失數據的Cox比例風險(Cox proportional hazard,CPH)模型[18]預測RFS。在基于神經網絡預訓練的圖像特征提取方面,Baek等[19]利用腫瘤分割任務對UNet網絡進行預訓練,然后提取網絡瓶頸層中的圖像特征,然而僅基于分割任務的預訓練會使網絡過度關注腫瘤邊界信息,忽略包含潛在生存預測信息的瘤內與瘤周區域;Liu等[20]利用二維(two-dimensional,2D)自然圖像數據集ImageNet對VGG-19網絡進行預訓練,然后提取CT圖像切片中的圖像特征,但自然圖像與CT圖像具有明顯差異,預訓練模型既無法理解腫瘤解剖結構,也無法挖掘腫瘤整體的三維(three-dimensional,3D)圖像特征[21]。此外,CPH模型屬于廣義線性模型,僅能對輸入特征進行線性組合,無法擬合CT圖像特征與RFS間可能存在的復雜非線性關系,導致其預測準確度受限。

針對現有研究的不足,本文提出一種基于自監督預訓練和多任務學習的肺腺癌RFS預測方法。首先,將3D-UNet作為骨干網絡,利用公開的肺部CT數據集進行自監督預訓練,使網絡充分理解肺部CT圖像中腫瘤3D解剖結構;利用分割與分類結合的多任務學習策略優化網絡的特征提取能力:腫瘤分割任務使網絡有效關注腫瘤區域,并利用包含腫瘤和瘤周的全局圖像預測與RFS相關的腫瘤病理高低危類別,引導網絡提取與RFS相關的全局圖像特征;然后,設計多尺度特征聚合模塊充分聚合來自不同網絡層的圖像特征;最后,基于CPH模型和前饋神經網絡,設計了一種具有非線性擬合能力的RFS預測網絡,以聚合特征為輸入預測RFS的風險評分。

1 數據與預處理

1.1 數據來源

本文收集了2010年至2018年間在中山大學腫瘤防治中心(中心1)以及中山大學附屬第一醫院(中心2)接受手術切除的924名T0-1期肺腺癌患者數據,其中773例患者來自中心1,151例患者來自中心2。每例患者的數據包括術前肺部CT圖像與隨訪信息。術前肺部CT圖像層厚為0.70~1.50 mm;通過門診記錄和電話訪談進行隨訪,收集患者RFS與復發狀態。在患者術后兩年內每三個月進行一次隨訪,之后每年進行一次隨訪。對于在隨訪期間發生復發轉移的患者,其RFS定義為發生復發轉移的日期與手術日期之間的時間間隔;對于信息刪失的患者,其RFS為最后一次隨訪的日期與手術日期之間的時間間隔。中心1患者的RFS范圍為69~3 547天(中位時間為1 869天),復發人數為143人(18.5%);中心2患者的RFS范圍為403~3 583天(中位時間為1 583天),復發人數為43人(28.5%)。為了獲得CT影像中腫瘤區域的標注模板,首先采用深度學習分割模型nnUNet[22]對腫瘤進行自動的粗分割,再由具有14年經驗的放射科醫生使用MITK 2022.04軟件修正自動分割結果。此外,根據患者術后或術中冷凍切片的病理評估結果確定腫瘤病理高低危分組:將預后較好[23]的非典型腺瘤性增生、原位腺癌、微浸潤性腺癌與貼壁型為主的浸潤性腺癌劃分為低危組,將其他類型劃分為高危組。

本文使用十折交叉驗證對所提方法進行評估。將整體數據集平均劃分為十組,在每次驗證中,使用其中的九組作為訓練集,剩余一組作為測試集,如此循環十次保證所有患者數據都經過獨立測試,最終報道測試的平均結果。

1.2 數據預處理

首先,為了解決不同CT圖像間的各向異性問題,利用線性插值將圖像的體素尺寸統一重采樣為1 mm × 1 mm × 1 mm。然后,為了降低骨骼、胸壁的干擾以及提高圖像的對比度,對圖像強度值進行窗寬窗位調整,將強度值裁剪至[?1 024, 400]。為了提高模型穩定性和加快訓練收斂速度,通過線性歸一化操作將圖像強度值歸一化至[0, 1]。最后,從每一例CT圖像中基于腫瘤標注模板計算的腫瘤中心點裁剪32 × 32 × 32的圖像塊作為網絡的輸入。

2 方法

本文提出的肺腺癌RFS預測方法整體框架與網絡結構如圖1所示。圖像輸入經自監督預訓練的3D-UNet骨干網絡后,在網絡的分類和分割端分別輸出病理分類和腫瘤分割結果實現多任務學習,從而提取與RFS相關的圖像特征。將來自網絡不同層次的圖像特征通過多尺度特征聚合模塊進行聚合,然后輸入RFS預測網絡以輸出最終的復發風險評分。

圖1

所提方法的整體框架與網絡結構

Figure1.

Overall framework and network structure of the proposed method

圖1

所提方法的整體框架與網絡結構

Figure1.

Overall framework and network structure of the proposed method

2.1 自監督預訓練

自監督預訓練可以通過設定合理的學習目標,有效地利用大量無標注數據訓練網絡,使網絡學習數據中與特定任務通用的特征信息,從而提升下游任務收益[24]。針對圖像類數據,“模型起源”(models genesis,MG)方法[25]采取了“圖像變換—圖像恢復”的自監督學習思路,將無標注的3D圖像本身作為標簽,訓練3D-UNet網絡恢復經過復雜變換的圖像,從中學習到圖像通用的視覺特征信息。因此,本文利用MG方法在公開肺部數據集上對3D-UNet網絡進行自監督預訓練,通過肺部CT圖像的恢復任務,使網絡解析肺部CT圖像中常見的解剖結構,從而提升網絡對肺部圖像的特征提取能力,作為本文后續RFS精準預測的基礎。

自監督預訓練具體流程圖見附件1。首先,在每一例預處理后的完整肺部CT圖像中,隨機裁剪32個能夠反映肺部解剖結構信息的(包含肺組織并且不包含空氣)、尺寸為32 × 32 × 32的圖像塊作為原始圖像塊。每一個原始圖像塊x經過一系列圖像變換操作得到變換圖像塊  ,再利用圖像恢復網絡對其恢復得到恢復圖像塊

,再利用圖像恢復網絡對其恢復得到恢復圖像塊  。利用量化恢復圖像塊

。利用量化恢復圖像塊  與原始圖像塊x差異的損失函數

與原始圖像塊x差異的損失函數  訓練網絡,使之具備將變換后圖像塊

訓練網絡,使之具備將變換后圖像塊  恢復為原始圖像塊x的能力。

恢復為原始圖像塊x的能力。

圖像變換部分共包含四種操作:強度值非線性變換、局部像素重排、內部掩碼變換、外部掩碼變換。對每一個輸入圖像塊采用隨機的不同變換方式組合得到更加多樣的變換,增加網絡恢復圖像的難度,使網絡從圖像的外觀、紋理、上下文等多個角度得到訓練,進而學習全面的肺部解剖結構特征。各項變換操作的具體細節見附件2。

圖像恢復部分采用3D-UNet網絡對經過復雜變換的圖像進行恢復。訓練中通過優化損失函數使網絡獲得圖像恢復能力,由于均方誤差(mean squared error,MSE)損失的計算量小,適用于大型數據集的訓練,因此本文以MSE損失作為圖像恢復任務的損失函數,計算過程如下:

|

其中, 為圖像塊中的體素數量,

為圖像塊中的體素數量, 為體素的真實強度值,

為體素的真實強度值, 為對應的體素經網絡所恢復出的強度值。

為對應的體素經網絡所恢復出的強度值。

為了保證網絡從自監督學習中獲得的特征提取能力的泛化性,本文自監督預訓練在肺結節檢測競賽(Lung Nodule Analysis 2016,LUNA16)公開數據集[26]上進行。LUNA16數據集共納入888例圖像層厚為0.60~2.50 mm的肺部CT圖像,并劃分出了若干子集,本文將其中0~4號子集作為預訓練的訓練集,將5~6號子集作為驗證集。

2.2 分割與分類多任務學習

將自監督預訓練后的3D-UNet作為骨干網絡進行分割和分類的多任務學習,進一步優化網絡對肺部圖像的特征提取能力:腫瘤分割任務使網絡有效關注腫瘤區域,降低骨骼及肺部其他組織的干擾;與RFS高度相關的腫瘤高低危分類[23]任務引導網絡挖掘與RFS相關的圖像特征。

圖像輸入骨干網絡后,分別在分割端與分類端輸出腫瘤分割與病理分類的結果,具體網絡結構如圖1所示。骨干網絡由編碼、解碼部分組成。編碼部分包含四個卷積塊(卷積塊1~4),其輸出通道數由64逐步翻倍至512,塊之間連接2 × 2 × 2步長為2的最大池化層以進行特征圖下采樣,每個塊內包括兩個3 × 3 × 3卷積,每個卷積后連接批歸一化層(batch normalization,BN)以及ReLU激活層。Baek等[19]的研究證明,預訓練后的3D-UNet網絡瓶頸層(卷積塊4)匯聚了豐富的生存信息,因此該研究使用了瓶頸層的圖像特征進行后續的生存期預測。然而,網絡瓶頸層的圖像特征屬于深層特征,雖然包含充分的全局信息并具有較強的語義表達能力,但分辨率較低,對肺部空間幾何細節信息的表征較弱;而網絡編碼部分的淺層網絡層的圖像特征雖然感受野較小,但其分辨率較高,幾何細節信息表征能力強。為了充分利用網絡中不同層次的圖像特征,本文提出多尺度特征聚合模塊,將來自瓶頸層與編碼部分三個淺層卷積塊(卷積塊1~3)的圖像特征聚合后再進行病理高低危分類以及后續的RFS預測。由于該模塊與編碼部分相連,額外的復雜卷積設計不僅會影響骨干網絡從自監督預訓練中獲得的學習能力,還會增加過擬合風險,因此本文對該模塊進行輕量化設計,模塊僅由三個全局平均池化層組成,其結構如圖1所示。首先對于編碼部分不同層次的每一個卷積塊,將其長、寬、高、通道數分別為w、h、l、n的特征圖  通過全局平均池化(global average pooling,GAP)壓縮至長度為n的一維特征映射

通過全局平均池化(global average pooling,GAP)壓縮至長度為n的一維特征映射  ,具體計算過程如下:

,具體計算過程如下:

|

然后將各層特征圖的一維特征映射進行串聯拼接,并通過兩個維度分別為1 024和1的全連接層與Sigmoid激活層,在分類端輸出患者為病理高危的預測概率。網絡的解碼部分包含三個與編碼部分相同結構的卷積塊(卷積塊5~7),輸出通道數由512逐步減半至64。每個卷積塊之前,特征圖由2 × 2 × 2步長為2的反卷積進行上采樣,然后與編碼部分中尺寸相同的對應層特征圖進行通道拼接,最終通過1 × 1 × 1卷積與Sigmoid激活層在分割端輸出腫瘤分割結果。

本文多任務學習的損失函數由分割任務損失、分類任務損失兩部分構成。首先,利用Dice Loss作為分割任務的損失函數,具體計算過程如下:

|

其中 是網絡預測分割結果,

是網絡預測分割結果, 是標準分割結果。其次,在分類任務中,由于一般的二分類交叉熵損失函數難以克服本文不同類間樣本數量嚴重不均衡及易學習樣本占比過大的問題,本文利用Focal Loss[27]作為損失函數進行優化,計算過程如下:

是標準分割結果。其次,在分類任務中,由于一般的二分類交叉熵損失函數難以克服本文不同類間樣本數量嚴重不均衡及易學習樣本占比過大的問題,本文利用Focal Loss[27]作為損失函數進行優化,計算過程如下:

|

其中 是平衡正負樣本占比的權重因子,正樣本的權重為

是平衡正負樣本占比的權重因子,正樣本的權重為 ,負樣本的權重為

,負樣本的權重為 ;

; 是聚焦因子,用以降低易學習樣本的損失貢獻,增加難學習樣本的損失比例;

是聚焦因子,用以降低易學習樣本的損失貢獻,增加難學習樣本的損失比例; 是網絡預測當前樣本為正樣本的概率,范圍在0~1之間。因此綜上,本文多任務學習的損失函數為:

是網絡預測當前樣本為正樣本的概率,范圍在0~1之間。因此綜上,本文多任務學習的損失函數為:

|

2.3 基于特征非線性擬合的RFS預測

RFS預測屬于生存分析任務,RFS是生存數據,存在數據刪失情況,需要同時考慮復發狀態以及復發時間,因此傳統回歸方法無法對RFS進行預測。現有研究常使用CPH模型進行生存分析,然而真實的醫學數據通常難以滿足CPH模型對特征的線性比例假設,這會導致其預測準確性和泛化性較差,因此本文基于前饋神經網絡構建具有非線性擬合能力的RFS預測網絡以提高RFS預測性能。網絡以聚合特征作為輸入,通過各神經元節點的權重和ReLU激活層確定輸入特征與輸出復發風險之間的復雜非線性關系,具體結構如圖1所示。網絡由若干隱層組成,每個隱層首先包含一個全連接層,后接丟棄層(Dropout)減少神經元個數避免過擬合。通過網格超參搜索法確定網絡最終由四個隱層組成,神經元節點數分別為32、8、8、1。

RFS預測網絡訓練所用損失函數由兩部分組成。首先,使用負對數平均似然函數[28]  作為損失的主要部分,其計算過程如下:

作為損失的主要部分,其計算過程如下:

|

其中  為網絡輸出的復發風險評分,

為網絡輸出的復發風險評分, 為在時間點

為在時間點  內發生復發轉移的患者數量,

內發生復發轉移的患者數量, 表示在時間點

表示在時間點  尚未發生復發轉移的患者的集合。為了控制網絡復雜度,防止過擬合,增加

尚未發生復發轉移的患者的集合。為了控制網絡復雜度,防止過擬合,增加  正則化懲罰項:

正則化懲罰項:

|

其中  是正則化系數,

是正則化系數, 是網絡權重。綜上,進行RFS預測時網絡所用損失函數為:

是網絡權重。綜上,進行RFS預測時網絡所用損失函數為:

|

3 實驗結果與分析

3.1 評價指標

本文采用一致性指數(concordance index,C-index)評價RFS預測性能,其數值越大代表預測越準確。部分算法僅能對患者是否在某一時間點內復發進行二分類預測,如預測三年RFS(即預測患者在三年內是否復發)。為了對比,本文也利用所提方法預測三年RFS,并使用受試者工作特征曲線(receiver operating characteristic curve,ROC)下的面積(area under curve,AUC)作為評估指標。

3.2 實驗環境與設置

本文在Ubuntu 20.05(Canonical Inc.,美國)操作系統的深度學習框架PyTorch 1.10(Facebook Inc.,美國)上進行深度神經網絡的訓練,計算機具體配置為:顯卡(NVIDIA GeForce RTX 3090 Ti,Nvidia Inc.,美國)、中央處理器器(Intel Xeon Silver 4210 CPU,Inter Inc.,美國)。自監督預訓練、多任務學習與RFS預測訓練環節中的具體超參設置見附件3。

3.3 對比實驗結果

為了驗證所提方法的性能,本文將所提方法與基于影像組學的Xie等[6]和基于深度學習的Hosny等[15]、Liu等[20]現有肺腺癌RFS預測方法進行了對比,預測性能見表1。所提方法的各項指標在十折交叉實驗中取得最優結果:C-index比Xie等[6]的方法提高了0.048,比Liu等[20]的方法提高了0.029;AUC比Hosny等[15]的方法提高了0.048,比Xie等[6]的方法提高了0.045,比Liu等[20]的方法提高了0.024。具體而言,Hosny等[15]的方法僅能對固定時間點的RFS進行預測,臨床應用價值有限,且該方法的AUC結果最低,說明端到端的CNN模型在預測RFS時表現較差。Xie等[6]方法的AUC結果超過上述深度學習方法,證明影像組學方法在肺腺癌RFS預測任務上具有較好的表現,但由于影像組學特征局限于人工勾畫的腫瘤區域,且特征由固定公式計算,忽略了瘤周區域的預測信息,再加上CPH模型無法擬合特征的非線性關系,因此該方法的RFS預測性能仍然有限。Liu等[20]的深度學習方法可實現完整的RFS預測,且C-index與AUC結果皆超過上述方法,說明深度神經網絡可以通過在2D自然圖像數據集上的預訓練來獲得一定的特征提取能力,但由于2D自然圖像數據與3D CT圖像存在區別,提取的特征用以預測RFS性能依舊受限。本研究所提方法通過一系列定制的學習任務有針對性地提高了網絡特征提取能力,并通過前饋神經網絡擬合RFS與特征間的非線性關系,從而克服了上述方法的缺陷,實現了最優的RFS預測性能。

3.4 消融實驗結果

為了驗證所提方法中各策略與模塊的有效性,基于所提完整方法分別構建去除多任務學習(方法1)、去除自監督預訓練(方法2)、去除多尺度特征聚合(方法3)、以“CPH模型”代替RFS預測網絡(方法4)的四種方法進行消融實驗,各方法預測RFS的結果如表2所示。由結果可見,任一策略與模塊的缺失都導致了預測性能的下降,這證明了其有效性,它們協同工作可提高RFS預測性能。

方法1與所提方法的性能差距最為明顯,表明多任務學習對性能提升的貢獻程度最高。為了進一步驗證多任務學習的有效性,本文實現了僅基于腫瘤高低危分類任務引導的RFS預測方法(方法5)。方法5的C-index為0.679 ± 0.078、AUC為0.696 ± 0.085,預測性能低于所提方法,說明相較于分類單任務,分割與分類多任務學習可令網絡更有效地挖掘與RFS相關的特征信息,提高后續RFS預測性能。

3.5 可視化分析

為了進一步展現所提方法的可解釋性,本文使用Grad-CAM方法[29]生成類激活圖(見圖2),視覺強化患者CT圖像中與復發相關的重要區域。圖中2a和2b行分別是隨機選取的一例RFS小于一年的術后早期復發患者和一例隨訪期大于五年且在隨訪期間未復發患者的圖像,各行的第一、二列分別為原始輸入圖像和手工標注的腫瘤區域圖像,第三、四列分別為骨干網絡淺網絡層(卷積塊1)和深網絡層(瓶頸層)輸出的類激活圖,類激活圖中越接近于紅色的高亮表示該區域對網絡分類決策的貢獻越大,白色箭頭指向胸膜牽拉區域,黃色箭頭指向腫瘤的毛刺,黑色箭頭指向腫瘤分葉處。

圖2

兩例不同復發情況患者的圖像

圖2

兩例不同復發情況患者的圖像

a. 術后早期復發患者;b. 術后無復發患者

Figure2. Images of two patients with different recurrence statusa. patient with early postoperative recurrence; b. patient with no postoperative recurrence

在術后早期復發患者的圖像中,腫瘤表現為實性并且伴有毛刺、分葉征以及胸膜牽拉等在早期研究中已被證實與高復發風險相關的征象[30]。在該患者淺網絡層輸出的類激活圖中,高亮區域與腫瘤區域高度重合,表明網絡經過分割任務的訓練后能夠精準識別并定位腫瘤區域,同時,部分高亮區域分布于腫瘤毛刺與胸膜牽拉區域。當網絡層加深到達瓶頸層后腫瘤內部高亮區域大面積加深,進一步集中至毛刺與分葉處,表明網絡能夠重點關注與高復發風險相關的腫瘤征象信息,這與臨床實踐相符。在無復發患者的圖像中,腫瘤表現為低風險的磨玻璃狀,且雖然該腫瘤與胸膜存在連接,但磨玻璃狀的腫瘤難以造成高危害的胸膜侵犯[31]。在該患者淺、深層網絡輸出的類激活圖中,腫瘤邊緣、內部和與胸膜連接處高亮的面積占比遠小于術后早期復發患者的情況,說明網絡從圖像中獲取的與高復發風險相關的信息少,這與該患者實際的良好術后情況相符。綜上所述,所提方法的可視化結果直觀地說明了該方法自動挖掘CT圖像中與復發相關信息的過程具有高度的臨床可解釋性,對不同復發情況的患者具有良好的區分性能。

此外,由圖2可知不同深度的網絡層包含著不同類型的信息,相較于Baek等[19]僅利用單一的瓶頸層特征進行RFS預測,本文設計的多尺度特征聚合模塊可充分聚合來自不同網絡層的多尺度圖像特征。并且,類激活圖中腫瘤周邊組織的高亮說明了瘤周區域同樣蘊含預測信息,所提方法的圖像輸入方式可充分利用該部分信息,這也有助于預測性能的提高。

4 結論

本文提出了一種全新的肺腺癌RFS預測方法,結合自監督預訓練與多任務學習策略深入挖掘與RFS相關的CT圖像特征,再利用多尺度特征融合模塊充分聚合多尺度的包含不同信息的圖像特征,最后設計了一種具有非線性擬合能力的RFS預測網絡,利用聚合特征完成RFS預測。本文通過消融實驗證明了所提方法中各策略與模塊的有效性,并通過與相關研究的對比實驗證明了所提方法在預測準確性與泛化性方面超越了現有的肺腺癌RFS預測方法,有望為肺腺癌患者個體化治療方案的制定提供有效依據,具有較高的臨床應用價值。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:胡倫瑜負責本文算法程序設計、結果記錄分析以及論文撰寫;夏威負責實驗指導、數據分析指導以及論文審閱修訂;李瓊負責本文工作的臨床指導;高欣負責論文審閱修訂與總體指導。

倫理聲明:本研究通過了中山大學腫瘤防治中心倫理委員會的審批(批文編號:B2022-293-01)。

本文附件見本刊網站的電子版本(biomedeng.cn)。