相較于以往將靶區作為單獨區域進行自動分割的神經網絡,本文提出了一種利用靶區周圍器官的位置及形狀信息來限定靶區形狀及位置,并通過多個網絡的疊加融合空間位置信息,從而提高醫學圖像自動分割精度的堆疊式神經網絡。本文以格蕾絲眼病為例,基于全卷積神經網絡構建了堆疊式神經網絡,對其左右兩側放療靶區分別進行分割。以醫生手動勾畫結果為標準,計算體積戴斯相似系數(DSC)和雙向豪斯多夫距離(HD)。相較于全卷積神經網絡,堆疊式神經網絡勾畫結果可以使左右兩側體積 DSC 分別提高 1.7% 和 3.4%,同時左右兩側的雙向 HD 距離分別下降 0.6。結果表明,堆疊式神經網絡在提升自動分割結果與手動勾畫靶區重合度的同時,減小了小區域靶區的分割誤差,進一步說明堆疊式神經網絡能有效地提高格蕾絲眼病放療靶區的自動勾畫精度。

引用本文: 蔣家良, 周莉, 何奕松, 姜筱璇, 傅玉川. 利用堆疊式神經網絡提高格蕾絲眼病放療靶區的自動勾畫精度. 生物醫學工程學雜志, 2020, 37(4): 670-675. doi: 10.7507/1001-5515.202002025 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

引言

深度學習(deep learning,DL)作為人工智能增長最為迅速的領域,已經廣泛應用于醫學影像處理之中[1]。對于腫瘤放射治療而言,基于深度學習的放療靶區和正常組織器官的自動勾畫可使醫生避免大量重復的勾畫工作,在提升整個放射治療流程效率的同時,減少觀察者內和觀察者間的誤差。隨著全卷積神經網絡(fully convolutional neural network,FCN)的提出,圖像的語義分割進入像素級的時代[2],FCN 之所以能夠取得較好的自動分割結果,是因為該網絡在對圖像進行卷積的過程之中,提取到了深層次的語義信息以及淺層次的位置信息,將這兩種信息有效地結合則能夠產生較好的分割結果。FCN 中圖像每當經過卷積層、池化層后,其寬、高會變為上一次的 1/2。在經過 5 次之后,圖像寬、高為原圖像的 1/32。此時為了得到與原圖大小相同的輸出特征圖,需要進行 32 倍的上采樣。進行 32 倍上采樣所得網絡為 FCN-32s。若在第四次卷積、池化的基礎上進行 16 倍上采樣則是 FCN-16s,在第 3 次基礎上的進行 8 倍上采樣則是 FCN-8s。在三者中,以 FCN-8s 的勾畫效果最好[2]。在此之后,基于 FCN 的大量神經網絡模型被提出,并用于研究人體正常組織結構的自動分割[3-4]。同時為了提高用于自動分割的神經網絡的精度,大量的研究在 FCN 的基礎上不斷改進網絡結構。其中一種采用了對稱的收縮和擴張路徑的 U 型網絡(U-net)作為這類研究的代表,改變了深淺層信息的融合方法,近年來在生物醫學影像分割領域表現優異[5]。此外,多種醫學影像的結合在圖像分割領域的應用也越發廣泛。

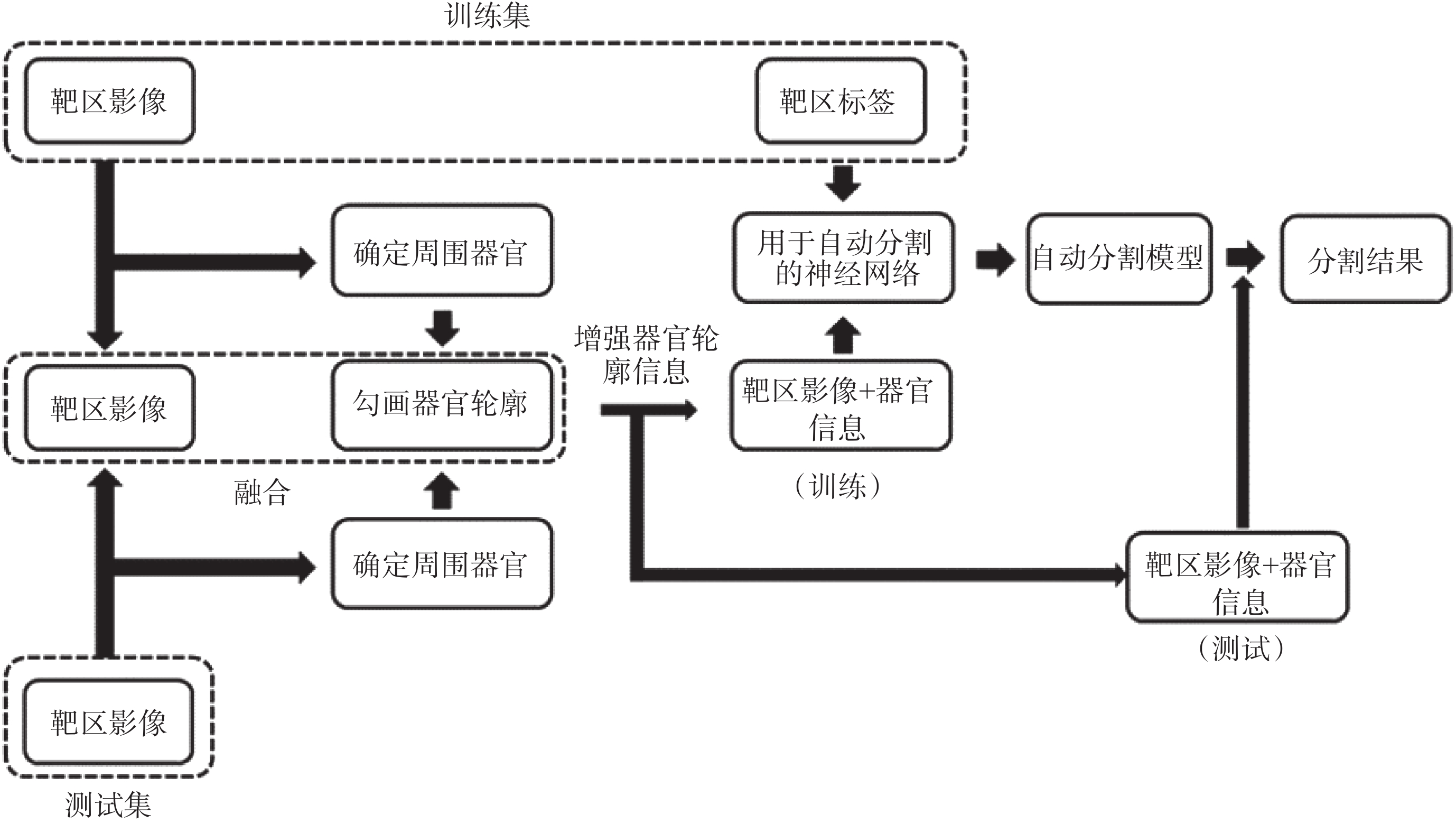

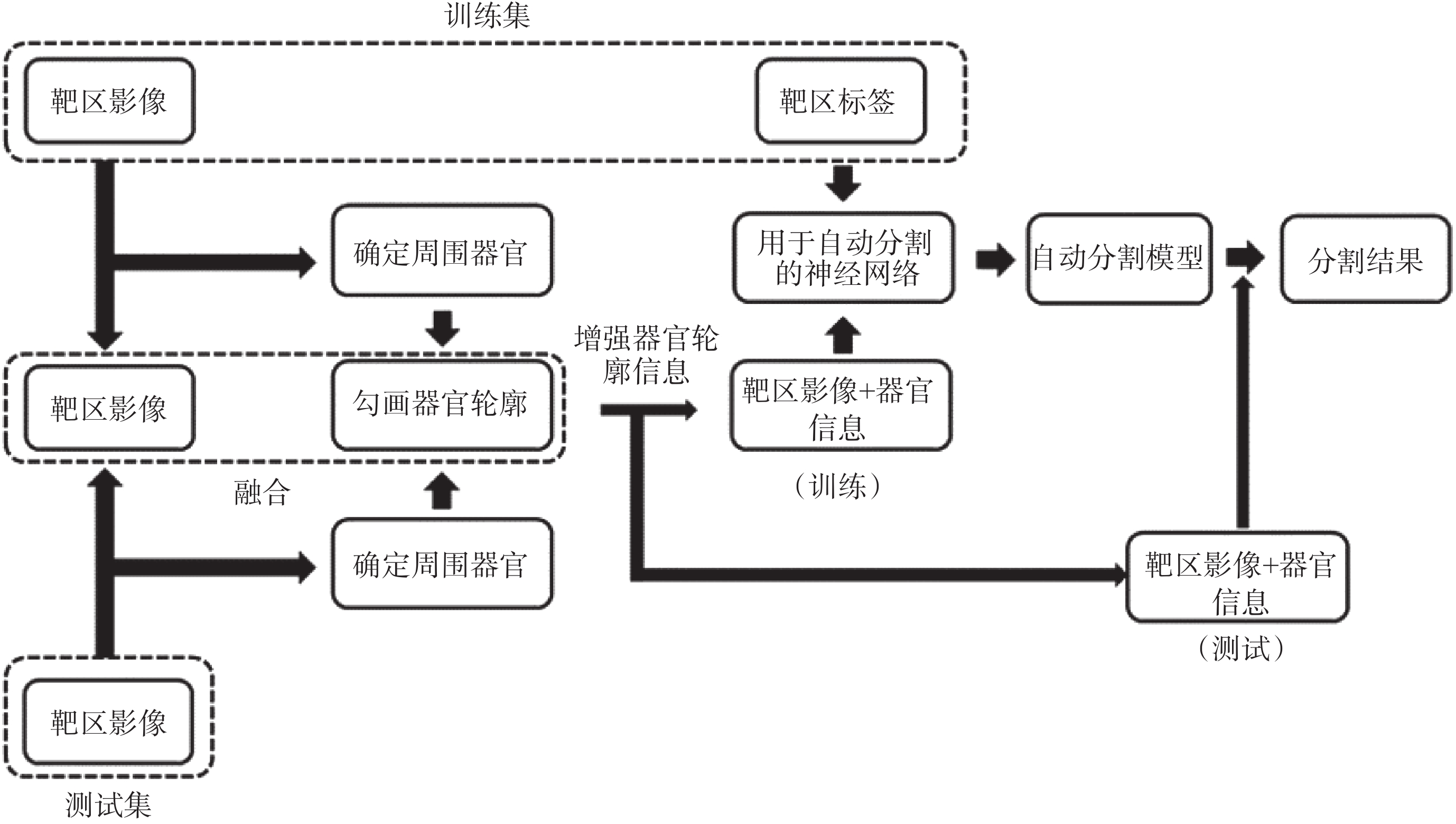

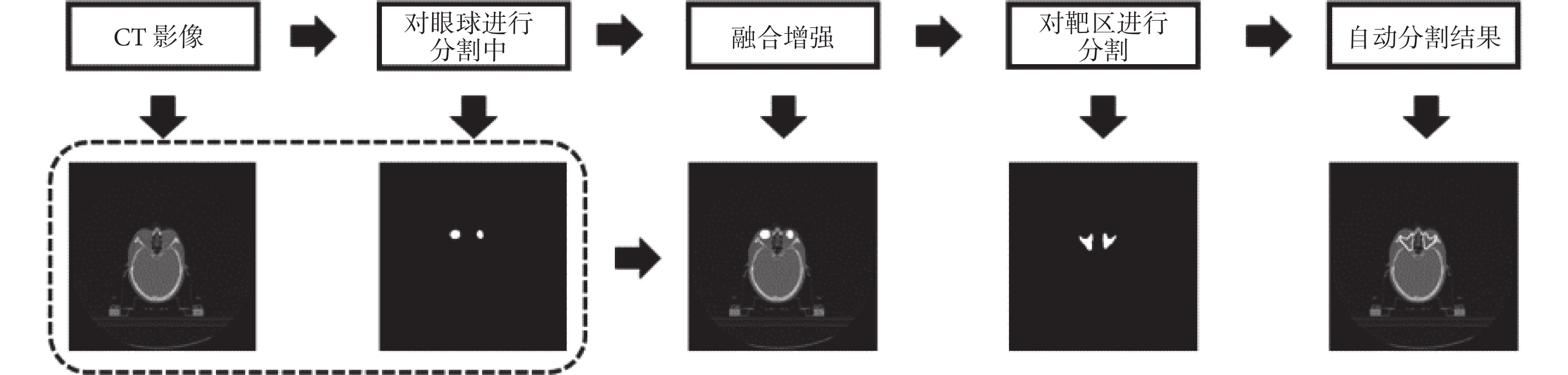

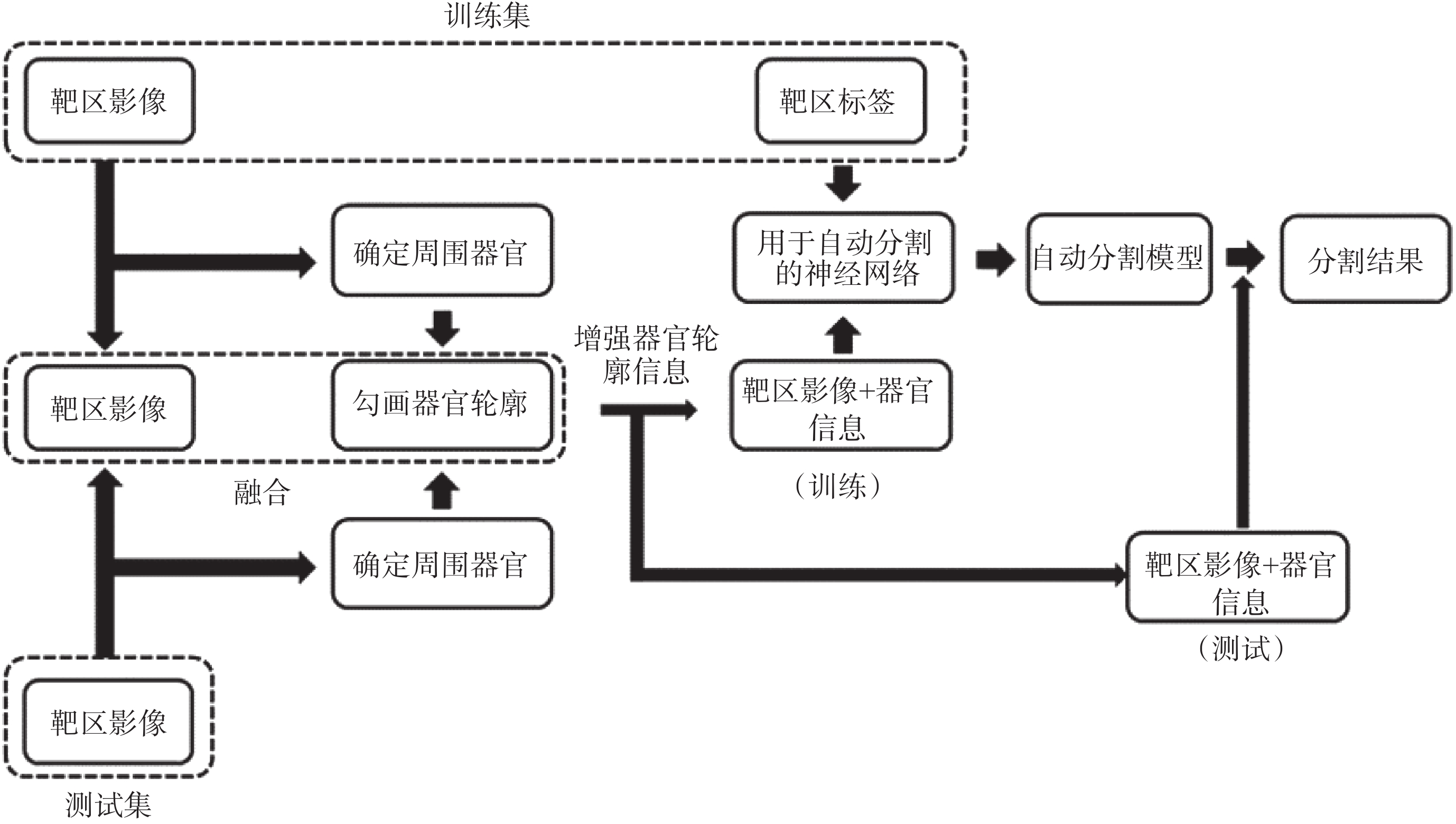

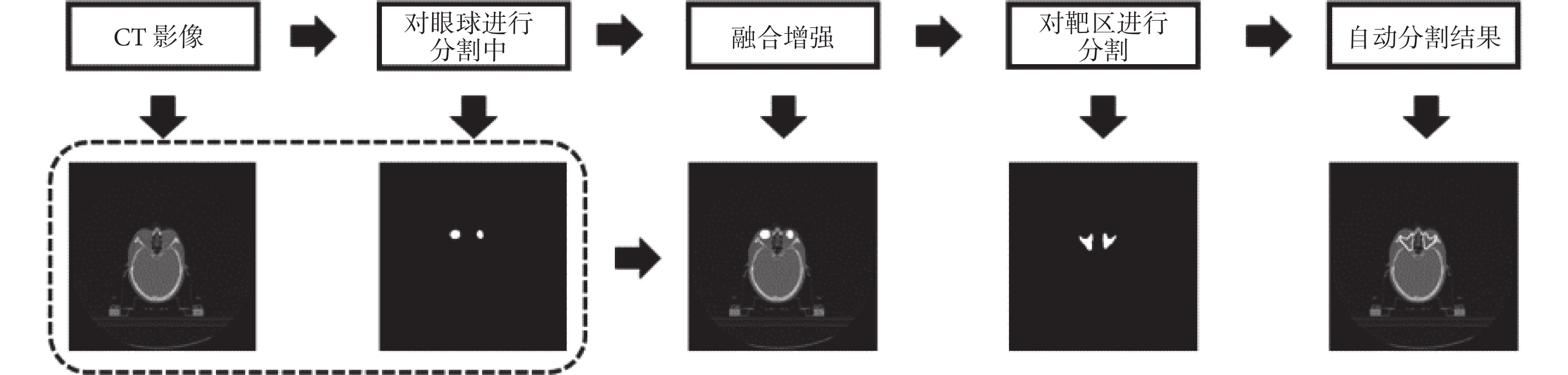

放射治療靶區與組織器官相比沒有較為特定的影像學特征,其邊界的確定往往需要結合周圍組織器官的形態結構以及醫生的經驗[6],這使得有關放射治療靶區的自動分割的研究較少[7-8]。在以往的靶區自動分割研究之中,放療靶區往往被作為一個獨立的結構用對應的靶區標簽和影像進行單獨訓練。但是這種方法顯然沒有考慮到在醫生勾畫靶區時,靶區周圍的正常組織器官所提供的信息的作用,而這些信息在很大程度上確定了靶區的形狀以及位置。以格蕾絲眼病為例,格蕾絲眼病作為一種常見的眼眶疾病,其中重度患者往往需要接受放射治療[9]。位于眼眶的放射治療靶區橫截面大致為三角形,范圍覆蓋眼球后的肌肉組織以及脂肪間隙[10]。雖然格蕾絲眼病的治療靶區體積較小,但位于靶區前方的眼球可用于確定靶區位置,規范靶區邊界形狀,同時眼球其本身特征在電子計算機斷層掃描(computed tomography,CT)影像上易于辨認。基于以上原因,本研究嘗試提出一種用于靶區自動分割的新方法,通過多個神經網絡的疊加,將靶區周圍利于確定靶區形狀的信息融入到靶區的自動分割之中,在現有網絡基礎上進一步提升靶區自動勾畫精度。由于其信息的融合是通過多個網絡的疊加得以實現,因此稱其為堆疊式神經網絡(stacked neural network),具體結構如圖 1 所示。相較于先定位再分割并以多種醫學影像信息融合為基礎的先進行粗略分割再進行精細分割等方法對于靶區本身包含信息的強化與利用,堆疊式神經網絡更多的是將周圍有利于確定靶區形狀位置的空間信息加以利用,先對用于訓練及測試的靶區 CT 影像進行信息增強,使周圍結構的空間信息更為突出,之后再進行訓練以及分割,進而達到提高靶區分割精度的目的。

圖1

堆疊式神經網絡結構

Figure1.

Structure of stacked neural network

圖1

堆疊式神經網絡結構

Figure1.

Structure of stacked neural network

1 材料和方法

1.1 堆疊式神經網絡

堆疊式神經網絡是在現有的神經網絡的基礎之上,將多個網絡進行聯合使用,其目的是通過多個神經網絡的聯合,在靶區分割的過程中加入更多的空間信息,以提升靶區的勾畫精度。如圖 1 所示,在整個神經網絡的訓練以及使用過程中,所使用的 CT 影像數據集要先經過對靶區周圍相關正常組織器官的定位、勾畫以及將器官的形狀和空間位置信息與原 CT 圖像融合這三個步驟。通過這三個步驟得到的訓練集和測試集圖像分別用于訓練和分割,將分割結果再映射到原有 CT 影像之上得到最終的靶區勾畫結果。為了使得勾畫靶區需要的周圍器官的信息更為突出,在進行信息融合時,本文改變了用于表示所選器官的圖像通道,使其在圖像上與周圍結構產生較大對比。本文以 FCN 作為基礎,利用 FCN-8s 神經網絡加以堆疊來完成對于堆疊式神經網絡的測試。FCN 作為圖像語義分割應用最為廣泛的神經網絡,在計算機視覺多個領域均有應用,可以較好完成彩色圖像或用灰度值來表示的醫學影像的分割。相較于為了專門進行醫學影像分割的 U-net,FCN 在對于彩色圖像的分割上更易于實現,這使得在進行信息融合時采用增強信息的方法有利更多的選擇,因此該實驗使用的堆疊式神經網絡也可以被稱為堆疊式 FCN(stacked FCN)。

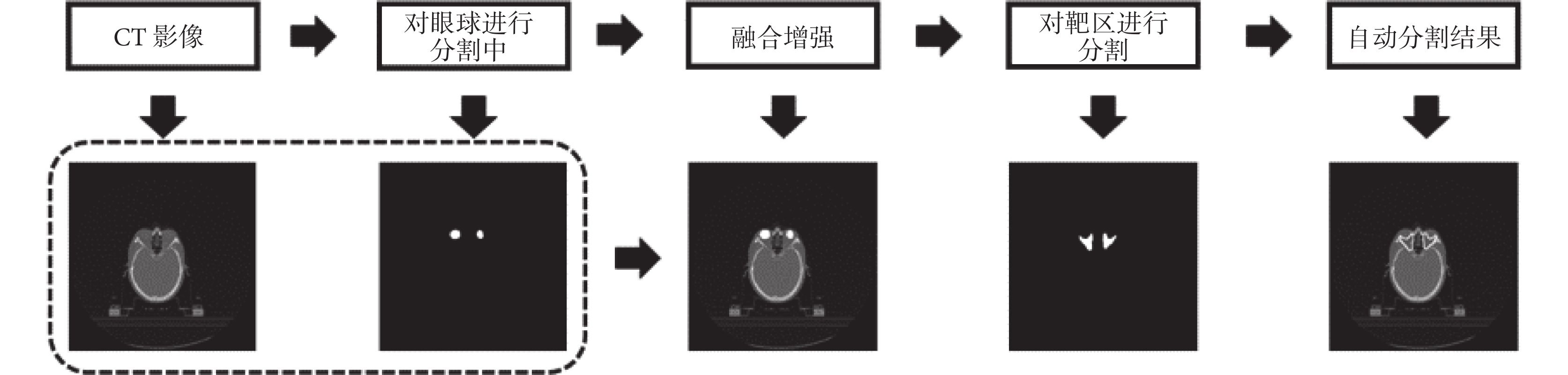

本文以格蕾絲眼病為例,考慮到眼球與放療靶區的相關性,將圖像的紅、綠、藍三通道分別取值為 0、255、0 來表示眼球左右的輪廓形狀,由于純色的添加與灰度圖像本身相差較大,因此在網絡學習的過程中,此部分所提取出的特征對靶區起到了很好的定位作用,同時與靶區差異很大不會被誤判為靶區的一部分。文中使用的 FCN 基于開源框架 Caffe(Berkeley AI Research Lab,美國)構建[11],預訓練模型使用 2011 年國際計算機視覺競賽的模式分析、統計建模與計算學習——可視對象類(Pattern Analysis,Statistical Modelling and Computational Learning-Visual Object Classes,PASCAL-VOC)圖集進行遷移學習[12]。數據提取以及圖像處理等操作使用編程語言 Python 2.7(Python software foundation,美國)完成,使用軟件平臺為 Anaconda 2(Anaconda Inc.,美國)。格蕾絲眼病放療靶區的分割流程示意圖如圖 2 所示。

圖2

以格蕾絲眼病為例的 stacked FCN 示意圖

Figure2.

Diagram of stacked FCN with Graves’ ophthalmopathy as an example

圖2

以格蕾絲眼病為例的 stacked FCN 示意圖

Figure2.

Diagram of stacked FCN with Graves’ ophthalmopathy as an example

1.2 數據的收集和整理

選取 2018-2019 年在四川大學華西醫院已經接受過放射治療的 120 例中重度格蕾絲眼病患者的 CT 影像集,其中女性患者 71 例,男性患者 49 例,其年齡、性別分布如表 1 所示。該 CT 影像均從放療計劃系統 Pinnacle3(V9.2,PHILIPS,美國)中導出,為患者進行放療前拍攝,用于制定放療計劃。患者數據均進行脫敏處理,CT 影像均由 CT 模擬定位機(SOMATOM Definition AS 128 排,SIEMENS,德國)掃描,層厚為 3 mm。每張 CT 影像均由醫學數字成像和通信(digital imaging and communications in medicine,DICOM)文件轉換為 512 × 512 像素大小并做歸一化處理。在這 120 名患者的 CT 影像集中,隨機選出 100 例作為訓練集,其余 20 例作為測試例。由于格蕾絲眼病的放療靶區分為左右相互獨立的兩部分,因此本文用 stacked FCN 模型和 FCN-8s 模型分別分割左右兩側靶區,來探究堆疊式神經網絡對于靶區勾畫精度的提升效果。

1.3 輪廓一致性評價方法

為了評估自動分割的準確性,將兩種模型的分割結果與醫生手動勾畫結果的相似度作為評判標準。總體來說,一種分割方法可以從準確性、效率和可靠性三個方面來判定其精度,各種評估指標大致分為四類:矩量法、重疊指標、平均距離和最大距離[13]。為了較為全面地反映分割結果間的相似度,本研究中使用重疊指標中的戴斯相似系數(Dice similarity coefficient,DSC)和最大距離指標中的豪斯多夫距離(Hausdorff distance,HD)將自動分割的輪廓與手動勾畫的輪廓進行定量比較[14]。

應用于圖像分割的 DSC 指的是兩個目標區域的重疊面積占總面積的百分比。就體積而言,它計算的是兩個體積的重疊部分占總體積的百分比。DSC 值保持在 0 和 1 之間,1 表示兩靶區體積完全重疊,0 表示靶區體積不相交。然而 DSC 對于圖像的細節不敏感,其數值無法體現小區域內的明顯分割誤差[15],這使得添加其他評估標準加以輔助變得十分必要。HD 是度量空間中任意兩個非空點集合之間的距離,它計算一個組中每個點距離另一個組中每個點的最小值,并取其最大值[16]。假設 A,B 為空間中的兩個非空點集,由 A 到 B 的 HD 定義如式(1)所示:

|

式中, 表示由 A 到 B 的單側 HD 值;d(a,b)表示a,b兩點間的距離。

表示由 A 到 B 的單側 HD 值;d(a,b)表示a,b兩點間的距離。

A 和 B 之間的(雙向)HD 取兩個單側 HD 中的較大值,其定義如式(2)所示:

|

式中, 表示由 B 到 A 的單側 HD 值。

表示由 B 到 A 的單側 HD 值。

本文使用了雙向 HD。通過編程提取醫生勾畫與自動分割的靶區像素點坐標,形成兩個坐標點集合,并計算兩點集的 HD。為了探究 stacked FCN 與 FCN-8s 的勾畫精度是否存在差異,使用統計分析軟件 SPSS 23.0(IBM,美國)對計算結果進行威爾科克森(Wilcoxon)符號秩和檢驗進行分析,P < 0.05 為差異有統計學意義。

2 結果

將 stacked FCN 和 FCN-8s 的分割結果,與醫生手動勾畫結果進行比較,計算體積 DSC 以及 HD,其結果如表 2、表 3 所示。由于格蕾絲眼病放療臨床靶區(clinical target volume,CTV)位于左右兩側眼球后方,故分別計算出了兩側的體積 DSC 以及雙向 HD,其中左側 CTV 用 CTV-L 表示,右側 CTV 用 CTV-R 表示。結合表 2、表 3 可知,stacked FCN 相較于 FCN-8s 將體積 DSC 值左側提高了 1.7%,右側提高了 3.4%;左右側靶區雙向 HD 值均下降了 0.6 左右。由于 DSC 值越大表示重合度越好,而 HD 值越小表示分割誤差越小,因此 stacked FCN 在對格蕾絲眼病放療靶區勾畫上的表現要優于 FCN-8s。

威爾科克森符號秩和檢驗結果顯示,兩種網絡的體積 DSC 值上的差異經檢驗均有P < 0.05,差異具有統計學意義。兩種網絡的雙向 HD 值上的差異經檢驗,左側靶區P > 0.05,差異不具有統計學意義;右側靶區P < 0.05,差異具有統計學意義。綜上所述,stacked FCN 對于格蕾絲眼病放療靶區的分割結果在與醫生手動勾畫結果的重合度上有著明顯的提高,同時小區域的不良分割在一定程度上減少。

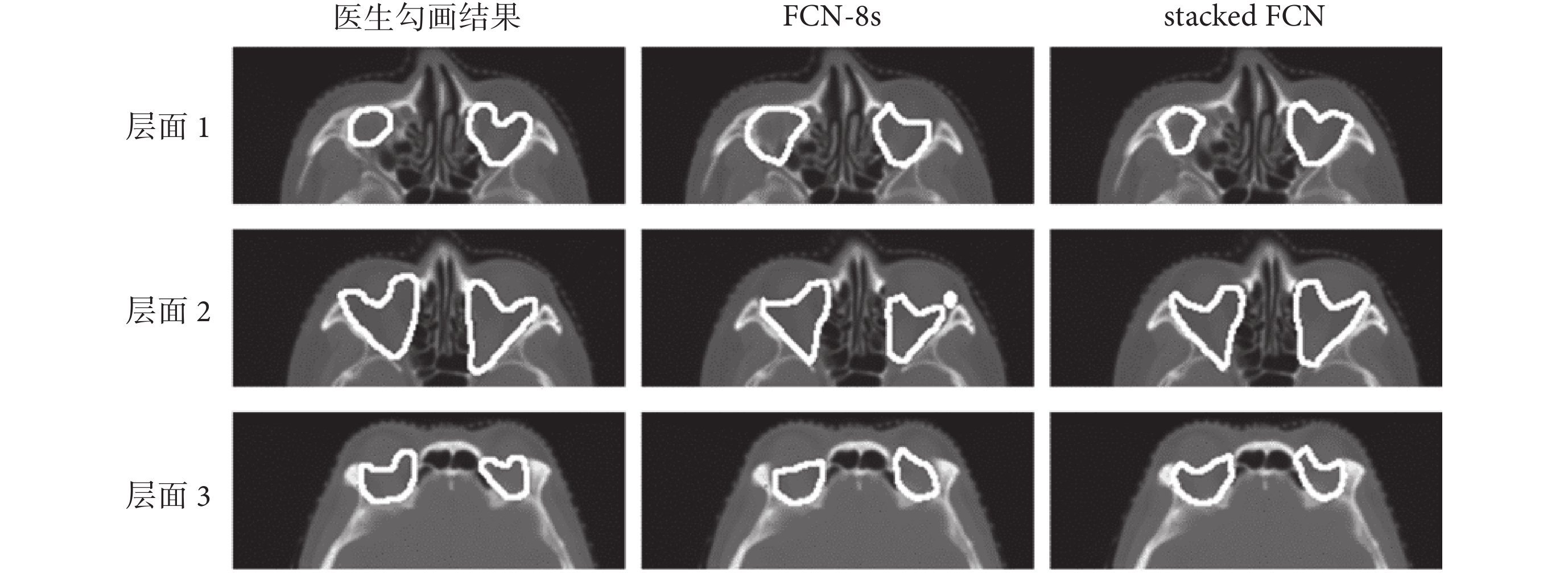

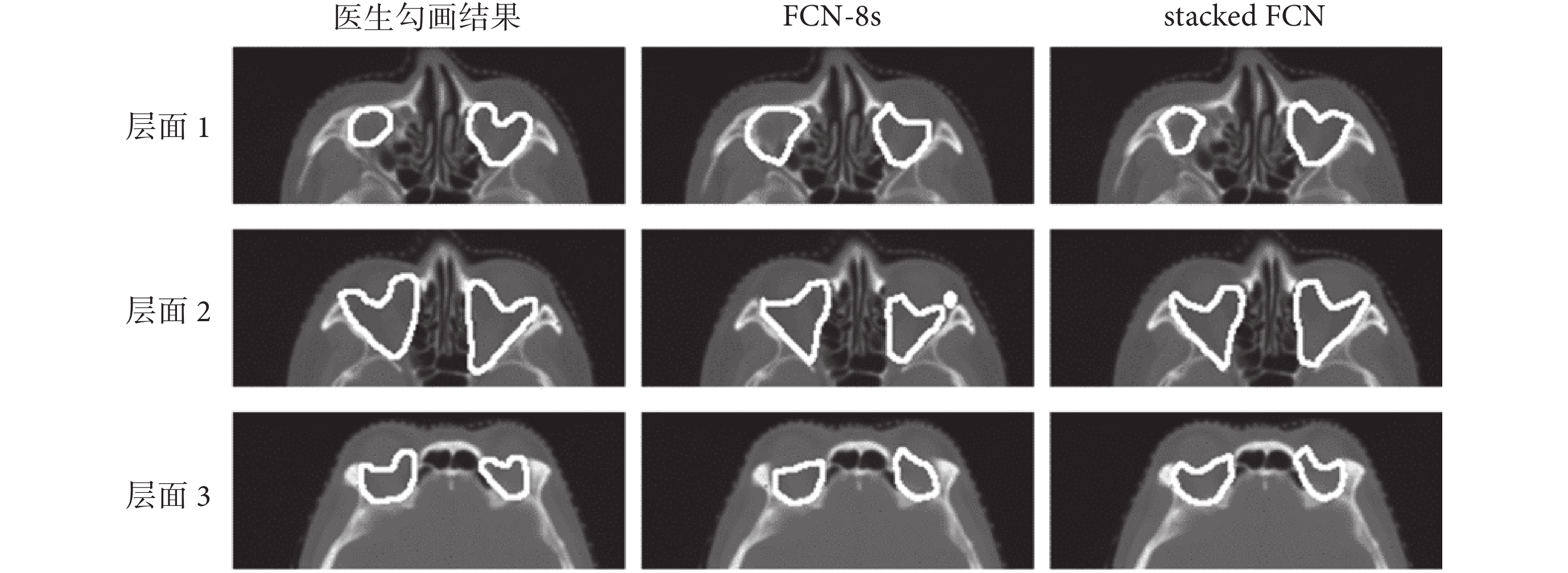

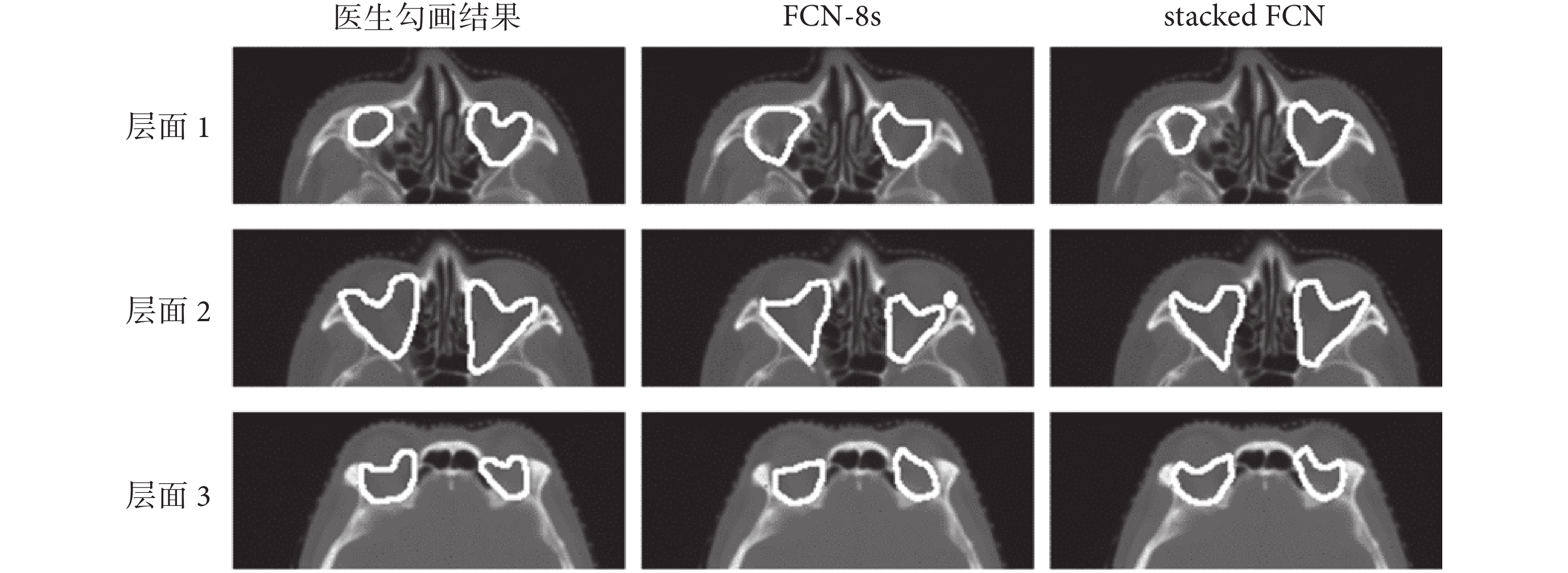

如圖 3 所示,為同一測試例三個不同層面的醫生勾畫結果、FCN-8s 勾畫結果以及 stacked FCN 勾畫結果的對比,層面 1、層面 2、層面 3 為同一測試例的三個不同層面的 CT 影像。結合表 2、表 3 和圖 3 的信息可知,對于體積較小的靶區來說,DSC 和 HD 值的改變反映在每一層 CT 影像上的結果十分明顯。通過利用眼球的形狀、位置信息,stacked FCN 使得勾畫結果靠近邊緣處形狀更為接近醫生手動勾畫結果,相較于 FCN-8s 小區域的不良分割更少,靶區形狀更為確定,勾畫結果更為精確。本文研究結果表明,堆疊式神經網絡通過利用靶區周圍器官所能提供的定位信息,在現有神經網絡的基礎上,能夠進一步增加靶區自動分割的精度。

圖3

醫生勾畫結果、FCN-8s 勾畫結果、stacked FCN 勾畫結果對比

Figure3.

Comparison of doctor’s segmentation results, FCN-8s segmentation results, and stacked FCN segmentation results

圖3

醫生勾畫結果、FCN-8s 勾畫結果、stacked FCN 勾畫結果對比

Figure3.

Comparison of doctor’s segmentation results, FCN-8s segmentation results, and stacked FCN segmentation results

3 討論

無論是基于圖集的分割(atlas-based segmentation,ABS)還是基于深度學習的靶區和危及器官的自動分割一直是放療領域的研究熱點,因為通過自動分割可以提高整個放療流程效率,并且能夠減少觀察者間的誤差[17]。目前有很多研究致力于提高 ABS 的精度,但這種方法本身也受到一定的限制。對于 ABS 來說,自動分割的精度高度依賴于被分割影像與圖集的相似度。這使得其在分割體積較小正常組織器官時很難達到一個較為完美的形變配準[18]。除此之外,相較于正常器官,由于靶區形狀不確定性較高,特征較難獲取,使得對其進行自動分割也更加困難一些。近年來,人工智能與放療領域的結合愈發緊密,不同的器官、組織以及其對應的各種模態的影像均被用來進行自動分割研究。深度學習通過從訓練集中提取不同維度的圖像特征來達到識別并分割目標區域這一目的,這也使得基于深度學習的自動分割在一定程度擺脫了形變配準的限制,彌補了 ABS 的不足。

以往基于深度學習的自動分割在進行目標區域分割的訓練時,網絡能夠學習到的信息僅限于目標區域本身;為了提高目標區域的勾畫精度通常也是將目標區域的多種影像信息加以組合,并沒有考慮目標區域與周圍器官之間的聯系。FCN 雖然使圖像分割進入像素級別時代,但對細節信息較為不敏感,對于每個像素的分類使得其忽略了像素與像素間的關系。目前已有一些研究利用圖像中的空間信息來提高自動分割精度[19-20]。堆疊式神經網絡與目前常用靶區自動分割方法的區別在于,堆疊式神經網絡更貼近于醫生對于靶區的定義的方式,在神經網絡不斷學習提取靶區像素特征的同時,通過靶區外部的相關信息,來進一步規范靶區形狀和確定像素的位置。由實驗結果可知,該方法可以進一步提高勾畫的準確性。這種方法也有利于較難以勾畫的小體積器官的自動分割。比如,利用視神經的形狀位置輔助視交叉的勾畫等。實驗中,為了產生與灰度值較為明顯的對比,研究中采取了通過將 CT 影像的顏色通道直接用色彩覆蓋來增強信息,這也是選擇基于 FCN 構建堆疊式神經網絡的原因。但堆疊式神經網絡正如其名,是通過多個網絡不斷疊加,豐富并增強用于分割的影像中的信息,因此具有靈活性。作為堆疊式神經網絡的內核,即用于進行堆疊的基礎神經網絡,可以隨著使用增強信息方法的不同加以更改和替換。這也使得在進一步的研究中,尋找不同信息融合和增強的方式用于搭配不同的網絡進行堆疊十分必要。實驗中,通過設定特定的顏色對所選擇區域進行更改,從原理上來說是對圖像顏色通道數值上的改變,也可嘗試添加新的通道用以控制圖像透明度或將兩者結合來探究其效果。另一方面,基于灰度值的改變是否具有相同的效果也同樣值得探究。

格蕾絲眼病靶區臨近眼球,形狀規則為本研究的驗證提供了良好的基礎。格蕾絲眼病靶區較小且與眼球聯系十分緊密,因此通過眼球定位起到了良好的效果。但考慮到靶區周圍結構的復雜性以及與周圍器官位置關系上的緊密程度,仍有大量細節情況值得探討。例如,使用多器官對靶區位置加以確定進行自動分割,其結果相較于僅融入單一器官信息的情況能否提高;同時隨著融合信息的增加,計算的速度與自動分割的效率都值得進一步研究。考慮到正常組織器官在靶區周圍的分布情況各異,器官與靶區間的距離對于這種定位效果的影響也值得考慮。

綜上所述,堆疊式神經網絡通過放療靶區周圍正常組織器官的形狀位置等信息,輔助目標靶區的勾畫,在格蕾絲眼病放療靶區的勾畫中已體現出相較于進行堆疊前精度上的提高。同時隨著網絡以及融合信息方法的不斷改進與提高,圖像靶區的勾畫精度還將有較大的提升空間。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

引言

深度學習(deep learning,DL)作為人工智能增長最為迅速的領域,已經廣泛應用于醫學影像處理之中[1]。對于腫瘤放射治療而言,基于深度學習的放療靶區和正常組織器官的自動勾畫可使醫生避免大量重復的勾畫工作,在提升整個放射治療流程效率的同時,減少觀察者內和觀察者間的誤差。隨著全卷積神經網絡(fully convolutional neural network,FCN)的提出,圖像的語義分割進入像素級的時代[2],FCN 之所以能夠取得較好的自動分割結果,是因為該網絡在對圖像進行卷積的過程之中,提取到了深層次的語義信息以及淺層次的位置信息,將這兩種信息有效地結合則能夠產生較好的分割結果。FCN 中圖像每當經過卷積層、池化層后,其寬、高會變為上一次的 1/2。在經過 5 次之后,圖像寬、高為原圖像的 1/32。此時為了得到與原圖大小相同的輸出特征圖,需要進行 32 倍的上采樣。進行 32 倍上采樣所得網絡為 FCN-32s。若在第四次卷積、池化的基礎上進行 16 倍上采樣則是 FCN-16s,在第 3 次基礎上的進行 8 倍上采樣則是 FCN-8s。在三者中,以 FCN-8s 的勾畫效果最好[2]。在此之后,基于 FCN 的大量神經網絡模型被提出,并用于研究人體正常組織結構的自動分割[3-4]。同時為了提高用于自動分割的神經網絡的精度,大量的研究在 FCN 的基礎上不斷改進網絡結構。其中一種采用了對稱的收縮和擴張路徑的 U 型網絡(U-net)作為這類研究的代表,改變了深淺層信息的融合方法,近年來在生物醫學影像分割領域表現優異[5]。此外,多種醫學影像的結合在圖像分割領域的應用也越發廣泛。

放射治療靶區與組織器官相比沒有較為特定的影像學特征,其邊界的確定往往需要結合周圍組織器官的形態結構以及醫生的經驗[6],這使得有關放射治療靶區的自動分割的研究較少[7-8]。在以往的靶區自動分割研究之中,放療靶區往往被作為一個獨立的結構用對應的靶區標簽和影像進行單獨訓練。但是這種方法顯然沒有考慮到在醫生勾畫靶區時,靶區周圍的正常組織器官所提供的信息的作用,而這些信息在很大程度上確定了靶區的形狀以及位置。以格蕾絲眼病為例,格蕾絲眼病作為一種常見的眼眶疾病,其中重度患者往往需要接受放射治療[9]。位于眼眶的放射治療靶區橫截面大致為三角形,范圍覆蓋眼球后的肌肉組織以及脂肪間隙[10]。雖然格蕾絲眼病的治療靶區體積較小,但位于靶區前方的眼球可用于確定靶區位置,規范靶區邊界形狀,同時眼球其本身特征在電子計算機斷層掃描(computed tomography,CT)影像上易于辨認。基于以上原因,本研究嘗試提出一種用于靶區自動分割的新方法,通過多個神經網絡的疊加,將靶區周圍利于確定靶區形狀的信息融入到靶區的自動分割之中,在現有網絡基礎上進一步提升靶區自動勾畫精度。由于其信息的融合是通過多個網絡的疊加得以實現,因此稱其為堆疊式神經網絡(stacked neural network),具體結構如圖 1 所示。相較于先定位再分割并以多種醫學影像信息融合為基礎的先進行粗略分割再進行精細分割等方法對于靶區本身包含信息的強化與利用,堆疊式神經網絡更多的是將周圍有利于確定靶區形狀位置的空間信息加以利用,先對用于訓練及測試的靶區 CT 影像進行信息增強,使周圍結構的空間信息更為突出,之后再進行訓練以及分割,進而達到提高靶區分割精度的目的。

圖1

堆疊式神經網絡結構

Figure1.

Structure of stacked neural network

圖1

堆疊式神經網絡結構

Figure1.

Structure of stacked neural network

1 材料和方法

1.1 堆疊式神經網絡

堆疊式神經網絡是在現有的神經網絡的基礎之上,將多個網絡進行聯合使用,其目的是通過多個神經網絡的聯合,在靶區分割的過程中加入更多的空間信息,以提升靶區的勾畫精度。如圖 1 所示,在整個神經網絡的訓練以及使用過程中,所使用的 CT 影像數據集要先經過對靶區周圍相關正常組織器官的定位、勾畫以及將器官的形狀和空間位置信息與原 CT 圖像融合這三個步驟。通過這三個步驟得到的訓練集和測試集圖像分別用于訓練和分割,將分割結果再映射到原有 CT 影像之上得到最終的靶區勾畫結果。為了使得勾畫靶區需要的周圍器官的信息更為突出,在進行信息融合時,本文改變了用于表示所選器官的圖像通道,使其在圖像上與周圍結構產生較大對比。本文以 FCN 作為基礎,利用 FCN-8s 神經網絡加以堆疊來完成對于堆疊式神經網絡的測試。FCN 作為圖像語義分割應用最為廣泛的神經網絡,在計算機視覺多個領域均有應用,可以較好完成彩色圖像或用灰度值來表示的醫學影像的分割。相較于為了專門進行醫學影像分割的 U-net,FCN 在對于彩色圖像的分割上更易于實現,這使得在進行信息融合時采用增強信息的方法有利更多的選擇,因此該實驗使用的堆疊式神經網絡也可以被稱為堆疊式 FCN(stacked FCN)。

本文以格蕾絲眼病為例,考慮到眼球與放療靶區的相關性,將圖像的紅、綠、藍三通道分別取值為 0、255、0 來表示眼球左右的輪廓形狀,由于純色的添加與灰度圖像本身相差較大,因此在網絡學習的過程中,此部分所提取出的特征對靶區起到了很好的定位作用,同時與靶區差異很大不會被誤判為靶區的一部分。文中使用的 FCN 基于開源框架 Caffe(Berkeley AI Research Lab,美國)構建[11],預訓練模型使用 2011 年國際計算機視覺競賽的模式分析、統計建模與計算學習——可視對象類(Pattern Analysis,Statistical Modelling and Computational Learning-Visual Object Classes,PASCAL-VOC)圖集進行遷移學習[12]。數據提取以及圖像處理等操作使用編程語言 Python 2.7(Python software foundation,美國)完成,使用軟件平臺為 Anaconda 2(Anaconda Inc.,美國)。格蕾絲眼病放療靶區的分割流程示意圖如圖 2 所示。

圖2

以格蕾絲眼病為例的 stacked FCN 示意圖

Figure2.

Diagram of stacked FCN with Graves’ ophthalmopathy as an example

圖2

以格蕾絲眼病為例的 stacked FCN 示意圖

Figure2.

Diagram of stacked FCN with Graves’ ophthalmopathy as an example

1.2 數據的收集和整理

選取 2018-2019 年在四川大學華西醫院已經接受過放射治療的 120 例中重度格蕾絲眼病患者的 CT 影像集,其中女性患者 71 例,男性患者 49 例,其年齡、性別分布如表 1 所示。該 CT 影像均從放療計劃系統 Pinnacle3(V9.2,PHILIPS,美國)中導出,為患者進行放療前拍攝,用于制定放療計劃。患者數據均進行脫敏處理,CT 影像均由 CT 模擬定位機(SOMATOM Definition AS 128 排,SIEMENS,德國)掃描,層厚為 3 mm。每張 CT 影像均由醫學數字成像和通信(digital imaging and communications in medicine,DICOM)文件轉換為 512 × 512 像素大小并做歸一化處理。在這 120 名患者的 CT 影像集中,隨機選出 100 例作為訓練集,其余 20 例作為測試例。由于格蕾絲眼病的放療靶區分為左右相互獨立的兩部分,因此本文用 stacked FCN 模型和 FCN-8s 模型分別分割左右兩側靶區,來探究堆疊式神經網絡對于靶區勾畫精度的提升效果。

1.3 輪廓一致性評價方法

為了評估自動分割的準確性,將兩種模型的分割結果與醫生手動勾畫結果的相似度作為評判標準。總體來說,一種分割方法可以從準確性、效率和可靠性三個方面來判定其精度,各種評估指標大致分為四類:矩量法、重疊指標、平均距離和最大距離[13]。為了較為全面地反映分割結果間的相似度,本研究中使用重疊指標中的戴斯相似系數(Dice similarity coefficient,DSC)和最大距離指標中的豪斯多夫距離(Hausdorff distance,HD)將自動分割的輪廓與手動勾畫的輪廓進行定量比較[14]。

應用于圖像分割的 DSC 指的是兩個目標區域的重疊面積占總面積的百分比。就體積而言,它計算的是兩個體積的重疊部分占總體積的百分比。DSC 值保持在 0 和 1 之間,1 表示兩靶區體積完全重疊,0 表示靶區體積不相交。然而 DSC 對于圖像的細節不敏感,其數值無法體現小區域內的明顯分割誤差[15],這使得添加其他評估標準加以輔助變得十分必要。HD 是度量空間中任意兩個非空點集合之間的距離,它計算一個組中每個點距離另一個組中每個點的最小值,并取其最大值[16]。假設 A,B 為空間中的兩個非空點集,由 A 到 B 的 HD 定義如式(1)所示:

|

式中, 表示由 A 到 B 的單側 HD 值;d(a,b)表示a,b兩點間的距離。

表示由 A 到 B 的單側 HD 值;d(a,b)表示a,b兩點間的距離。

A 和 B 之間的(雙向)HD 取兩個單側 HD 中的較大值,其定義如式(2)所示:

|

式中, 表示由 B 到 A 的單側 HD 值。

表示由 B 到 A 的單側 HD 值。

本文使用了雙向 HD。通過編程提取醫生勾畫與自動分割的靶區像素點坐標,形成兩個坐標點集合,并計算兩點集的 HD。為了探究 stacked FCN 與 FCN-8s 的勾畫精度是否存在差異,使用統計分析軟件 SPSS 23.0(IBM,美國)對計算結果進行威爾科克森(Wilcoxon)符號秩和檢驗進行分析,P < 0.05 為差異有統計學意義。

2 結果

將 stacked FCN 和 FCN-8s 的分割結果,與醫生手動勾畫結果進行比較,計算體積 DSC 以及 HD,其結果如表 2、表 3 所示。由于格蕾絲眼病放療臨床靶區(clinical target volume,CTV)位于左右兩側眼球后方,故分別計算出了兩側的體積 DSC 以及雙向 HD,其中左側 CTV 用 CTV-L 表示,右側 CTV 用 CTV-R 表示。結合表 2、表 3 可知,stacked FCN 相較于 FCN-8s 將體積 DSC 值左側提高了 1.7%,右側提高了 3.4%;左右側靶區雙向 HD 值均下降了 0.6 左右。由于 DSC 值越大表示重合度越好,而 HD 值越小表示分割誤差越小,因此 stacked FCN 在對格蕾絲眼病放療靶區勾畫上的表現要優于 FCN-8s。

威爾科克森符號秩和檢驗結果顯示,兩種網絡的體積 DSC 值上的差異經檢驗均有P < 0.05,差異具有統計學意義。兩種網絡的雙向 HD 值上的差異經檢驗,左側靶區P > 0.05,差異不具有統計學意義;右側靶區P < 0.05,差異具有統計學意義。綜上所述,stacked FCN 對于格蕾絲眼病放療靶區的分割結果在與醫生手動勾畫結果的重合度上有著明顯的提高,同時小區域的不良分割在一定程度上減少。

如圖 3 所示,為同一測試例三個不同層面的醫生勾畫結果、FCN-8s 勾畫結果以及 stacked FCN 勾畫結果的對比,層面 1、層面 2、層面 3 為同一測試例的三個不同層面的 CT 影像。結合表 2、表 3 和圖 3 的信息可知,對于體積較小的靶區來說,DSC 和 HD 值的改變反映在每一層 CT 影像上的結果十分明顯。通過利用眼球的形狀、位置信息,stacked FCN 使得勾畫結果靠近邊緣處形狀更為接近醫生手動勾畫結果,相較于 FCN-8s 小區域的不良分割更少,靶區形狀更為確定,勾畫結果更為精確。本文研究結果表明,堆疊式神經網絡通過利用靶區周圍器官所能提供的定位信息,在現有神經網絡的基礎上,能夠進一步增加靶區自動分割的精度。

圖3

醫生勾畫結果、FCN-8s 勾畫結果、stacked FCN 勾畫結果對比

Figure3.

Comparison of doctor’s segmentation results, FCN-8s segmentation results, and stacked FCN segmentation results

圖3

醫生勾畫結果、FCN-8s 勾畫結果、stacked FCN 勾畫結果對比

Figure3.

Comparison of doctor’s segmentation results, FCN-8s segmentation results, and stacked FCN segmentation results

3 討論

無論是基于圖集的分割(atlas-based segmentation,ABS)還是基于深度學習的靶區和危及器官的自動分割一直是放療領域的研究熱點,因為通過自動分割可以提高整個放療流程效率,并且能夠減少觀察者間的誤差[17]。目前有很多研究致力于提高 ABS 的精度,但這種方法本身也受到一定的限制。對于 ABS 來說,自動分割的精度高度依賴于被分割影像與圖集的相似度。這使得其在分割體積較小正常組織器官時很難達到一個較為完美的形變配準[18]。除此之外,相較于正常器官,由于靶區形狀不確定性較高,特征較難獲取,使得對其進行自動分割也更加困難一些。近年來,人工智能與放療領域的結合愈發緊密,不同的器官、組織以及其對應的各種模態的影像均被用來進行自動分割研究。深度學習通過從訓練集中提取不同維度的圖像特征來達到識別并分割目標區域這一目的,這也使得基于深度學習的自動分割在一定程度擺脫了形變配準的限制,彌補了 ABS 的不足。

以往基于深度學習的自動分割在進行目標區域分割的訓練時,網絡能夠學習到的信息僅限于目標區域本身;為了提高目標區域的勾畫精度通常也是將目標區域的多種影像信息加以組合,并沒有考慮目標區域與周圍器官之間的聯系。FCN 雖然使圖像分割進入像素級別時代,但對細節信息較為不敏感,對于每個像素的分類使得其忽略了像素與像素間的關系。目前已有一些研究利用圖像中的空間信息來提高自動分割精度[19-20]。堆疊式神經網絡與目前常用靶區自動分割方法的區別在于,堆疊式神經網絡更貼近于醫生對于靶區的定義的方式,在神經網絡不斷學習提取靶區像素特征的同時,通過靶區外部的相關信息,來進一步規范靶區形狀和確定像素的位置。由實驗結果可知,該方法可以進一步提高勾畫的準確性。這種方法也有利于較難以勾畫的小體積器官的自動分割。比如,利用視神經的形狀位置輔助視交叉的勾畫等。實驗中,為了產生與灰度值較為明顯的對比,研究中采取了通過將 CT 影像的顏色通道直接用色彩覆蓋來增強信息,這也是選擇基于 FCN 構建堆疊式神經網絡的原因。但堆疊式神經網絡正如其名,是通過多個網絡不斷疊加,豐富并增強用于分割的影像中的信息,因此具有靈活性。作為堆疊式神經網絡的內核,即用于進行堆疊的基礎神經網絡,可以隨著使用增強信息方法的不同加以更改和替換。這也使得在進一步的研究中,尋找不同信息融合和增強的方式用于搭配不同的網絡進行堆疊十分必要。實驗中,通過設定特定的顏色對所選擇區域進行更改,從原理上來說是對圖像顏色通道數值上的改變,也可嘗試添加新的通道用以控制圖像透明度或將兩者結合來探究其效果。另一方面,基于灰度值的改變是否具有相同的效果也同樣值得探究。

格蕾絲眼病靶區臨近眼球,形狀規則為本研究的驗證提供了良好的基礎。格蕾絲眼病靶區較小且與眼球聯系十分緊密,因此通過眼球定位起到了良好的效果。但考慮到靶區周圍結構的復雜性以及與周圍器官位置關系上的緊密程度,仍有大量細節情況值得探討。例如,使用多器官對靶區位置加以確定進行自動分割,其結果相較于僅融入單一器官信息的情況能否提高;同時隨著融合信息的增加,計算的速度與自動分割的效率都值得進一步研究。考慮到正常組織器官在靶區周圍的分布情況各異,器官與靶區間的距離對于這種定位效果的影響也值得考慮。

綜上所述,堆疊式神經網絡通過放療靶區周圍正常組織器官的形狀位置等信息,輔助目標靶區的勾畫,在格蕾絲眼病放療靶區的勾畫中已體現出相較于進行堆疊前精度上的提高。同時隨著網絡以及融合信息方法的不斷改進與提高,圖像靶區的勾畫精度還將有較大的提升空間。

利益沖突聲明:本文全體作者均聲明不存在利益沖突。