針對數量日益增多的抑郁癥患者群體,本文提出一種通過語音信號有效識別抑郁癥的人工智能方法,以提高診斷和治療效率。首先,通過微調語音到特征向量模型2.0(wav2vec 2.0)的預訓練模型對語音進行編碼和上下文化,從而獲得高質量的語音特征;然后,應用情感障礙分析的公用數據集——綠野仙蹤憂慮分析訪談語料庫(DAIC-WOZ)數據集驗證上述模型。結果顯示,在抑郁癥識別的二分類任務中,該方法在精確率方面達到了93.96%、召回率達到了94.87%、F1分數達到了94.41%,總體分類準確率達到96.48%。在評估抑郁癥嚴重程度的四分類任務中,精確率均達到92.59%及以上,召回率均達到92.89%及以上,F1分數均達到93.12%以上,總體分類準確率達到94.80%。基于上述結果證明,本文提出的方法在小樣本情況下有效提升了分類的準確率,對于抑郁癥的識別和嚴重程度評估效果良好。未來,該方法有望在抑郁癥的診斷中起到輔助支持的作用。

引用本文: 黃祥勝, 廖義龍, 張文勁, 張莉. 基于語音預訓練模型的抑郁癥識別研究. 生物醫學工程學雜志, 2024, 41(1): 9-16. doi: 10.7507/1001-5515.202304008 復制

版權信息: ?四川大學華西醫院華西期刊社《生物醫學工程學雜志》版權所有,未經授權不得轉載、改編

0 引言

目前,全球范圍內抑郁癥的患病率呈驚人的上升趨勢,已有超過3.22億人遭受抑郁癥困擾[1]。世界衛生組織已將抑郁癥確定為第四大致殘原因,預計到2030年將成為第二大致殘原因[2]。作為一種常見的精神障礙,抑郁癥會導致患者情緒調節能力受損,其特征是情緒低落、對事物失去興趣或難以感受到快樂、注意力不集中,嚴重情況下患者甚至會產生自殺念頭[3]。傳統的精神病理學評估方法主要依賴于患者口頭描述和精神狀態的表現,以及家庭成員的反饋意見等主觀評價,缺乏客觀的定量評價指標[4]。此外,精神病理學評估通常需要豐富的專業知識支持,而且耗時長、評測項目繁多,不利于抑郁癥的早期快速確診。

近年來,研究人員提出了許多客觀評估抑郁癥的方法,例如使用細胞因子或者唾液等生物樣本進行評估,但這些生物樣本的獲取通常具有侵入性,并且進行分析檢測的成本較高[5-6]。還有一些研究提出了通過視覺跡象進行抑郁癥自動檢測的方法,例如采集受試者的瞳孔數據、面部表情、頭部姿勢等進行分析,但這些方法的特征提取步驟復雜,識別準確率不高[7]。此外,盡管人體視覺行為蘊含豐富的生理病理信息,但數據獲取具有挑戰性,并且存在個人隱私泄露的風險。隨后,Solieman等[8]證明了使用語音信號檢測抑郁癥的可行性,并指出抑郁癥患者的聲學特征與常人有所不同。由于錄音設備的普及率高、錄音成本低、語音信號的獲取相對簡單且無侵入性,因此陸續有研究基于聲學特征如韻律、頻譜和語音質量等,來探索抑郁癥的自動檢測方法。例如,Ooi等[9]使用聲學特征的多通道加權方法進行抑郁癥檢測,準確率超過70.00%。Gao等[10]提取語音信號的短期特征和長期特征,使用隨機森林算法和極值梯度提升算法進行分類,識別抑郁癥患者的靈敏度達到75.00%。Jiang等[11]使用集成邏輯回歸模型檢測抑郁癥,準確率超過75.00%。van Eeden等[12]使用機器學習方法進行抑郁癥檢測,獲得了79.00%的準確率。早期的研究主要采用機器學習方法進行抑郁癥檢測,雖然這些方法不需要大量的訓練數據,但其準確率依賴于特征選擇,并且難以判斷特征質量的優劣,同時還存在關鍵特征丟失的風險。

隨著深度學習方法的發展, 一些研究開始嘗試將其應用于抑郁癥檢測。例如,Sun等[13]結合無監督編碼和基于注意力機制的轉換器(transformer)進行抑郁癥檢測。Yin等[14]使用基于transformer和并行卷積神經網絡(transformer and parallel convolutional neural networks,TCC)的深度學習模型檢測抑郁癥。TCC模型注重局部知識,能夠感知時序信息,并挖掘出復雜維度中的有效信息。然而,這些方法并未使用語音屬性,無法充分發揮transformer在語音領域的潛力。為了解決這個問題,Chen等[15]基于語音中的分量關系,提出了一個名為高效語音架構(speechformer++)的模型,該模型基于語音中的分量關系,能夠有效地平衡細粒度和粗粒度信息, 并增強特征的提取能力。另外, Wang等[16]使用注意力機制(attention)和雙向門控循環單元(bidirectional gate recurrent unit,Bi-GRU)相結合的模型提取了語音的三維特征,并獲得了77.14%的準確率。Rejaibi等[17]使用梅爾頻率倒譜系數(Mel-scale frequency cepstral coefficients,MFCC)作為特征輸入循環神經網絡,并使用數據增強技術,提升抑郁癥識別性能。Miao等[18]利用高階譜分析技術,將雙譜特征和非線性雙相干特征進行融合,以實現抑郁癥識別,并獲得了良好的分類效果。Zhao等[19]采用幀級特征來捕獲語音中的時間信息,并將其作為長短時記憶網絡(long short term memory network,LSTM)的輸入,該方法的準確率達到了90.20%。深度學習方法通常需要使用信號處理后的特征作為輸入,然而手工制作特征的過程復雜而繁瑣、常常需要特定任務的專業知識,且容易丟失有用信息。為了在一定程度上彌補信息丟失,一些研究采用了多模態研究方法。Toto等[20]提出一種音頻和文本的多模態表示模型,并將其集成到深度學習架構中用于抑郁癥檢測。Muzammel等[21]提出了一種使用音頻和視覺特征的深度學習網絡,采用更深層次的模型級融合方法來獲取多模態的聯合特征表示,該方法的最佳分類準確率達95.38%。Sun等[22]提出一種自適應融合transformer網絡的多模態模型,首先從音頻和視覺數據的單一模態中提取長期的時間上下文信息,然后使用該模型自適應地融合有用的多模態特征,以實現抑郁癥的檢測。上述研究結果表明,盡管多模態方法在語言理解和序列建模方面表現出良好的性能,但對語音信號中抑郁癥特征表示的能力仍然存在不足之處,此外多模態數據獲取不易、模型構建復雜、并且目前還缺乏高效的多模態融合方法。

自監督學習方法因其在多個下游任務中表現出色而備受關注[23]。語音到特征向量模型2.0(wav2vec 2.0)是一個在大規模無標注數據上進行預訓練的自監督學習語音識別模型,它在語音特征提取方面表現出優異的性能,并能夠學習到通用的語言表示。該模型引入了乘積量化方法以提升其表示能力,并能夠充分利用transformer 的長距離信息整合優勢,增強信息捕獲能力。對于不同的下游任務,該模型只需在有限的標注數據上進行微調,就能達到或超越上游任務的最佳水平[24]。目前,在使用語音數據進行抑郁癥識別方面仍然存在數據規模不足、特征提取依賴手工設計、模型泛化性能有待提高等缺陷和挑戰。因此,本文提出了一種微調wav2vec 2.0預訓練模型的方法。與傳統的機器學習或深度學習方法相比,本文方法簡化了特征提取步驟、降低對手工制作特征的需求。此外,本文方法無需使用數據增強技術即可處理小樣本數據庫,有效避免了數據增強可能引入的不必要噪聲和誤差,這為智能診斷的實際應用提供了可能性。本文首先使用wav2vec 2.0預訓練模型對輸入的語音數據進行編碼和上下文化,以獲得高質量的語音特征。然后,將這些高質量的語音特征輸入到小型微調網絡中,以期實現抑郁癥的檢測。本文使用小樣本的綠野仙蹤(又譯:奧茲國巫師)憂慮分析訪談語料庫(the distress analysis interview corpus-wizard of OZ,DAIC-WOZ)數據集來評估模型的分類性能,在抑郁癥識別的二分類任務以及評估抑郁癥嚴重程度的四分類任務中,期待通過本文方法取得良好的分類效果,能夠有效識別抑郁個體,并精準評估患者抑郁的程度。

1 數據集及預處理

1.1 實驗數據集

本文研究中使用的語音信號選取自DAIC-WOZ數據集,該數據集由南加州大學(University of Southern California,USC)的創新技術研究所(Institute for Creative Technologies,ICT)構建。本研究使用的的數據已經獲得了授權許可。該數據集是憂慮分析訪談語料庫(the distress analysis interview corpus,DAIC)的一部分,包含了焦慮、抑郁和創傷后應激障礙等多種心理壓力疾病的臨床訪談記錄。數據集提供了詳細的轉錄文件,記錄了一個名為艾莉(Ellie)的動畫虛擬面試官和受訪者每句話發言的開始時間和結束時間。在臨床訪談過程中,使用了虛擬人類訪談器,通過由另一個房間的人類面試官控制Ellie進行訪談,這一過程就彷如綠野仙蹤(又譯:奧茲國巫師)(wizard-of-OZ,WOZ)里的場景一樣。語音數據采用頭戴式麥克風(HSP 4-EW-3,森海塞爾,德國),以16 kHz進行錄制,交互時長在7~33 min之間 ,平均為16 min [25-26]。該數據集屬于小樣本數據集,共包含189個音頻文件,其中包括56個抑郁癥患者的音頻,每個音頻文件都包含動畫虛擬面試官和受訪者的語音。此外,該數據集還提供了受訪者身份識別號(identity document,ID)、性別、八項患者健康問卷抑郁量表(the eight-item patient health questionnaire depression scale,PHQ-8)評分等信息[25]。

1.2 預處理

本研究僅對受訪者的語音數據進行分析,由于每個音頻文件中同時包含Ellie和受訪者的語音,并且存在長期沉默片段,因此需對DAIC-WOZ數據集中的音頻文件進行預處理操作,以提高數據質量。首先,采用語音切割技術,從189個原始音頻中切割出受訪者的語音片段,并剔除Ellie發言的語音片段以及原始音頻中的長期靜默片段。其次,采用語音合并技術,將受訪者的語音片段按照每組5個句子進行合并,形成新的音頻文件;需要注意的是,只對來自同一ID的語音數據進行合并。通過上述操作,共獲得6 545個新音頻文件,其中僅包含受訪者的發言片段。此時,本研究獲得的數據樣本已經足夠充分,能有效緩解樣本不均衡導致分類效果不佳的問題,因此無需再進行數據增強處理。

1.3 數據集重構

數據集的劃分對于調整模型參數、驗證模型性能和評估模型泛化能力具有重要意義。為了保證各類別標簽比例的平衡,且重構的數據集均能包含無抑郁(non-depression,non)、輕度抑郁(mild-depression,mild)、中度抑郁(moderate-depression,moderate)和重度抑郁(severe-depression,severe)這四個類別的數據,首先在進行隨機分組之前將這四個類別的數據分開,然后按照6∶2∶2的比例隨機劃分這四個類別的數據為訓練集、驗證集和測試集。訓練集和驗證集用于微調模型,使其適用于抑郁癥識別,而測試集用于評估模型性能。為了保證實驗的可重復性,本文采用隨機種子進行劃分,并統一將隨機種子數值設置為103。

2 模型及實驗設置

2.1 語音識別模型

已經證實,預訓練和微調的結合是一種有效的學習策略[27]。相較于從零開始訓練,使用預訓練模型可以提供一個良好的初始化狀態,該方法只需要少量的數據集就能取得良好的效果,從而節省了大量時間和資源。預訓練階段通常以無監督方式在大規模數據集上進行,以便讓模型學習有意義的表示[28-29]。預訓練階段的作用類似于正則化器,可以提供大量的先驗信息,從而降低過擬合的風險,并增強模型的泛化能力[30]。

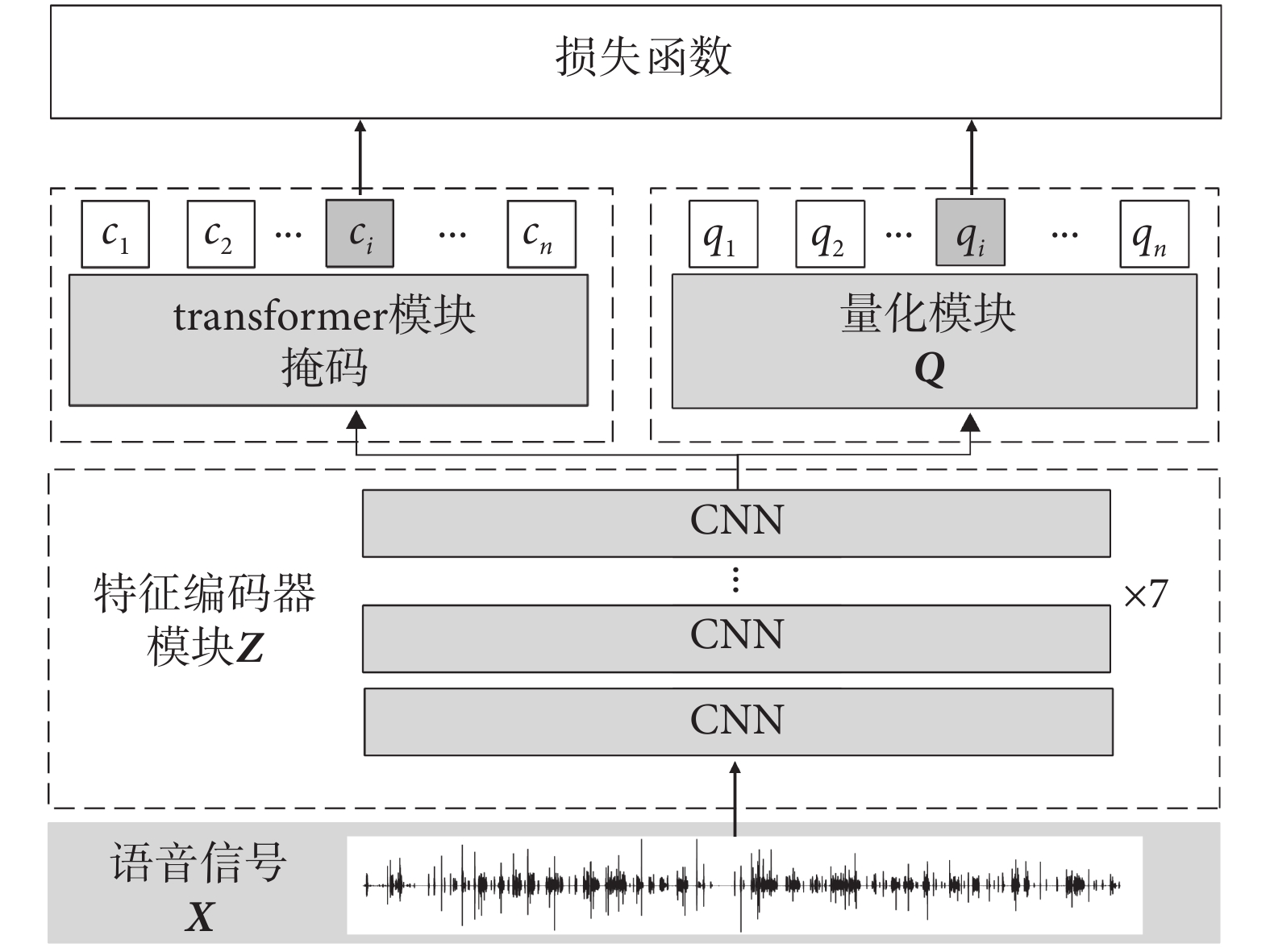

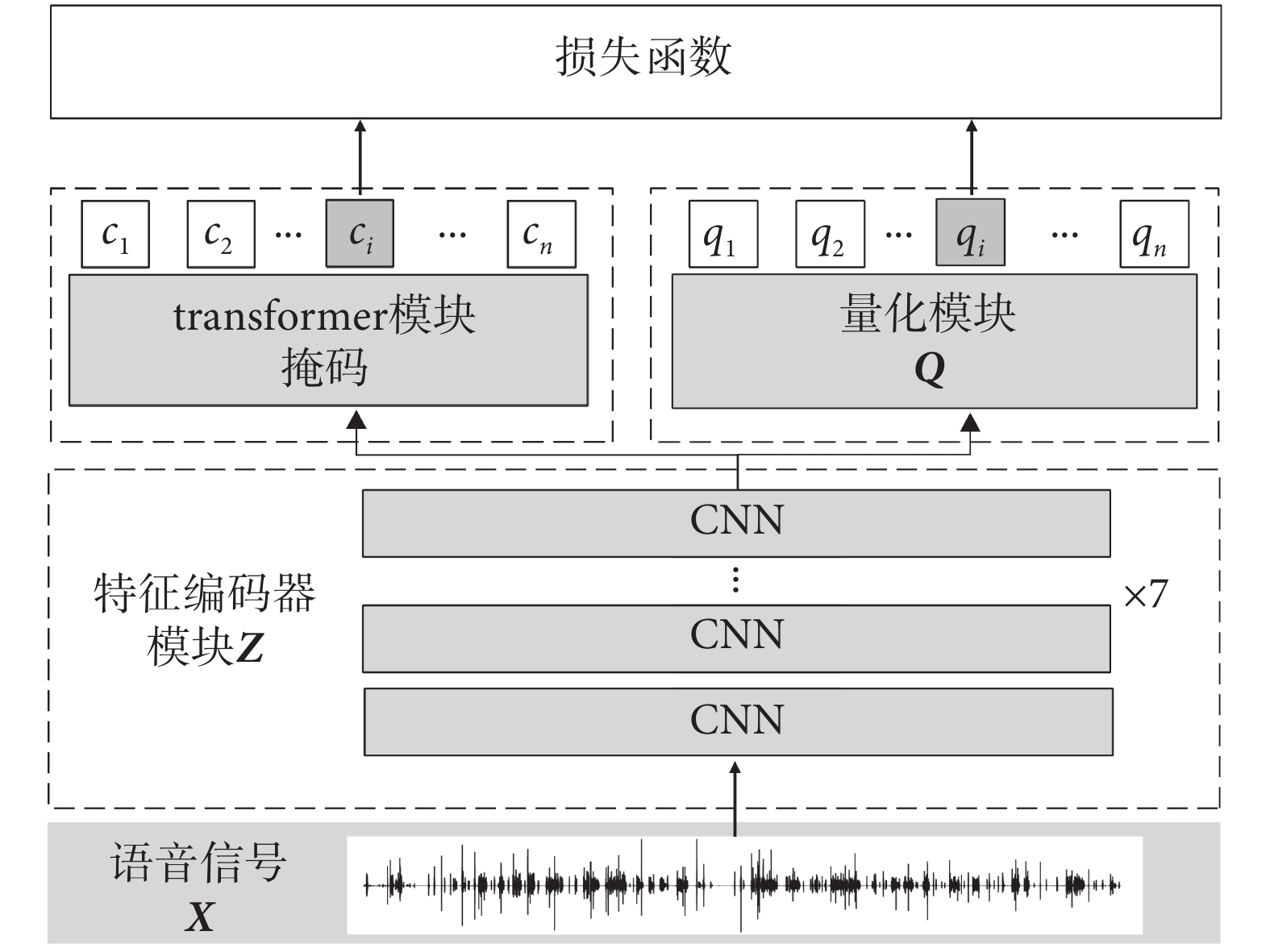

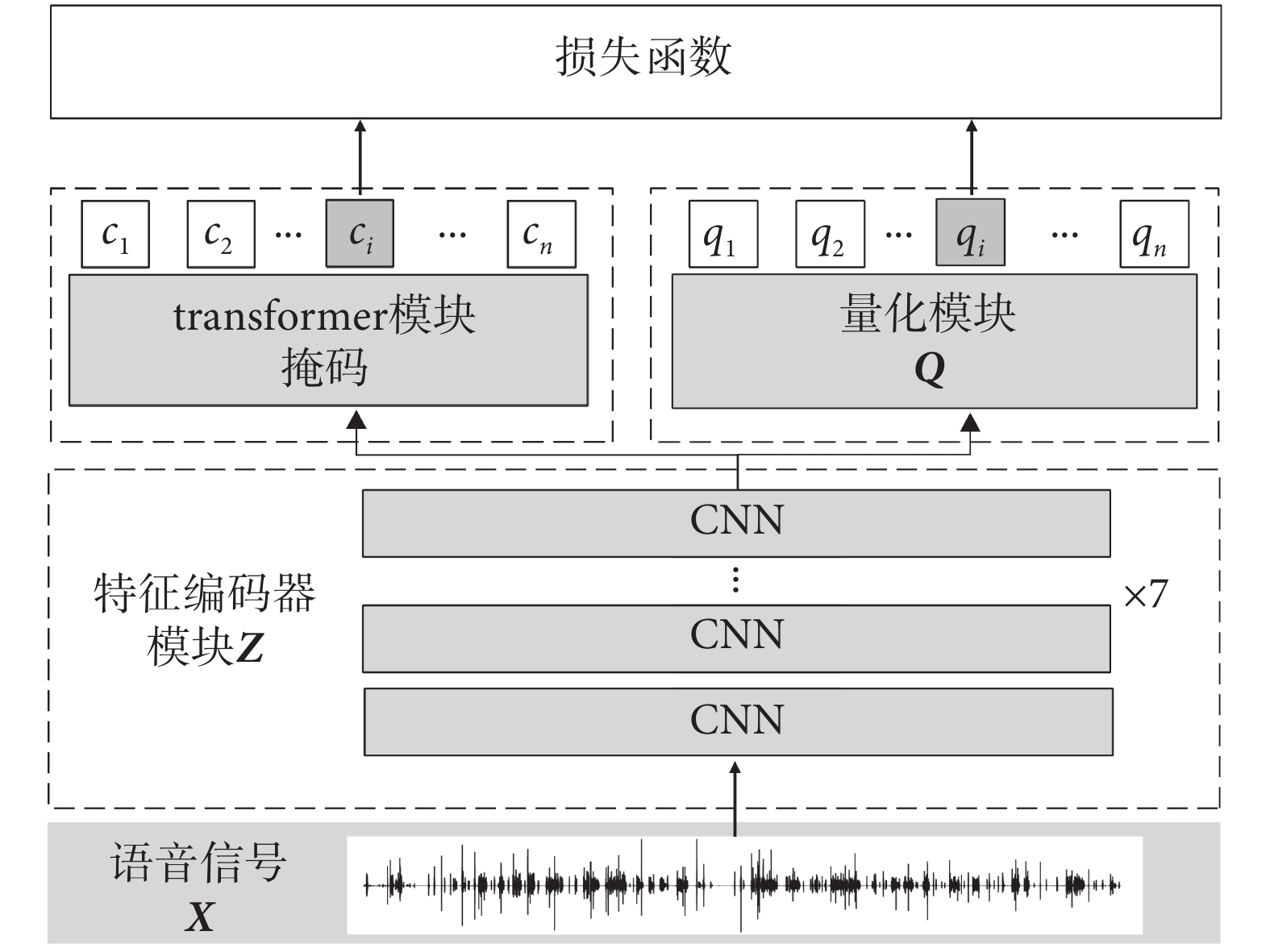

wav2vec 2.0是一個在語音處理領域具有很大潛力的預訓練模型,它是在對比預測編碼(contrastive predictive coding,CPC)、語音到特征向量模型(wav2vec),再到向量量化(vector quantization,VQ)的wav2vec(VQ-wav2vec)的基礎上發展而來的,wav2vec 2.0模型能夠學習離散語音單元和端到端上下文表示[31-33]。它能夠從被掩碼的潛在表示中有效地識別出正確的量化潛在語音表示。如Baevski等[24]所描述的,該模型主要由特征編碼器模塊、transformer模塊和量化模塊組成,如圖1所示。

圖1

wav2vec 2.0預訓練模型框架圖

Figure1.

Framework of the wav2vec 2.0 pre-training model

圖1

wav2vec 2.0預訓練模型框架圖

Figure1.

Framework of the wav2vec 2.0 pre-training model

首先,特征編碼器模塊將語音信號X映射到特征Z,表示為f:X→Z,其中Z為特征集合{z1, z2, …, zn}。特征編碼器包含7層卷積神經網絡(convolutional neural network,CNN),并應用了高斯誤差線性單元(Gaussian error linear units,GELU)。通過CNN,特征編碼器模塊能夠從語音中學習到高級語義信息,而GELU引入非線性元素,使特征編碼器可以完成非線性映射。在這個過程中,第一層CNN的輸出使用組歸一化(group normalization,GN)方法,對整個序列上的每個輸出通道進行歸一化,而其余幾層CNN的輸出則使用層歸一化(layer normalization,LN)方法,對每個批次(batch)內的輸出通道進行歸一化。此外,在該模塊的最后一層激活層之前,使用L2正則化項來穩定訓練,并進行歸一化處理,以避免權值矩陣過大。

其次,量化模塊將特征編碼器Z的輸出離散化為一組有限的語音表示Q:{q1, q2, …, qi, …, qn},表示為h:Z→Q,Q作為自監督目標。這個過程使用乘積量化操作,將無限的特征表達空間坍縮成有限的離散空間,從而降低模型預測的難度并提高特征的魯棒性。在該模塊中,采用耿貝爾歸一化指數函數柔性最大(Gumbel softmax)技術對離散分布進行采樣,并將其轉化為可微的連續分布,以解決特征空間離散后無法進行反向傳播的問題。

緊接著,transformer模塊接收潛在語音表示Z,并創建上下文表示{c1, c2, …, ci, …, cn},表示為g:Z→C。在輸入transformer模塊之前,對大約一半語音表示Z進行掩碼操作。由于transformer中的自注意力機制(self-attention)能夠捕獲輸入數據的長期依賴關系,因此最終的輸出序列{c1, c2, …, ci, …, cn}可能同時包含局部和全局信息[34]。因此,wav2vec 2.0的預訓練模型具備從掩碼位置中識別正確的量化語音單位的能力,也就是表明其信息捕捉能力更強。

最后,使用量化的語音表示qi和上下文表示ci來計算損失函數。當損失函數達到理想值時,wav2vec 2.0就能夠學習到高質量的語音特征。

wav2vec 2.0有兩種實驗配置:基礎(base)模型(wav2vec 2.0-base)和大(large)模型(wav2vec 2.0- large)。這兩種模型具有相同的編碼器架構,但它們的transformer塊數量以及模型維度有所區別。wav2vec 2.0-base模型包含7層CNN和12層transformer結構。各卷積層的通道數為512,各自的步幅為(5,2,2,2,2,2,2),核大小為(10,3,3,3,3,2,2)。相比于wav2vec 2.0-large模型,wav2vec 2.0-base模型具有更快的訓練速度和更低的計算資源需求,更適用于小數據集或計算能力有限的場景。

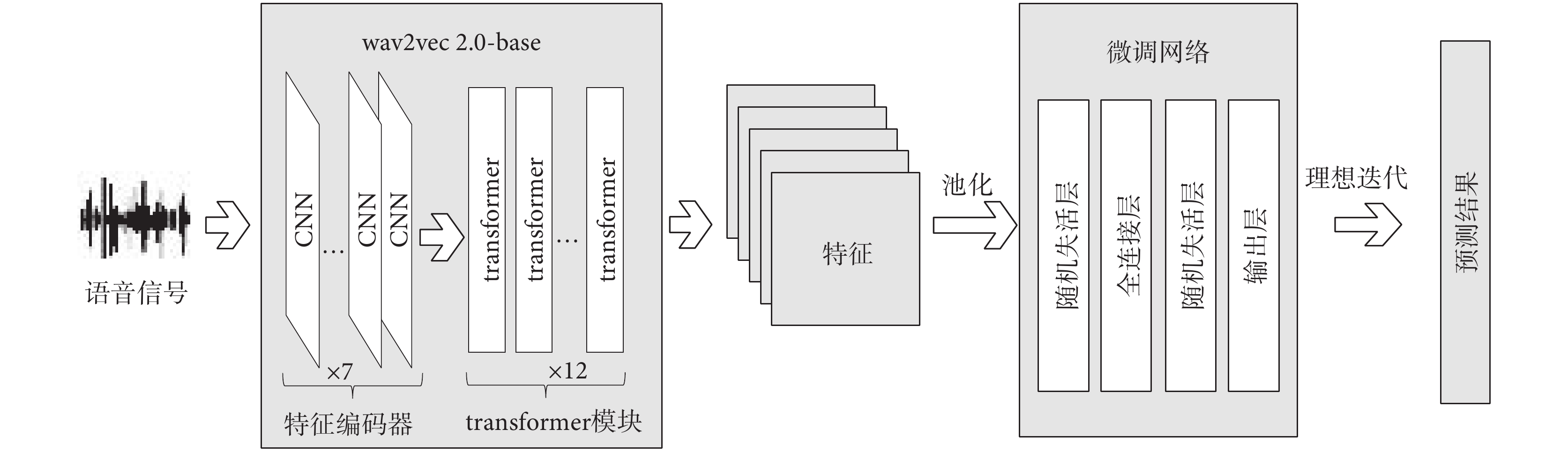

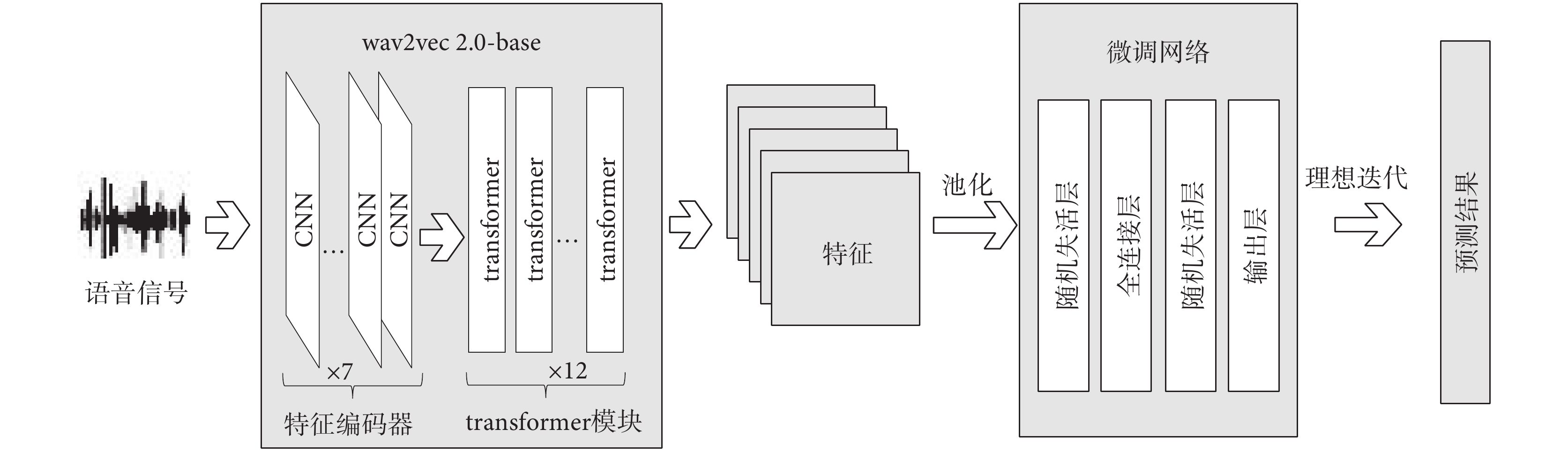

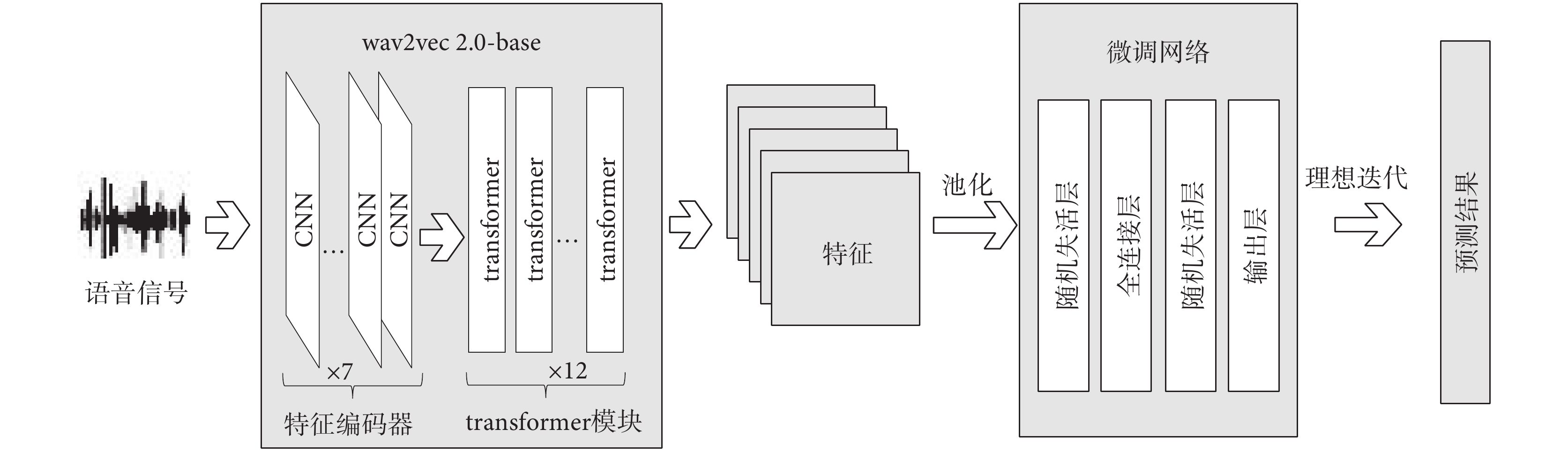

本文的所有實驗都基于wav2vec 2.0-base模型進行。本文設計了一個微調網絡,并將其連接在wav2vec 2.0-base模型的輸出端,使得wav2vec 2.0-base模型適用于抑郁癥識別檢測任務,如圖2所示。

圖2

語音抑郁癥識別的整體框架圖

Figure2.

Overall framework of voice depression recognition

圖2

語音抑郁癥識別的整體框架圖

Figure2.

Overall framework of voice depression recognition

首先,將語音信號輸入wav2vec 2.0-base模型中,利用特征編碼器模塊捕捉語音信號的局部信息,并使用transformer 模塊捕捉具有全局信息的語音特征,從而獲取高質量的語音特征。接著,對提取的高質量語音特征進行池化處理,以增大模型的感受野,提高語音識別的準確性和魯棒性。然后,在微調網絡中使用隨機失活層(dropout),以減少神經元之間的共適應關系,降低權值更新對固定隱含節點共同作用的依賴,迫使神經網絡學習更加魯棒的特征。同時,該方法還起到增加稀疏性的作用,增加語音特征之間的區分度。因此,在全連接層和輸出層之前,本研究使用隨機失活層來提升模型性能。通過不斷迭代微調本文所提出的模型,當損失函數達到理想值時,輸出模型的預測結果。

2.2 實驗任務

目前,對抑郁癥的識別研究主要局限于二分類任務,鮮有對抑郁癥嚴重程度進行多分類研究。然而,為了更好地輔助判斷抑郁癥,進行抑郁癥多分類研究是非常必要的。因此,本研究定義了兩個實驗任務:抑郁癥二分類和抑郁癥四分類。二分類任務中,研究檢測患者是否受到抑郁癥困擾。該任務的標簽劃分方法基于DAIC-WOZ數據集提供的二進制(binary)數值,將語音數據標簽設為抑郁(depression,dep)和非抑郁(non depression,ndep)。四分類任務中,將抑郁癥嚴重程度劃分為四個等級:non、mild、moderate和severe。該任務的標簽劃分方法是將數據集中的PHQ-8評分(范圍0~24)離散化為4個類別:[0-4]、[5-9]、[10-14]和[15-24],標簽分別對應:non、mild、moderate和severe。

此外,本研究還設置了wav2vec 2.0預訓練模型的參數微調和凍結實驗、池化方法實驗以及模型迭代次數實驗,以研究微調或凍結wav2vec 2.0模型的參數對抑郁癥分類性能的影響、不同的池化方法對提高預訓練模型準確率的影響,以及模型迭代次數(epoch)對模型收斂的影響。

2.3 參數設置

學習率(learning rate,LR)和批大小(batch size,BS)是深度學習中非常重要的超參數,它們影響著模型的收斂速度和性能。LR是控制權重更新步長的參數,BS是指每次迭代訓練時所使用的樣本數。在預訓練階段,wav2vec 2.0模型的參數幾乎調整至最佳狀態。在微調過程中,預訓練模型的網絡參數也會被更新。為了防止wav2vec 2.0模型參數發生較大變化而影響模型性能,應選擇較小的LR。通過對比不同LR(1 × 10?4、1 × 10?5、1 × 10?6)對模型性能的影響,本研究發現LR為1 × 10?5時,模型性能表現最佳。為避免模型在訓練過程中出現震蕩并增加內存的消耗,本研究使用梯度累加(gradient accumulation,GA)方法,即在兩次累加之后更新模型神經網絡的參數,然后將梯度清零。因此,本研究的BS設置為4,GA設置為2,累加BS(accumulated BS,ABS)設置為8,并且均在LR設置為1 × 10?5的條件下進行實驗。

2.4 評估方法

在樣本不平衡的情況下,僅使用單一評估指標作為衡量準則可能存在偏差,無法全面評估模型在不同方面的性能表現。因此,本研究采用準確率(accuracy,ACC)、精確率(precision,PRE)、召回率(recall,REC)以及F1分數這4個評價指標來衡量模型的分類性能,計算方法分別如式(1)~式(4)所示:

|

|

|

|

其中,真陽性(true positive,TP)表示預測為正類且預測正確的樣本數量。真陰性(true negative,TN)表示預測為負類且預測正確的樣本數量。假陽性(false positive,FP)表示預測為正類,但預測錯誤的樣本數量。假陰性(false negative,FN)表示預測為負類但預測錯誤的樣本數量。PRE表示對正樣本結果進行預測的準確程度,REC表示實際為正樣本的樣本中被正確預測為正樣本的概率。F1分數綜合考慮了模型的ACC和REC,可看作是這兩者的加權平均,從而綜合評估分類模型的性能。

3 實驗結果及討論

相較于從零開始訓練模型,使用預訓練模型可以節省大量的時間和資源,并且僅需少量數據集即可取到良好效果。傳統的深度學習模型具有大量參數,在小規模數據集上容易過擬合,而預訓練模型提供了良好的初始化狀態,從而降低了過擬合風險,并增強了模型的泛化能力。wav2vec 2.0預訓練模型具備強大的語音特征提取能力,能夠學習到有意義的語言表示。本研究通過微調wav2vec 2.0 預訓練模型,將其應用于抑郁癥識別任務。

由于預訓練模型已經在大規模數據上進行了訓練,其參數已接近最優解,在微調過程中僅需調整部分參數即可獲得良好效果。如果在不影響wav2vec 2.0分類性能的前提下,凍結底部參數并僅調整頂部或特定層參數,將有助于減少訓練參數并提高訓練速度。

本文所有的表格中,“類別”一詞表示抑郁癥的分類數目。在研究微調或凍結參數對模型性能影響的實驗中,將epoch設置為5。實驗結果如表1所示,其中“凍結”一欄中“是”表示凍結模型wav2vec 2.0中的特征編碼模塊參數,“否”表示對該模塊的參數進行微調。

如表1所示,凍結了wav2vec 2.0 特征編碼器的參數后,在二分類任務中,ACC有所提升;在評估抑郁癥嚴重程度的四分類任務中,ACC的提升更為明顯。實驗結果表明,通過凍結模型wav2vec 2.0底層參數來減少訓練參數,可以提高訓練效率。這種方法既可以將更多資源用于優化后端網絡參數,又能很好地保留模型的先驗知識。

此外,池化方法可以增大感受野、改善過擬合現象、提高魯棒性和加快計算速度,并且能在降低特征圖的參數量的同時保留特征圖中最顯著的特征。池化操作通常有最大池化和平均池化兩種方式,最大池化通過選擇窗口中的最大值作為下采樣后的值,平均池化則是選擇窗口中的平均值作為下采樣后的值。在凍結參數的實驗基礎上,本文比較了不同池化方法對模型分類性能的影響,其中epoch設置為5,實驗結果如表2所示。

如表2所示,在二分類和四分類任務中,采用平均池化方法時,模型的ACC均有提升。實驗結果表明,采用平均池化方法優于最大池化方法。最大池化雖然能有效抑制噪聲和異常值,但也會損失部分重要信息;而平均池化能夠平滑輸出,并盡可能地保留所有特征信息,從而減少過擬合風險并提高魯棒性。wav2vec 2.0 預訓練模型具備強大的語義信息學習能力,提取出的語音特征無需去除噪聲或異常值,并且平均池化方法對于小樣本數據集更為合適。

epoch的次數是指將所有數據完整地訓練一遍的次數。如果epoch輪次過少,模型可能無法充分學習訓練數據,導致欠擬合;如果epoch輪次過多,模型可能會過擬合,導致在測試集上表現不佳。因此,在凍結參數并使用平均池化方法的基礎上,本文進一步研究了epoch對模型性能的影響,實驗結果如表3所示。

如表3所示,隨著epoch的增加,模型ACC也得到提高。但是當達到10之后,增加epoch無法再帶來明顯的性能提升。此外,增加epoch輪次還會導致訓練時間的增加和進一步消耗計算資源,因此需要在模型性能、訓練速度和計算資源之間進行權衡,綜合考慮后,本研究決定將epoch設置為10。

綜合前面的實驗結果,對模型的參數進行設置,并使用測試集評估模型的分類性能。模型二分類和四分類的混淆矩陣如表4和表5所示。在混淆矩陣中,每一行數據的總和為對應類別的樣本總數,對角線上的數據為正確預測的樣本數。二分類和四分類的模型分類效果如表6所示。

如表4所示,在410個抑郁樣本中,模型正確預測了389個;在899個非抑郁樣本中,正確預測了874個,這表明本文提出的模型在抑郁個體和非抑郁個體的識別方面具有良好的效果。

如表5所示,本文模型也能夠有效評估不同程度的抑郁患者。例如在non這一行中,樣本總數為572,正確預測的樣本為548個。

如表6所示,二分類和四分類任務ACC分別達到了96.48%、94.80%。F1分數均達到93.12%及以上,表明模型的分類性能非常出色。實驗結果表明,本文所提模型能夠有效識別抑郁個體,并且能夠精確評估患者的抑郁的程度。

由于目前大多數抑郁癥研究都是針對二分類任務,對于抑郁癥的多分類識別研究較少,因此在與其他的研究方法進行對比時,本文選擇了二分類任務。如表7所示,列出了不同研究方法在抑郁癥識別方面的結果,這些方法都使用了DAIC-WOZ數據集和相同的評價指標,表7中數據統一保留小數點后兩位,括號中的數據表示非抑郁類別的評價指標。

如表7所示,在PRE方面,本文模型對抑郁類別的識別略低于文獻[21],但對于非抑郁類別的識別精度更高。在REC方面,文獻[18]表現最優,但在其它三個評估指標上不及本文模型。綜合考慮,在實際應用中,本文模型具備更高的可靠性和優越性。在F1分數和ACC方面,本文模型均優于現有方法。

4 總結

本研究提出一種微調wav2vec 2.0預訓練模型的方法,該方法能夠對語音數據進行編碼和上下文化,自動提取高質量的語音特征,從而提升模型性能和泛化能力。與傳統的機器學習或深度學習方法不同,該方法省去了復雜的特征提取步驟,并且在不進行語音降噪和數據增強的情況下,能夠改善小樣本數據集的識別效果。相較于現有技術,本文方法在帶噪聲的DAIC-WOZ數據集上展現了更卓越的性能。此外,本研究還提供了多分類研究的經驗,豐富了抑郁癥研究的視角,并分享預訓練模型微調的經驗,這對于從事類似任務的其他研究人員具有借鑒意義。基于已有研究,本課題組未來的計劃是進一步完善和推廣這一成果,開發一個實用性強的工具助手,作為初篩手段來輔助醫生進行抑郁癥診斷,為患者提供更便捷、高效的診斷和治療服務,同時減少就醫成本和時間消耗。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:黃祥勝完成實驗設計與執行、數據采集與分析、論文初稿撰寫;廖義龍與張文勁參與文獻資料整理、收集和數據分析;張莉參與項目構思,指導論文寫作,提出修改意見。

0 引言

目前,全球范圍內抑郁癥的患病率呈驚人的上升趨勢,已有超過3.22億人遭受抑郁癥困擾[1]。世界衛生組織已將抑郁癥確定為第四大致殘原因,預計到2030年將成為第二大致殘原因[2]。作為一種常見的精神障礙,抑郁癥會導致患者情緒調節能力受損,其特征是情緒低落、對事物失去興趣或難以感受到快樂、注意力不集中,嚴重情況下患者甚至會產生自殺念頭[3]。傳統的精神病理學評估方法主要依賴于患者口頭描述和精神狀態的表現,以及家庭成員的反饋意見等主觀評價,缺乏客觀的定量評價指標[4]。此外,精神病理學評估通常需要豐富的專業知識支持,而且耗時長、評測項目繁多,不利于抑郁癥的早期快速確診。

近年來,研究人員提出了許多客觀評估抑郁癥的方法,例如使用細胞因子或者唾液等生物樣本進行評估,但這些生物樣本的獲取通常具有侵入性,并且進行分析檢測的成本較高[5-6]。還有一些研究提出了通過視覺跡象進行抑郁癥自動檢測的方法,例如采集受試者的瞳孔數據、面部表情、頭部姿勢等進行分析,但這些方法的特征提取步驟復雜,識別準確率不高[7]。此外,盡管人體視覺行為蘊含豐富的生理病理信息,但數據獲取具有挑戰性,并且存在個人隱私泄露的風險。隨后,Solieman等[8]證明了使用語音信號檢測抑郁癥的可行性,并指出抑郁癥患者的聲學特征與常人有所不同。由于錄音設備的普及率高、錄音成本低、語音信號的獲取相對簡單且無侵入性,因此陸續有研究基于聲學特征如韻律、頻譜和語音質量等,來探索抑郁癥的自動檢測方法。例如,Ooi等[9]使用聲學特征的多通道加權方法進行抑郁癥檢測,準確率超過70.00%。Gao等[10]提取語音信號的短期特征和長期特征,使用隨機森林算法和極值梯度提升算法進行分類,識別抑郁癥患者的靈敏度達到75.00%。Jiang等[11]使用集成邏輯回歸模型檢測抑郁癥,準確率超過75.00%。van Eeden等[12]使用機器學習方法進行抑郁癥檢測,獲得了79.00%的準確率。早期的研究主要采用機器學習方法進行抑郁癥檢測,雖然這些方法不需要大量的訓練數據,但其準確率依賴于特征選擇,并且難以判斷特征質量的優劣,同時還存在關鍵特征丟失的風險。

隨著深度學習方法的發展, 一些研究開始嘗試將其應用于抑郁癥檢測。例如,Sun等[13]結合無監督編碼和基于注意力機制的轉換器(transformer)進行抑郁癥檢測。Yin等[14]使用基于transformer和并行卷積神經網絡(transformer and parallel convolutional neural networks,TCC)的深度學習模型檢測抑郁癥。TCC模型注重局部知識,能夠感知時序信息,并挖掘出復雜維度中的有效信息。然而,這些方法并未使用語音屬性,無法充分發揮transformer在語音領域的潛力。為了解決這個問題,Chen等[15]基于語音中的分量關系,提出了一個名為高效語音架構(speechformer++)的模型,該模型基于語音中的分量關系,能夠有效地平衡細粒度和粗粒度信息, 并增強特征的提取能力。另外, Wang等[16]使用注意力機制(attention)和雙向門控循環單元(bidirectional gate recurrent unit,Bi-GRU)相結合的模型提取了語音的三維特征,并獲得了77.14%的準確率。Rejaibi等[17]使用梅爾頻率倒譜系數(Mel-scale frequency cepstral coefficients,MFCC)作為特征輸入循環神經網絡,并使用數據增強技術,提升抑郁癥識別性能。Miao等[18]利用高階譜分析技術,將雙譜特征和非線性雙相干特征進行融合,以實現抑郁癥識別,并獲得了良好的分類效果。Zhao等[19]采用幀級特征來捕獲語音中的時間信息,并將其作為長短時記憶網絡(long short term memory network,LSTM)的輸入,該方法的準確率達到了90.20%。深度學習方法通常需要使用信號處理后的特征作為輸入,然而手工制作特征的過程復雜而繁瑣、常常需要特定任務的專業知識,且容易丟失有用信息。為了在一定程度上彌補信息丟失,一些研究采用了多模態研究方法。Toto等[20]提出一種音頻和文本的多模態表示模型,并將其集成到深度學習架構中用于抑郁癥檢測。Muzammel等[21]提出了一種使用音頻和視覺特征的深度學習網絡,采用更深層次的模型級融合方法來獲取多模態的聯合特征表示,該方法的最佳分類準確率達95.38%。Sun等[22]提出一種自適應融合transformer網絡的多模態模型,首先從音頻和視覺數據的單一模態中提取長期的時間上下文信息,然后使用該模型自適應地融合有用的多模態特征,以實現抑郁癥的檢測。上述研究結果表明,盡管多模態方法在語言理解和序列建模方面表現出良好的性能,但對語音信號中抑郁癥特征表示的能力仍然存在不足之處,此外多模態數據獲取不易、模型構建復雜、并且目前還缺乏高效的多模態融合方法。

自監督學習方法因其在多個下游任務中表現出色而備受關注[23]。語音到特征向量模型2.0(wav2vec 2.0)是一個在大規模無標注數據上進行預訓練的自監督學習語音識別模型,它在語音特征提取方面表現出優異的性能,并能夠學習到通用的語言表示。該模型引入了乘積量化方法以提升其表示能力,并能夠充分利用transformer 的長距離信息整合優勢,增強信息捕獲能力。對于不同的下游任務,該模型只需在有限的標注數據上進行微調,就能達到或超越上游任務的最佳水平[24]。目前,在使用語音數據進行抑郁癥識別方面仍然存在數據規模不足、特征提取依賴手工設計、模型泛化性能有待提高等缺陷和挑戰。因此,本文提出了一種微調wav2vec 2.0預訓練模型的方法。與傳統的機器學習或深度學習方法相比,本文方法簡化了特征提取步驟、降低對手工制作特征的需求。此外,本文方法無需使用數據增強技術即可處理小樣本數據庫,有效避免了數據增強可能引入的不必要噪聲和誤差,這為智能診斷的實際應用提供了可能性。本文首先使用wav2vec 2.0預訓練模型對輸入的語音數據進行編碼和上下文化,以獲得高質量的語音特征。然后,將這些高質量的語音特征輸入到小型微調網絡中,以期實現抑郁癥的檢測。本文使用小樣本的綠野仙蹤(又譯:奧茲國巫師)憂慮分析訪談語料庫(the distress analysis interview corpus-wizard of OZ,DAIC-WOZ)數據集來評估模型的分類性能,在抑郁癥識別的二分類任務以及評估抑郁癥嚴重程度的四分類任務中,期待通過本文方法取得良好的分類效果,能夠有效識別抑郁個體,并精準評估患者抑郁的程度。

1 數據集及預處理

1.1 實驗數據集

本文研究中使用的語音信號選取自DAIC-WOZ數據集,該數據集由南加州大學(University of Southern California,USC)的創新技術研究所(Institute for Creative Technologies,ICT)構建。本研究使用的的數據已經獲得了授權許可。該數據集是憂慮分析訪談語料庫(the distress analysis interview corpus,DAIC)的一部分,包含了焦慮、抑郁和創傷后應激障礙等多種心理壓力疾病的臨床訪談記錄。數據集提供了詳細的轉錄文件,記錄了一個名為艾莉(Ellie)的動畫虛擬面試官和受訪者每句話發言的開始時間和結束時間。在臨床訪談過程中,使用了虛擬人類訪談器,通過由另一個房間的人類面試官控制Ellie進行訪談,這一過程就彷如綠野仙蹤(又譯:奧茲國巫師)(wizard-of-OZ,WOZ)里的場景一樣。語音數據采用頭戴式麥克風(HSP 4-EW-3,森海塞爾,德國),以16 kHz進行錄制,交互時長在7~33 min之間 ,平均為16 min [25-26]。該數據集屬于小樣本數據集,共包含189個音頻文件,其中包括56個抑郁癥患者的音頻,每個音頻文件都包含動畫虛擬面試官和受訪者的語音。此外,該數據集還提供了受訪者身份識別號(identity document,ID)、性別、八項患者健康問卷抑郁量表(the eight-item patient health questionnaire depression scale,PHQ-8)評分等信息[25]。

1.2 預處理

本研究僅對受訪者的語音數據進行分析,由于每個音頻文件中同時包含Ellie和受訪者的語音,并且存在長期沉默片段,因此需對DAIC-WOZ數據集中的音頻文件進行預處理操作,以提高數據質量。首先,采用語音切割技術,從189個原始音頻中切割出受訪者的語音片段,并剔除Ellie發言的語音片段以及原始音頻中的長期靜默片段。其次,采用語音合并技術,將受訪者的語音片段按照每組5個句子進行合并,形成新的音頻文件;需要注意的是,只對來自同一ID的語音數據進行合并。通過上述操作,共獲得6 545個新音頻文件,其中僅包含受訪者的發言片段。此時,本研究獲得的數據樣本已經足夠充分,能有效緩解樣本不均衡導致分類效果不佳的問題,因此無需再進行數據增強處理。

1.3 數據集重構

數據集的劃分對于調整模型參數、驗證模型性能和評估模型泛化能力具有重要意義。為了保證各類別標簽比例的平衡,且重構的數據集均能包含無抑郁(non-depression,non)、輕度抑郁(mild-depression,mild)、中度抑郁(moderate-depression,moderate)和重度抑郁(severe-depression,severe)這四個類別的數據,首先在進行隨機分組之前將這四個類別的數據分開,然后按照6∶2∶2的比例隨機劃分這四個類別的數據為訓練集、驗證集和測試集。訓練集和驗證集用于微調模型,使其適用于抑郁癥識別,而測試集用于評估模型性能。為了保證實驗的可重復性,本文采用隨機種子進行劃分,并統一將隨機種子數值設置為103。

2 模型及實驗設置

2.1 語音識別模型

已經證實,預訓練和微調的結合是一種有效的學習策略[27]。相較于從零開始訓練,使用預訓練模型可以提供一個良好的初始化狀態,該方法只需要少量的數據集就能取得良好的效果,從而節省了大量時間和資源。預訓練階段通常以無監督方式在大規模數據集上進行,以便讓模型學習有意義的表示[28-29]。預訓練階段的作用類似于正則化器,可以提供大量的先驗信息,從而降低過擬合的風險,并增強模型的泛化能力[30]。

wav2vec 2.0是一個在語音處理領域具有很大潛力的預訓練模型,它是在對比預測編碼(contrastive predictive coding,CPC)、語音到特征向量模型(wav2vec),再到向量量化(vector quantization,VQ)的wav2vec(VQ-wav2vec)的基礎上發展而來的,wav2vec 2.0模型能夠學習離散語音單元和端到端上下文表示[31-33]。它能夠從被掩碼的潛在表示中有效地識別出正確的量化潛在語音表示。如Baevski等[24]所描述的,該模型主要由特征編碼器模塊、transformer模塊和量化模塊組成,如圖1所示。

圖1

wav2vec 2.0預訓練模型框架圖

Figure1.

Framework of the wav2vec 2.0 pre-training model

圖1

wav2vec 2.0預訓練模型框架圖

Figure1.

Framework of the wav2vec 2.0 pre-training model

首先,特征編碼器模塊將語音信號X映射到特征Z,表示為f:X→Z,其中Z為特征集合{z1, z2, …, zn}。特征編碼器包含7層卷積神經網絡(convolutional neural network,CNN),并應用了高斯誤差線性單元(Gaussian error linear units,GELU)。通過CNN,特征編碼器模塊能夠從語音中學習到高級語義信息,而GELU引入非線性元素,使特征編碼器可以完成非線性映射。在這個過程中,第一層CNN的輸出使用組歸一化(group normalization,GN)方法,對整個序列上的每個輸出通道進行歸一化,而其余幾層CNN的輸出則使用層歸一化(layer normalization,LN)方法,對每個批次(batch)內的輸出通道進行歸一化。此外,在該模塊的最后一層激活層之前,使用L2正則化項來穩定訓練,并進行歸一化處理,以避免權值矩陣過大。

其次,量化模塊將特征編碼器Z的輸出離散化為一組有限的語音表示Q:{q1, q2, …, qi, …, qn},表示為h:Z→Q,Q作為自監督目標。這個過程使用乘積量化操作,將無限的特征表達空間坍縮成有限的離散空間,從而降低模型預測的難度并提高特征的魯棒性。在該模塊中,采用耿貝爾歸一化指數函數柔性最大(Gumbel softmax)技術對離散分布進行采樣,并將其轉化為可微的連續分布,以解決特征空間離散后無法進行反向傳播的問題。

緊接著,transformer模塊接收潛在語音表示Z,并創建上下文表示{c1, c2, …, ci, …, cn},表示為g:Z→C。在輸入transformer模塊之前,對大約一半語音表示Z進行掩碼操作。由于transformer中的自注意力機制(self-attention)能夠捕獲輸入數據的長期依賴關系,因此最終的輸出序列{c1, c2, …, ci, …, cn}可能同時包含局部和全局信息[34]。因此,wav2vec 2.0的預訓練模型具備從掩碼位置中識別正確的量化語音單位的能力,也就是表明其信息捕捉能力更強。

最后,使用量化的語音表示qi和上下文表示ci來計算損失函數。當損失函數達到理想值時,wav2vec 2.0就能夠學習到高質量的語音特征。

wav2vec 2.0有兩種實驗配置:基礎(base)模型(wav2vec 2.0-base)和大(large)模型(wav2vec 2.0- large)。這兩種模型具有相同的編碼器架構,但它們的transformer塊數量以及模型維度有所區別。wav2vec 2.0-base模型包含7層CNN和12層transformer結構。各卷積層的通道數為512,各自的步幅為(5,2,2,2,2,2,2),核大小為(10,3,3,3,3,2,2)。相比于wav2vec 2.0-large模型,wav2vec 2.0-base模型具有更快的訓練速度和更低的計算資源需求,更適用于小數據集或計算能力有限的場景。

本文的所有實驗都基于wav2vec 2.0-base模型進行。本文設計了一個微調網絡,并將其連接在wav2vec 2.0-base模型的輸出端,使得wav2vec 2.0-base模型適用于抑郁癥識別檢測任務,如圖2所示。

圖2

語音抑郁癥識別的整體框架圖

Figure2.

Overall framework of voice depression recognition

圖2

語音抑郁癥識別的整體框架圖

Figure2.

Overall framework of voice depression recognition

首先,將語音信號輸入wav2vec 2.0-base模型中,利用特征編碼器模塊捕捉語音信號的局部信息,并使用transformer 模塊捕捉具有全局信息的語音特征,從而獲取高質量的語音特征。接著,對提取的高質量語音特征進行池化處理,以增大模型的感受野,提高語音識別的準確性和魯棒性。然后,在微調網絡中使用隨機失活層(dropout),以減少神經元之間的共適應關系,降低權值更新對固定隱含節點共同作用的依賴,迫使神經網絡學習更加魯棒的特征。同時,該方法還起到增加稀疏性的作用,增加語音特征之間的區分度。因此,在全連接層和輸出層之前,本研究使用隨機失活層來提升模型性能。通過不斷迭代微調本文所提出的模型,當損失函數達到理想值時,輸出模型的預測結果。

2.2 實驗任務

目前,對抑郁癥的識別研究主要局限于二分類任務,鮮有對抑郁癥嚴重程度進行多分類研究。然而,為了更好地輔助判斷抑郁癥,進行抑郁癥多分類研究是非常必要的。因此,本研究定義了兩個實驗任務:抑郁癥二分類和抑郁癥四分類。二分類任務中,研究檢測患者是否受到抑郁癥困擾。該任務的標簽劃分方法基于DAIC-WOZ數據集提供的二進制(binary)數值,將語音數據標簽設為抑郁(depression,dep)和非抑郁(non depression,ndep)。四分類任務中,將抑郁癥嚴重程度劃分為四個等級:non、mild、moderate和severe。該任務的標簽劃分方法是將數據集中的PHQ-8評分(范圍0~24)離散化為4個類別:[0-4]、[5-9]、[10-14]和[15-24],標簽分別對應:non、mild、moderate和severe。

此外,本研究還設置了wav2vec 2.0預訓練模型的參數微調和凍結實驗、池化方法實驗以及模型迭代次數實驗,以研究微調或凍結wav2vec 2.0模型的參數對抑郁癥分類性能的影響、不同的池化方法對提高預訓練模型準確率的影響,以及模型迭代次數(epoch)對模型收斂的影響。

2.3 參數設置

學習率(learning rate,LR)和批大小(batch size,BS)是深度學習中非常重要的超參數,它們影響著模型的收斂速度和性能。LR是控制權重更新步長的參數,BS是指每次迭代訓練時所使用的樣本數。在預訓練階段,wav2vec 2.0模型的參數幾乎調整至最佳狀態。在微調過程中,預訓練模型的網絡參數也會被更新。為了防止wav2vec 2.0模型參數發生較大變化而影響模型性能,應選擇較小的LR。通過對比不同LR(1 × 10?4、1 × 10?5、1 × 10?6)對模型性能的影響,本研究發現LR為1 × 10?5時,模型性能表現最佳。為避免模型在訓練過程中出現震蕩并增加內存的消耗,本研究使用梯度累加(gradient accumulation,GA)方法,即在兩次累加之后更新模型神經網絡的參數,然后將梯度清零。因此,本研究的BS設置為4,GA設置為2,累加BS(accumulated BS,ABS)設置為8,并且均在LR設置為1 × 10?5的條件下進行實驗。

2.4 評估方法

在樣本不平衡的情況下,僅使用單一評估指標作為衡量準則可能存在偏差,無法全面評估模型在不同方面的性能表現。因此,本研究采用準確率(accuracy,ACC)、精確率(precision,PRE)、召回率(recall,REC)以及F1分數這4個評價指標來衡量模型的分類性能,計算方法分別如式(1)~式(4)所示:

|

|

|

|

其中,真陽性(true positive,TP)表示預測為正類且預測正確的樣本數量。真陰性(true negative,TN)表示預測為負類且預測正確的樣本數量。假陽性(false positive,FP)表示預測為正類,但預測錯誤的樣本數量。假陰性(false negative,FN)表示預測為負類但預測錯誤的樣本數量。PRE表示對正樣本結果進行預測的準確程度,REC表示實際為正樣本的樣本中被正確預測為正樣本的概率。F1分數綜合考慮了模型的ACC和REC,可看作是這兩者的加權平均,從而綜合評估分類模型的性能。

3 實驗結果及討論

相較于從零開始訓練模型,使用預訓練模型可以節省大量的時間和資源,并且僅需少量數據集即可取到良好效果。傳統的深度學習模型具有大量參數,在小規模數據集上容易過擬合,而預訓練模型提供了良好的初始化狀態,從而降低了過擬合風險,并增強了模型的泛化能力。wav2vec 2.0預訓練模型具備強大的語音特征提取能力,能夠學習到有意義的語言表示。本研究通過微調wav2vec 2.0 預訓練模型,將其應用于抑郁癥識別任務。

由于預訓練模型已經在大規模數據上進行了訓練,其參數已接近最優解,在微調過程中僅需調整部分參數即可獲得良好效果。如果在不影響wav2vec 2.0分類性能的前提下,凍結底部參數并僅調整頂部或特定層參數,將有助于減少訓練參數并提高訓練速度。

本文所有的表格中,“類別”一詞表示抑郁癥的分類數目。在研究微調或凍結參數對模型性能影響的實驗中,將epoch設置為5。實驗結果如表1所示,其中“凍結”一欄中“是”表示凍結模型wav2vec 2.0中的特征編碼模塊參數,“否”表示對該模塊的參數進行微調。

如表1所示,凍結了wav2vec 2.0 特征編碼器的參數后,在二分類任務中,ACC有所提升;在評估抑郁癥嚴重程度的四分類任務中,ACC的提升更為明顯。實驗結果表明,通過凍結模型wav2vec 2.0底層參數來減少訓練參數,可以提高訓練效率。這種方法既可以將更多資源用于優化后端網絡參數,又能很好地保留模型的先驗知識。

此外,池化方法可以增大感受野、改善過擬合現象、提高魯棒性和加快計算速度,并且能在降低特征圖的參數量的同時保留特征圖中最顯著的特征。池化操作通常有最大池化和平均池化兩種方式,最大池化通過選擇窗口中的最大值作為下采樣后的值,平均池化則是選擇窗口中的平均值作為下采樣后的值。在凍結參數的實驗基礎上,本文比較了不同池化方法對模型分類性能的影響,其中epoch設置為5,實驗結果如表2所示。

如表2所示,在二分類和四分類任務中,采用平均池化方法時,模型的ACC均有提升。實驗結果表明,采用平均池化方法優于最大池化方法。最大池化雖然能有效抑制噪聲和異常值,但也會損失部分重要信息;而平均池化能夠平滑輸出,并盡可能地保留所有特征信息,從而減少過擬合風險并提高魯棒性。wav2vec 2.0 預訓練模型具備強大的語義信息學習能力,提取出的語音特征無需去除噪聲或異常值,并且平均池化方法對于小樣本數據集更為合適。

epoch的次數是指將所有數據完整地訓練一遍的次數。如果epoch輪次過少,模型可能無法充分學習訓練數據,導致欠擬合;如果epoch輪次過多,模型可能會過擬合,導致在測試集上表現不佳。因此,在凍結參數并使用平均池化方法的基礎上,本文進一步研究了epoch對模型性能的影響,實驗結果如表3所示。

如表3所示,隨著epoch的增加,模型ACC也得到提高。但是當達到10之后,增加epoch無法再帶來明顯的性能提升。此外,增加epoch輪次還會導致訓練時間的增加和進一步消耗計算資源,因此需要在模型性能、訓練速度和計算資源之間進行權衡,綜合考慮后,本研究決定將epoch設置為10。

綜合前面的實驗結果,對模型的參數進行設置,并使用測試集評估模型的分類性能。模型二分類和四分類的混淆矩陣如表4和表5所示。在混淆矩陣中,每一行數據的總和為對應類別的樣本總數,對角線上的數據為正確預測的樣本數。二分類和四分類的模型分類效果如表6所示。

如表4所示,在410個抑郁樣本中,模型正確預測了389個;在899個非抑郁樣本中,正確預測了874個,這表明本文提出的模型在抑郁個體和非抑郁個體的識別方面具有良好的效果。

如表5所示,本文模型也能夠有效評估不同程度的抑郁患者。例如在non這一行中,樣本總數為572,正確預測的樣本為548個。

如表6所示,二分類和四分類任務ACC分別達到了96.48%、94.80%。F1分數均達到93.12%及以上,表明模型的分類性能非常出色。實驗結果表明,本文所提模型能夠有效識別抑郁個體,并且能夠精確評估患者的抑郁的程度。

由于目前大多數抑郁癥研究都是針對二分類任務,對于抑郁癥的多分類識別研究較少,因此在與其他的研究方法進行對比時,本文選擇了二分類任務。如表7所示,列出了不同研究方法在抑郁癥識別方面的結果,這些方法都使用了DAIC-WOZ數據集和相同的評價指標,表7中數據統一保留小數點后兩位,括號中的數據表示非抑郁類別的評價指標。

如表7所示,在PRE方面,本文模型對抑郁類別的識別略低于文獻[21],但對于非抑郁類別的識別精度更高。在REC方面,文獻[18]表現最優,但在其它三個評估指標上不及本文模型。綜合考慮,在實際應用中,本文模型具備更高的可靠性和優越性。在F1分數和ACC方面,本文模型均優于現有方法。

4 總結

本研究提出一種微調wav2vec 2.0預訓練模型的方法,該方法能夠對語音數據進行編碼和上下文化,自動提取高質量的語音特征,從而提升模型性能和泛化能力。與傳統的機器學習或深度學習方法不同,該方法省去了復雜的特征提取步驟,并且在不進行語音降噪和數據增強的情況下,能夠改善小樣本數據集的識別效果。相較于現有技術,本文方法在帶噪聲的DAIC-WOZ數據集上展現了更卓越的性能。此外,本研究還提供了多分類研究的經驗,豐富了抑郁癥研究的視角,并分享預訓練模型微調的經驗,這對于從事類似任務的其他研究人員具有借鑒意義。基于已有研究,本課題組未來的計劃是進一步完善和推廣這一成果,開發一個實用性強的工具助手,作為初篩手段來輔助醫生進行抑郁癥診斷,為患者提供更便捷、高效的診斷和治療服務,同時減少就醫成本和時間消耗。

重要聲明

利益沖突聲明:本文全體作者均聲明不存在利益沖突。

作者貢獻聲明:黃祥勝完成實驗設計與執行、數據采集與分析、論文初稿撰寫;廖義龍與張文勁參與文獻資料整理、收集和數據分析;張莉參與項目構思,指導論文寫作,提出修改意見。